전통 및 대중 무용의 체험학습 창작을 위한 퍼포먼스 분석 및 생성기술

Performance Analysis and Generation Technology for Creation of Empirical Learning about Traditional and Popular Dances

- 저자

- 김예진, 서상우, 백성민, 김종성, 김명규 / 차세대영상연구실

- 권호

- 29권 1호 (통권 145)

- 논문구분

- 차세대 콘텐츠기술 특집

- 페이지

- 21-30

- 발행일자

- 2014.02.15

- DOI

- 10.22648/ETRI.2014.J.290103

- 초록

- 무용, 춤, 연기 등의 전문가 퍼포먼스를 분석, 학습, 보급하는 콘텐츠 기술개발은 문화산업의 중요한 당면과제이나 기존 기술은 동작만 인식하고, 감성 및 도구를 포함하지 않으며, 단순 열람은 가능하나 체험 및 학습할 수 있는 효율적인 방법이 부재하다. 따라서 전문가의 퍼포먼스 동작을 일반인 시점에서 학습할 수 있는 체감형 콘텐츠를 제공하기 위해서는 빠르고 능동적인 동작 영상 획득 시스템의 개발과 동작 데이터를 분석 및 생성하는 기술들이 필요하다. 따라서, 본 논문에서는 퍼포먼스 무용의 학습 콘텐츠 제작을 위한 핵심 기술들의 동향을 분석하고자 한다.

Share

I. 서론

본 논문에서 퍼포먼스(performance)란 동작보다 큰 개념으로, 전통 및 대중 무용의 빠른 신체동작, 문양/질감/색감이 있는 펄럭이는 의상, 활용하는 소품/도구, 표현하는 감성을 모두 포함하는 개념이다. 무용, 춤, 연기 등의 전문가 퍼포먼스를 분석, 학습, 보급하는 콘텐츠 기술개발은 문화산업의 중요한 당면 과제이다. 예로 유네스코 무형유산협약은 무형문화재의 보호를 위해 진행되어야 할 최우선 과제로 ‘무형유산의 기록’을 권고하고 있다. 또한, 새로운 안무 창조를 위한 전자 안무노트와 같은 사전검토 및 다양한 창작의 시도를 통해 보다 질 높은 작품제작이 가능하다. 이는 한류문화 확산에 있어 대중문화에서 ‘한국문화 전반’으로, 아날로그에서 ‘디지털 융합’으로, 단방향에서 ‘양방향 문화’로 변화를 통한 한류문화 고도화 및 세계화에 기여할 수 있다.

삶의 질 향상을 위해 다양한 퍼포먼스를 체험하고 학습하는 참여형 여가산업(국내 산업 시장은 2011년 기준 약 45조원)은 빠르게 증대하고 있으나, 기존 기술은 동작만 인식하고 감성 및 도구를 포함하지 않으며, 단순 열람만 가능한 단방향적 기술만을 제공하고 있다. 따라서 일반인 시점에서 학습할 수 있는 콘텐츠의 개발을 위해서는 빠르고 능동적인 무용 퍼포먼스에 대한 영상 획득 시스템을 구축하고 획득한 영상을 분석한 후 콘텐츠 개발에 사용할 수 있는 무용 데이터를 생성하는 원천 기술이 필요하다.

본 논문에서는 학습형 콘텐츠개발을 위한 다중 영상 기반 퍼포먼스 분석 및 생성기술들에 대한 동향을 분석하고자 한다.

II. 퍼포먼스 분석기술

1. 국내 기술동향 및 수준

고속 RGB-D(Red, Green, Blue-Depth) 카메라에 관련된 국내 기술로는 삼성전자와 프랑스 INRIA 연구소가 수행한 Mix Cam Project[1]가 있지만, 해외에 비해 미비한 실정이다((그림1) 참조).

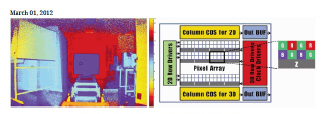

특히, 삼성전자는 2012년 3월에 RGB-D 카메라에 적용될 수 있는 CMOS(Complementary Metal-Oxide-Semicondocutor) type의 Image Sensor[2]를 발표하였는데, Sensor 자체에 RGB 화소뿐 아니라 깊이 정보를 측정하는 Z화소를 배치하여 완벽한 의미의 RGB-D 카메라 구현((그림 2) 참조)을 용이하게 하였으나 아직 상업적으로 이용하기엔 어려움이 있다.

고속촬영 및 특수효과와 같은 방송분야, 착순 분석과 스윙 분석과 같은 스포츠분야, 충돌 및 발사 시험과 같은 산업용 시험분야 등에서 고속카메라는 폭넓게 활용되고 있으나 동작 분석을 포함한 디지털 콘텐츠분야((그림 3) 참조)에서의 활용은 미비한 실정이다.

한국전자통신연구원(ETRI)에서는 구조광 기반의 3D 깊이 카메라를 개발하여 3D 콘텐츠를 위한 UI(User Interface)를 적용하였고, 광주과학기술원(GIST)에서는 다시 점 비디오 카메라와 TOF(Time-of-Flight) 방식의 3D 깊이 카메라를 결합한 복합 카메라 시스템을 개발하여 3D 방송 분야에 적용하였으며, 삼성전자에서는 동작 인식을 위한 TOF 방식의 3D 깊이 센서 모듈을 개발하여 자사의 스마트 TV UI로 활용하는 등, 3D 깊이 카메라에 대한 기술 개발((그림 4) 참조)은 활발하나 카메라 속도 및 해상도 등의 제약으로 무용 동작과 같은 고속 모션을 분석하는데 적용하기에는 어려움이 있다.

또한, 정적 배경이나 객체에 대한 다중 카메라 기반의 3D 복원기술은 활발하게 연구되고 있으나 무용이나 댄스와 같이 고속 동작과 도구, 의상 등이 복합된 동적 객체에 3D 분석기술에 관한 연구 사례는 없다. 다중 카메라 기반의 3D 복원기술((그림 5) 참조)로는, 한국과학기술원(KAIST)에서 개발한 여러 대의 카메라와 레이저 센서를 융합한 넓은 영역의 정적 배경에 대한 3D 복원기술, 경북대에서 개발한 정적 객체의 3D 복원을 위한 구조광 기반의 카메라 기술, GPU(Graphics Processing Unit) 기반의 가속화기술 등이 있으며, ETRI에서는 여러 대의 방송용 카메라를 통해 공연이나 이벤트에 등장하는 객체의 3D 외형을 복원하여 전송하는 기술을 개발 중에 있다.

동작 분석에 대한 수요는 많으나 기술적인 한계로 고가의 외산 동작 분석시스템이 수입되어 사용 중이며 국내에서 자체 개발되어 상용화된 시스템은 없는 실정이다. 서울대, 숭실대, 전남대 등 국내 대학에서 동작 분석 기술에 대한 연구는 활발하게 진행되고 있으나 상용화에 성공한 사례는 없다.

미국 Vicon사의 Vicon MX[3]와 Phase Space사의 Impluse[4] 등 고가의 외산 마커 기반 분석시스템이 국내 스튜디오 및 교육기관 등에 판매 중이고, 미국 Organic Motion사의 Open Stage[5] 등과 같은 마커리스 분석시스템도 수입되기 시작하였으나 기술적인 제약이 많아 활용도는 낮은 편이다.

정적인 동작 및 의상을 분석하는 연구((그림 6) 참조)가 수행되었으나 무용 및 댄스의 빠른 동작이나 도구, 의상 내 동적인 고속 모션을 분석하는 연구는 미미한 편이다. ETRI에서는 다중 카메라 기반의 3D 복원을 통한 신체 동작 분석연구와 저가 고속카메라를 이용한 3D 공 추적 및 속도, 회전 인식을 통한 3D 가상 스포츠 연구, 3D 스캐닝을 통한 계측된 신체 모델에 가상으로 의상을 피팅해주는 3D 가상 피팅 연구를 수행하였다. 또한, 서울대 및 FX Gear사에서 의상 애니메이션을 위한 다수의 연구개발을 수행하였으나 의상의 실제 비정형 모션을 정밀하게 분석하기 위한 연구는 수행되지 않았다.

무용과 같은 예술분야의 감성분석을 위한 자세 및 동작을 인식하는 연구 또한 미미한 편이다. 연세대, KIST, KAIST 등에서 연기자와 무용수의 얼굴표정 데이터베이스와 얼굴표정 해석용 헬멧 장비를 이용해 감성을 인식하는 연구를 수행하였고, 포항공대(POSTECH)에서는 영상 기반으로 얼굴표정을 자동으로 추출하고 분석하여 표현 및 감성을 인식할 수 있는 기술을 개발하였으며, 올라웍스에서는 디지털 카메라의 감성 인터페이스 개발을 위해 촬영 순간에 자동으로 얼굴을 찾고 미소나 깜빡임과 같은 얼굴표정을 인식하여 사용자에게 제공하는 기술을 개발하였다. 또한, 한양대에서 무용 영상 시퀀스에서 무용 동작의 전체적 외관 특징을 추출하여 이를 기반으로 happy, surprised, angry, sad 등의 감성을 분석하는 기술을 개발하였으나, 이들은 모두 영상을 통해 감성분석을 위해 얼굴표정을 인식하는 연구이다.

2. 국외 기술동향 및 수준

RGB-D 카메라에 관한 연구는 매우 활발하나 저속이거나 고가의 제품이다. 해외에서는 RGB-D 카메라에 대한 연구가 일일이 열거할 수 없을 정도로 활발히 진행되고 있으나, 2차원 정보를 담당하는 RGB 카메라의 경우 상대적으로 저속의 제품이 대부분이고, 미국 Organic Motion사의 Open Stage에 사용되는 카메라((그림 7) 참조)의 경우 HD 영상 및 200프레임이라고 광고하고 있으나, 흑백카메라에 VGA 급이 200프레임이고 HD급인 경우 60프레임 이내의 저속을 사용하고 있다.

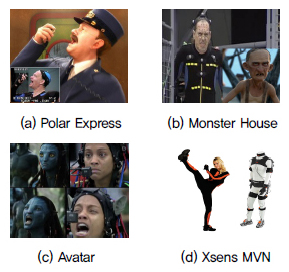

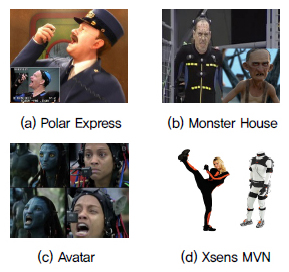

영화나 애니메이션을 위한 상용 퍼포먼스 분석기술이 존재하나 전신슈트와 같은 부자연스러운 복장 착용 또는 마커나 센서의 추가 부착 등의 제약이 있다. 퍼포먼스 분석 기술은 영화 ‘The Polar Express (2004)’에서 처음 도입된 후, ‘Monster House (2006)’, ‘Avatar (2009)’ 등의 성공으로 크게 주목 받았다. 상용시스템으로는 미국 Vicon사의 Vicon MX, Motion Analysis사의 Raptor와 같은 마커방식과 Xsens사의 MVN과 같은 센서방식((그림 8) 참조)이 다수 존재한다.

문화예술분야에서는 전문가가 센서를 부착하지 않고 자연스러운 복장만 착용한 상태에서 퍼포먼스를 획득하여 분석하는 기술개발이 필요하다. 미국 Organic Motion사에서 개발한 마커리스 모션 캡쳐기술은 센서 부착이나 슈트 착용 없이 간편한 복장을 착용한 상태에서 2명까지 모션분석이 가능한 장점은 있으나 정밀도가 낮고 의상과 같은 비정형체의 모션분석은 지원하지 못하는 제약이 있다.

국외 유수 연구기관에서 복장 등에 제한이 없는 퍼포먼스 분석기술이 연구되고 있으나 느린 동작만 분석 가능하고 음영 지역, 의상 내 및 비정형체는 분석 불가하다. 최근 독일 MPI와 프랑스 INRIA 등에서 마커리스 퍼포먼스 분석 기술에 대한 연구 결과[6][7]를 SIGGRAPH, CVPR 등의 유수 저널 및 학회에 발표하였으며, 스위스 ETH, 독일 MPI, 미국 Stanford 대학에서 공동으로 의상 외부에서 동작 일부가 관찰될 경우 스켈레톤이 연결된 외형 모델을 기반으로 의상 내부의 동작까지 분석할 수 있는 기술[8]을 개발하여 학회에 발표하였으나, 빠른 동작 추적, 음영 지역, 의복 내 모션 역추적 및 비정형체 모션 추적 기술개발이 여전히 필요한 실정이다.

III. 퍼포먼스 생성기술

1. 국내 기술동향 및 수준

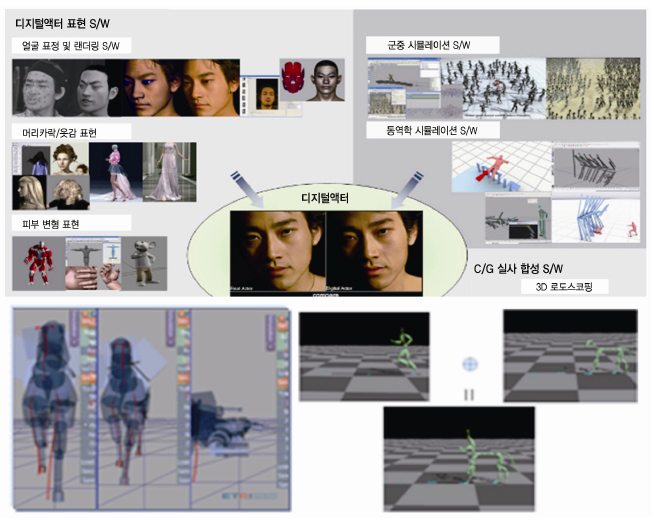

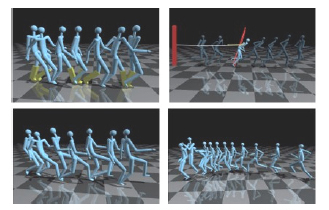

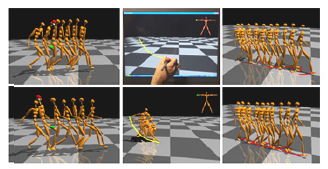

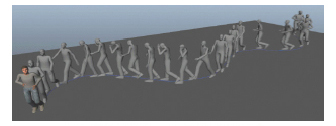

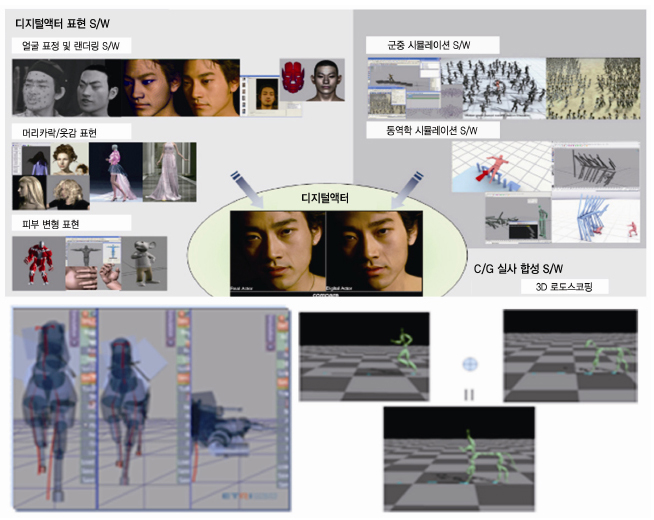

모션 캡쳐 데이터를 활용한 동작 편집에 대한 연구는 KAIST, 서울대 등 학계 및 ETRI 등 연구소를 중심으로 활발하게 연구되고 있다. 서울대 MR 랩((그림 9, 10) 참조)에서는 모션 캡쳐 데이터를 기반으로 동작 패치[9]들을 연결하여 상호 간에 반응하는 새로운 동작을 생성하거나, dynamic 동작에 대해 모멘텀과 힘을 계산[10]하여 높이가 달라질 때에 대해서도 물리적으로 타당해 보이는 동작을 생성하는 등 다양한 분야에서 연구가 진행되고 있다. ETRI에서는 디지털 액터 및 크리쳐 제작 과제((그림 11) 참조)를 통해 인간형 캐릭터의 움직임 변형 및 복제, 동역학 시뮬레이션, 크리쳐 동작 생성, 군중 시뮬레이션 등에 관한 기술을 개발하였다. 하지만, 무용과 같은 능동적이고 감성적인 동작에 대한 연구는 거의 없으며, 무용 동작에 대한 특수 코드화 부분은 국내에 없는 기술이다.

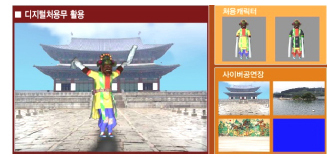

최근 국내에서도 무용분야에 디지털 미디어를 활용하고자 하는 연구가 다수 발표되고 있으나 안무 제작 등에는 미흡한 면이 있다. 1981년부터 2010년까지 무용교육공학(가상현실, 3D 무용, 멀티미디어, 컴퓨터 등)에 대한 72편의 연구 중 교육(39.6%) 분야 연구가 가장 많이 다루어졌으며, 분석 27.8%, 기록 22.4%, 안무 10.3%로 안무분야 영역의 연구가 가장 미약하다. 디지털 처용무((그림 12) 참조)는 모션 캡쳐를 통해 춤 동작을 획득하고, 처용무 복식(의상)을 모델링 및 시뮬레이션을 통해 복원[11]하였으나, 한삼의 움직임 및 감성적 느낌이 표현되지 못했다는 한계가 있다. 해외에서는 라바노테이션(Labanotation)[12], BMN(Benesh Movement Notataion)[13], EWMN(Eshkol-Wachman Movement Notation)[14] 등 움직임을 표현하기 위한 많은 시도가 있어왔으나, 국내에서는 이러한 연구가 부족한 현실이다.

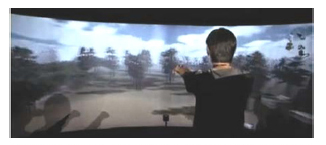

최근 교육분야에서 멀티미디어와 같은 정보기술의 사용이 급증하면서, 가상(VR: Virtual Reality)/증강(AR: Augmented Reality) 현실 기반 체험형콘텐츠 서비스가 제공되고 있다. KAIST AIM 연구실[15]에서는 컬러 이미지를 이용해 학습자를 추출하고 얼굴, 손, 발을 인식하여 추적하는 연구를 진행하였고, 디스트릭트사에서는 사용자의 포스처 및 제스처를 인식하여 가상공간상의 뷰 변환을 얻는 시스템((그림 13) 참조)을 발표하였다. ETRI에서는 입체 몰입형 다자 간 참여형 교육서비스((그림 14) 참조)를 개발한 바 있으며, 최근 사용자와의 직접적인 3D 터치 인터랙션을 지원하는 인터랙티브 증강 공간 디스플레이 서비스를 개발하고 있다.

2. 국외 기술동향 및 수준

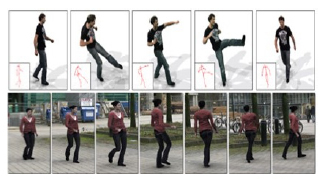

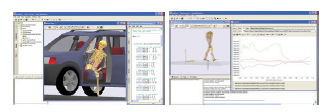

국외에서는 동작 자동생성을 위한 기술이 많이 개발되고 있으나 동작, 외형, 감성, 도구를 포함하는 다목적 퍼포먼스 생성에 관한 연구는 부족한 편이다. 중국의 Tsighua대학((그림 15) 참조)에서는 사용자의 동작을 여러 방향에서 비디오로 캡쳐한 후, 새로운 동작을 입력하였을 때 저장된 MDB(Motion Database)로부터 퍼포먼스를 복원하는 방법[16]을 제시했다. 미국의 Texas A&M대학((그림 16) 참조)에서는 캡쳐된 동작 데이터로부터 비선형 확률적 force field를 학습하여 물리적 제약 조건과 결합함으로써 물리사실적인 동작을 생성하는 방법[17]을 발표하였다. 덴마크의 Any Body Technology사는 환경적응형 인체동작에 대한 역학적 시뮬레이션을 위한 Any Body Modeling System((그림 17) 참조)을 개발하였고, 영국의 Natural Motion사의 Dynamic Motion Synthesis SW인 Endorphin((그림 18) 참조)에 스스로 움직임을 부여한 적응형 행동양식 기술을 적용하였으나, 동작, 외형, 도구뿐만 아니라 무용에서 중요한 감성까지 포함하는 퍼포먼스 생성 연구는 시도된 바가 없는 걸로 파악되고 있다.

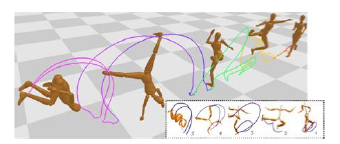

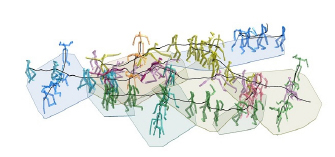

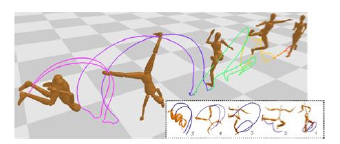

동작을 자동으로 생성하기 위한 사용자 인터페이스 분야가 많이 연구되고 있으나, 아직은 제한적인 부분이많다. 미국의 Texas A&M 대학연구팀((그림 19) 참조)은 캡쳐된 동작에 대한 통계적 분석과 저-차원 동작 모델을 생성한 후 사용자가 입력한 제약조건을 만족하도록 변형 가능한 파라미터를 수정하여 원하는 동작을 생성하는 방법[18]에 대해 발표하였고, 캘리포니아 대학 연구팀((그림 20) 참조)은 사용자로부터 이동경로 및 동작순서를 입력 받으면, 경로를 따라가며 입력된 locomotion 클립을 합성하여 자동으로 경로를 따라가도록 생성하는 기술[19]을 개발하였다. 또한, Cheng Kung대학((그림 21) 참조)에서는 동작 데이터들에 대한 움직임 경로를 인코딩하여 계수로 표현한 후 사용자의 동작 스케치를 입력으로 받아 가장 유사한 동작들을 찾아 하나의 동작으로 연결해주는 방법[20]을 제시하였으나, 대부분의 기술에서 사용하고 있는 동작 데이터의 종류는 locomotion이나 점프와 같이 간단한 움직임만을 고려하고 있다.

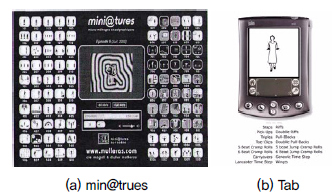

해외에서는 공연예술을 위한 창의적 도구, 미디어 변환을 위한 소프트웨어의 개발 및 활용이 확장되고 있다. 미디어 아티스트이며 프로그래머인 Mark Coniglio는 춤과 연극 제작분야에서 비전문인을 위한 Isadora라는 프로그램((그림 22) 참조)을 개발하였고, 프랑스 안무가 Magali와 D. Mulleras는 mini@trues 프로젝트((그림 23) 참조)를 통해 비디오 및 애니메이션 효과를 적용하였으며, 미디어 작가 James Buckhouse의 TAP이라는 댄스 프로그램(그림 23)을 개발하였다. 실시간 상호작용에 사용되는 프로그램으로는 MIDI Dancer, Eye Con, Very Nervous System 등이 다수 존재한다. 또한, 미국의 Mattle사와 New York City Ballet의 수석 안무가 Peter Martin의 애니메이션 발레작품 ‘바비의 호두까기 인형’, ‘바비의 백조의 호수’ 등은 모션 캡쳐를 사용하여 제작한 애니메이션 만화영화이고, 인터랙티브 댄스, 버추얼 댄스, 디지털 댄스, 웹 댄스, 댄스 애니메이션 등 무용을 중심으로 하는 다양한 디지털 매체가 있다.

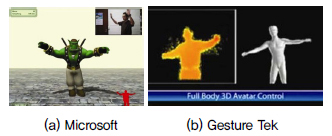

최근 동작 인식에 대한 관심이 높아지면서 다자 간 학습자 인터랙션 기술이 개발되고 있는 추세이다. 일본 닌텐도는 3차원 가속도 센서를 내장한 게임 컨트롤러인 Wiimote로 유명하며, 게임에 필요한 인터랙션 기능((그림 24) 참조)을 제공하나 제한된 사용환경으로 학습용도에는 적합하지 않다는 단점이 있다. Microsoft사는 최근 국제 전자제품 전시회를 통해 유아용 엔터테인먼트 콘텐츠에서 사용자의 몸동작을 인식하는 Kinect 기술에 음성에 의한 컨트롤을 강화하여 제스처 인식을 이용하는 기술((그림 25) 참조)을 발표하였으나 인터랙션의 정확도가 낮으며 사용자 조작을 위한 별도의 학습이 필요하다. Gesture Tek사는 사용자 영상에서 스켈레톤을 추출하여 가상공간에서 내비게이션을 수행하는 풀-바디 아바타 컨트롤 기술((그림 25) 참조)을 개발하였으나 증강현실 경험은 제공하지 않고 있다.

모션 센서를 통해 사용자 또는 도구를 각각 지원하는 인터랙션 기술은 존재하나 사용자와 도구의 모션을 동시에 지원할 수 있는 인터랙션 기술은 없는 실정이다. 미국 Microsoft사의 Kinect와 벨기에 Softkinetic사의 Depth Sense는 사용자 모션만 지원하며, 일본 닌텐도사의 Wii는 자사의 전용 도구만 지원하고 있다.

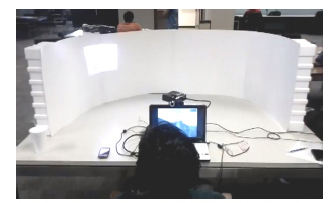

스크린과 모니터와 같은 고정 디스플레이만을 이용하는 기존 체험-전수 플랫폼은 동적 시점 변화가 필요한 몰입형 실전용 퍼포먼스 체험-전수에는 부적합하다. 따라서 최근 미국 Microvision사와 텍사스 오스틴 대학에서 PicoP 레이져 프로젝터를 이용한 몰입형 VR 시스템((그림 26) 참조)에 대한 연구를 시작하였으며, 자기중심 몰입 시점의 사실적 실감체험 및 훈련이 가능한 몰입형 AR/MR(Mixed Reality) 시스템개발이 필요한 실정이다.

IV. 결론

실감 미디어 SW(실감형 인터랙션 및 체험형 가상 시뮬레이션 분야) 시장은 매년 10%이상의 성장률을 예상하고 있다. 실감형 인터랙션 부분은 단방향, 단일 장치 사용에서 인터랙티브 UX(Uxinteractive) 환경 및 멀티모달 장치 사용으로 발전하고 있고, 가상 시뮬레이션 SW의 경우 시청각 위주에서 실감형 인터페이스 적용으로 발전하고 있으나 국내에는 애니메이션 제작을 위한 도구를 개발하여 판매하는 업체가 거의 없으며, 대부분 해외에서 구매한 소프트웨어를 사용하고 있는 실정이므로 국내 SW 개발역량에 대한 국제적 평가는 후진국 등급이며, 패키지 SW 부분에 대한 국내 시장 외국계 기업 비중은 75.1%에 달하고 있는 실정(ITR&D 발전전략 2010-2015 SW 부분)이다. 특히, 마야, 맥스, 소프트이미지 등은 모델링, 렌더링, 애니메이션을 모두 포함한 소프트웨어이며, 모션 빌더, 엔돌핀과 같은 모션 전용 소프트웨어의 경우에도 직접적인 시장 규모 자체는 크지 않을 것으로 파악되나, 콘텐츠 제작 툴을 활용하여 창조하는 콘텐츠의 부가가치(세계 애니메이션 시장 규모는 2010년 170억 달러에서 2015년 199억 달러로 성장 전망 - 해외 콘텐츠시장조사2011, 세계 게임 시장 규모는 84억 달러 수준 - 대한민국 게임백서 2010)는 매우 높다.

콘텐츠 산업은 타 산업에 비해 높은 고용유발 효과(10억 매출 대비 18.3명의 취업유발로 제조업의 거의 2배)가 있고, 콘텐츠 산업 내 문화서비스 분야의 고용유발 효과는 오락서비스 분야와 함께 방송, 광고, 출판서비스 등의 콘텐츠 산업 내 타 분야의 평균보다 상대적으로 높은 것으로 나타나고 있다. 특히, 새로운 형태의 체험 및 학습 형태의 콘텐츠는 ‘강남스타일(싸이)’과 같은 제2의 문화상품 기획 및 제작이 가능하여 한류 콘텐츠 제작 및 퍼포먼스 콘텐츠 분야의 세계 시장 진출 가속화를 기대할 수 있다.

이를 위해 전문가 퍼포먼스 동작의 캡쳐, 분석, 생성 기술에 대한 연구가 계속적으로 진행되어야 하며, 향후 이와 같은 핵심 기술들은 가상현실, 게임, 영화, 애니메이션 등 문화 콘텐츠 산업(디지털 액터 분야) 전반의 SW 상품화에 크게 기여할 수 있다. 특히, 저가 RGB-D 카메라 시스템은 산업용 3D 비전 시스템, 교통통제 시스템, 얼굴인식 등의 보안 시스템 등에 적용이 가능하고, 체험활동 활성화로 관련 장비, 용품, 시절, 서비스 시장의 동반 성장이 가능할 것으로 예상된다.

약어 정리

AR Augmented Reality

BMN Benesh Movement Notation

CMOS Complementary Metal-Oxide-Semicon-ductor

EWMN Eshkol-Wachman Movement Notation

GPU Graphics Processing Unit

MDB Motion Database

MR Mixed Reality

RGB-D Red, Green, Blue-Depth

TOF Time-of-Flight

UI User Interface

UX Uxinteractive

VR Virtual Reality

W. Kim et al., “A 1.5Mpixel RGBZ CMOS image sensor for simultaneous color and range image capture,” ISSCC IEEE, 2012, pp. 392-394.

E. de Aguiar et al., “Performance capture from sparse multi-view video,” ACM Trans. Graph., vol. 27, no. 3, 2008, pp. 1–10.

Y. Liu et al., “Markerless motion capture of interacting characters using multi-view image segmentation,” CVPRIEEE, 2011, pp. 1249-1256.

J. Gall et al., “Motion Capture Using Joint Skeleton Tracking and Surface Estimation,” IEEE Conf. Comput. Vision Pattern Recognition, 2009.

K. W. Sok et al., “Editing Dynamic Human Motions via Momentum and Force,” ACM SIGGRAPH / Eurographics Symposium Comput. Animation, 2010, pp. 11-20.

K. H. Lee, M. G. Choi, and J. Lee, “Motion patches: building blocks for virtual environments annotated with motion data,” ACM Trans. Graph., vol. 25, no. 3, 2006, pp. 898-906.

F. Wu et al., “Video-based Characters - Creating New Human Performances from a Multi-view Video Database,” ACM Trans. Graph., vol. 30, no. 3, 2011, pp. 32:1-32:10.

X. Wei, J. Min, and J. Chai, “Physically-valid Statistical Motion Models for Human Motion Generation,” ACM Trans. Graph., vol. 30, no. 3, 2011, pp. 19:1-19:10.

J. Min, Y-L Chen, and J. Chai, “Interactive Generation of Human Animation with Deformable Motion Models,” ACM Trans. Graph., vol. 29, no. 1, 2009, pp. 9:1-9:12.

Y. Kim and M. Neff, “Automating Expressive Locomotion Generation,” Trans. Edutainment VII, 2012, pp. 48-61.

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.