전영득 (Jeon Y.-D.) 기술사업화지원팀 선임연구원

여준기 (Lyuh C.-G.) 혼성신호처리연구실 실장

I. 서론

사람은 User Interface(UI)를 통해 기기와 접촉하고, 활용하며, 서비스를 제공받는다. 초기 컴퓨터에서 사용된 펀칭카드에서부터, 지속적으로 사용되고 있는 키보드/마우스/Graphical User Interface(GUI)뿐만 아니라, 터치 등 다양한 UI들이 개발되고 사용되었다.

대부분의 입력도구들은 사용자의 접촉이 필요하다. 사람의 손을 이용하여 키를 누르거나, 화면에 손을 터치하거나, 기기 자체를 움직이는 등의 동작을 통해 사용자의 의도를 시스템에 전달하게 된다. 접촉을 수반한 입력방법들은 사용에 익숙하고, 정확한 의도를 전달할 수 있는 장점이 있으나, 요리나 수술을 하는 경우와 같이 해당 기기에 접촉이 불가능하거나, 운전할 때와 같이 휴대폰을 주시할 수 없는 경우에는 사용자의 의도를 전달할 수 없는 단점이 있다. 이를 극복하기 위해서는 접촉이 필요 없는 UI가 필요하다.

여기서는 사람의 동작이나 사물의 움직임을 통한 UI 기술인 제스처 센싱기술 중에서 적외선 근접센서를 사용하는 기술에 초점을 맞추어 관련 기술동향과 제품동향을 살펴보고, 휴대기기에 적용하기 위하여 다른 센서들과 집적함으로써 초소형으로 개발된 제스처 센서기술을 소개한다.

Ⅱ. 제스처 센싱기술 동향

사람의 동작이나 사물의 움직임을 인식하는 제스처 센싱의 기술은 가속도 센서를 이용하는 방법, 일반적인 이미지 센서를 사용한 방법과 적외선 이미지 센서를 사용하는 방법, 최근 스마트폰에 기본적으로 탑재된 근접센서를 기반으로 하는 방법 등, 다양한 방면으로 개발되고 있다.

1. 가속도 센서를 이용한 제스처 인식

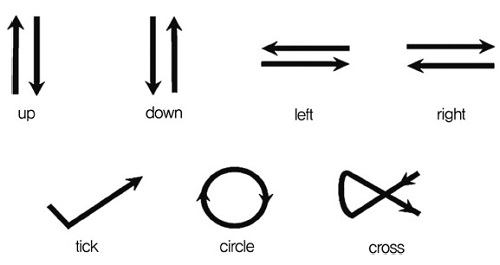

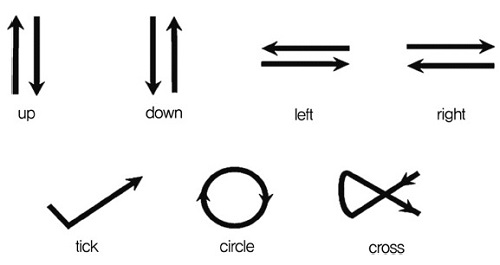

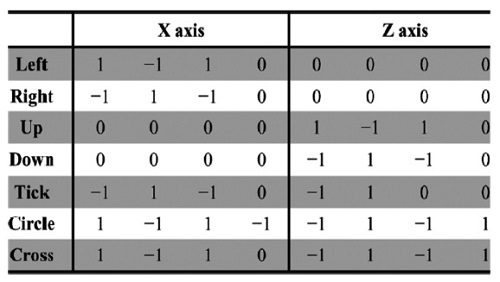

물체의 움직임을 인식하기 위해 사용되는 대표적인 센서는 가속도 센서이다. R. Xu 등은 Microelectromechanical Systems(MEMS) 3축 가속도 센서를 이용하여 (그림 1)과 같은 7가지의 움직임을 인식하는 연구를 수행하였다[1]. 이들은 움직임 인식을 위해 3축의 가속도를 +/0/-로 인코딩하고, 3가지의 인식 모델을 만들고 이를 비교하였다. (그림 2)는 3번째 모델에서 사용한 코드 테이블이며, 이를 이용하여 제스처를 인식하였을 때 7가지 제스처에 대해 95.6%의 인식률을 얻었다. 이러한 가속도 센서를 이용한 제스처 인식은 센서가 탑재된 기기를 직접 움직여 기기의 움직임을 인식하기 때문에 손으로 기기를 쥐어야 하거나 몸에 기기를 부착하는 등의 부담이 있다.

2. 이미지 센서를 이용한 제스처 인식

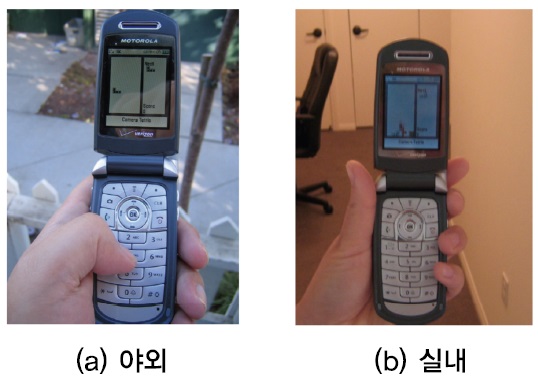

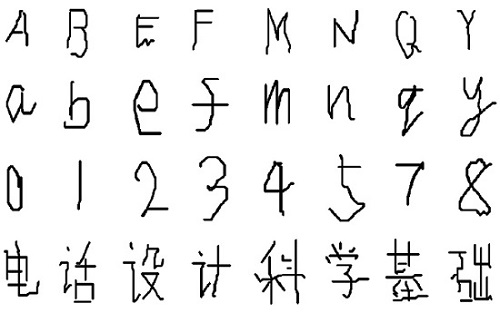

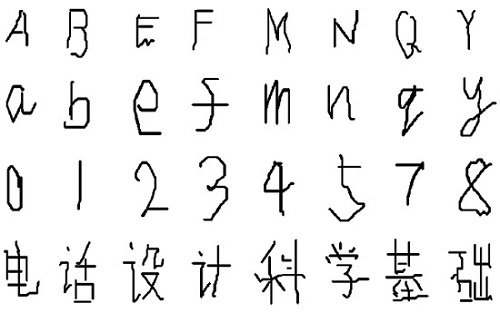

J. Wang 등은 휴대폰에 탑재된 카메라로 영상을 받아들이고, 휴대폰의 이동이나 회전 등의 제스처가 발생했을 때 이미지 센서로부터 입력되는 영상의 변화를 분석함으로써 휴대폰의 움직임을 인식하는 연구를 수행하였다[2]. (그림 3)은 이들이 개발한 TinyMotion이 실외와 실내에서 정상으로 동작함을 보여준다. 실내외 각각 2가지의 조명 조건하에서 상/하/좌/우 방향으로 시프트/틸트 동작을 각각 50회씩 수행했을 때의 인식률은 각각 97.5%, 99.5%, 100%, 99.75%를 가졌다. 그리고 TinyMotion을 기반으로 하여 사용자가 키패드의 숫자버튼을 누른 상태에서 휴대폰을 움직임(틸트)으로써 움직이는 방향에 따라 다른 텍스트가 입력되도록 하여 더욱 빠르게 텍스트 입력을 가능하게 하는 Vision TiltText와 (그림 4)와 같은 텍스트 핸드라이팅도 구현하였다. 이 방법을 통한 제스처 인식도 가속도 센서를 이용한 방법과 같이 이미지 센서가 탑재된 기기를 직접 움직여 기기의 움직임을 인식하기 때문에 손으로 기기를 쥐어야 하는 부담이 있으며, 이미지 센서는 기본적으로 가속도 센서에 비해 크기, 신호처리 등의 부담이 크다고 할 수 있다.

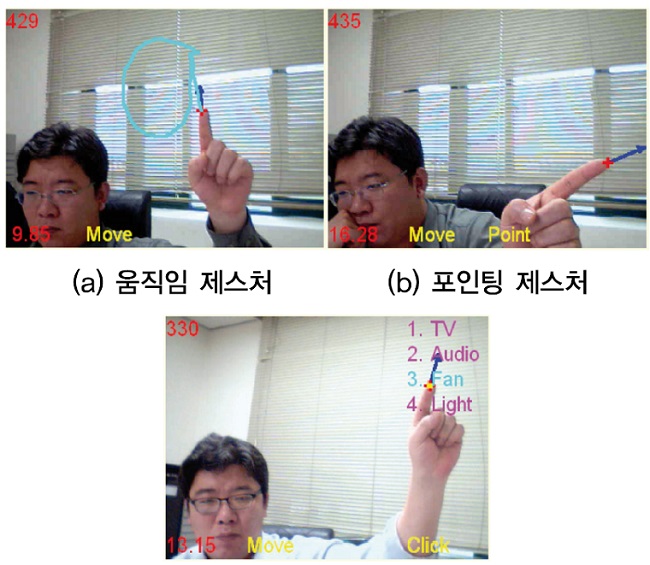

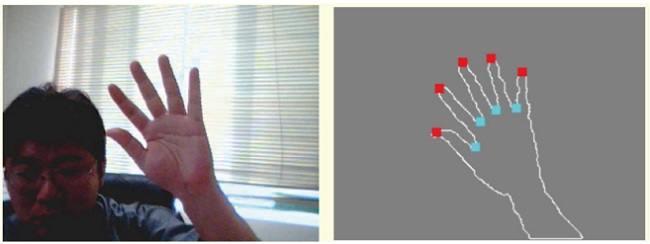

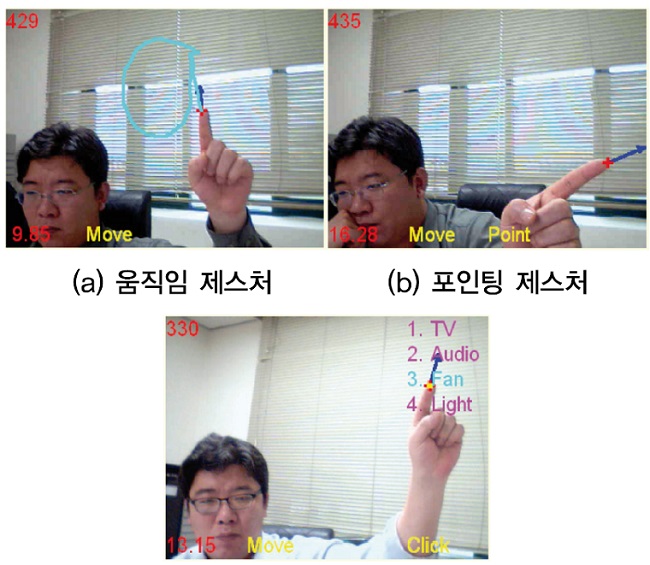

D. Lee 등은 단순히 기기의 움직임 정도의 제스처를 넘어서 다양한 명령을 처리하려는 방법으로 이미지 센서에 의해 입력된 손가락의 움직임을 인식하는 방법을 연구하였다[3]. 이들은 영상에서 색깔정보를 이용하여 피부의 영역을 검출하고, 입력된 영상 내에서 크기와 상관없이 각도를 검출하는 방법으로 손가락 끝을 검출하는 방법을 제안하였다. (그림 5)는 영상으로부터 손의 영역과 손가락을 검출한 결과를 보여주며, 손 영상에서 손가락 끝을 카운팅하는 실험은 98.4%의 인식률을 보였으며, 이렇게 검출된 손가락 끝을 추적함으로써, 움직임, 클릭, 포인팅 등의 제스처를 인식하도록 하였다. (그림 6)은 움직임 제스처, 포인팅 제스처, 클릭 제스처의 인식 예를 보여준다. 이 연구와 같이 이미지 센서를 사용하여 제스처를 인식하게 되면 다양한 움직임을 구분함으로써 다양한 사용자 입력을 가능하게 할 수 있으나, 이미지 처리에 대한 연산량에 대한 부담이 커서 휴대기기에는 적합하지 않다.

3. IR 카메라를 이용한 모션인식

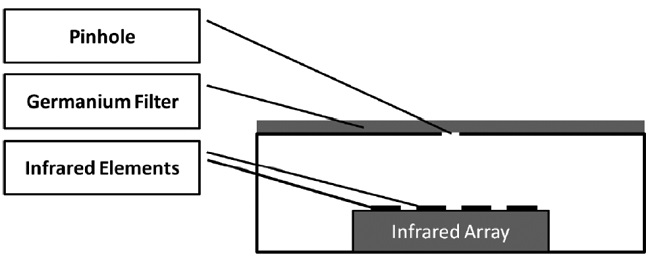

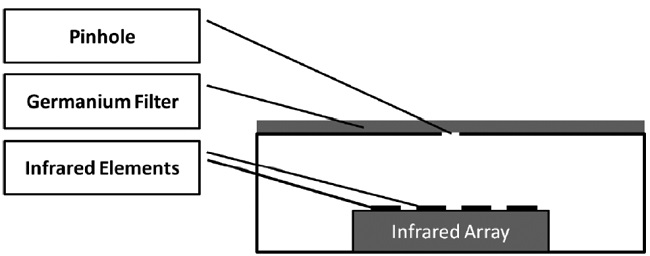

P. Wojtczuk 등은 적외선 Light-Emitting Diode(LED)를 사용하지 않고, 물체에서 방사되는 적외선을 감지하는 Passive Infrared(PIR) 센서를 (그림 7)과 같은 광학구조로 이용하여 손의 움직임을 인식하는 연구를 수행하였다[4]. 그리고 사람 카운팅에도 쓰이는 알고리즘을 사용하여 손동작의 방향을 인식하였다. 이러한 방법으로 20cm 거리에서의 상/하/좌/우 각 방향에 대해 제스처를 25회씩 테스트하여 평균 81.4%의 검출률과 92.6%의 정확도를 보였다. 이렇게 PIR을 이용한 제스처 인식은 추가적인 광원을 사용하지 않기 때문에 LED를 사용하는 방식에 비해 전력소모를 줄일 수 있는 장점은 있으나 인식률은 상대적으로 떨어지게 된다.

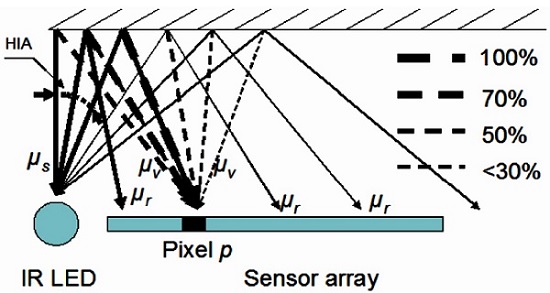

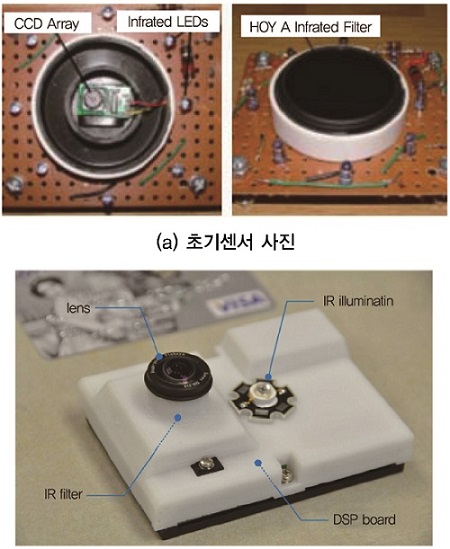

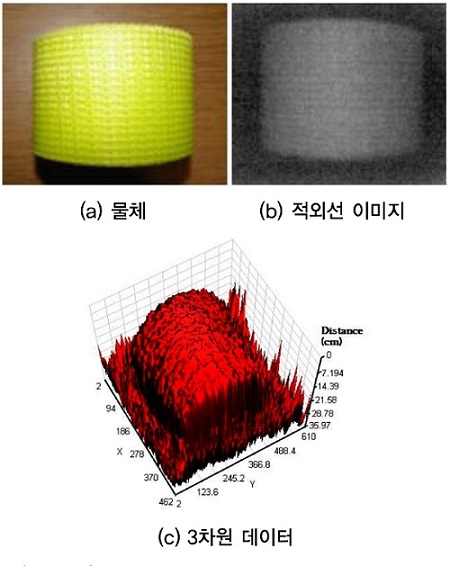

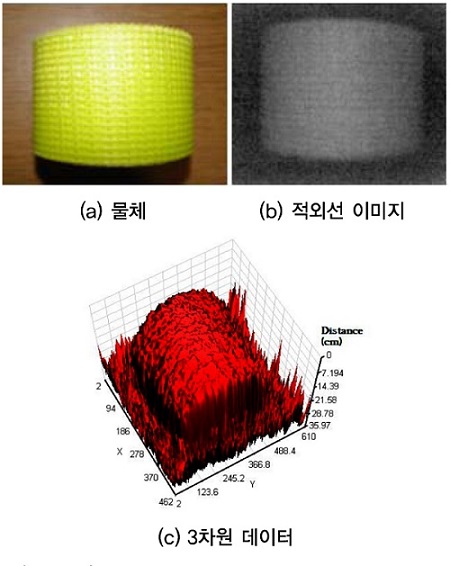

D. Um 등은 적외선 근접 어레이 센서를 개발하여 물체의 3차원 정보를 추출하는 연구를 수행하였다[5]. 이들은 (그림 8)과 같이 적외선 LED와 어레이로 구성된 Photo Diode(PD)를 이용하여 LED에서 발광된 적외선이 물체에 반사되어 PD로 들어오는 양을 측정함으로써 물체의 3차원 정보를 추출하였다. 이러한 적외선 근접 어레이 센서를 이용하게 되면 스테레오 카메라에서 주로 문제로 제기되는 카메라 배열 변화에 의한 보정 이슈를 극복할 수 있다. (그림 9a)는 초기에 개발된 적외선 근접 어레이 센서이며, (그림 9b)는 D. Ryu 등에 의해 개선된 적외선 근접 어레이 센서이다[6]. (그림 10)은 적외선 근접 어레이 센서를 이용하여 얻은 적외선 이미지와 3차원 데이터를 보여준다.

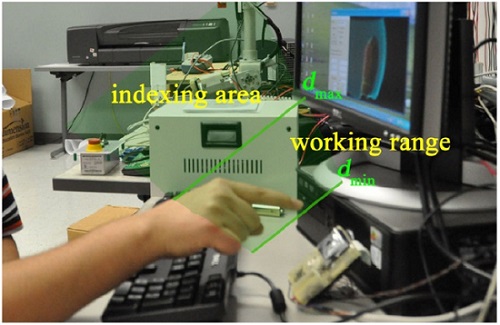

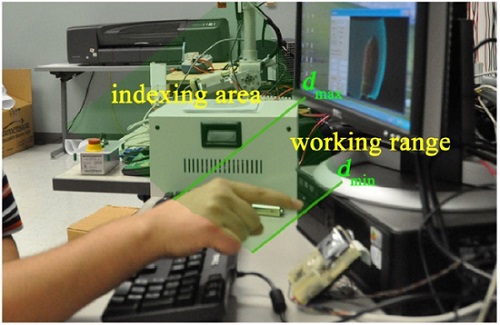

D. Ryu 등은 이렇게 개발된 적외선 근접 어레이 센서를 사용하여 접촉하지 않고 사용자 입력이 가능한 인터페이스인 T-less를 개발하였다[6]. 이들은 먼저 손가락 입력모드와 손바닥 입력모드를 구분하였으며, 손가락 입력모드에서는 (그림 11)과 같이 50mm에서 150mm 거리의 영역을 작업영역, 그보다 먼 거리를 인덱싱 영역으로 구분하여, 작업영역에서의 손가락 움직임을 마우스 이동에 대응하고, 손가락을 센서로 더 가까이 이동하면 클릭 동작에 대응하도록 하였으며, 이와 유사하게 손바닥 입력모드도 구현하였다. 이 시스템을 이용함으로써 접촉이 없는 사용자 입력이 가능하고, 3차원에 대한 입력이 가능하며, 마우스 포인팅과 같은 정확한 입력이 가능하다는 장점이 있으나, 사용자의 명령 입력시간이 길어지는 단점과 함께, 마우스에 비해 처리해야 하는 연산량도 많아서 휴대기기에 적용하기에는 어려움이 있다.

4. 다수의 적외선 LED를 사용하는 적외선 근접센서 기반 제스처 인식

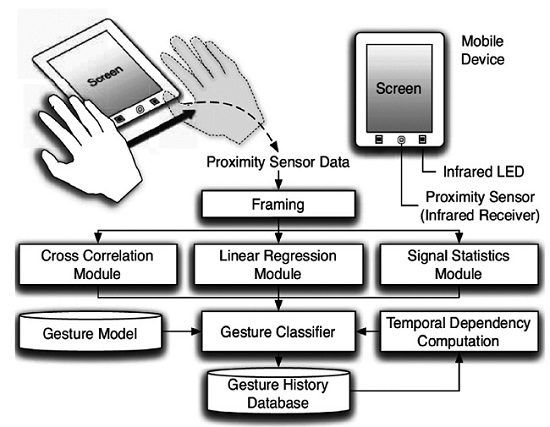

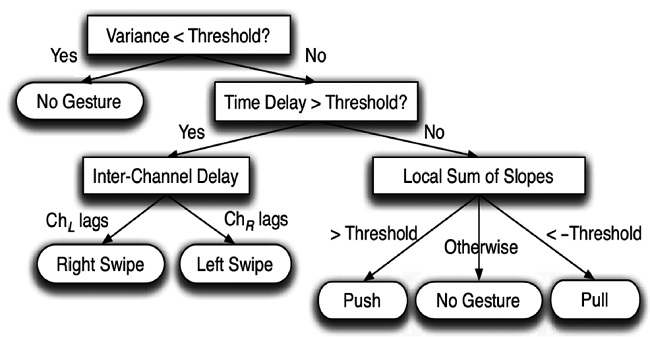

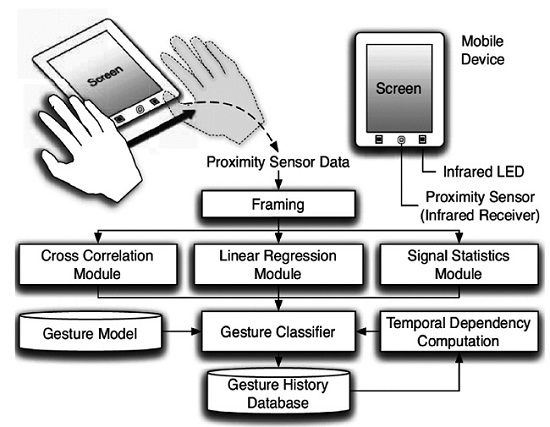

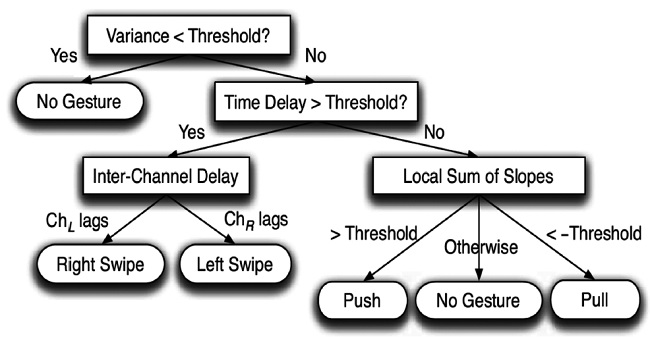

제스처 인식을 휴대기기에 적용하기 위해 적외선 LED와 PD를 최소한으로 사용하면서 제스처를 인식하는 연구들이 다양하게 이루어졌다. H.-T. Cheng 등은 기존 휴대기기에 탑재되고 있었던 적외선 근접센서를 기반으로 2개의 적외선 LED를 사용하여 좌/우 제스처와 푸쉬/풀 제스처를 인식하는 연구를 수행하였다[7]. (그림 12)는 이들이 제안한 제스처 인식 시스템 구조를 보여준다. 이들은 2개의 적외선 LED를 채널로 구분하여 100Hz로 샘플링 한 후 (그림 13)의 알고리즘을 이용하여 제스처를 인식하였다. 테스트를 위해 총 2000개의 제스처 샘플을 이용하였고, 평균 98%의 정확도를 보였으며, 20mW의 전력을 소모하였다. 이처럼 기존의 높은 해상도를 갖는 이미지 센서를 사용하지 않음으로 기존보다 낮은 전력소모를 가지면서도 높은 인식률로 제스처를 인식할 수 있게 하였으나, 적외선 LED에서 소모되는 전력을 무시할 수 없다.

5. 다수의 PD를 이용하는 적외선 근접센서 기반 제스처 인식

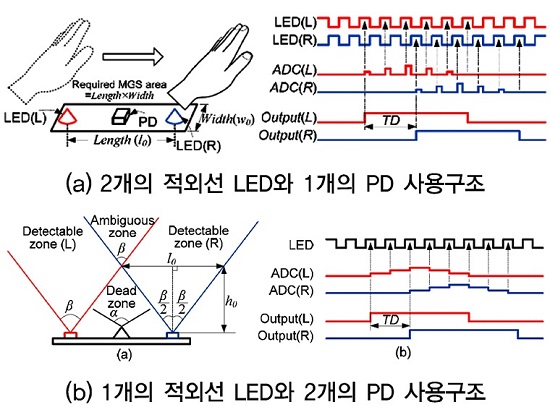

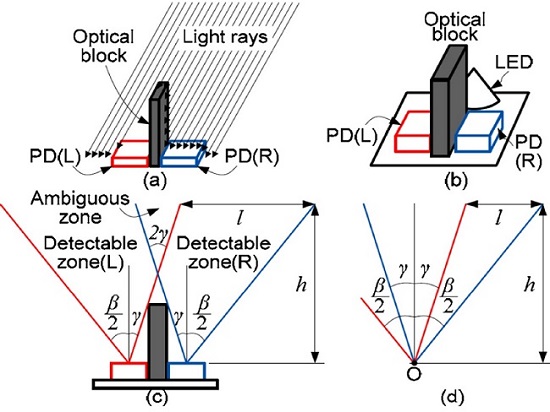

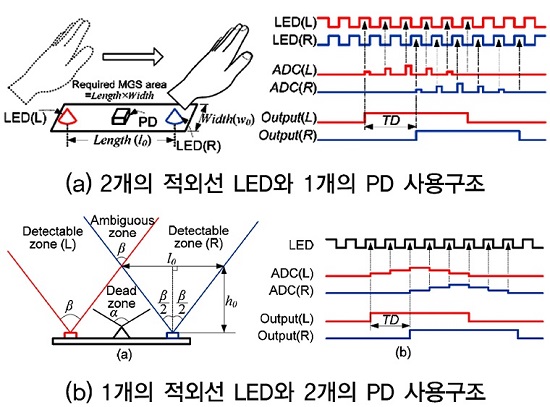

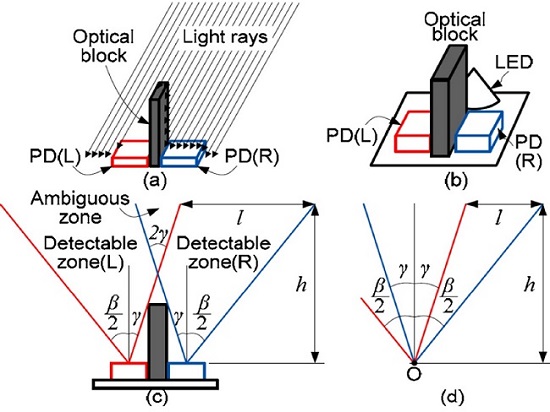

Y.S. Kim은 적외선 LED에서 소모되는 전력소모를 줄이기 위해 적외선 LED를 하나로 줄이고, PD를 다수 개 사용하는 연구를 수행하였다[8]. (그림 14)는 이러한 적외선 LED와 PD의 수에 따른 신호검출의 차이를 보여준다. 이들은 여기에서 한 단계 더 나아가 시스템의 크기를 줄이기 위해 광학블록을 사용하는 방법을 제안하였다. (그림 14b)에서 보는 바와 같이 PD의 간격이 줄어들면 ambiguous zone이 넓어지게 되고, 이로 인해 제스처의 방향 판단이 어려워진다. 이들은 (그림 15)와 같이 PD를 가까이 배치하면서 PD 사이에 광학블록을 배치함으로써 ambiguous zone을 좁히는 방법을 제안하였다. 이들의 실험결과에서는 검출하고자 하는 물체의 크기에 따라 99.5%의 정확도로 인식하기 위한 최소 샘플링 주파수를 제시하고 있으며, 물체의 가로폭은 클수록, 세로폭은 작을수록 최소 샘플링 주파수는 커지는 경향이 있다. 이러한 방법으로 전력소모는 52%, 사이즈는 69% 수준으로 줄일 수 있다.

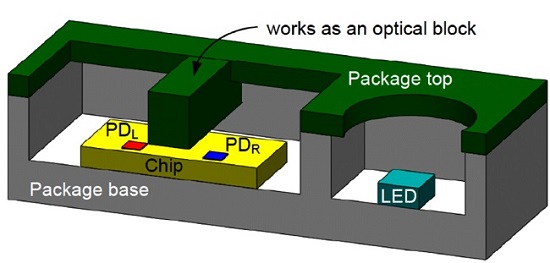

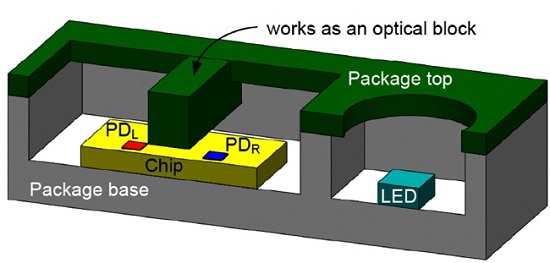

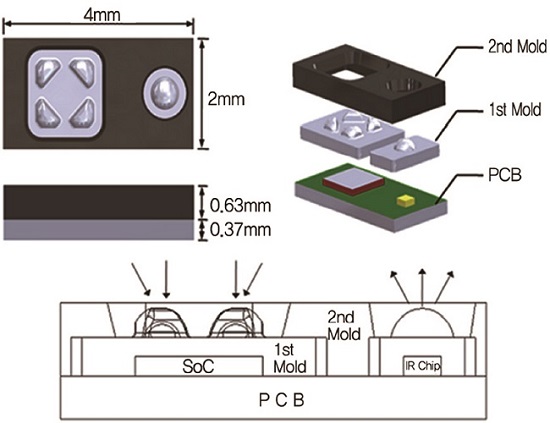

K.-H. Kong 등은 이러한 광학블록에 의한 추가 공정의 부담을 줄이기 위해 패키지를 이용하는 방법을 제안하였다[9]. (그림 16)은 이들이 제안한 제스처 센서의 구조를 보여준다. 이러한 방법으로 선행연구보다 면적은 96.2%, 높이는 71.7%로 줄일 수 있었다. 이렇게 적외선 LED와 PD의 조합으로 적은 비용과 면적과 전력소모로 높은 인식률의 제스처 인식이 가능하며, PD를 추가로 배치할 경우 좌/우 방향의 제스처뿐만 아니라 상/하 방향의 제스처도 인식이 가능하다.

III. 제스처 센싱제품 동향

스마트폰은 대부분 가속도 센서, 지자기 센서, 자이로스코프 센서를 탑재하고 있다. 삼성전자의 갤럭시 S에서는 가속도 센서와 나침반 센서를 탑재하였고, 2011년에 출시한 갤럭시 SII 모델부터는 자이로스코프 센서까지 모두 탑재하고 있다. 이러한 센서들을 통해 스마트폰을 직접 움직임으로써 사용자의 입력을 받는 기능이 제공된다.

또한, 카메라와 근접센서를 이용한 제스처 인식기술도 제품에 적용되었다. 스마트폰 자체에서 기능을 제공하는 제품도 있으며, 앱을 통해 이러한 제스처 인식기능을 제공하기도 한다.

1. 카메라를 이용한 제스처 인식지원 스마트폰과 앱

카메라를 이용하여 제스처를 인식함으로써 접촉이 필요 없는 사용자 인터페이스를 제공하는 세계 최초의 휴대폰은 2011년 11월에 팬택에서 출시한 스카이 베가 LTE 모델이다[10]. (그림 17)은 이러한 접촉이 필요 없는 사용자 인터페이스를 보여주는 영상이다. 전면의 카메라를 통해 사용자의 손동작을 인식하여, 스피커 통화를 하거나, 음악재생의 조작 등을 가능하게 하였다. 2011년 12월에는 카메라를 이용하여 제스처를 인식함으로써 사용자의 접촉 없이 전화를 받을 수 있는 기능을 지원하는 안드로이드 플랫폼용 앱도 출시되었다[11]. 이 앱은 초기에는 유료로 출시되었다가 무료로 전환되었다.

2. 근접센서 및 적외선 센서를 이용한 제스처 인식지원 스마트폰과 앱

근접센서를 이용하여 제스처를 인식함으로써 사용자의 접촉 없이 전화를 받을 수 있는 기능을 지원하는 앱도 다수 출시되었다. 하지만 이러한 앱들은 단순히 하나의 LED와 하나의 PD를 사용한 근접센서를 사용하기 때문에, 사용자의 다양한 제스처를 구분할 수는 없으며 사용자의 근접 여부만을 판단함으로써 단순한 기능만 제공한다.

제스처 인식이 가능한 부품을 탑재함으로써 본격적인 제스처 인식기능을 제공하는 스마트폰 제품들도 출시되었다. 2013년 4월에 출시된 삼성전자 갤럭시 S4 스마트폰은 이러한 제스처 센서를 탑재하였고, 에어뷰/에어 제스처라는 이름으로 홍보하였다[12]. (그림 18)은 삼성전자 갤럭시 S4의 에어뷰/에어 제스처 소개 그림이다. 에어뷰는 손가락을 화면 가까이에 가져감으로써 내용을 미리 볼 수 있도록 하는 기능이며, 에어 제스처는 제스처 센서 위에서 손을 움직임으로써 전화를 받거나 음악을 컨트롤 하는 등의 기능을 제공한다. 이러한 제스처 인식기능은 다음 모델인 갤럭시 S5까지만 탑재되었고, 이후 모델인 갤럭시 S6에는 탑재되지 않았다. 이는 사용자의 제스처 인식기능이 터치보다 부정확하고, 반응도 느리며, 스마트폰의 일반적인 활용 상황에서는 이미 한 손으로는 스마트폰을 잡고 있을 경우가 대부분이므로 이러한 접촉이 없는 사용자의 입력 필요성이 낮기 때문으로 보인다.

IV. 초소형 제스처 센싱기술

1. 구조

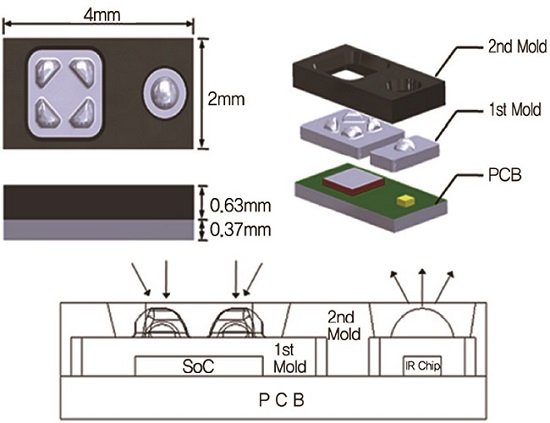

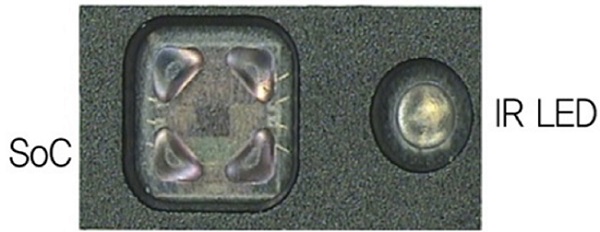

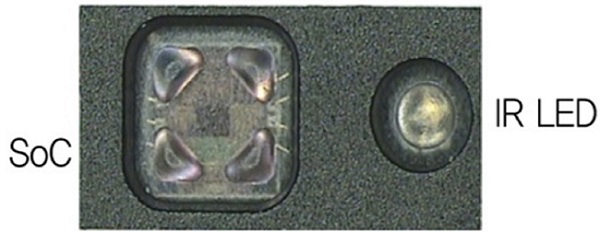

(그림 19)는 모바일 단말에서 조도, 근접거리 및 모션 제스처 센싱을 위해 제작된 Ambient light, Proximity and Motion Gesture Sensor(AP-MGS1))구조를 나타낸다. 물체에 의한 적외선 반사광을 수신하기 위한 PD 어레이 및 조도, 근접거리, 모션 신호처리 회로가 집적화된 SoC와 적외선 발광을 위한 적외선 LED 칩이 초소형 단일 패키지(가로 4mm, 세로 2mm, 높이 1mm)로 제작되었다. 단일 패키지는 1차 몰드, 2차 몰드 및 PCB로 구성된다. 1차 몰드는 SoC 내부에 있는 PD 어레이에 적외선 반사광을 집광하기 위한 수광 렌즈와 적외선 LED 칩에서 발광하는 적외선이 view angle 안에서 일정한 분포를 가질 수 있도록 하는 볼록 구면렌즈로 이루어졌다. 2차 몰드는 전체 센서 모듈을 보호하고 특히 적외선 LED 칩에서 적외선이 SoC로 누설되지 않도록 차폐한다.

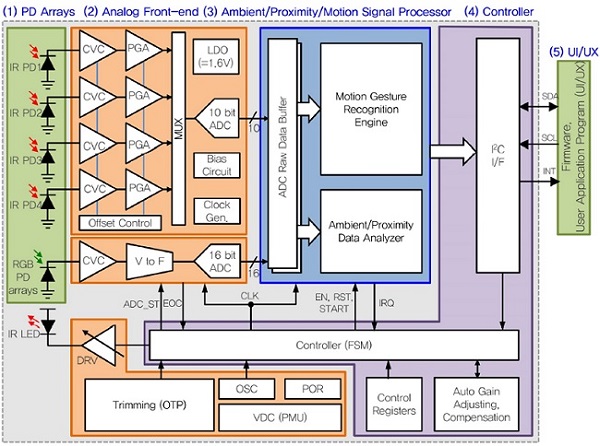

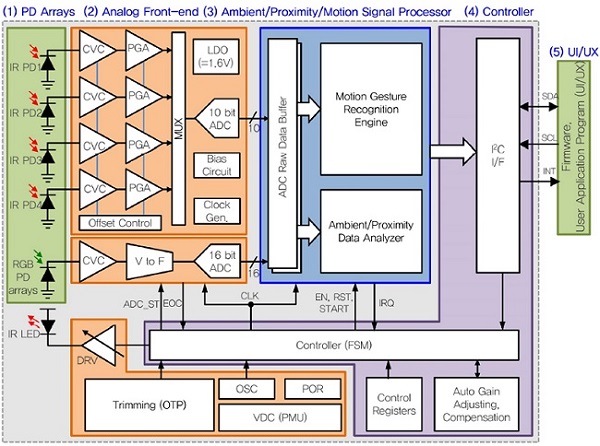

(그림 20)은 적외선 PD 어레이, Analog Front End (AFE), 조도, 근접거리, 모션 제스처 신호처리부로 구성된 SoC 세부 블록도를 나타낸다. PD 어레이는 근접 및 모션 제스처 센싱을 위한 4개의 PD와 조도센싱을 위해 칼라필터를 사용한 10×10 PD들로 구성된다. AFE는 10kHz로 25mA~200mA에서 적외선 LED를 구동하기 위한 드라이버와 PD에서 수신된 신호를 처리하기 위한 Current-to-Voltage Converter(CVC), Programmable Gain Amplifier(PGA), 4-1 MUX, 10 bit ADC, 바이어스 회로 및 클럭 발생기로 이루어져 있다. 그리고, 상/하/좌/우/푸쉬 등의 손동작 제스처를 인식하는 저전력/저면적의 디지털 엔진을 포함한다.

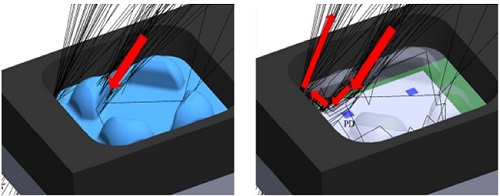

2. 광학기술

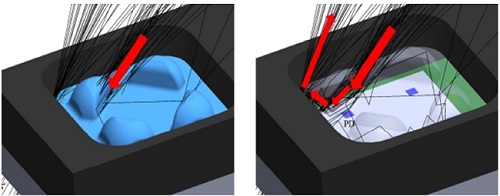

모션 제스처의 인식률을 높이고 센싱거리를 높이기 위해서는 정교한 광학기술을 필요로 한다. 우선 적외선 LED의 발광 도달거리를 높이기 위하여 볼록렌즈로 집광하면서 적외선의 분포가 일정할 수 있도록 적외선 LED 칩 위에 투명 에폭시를 사용하여 렌즈를 제작한다. 적외선 LED 칩 위쪽 160µm(패키지 제약에 의한 최대 거리)에 렌즈를 위치시킨 조건에서 레이 트레이싱 시뮬레이션을 통해 ±30°의 view angle에서 일정한 레이 분포를 가지도록 구면렌즈의 반지름 및 곡률을 결정하였다. (그림 21)은 SoC의 상하좌우 각 모서리에 있는 수광용 PD를 위한 렌즈제작 시뮬레이션을 보여준다. 수광부에서도 집광을 하여 수신 거리를 높일 수 있다. 또한, 상하좌우 움직임에 의해 각 4개 PD의 수신 광량의 차이가 커질 수 있도록 렌즈 각 안쪽 면을 절단하였다.

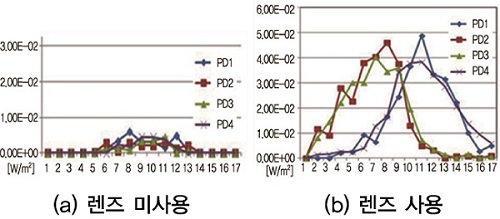

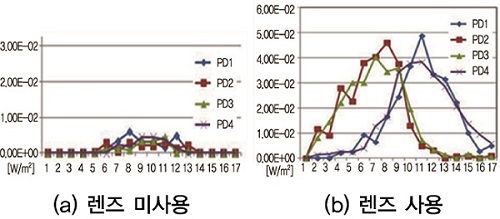

(그림 22)는 좌에서 우로 물체가 움직였을 때 수광부 PD의 렌즈 유무에 따른 출력 값의 차이를 나타낸다. 렌즈를 사용한 경우, 좌측의 적외선 센서들(PD2, PD3)과 우측의 적외선 센서들(PD1, PD4) 간의 신호차이가 큰 것을 알 수 있고 이로 인해 인식률을 높일 수 있다.

3. 아날로그 회로 기술

작은 크기의 PD에 의해 생성되는 전류는 nA급으로 미세하고 잡음에 민감하여서 증폭기와 필터가 필요하며 신호처리를 위한 디지털 변환도 요구된다. 4채널의 PD 신호를 저전력 저면적으로 처리하기 위하여 MOS 문턱전압 기반의 바이어스 회로를 이용한 전류/전압 변환기, 스위치 커패시터 구조의 프로그래머블 증폭기 및 4채널 공유형 Successive Approximation Register-Analog-to-Digital Converter(SAR-ADC)를 적용하였다.

4. 디지털 신호처리 및 회로 기술

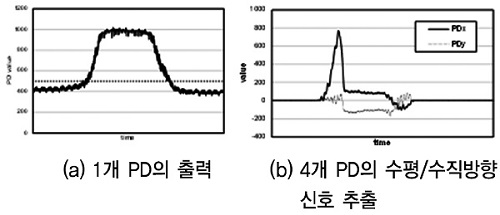

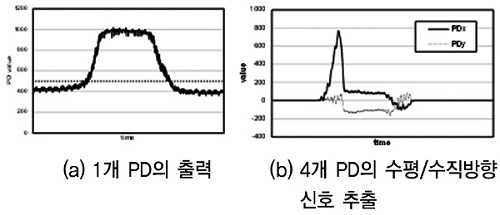

4개 PD의 출력으로부터 상하좌우/푸쉬 제스처를 실시간 인식하기 위한 엔진을 탑재하였다. (그림 23a)는 물체가 좌에서 우로 움직였을 때 1개의 PD에서 발생하는 출력을 나타내며 일반적으로 모션이 없더라도 PD 출력 값은 ‘zero’보다 큰 값이 출력된다. 점선으로 표시된 문턱 값을 적용하여 그 이하는 ‘zero’로 처리하고, ‘zero’보다 클 경우에만 인식 엔진이 동작하도록 제어한다.

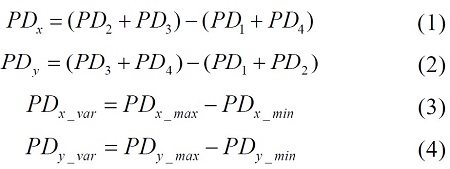

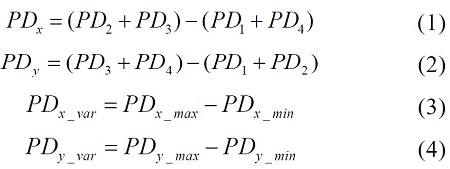

PD1, PD2, PD3, PD4에 의한 수평방향 신호 값 PDx와 수직방향 신호 값 PDy는 식 (1)과 (2)으로 정의되고 예를 들면 (그림 23b)와 같다. 식 (3)과 (4)로 정의되는 PDx의 변화폭(PDx_var)과 PDy의 변화폭(PDy_var)을 이용하여 모션 제스처의 방향을 인식할 수 있다.

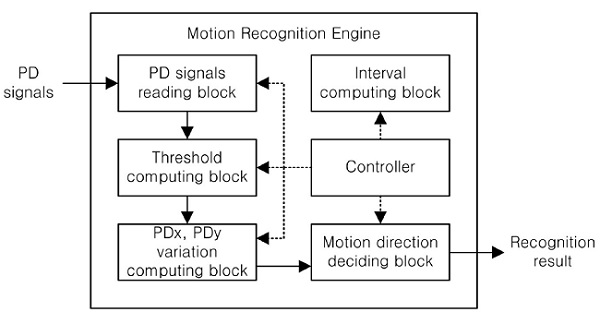

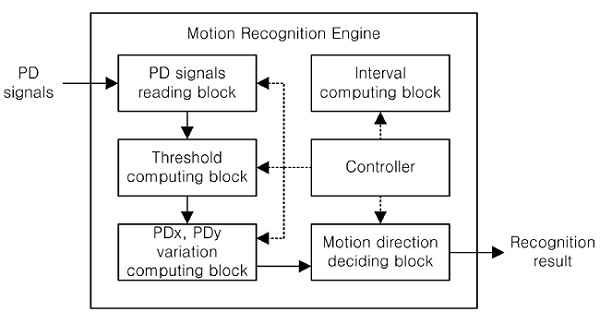

(그림 24)는 모션 제스처 인식 엔진의 블록도를 나타내고 덧셈기, 뺄셈기, 비교기 및 간단한 제어 로직으로 설계되었다. 0.18µm CMOS 공정에서 19,060µm2 의 저면적으로 제작되었고 10µW 이하 전력소모로 실시간으로 모션 제스처를 인식할 수 있다.

5. 개발 결과

가. 패키지, SoC 및 광학부

(그림 25)는 개발된 AP-MGS의 top-view 사진이다. 가로 4mm, 세로 2mm, 높이 1mm의 단일 패키지로 제작되었고, 제작된 SoC와 상용 적외선 LED 칩 크기는 각각 1.2mm×1.3mm와 0.355mm×0.355mm이며, 렌즈에 의한 FOV는 ±30° 이다.

나. 조도 및 근접센서

조도 센서는 최대 65,000lux 측정가능하고, 근접센서의 최대 감지거리는 15cm이다.

다. 모션 제스처 센서

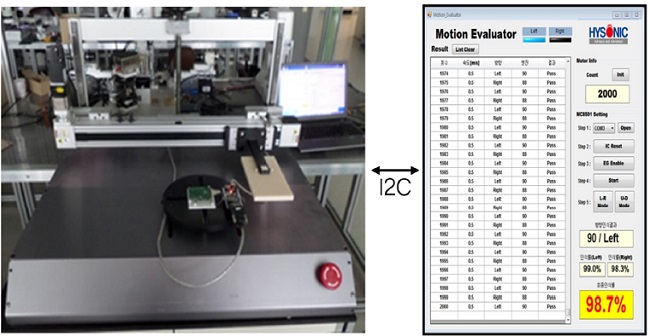

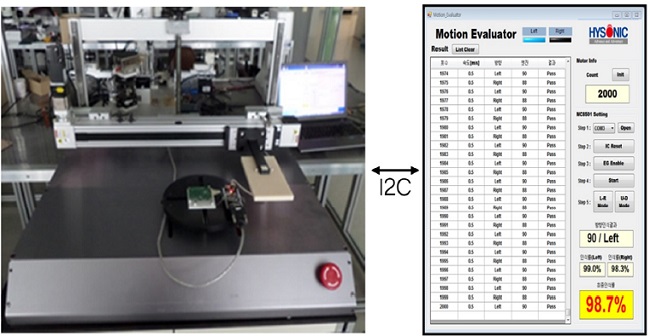

인식률 측정은 Telecommunications Technology Association(TTA) 표준 ‘적외선 발광다이오드를 이용한 손동작 인식 SoC의 인식률 측정 지침’에 준하여 (그림 26)과 같은 자동측정방법을 사용하였다. 0.5m/s의 손동작에 대하여 10kHz 샘플링 주파수에서 좌우 98.7%, 상하 98.8%의 인식률을 가지며, 적외선 LED 구동 전류를 제외하고 250µA의 동작 전류를 소모한다.

V. 결론

사용자는 다양한 환경에서 여러가지 기기들을 사용한다. 이러한 환경의 차이와 요구의 다양성으로 인해 각각의 상황에 적합한 다양한 UI들이 개발되고 있다. 본 논문에서는 접촉이 없이 사용자의 제스처 만으로 명령을 전달하는 제스처 센서의 연구 및 제품 적용동향을 소개하였다. 이러한 제스처 인식기능은 스마트폰에 적용되기도 하였으나 지속적으로 적용되지는 않았다. 하지만, 요리하는 주방이나 수술실 등과 같은 특수한 환경에서는 여전히 접촉이 없는 사용자의 입력에 대한 요구가 존재하고 있으므로, 이에 대응하기 위한 연구개발이 지속될 것으로 보인다.

약어 정리

AFE

Analog Front End

AP-MGS

Ambient light, Proximity and Motion Gesture Sensor

CVC

Current-to-Voltage Converter

GUI

Graphical User Interface

LED

Light-Emitting Diode

MEMS

Microelectromechanical Systems

PD

Photo Diode

PGA

Programmable Gain Amplifier

PIR

Passive Infrared

SAR-ADC

Successive Approximation Register-Analog-to-Digital Converter

TTA

Telecommunications Technology Association

UI

User Interface

References

(그림 1)

가속도 센서 기반 인식 제스처<a href="#r001">[1]</a>

(그림 2)

제스처 인식을 위한 코드 테이블<a href="#r001">[1]</a>

(그림 3)

실외와 실내에서의 TinyMotion 동작 예<a href="#r002">[2]</a>

(그림 4)

TinyMotion을 이용한 핸드라이팅 입력 예<a href="#r002">[2]</a>

(그림 5)

이미지 센서 영상에서의 손가락 끝 검출 결과<a href="#r003">[3]</a>

(그림 6)

움직임, 포인팅, 클릭 제스처<a href="#r003">[3]</a>

(그림 7)

PIR 센서를 이용하여 제스처 인식을 하기 위한 광학구조<a href="#r004">[4]</a>

(그림 8)

물체에 의해 반사된 적외선<a href="#r005">[5]</a>

(그림 9)

적외선 근접 어레이 센서<a href="#r005">[5]</a><a href="#r006">[6]</a>

(그림 10)

적외선 근접 어레이 센서를 이용하여 얻은 3차원 데이터<a href="#r005">[5]</a>

(그림 11)

손가락 입력모드에서의 입력영역 구분<a href="#r006">[6]</a>

(그림 12)

제스처 인식 시스템 구조<a href="#r007">[7]</a>

(그림 13)

제스처 판단 알고리즘<a href="#r007">[7]</a>

(그림 14)

적외선 LED와 PD의 수에 따른 신호검출 차이 비교<a href="#r008">[8]</a>

(그림 15)

Ambiguous Zone을 줄이기 위한 광학블록 배치<a href="#r008">[8]</a>

(그림 16)

패키징을 이용한 광학블록 구조<a href="#r009">[9]</a>

(그림 17)

접촉이 필요 없는 사용자 인터페이스<a href="#r010">[10]</a>

(그림 18)

삼성전자 갤럭시 S4 에어뷰/에어 제스처<a href="#r012">[12]</a>

(그림 19)

AP-MGS의 패키지 및 내부 구조도<a href="#r013">[13]</a>

(그림 20)

AP-MGS의 SoC 세부 블록도<a href="#r013">[13]</a>

(그림 21)

적외선 반사광을 집광하기 위한 렌즈 시뮬 레이션<a href="#r013">[13]</a>

(그림 22)

PD 출력 비교<a href="#r013">[13]</a>

(그림 23)

물체 움직임에 의한 PD 신호의 출력

(수식 1)

(그림 24)

모션 제스처 인식 엔진의 블록도

(그림 25)

제작된 AP-MGS의 top-view 사진<a href="#r013">[13]</a>

(그림 26)

모션 제스처 인식률 측정 환경