플렌옵틱 영상처리 기술동향

Plenoptic Image Processing Technology Trends

- 저자

- 손욱호, 장호욱, 배성준, 박성진, 김재우, 김도형 / 감성디자인콘텐츠연구실

- 권호

- 31권 4호 (통권 160)

- 논문구분

- 초지능 기술동향 특집

- 페이지

- 1-12

- 발행일자

- 2016.08.01

- DOI

- 10.22648/ETRI.2016.J.310401

- 초록

- 깊이감, 시점 등의 3차원 영상정보 제공 방법에는 양안 시차에 의한 스테레오 방식, 다시점 기반의 스테레오 방식, 라이트필드 기반의 스테레오 방식, 체적 내에 실제 발광점들을 물리적으로 형성하는 체적형 방식, 빛의 간섭과 회절현상을 이용하여 실제 물체의 파면을 재현하는 홀로그래피 방식 등이 존재한다. 본고에서는, 3차원 영상기술로써 최근 이슈화되고 있는 플렌옵틱 영상기술의 개념을 다시점 영상생성 및 재초점 기능의 관점에서 소개하고, 동시에 관련 국내외 기술개발 동향을 파악하고자 한다. 또한, 플렌옵틱 영상기술의 고도화를 위한 최신 연구개발 이슈 및 응용 가능한 서비스 시나리오에 대해 탐구해 봄으로써, 향후 플렌옵틱 영상처리 기술의 발전 및 활용도를 전망해 보고자 한다.

Share

Ⅰ. 서론

2차원 카메라 영상정보에 의존하는 기존의 영상처리기술에 비해, 플렌옵틱(plenoptic) 또는 라이트필드(light field, 光場) 영상은 공간상에서 임의의 방향으로 진행하는 빛의 정보를 제공한다. 즉, 2차원 영상을 구성하는 각 픽셀에 대하여 샘플링된 방향에 대한 빛의 세기와 컬러 정보를 제공하기에 실제 공간에서 물체들을 사실적으로 묘사하는데 아주 적합하다.

일반적으로 플렌옵틱 영상정보는 기존 2차원 영상이 가지는 공간영역(spatial domain) 정보와 동시에 방향 정보에 의한 각영역(angular domain) 정보를 가지는데, 이러한 공간영역의 깊이정보 및 각영역에 의한 광선의 추가적인 방향정보를 활용하여 원근시점 이동(pers-pective viewing change), 재초점(refocusing) 및 3차원 깊이정보 추출(depth of field extraction) 등의 다양한 영상처리를 수행할 수 있는 것이 특징이다.

깊이정보는 기존의 양안 시차 방식의 스테레오 카메라 및 깊이센서 등으로부터도 취득할 수 있지만, 이러한 카메라들은 특정 뷰포인트로부터 객체까지의 깊이정보를 제공한다. 반면에, 플렌옵틱 영상은 추가적인 광학정보를 담고 있으므로 깊이값 취득이 가능하며 동시에 광학적으로 정확한 재초점 생성이 가능하다. 구조광 방식의 카메라와는 달리 실외 환경에서의 깊이정보 처리도 가능하게 한다.

플렌옵틱 영상처리 기술에는 카메라 어레이에 의한 집적영상(integral imaging) 방식, 체적 내에 실제 발광점들을 물리적으로 형성하는 체적형 방식, 빛의 간섭효과를 이용하는 홀로그래피 방식 등이 존재한다[1][2]. 본고에서는 집적영상에 의한 플렌옵틱 영상처리 기술을 다루고자 한다.

플렌옵틱 영상의 이러한 기능들을 응용 영역에서 잘 활용하기 위해서는 해결되어야 할 기술적 난제들이 많이 존재하는데, 이에 대해서도 탐구하고자 한다. 우선, 영상 취득 단계에서 다차원인 플렌옵틱 정보를 2차원 센서(통상 디지털카메라의 Complimentary Metal-Oxide-Semiconductor(CMOS) 센서)로 취득하므로, 공간영역과 각영역 간의 상호 의존적인 관계로 인해 존재하는 해상도 제약 문제가 있다. 장착 가능한 렌즈 개수 및 크기, 그리고 디스플레이 패널의 해상도 제약에 의해 제한된 입력 영상정보량에서 각영역 해상도가 증가하면 상반되게 공간영역 해상도가 감소할 수밖에 없기 때문이다. 또한, 이러한 하드웨어적인 제약요소 외에, 응용 콘텐츠 상에서 폭넓게 활용하기 위해서는 플엔옵틱 영상정보 자체를 효과적으로 편집할 수 있는 기능들이 필요한데, 깊이정보 생성, 시점이동, 재초점, 스티칭 등의 단순한 기능에서부터 객체 분리, 삽입 및 추적 등의 고차원적 저작기능 개발이 필요하다. 그뿐만 아니라, 전 방향에서의 광 정보를 제공하는 대용량 플렌옵틱 데이터의 특성에 의해 실시간 영상처리를 위한 가속화 문제도 해결해야 된다.

본고에서는, 플렌옵틱 영상처리 기술의 국내외 기술개발 동향을 살펴보고 또한, 해당 영상기술의 콘텐츠 기술로서의 활용에 요구되는 향후 관련 기술개발 이슈 및 서비스 시나리오를 파악해봄으로써, 기존 2차원 영상이 제공하지 못하는 신차원의 콘텐츠 서비스 및 시장을 전망하고자 한다.

Ⅱ. 플렌옵틱 영상기술 개요

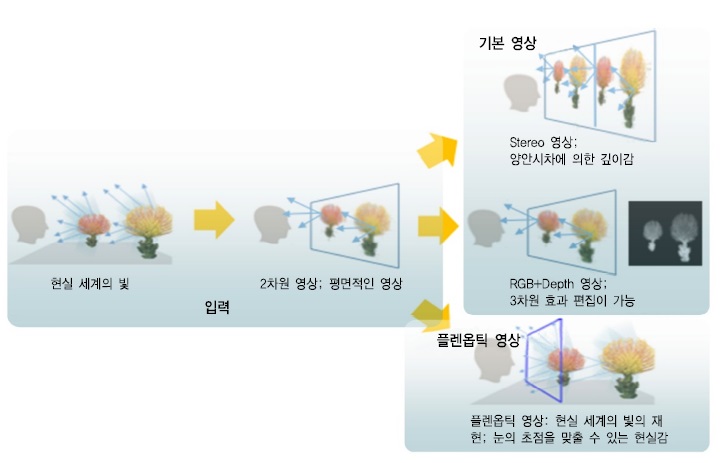

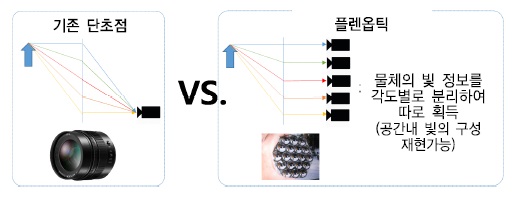

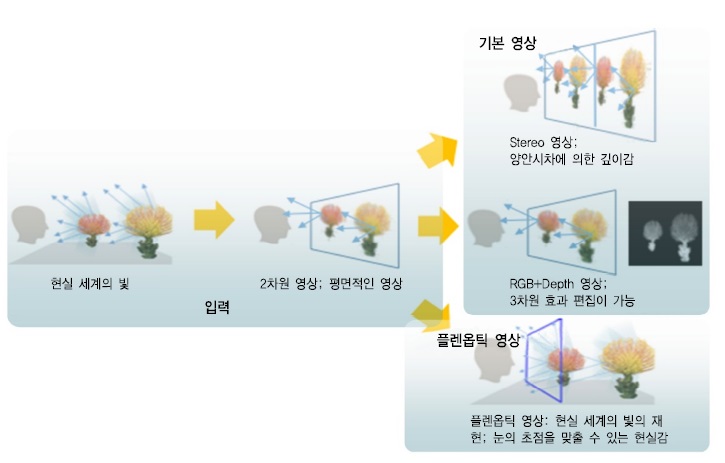

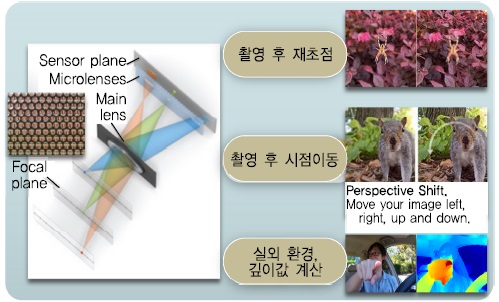

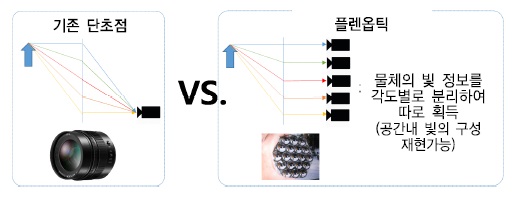

일반적으로 기존 2차원 영상은 촛점평면 기록된 2차원 이미지를 관찰할 수 있는 형태이며, 스테레오 또는 깊이센터에 의해 깊이정보가 부가된 경우는 Red, Blue, Green(RGB) 및 깊이(depth) 정보를 활용하여 3차원 효과정보 단순처리 및 관찰이 가능하다. 반면에 (그림 1)에서처럼 플렌옵틱 영상정보는 3차원 공간상에서의 공간정보 및 각정보를 모두 가지고 있으므로, 보다 자연스럽게 현실세계의 빛 재현이 가능하다.

플렌옵틱의 3차원 공간상에서의 정보는 좌표계(θ, Φ, λ, t, x, y, z,)에 대한 세기(intensity)로 표현이 가능하며, θ과 Φ는 빛의 방향, λ는 파장(컬러), t는 시간 그리고 (x, y, z)은 관측자의 3차원 위치를 나타낸다. 기본적으로, 라이트필드 영상처리는 이러한 3차원 각 점에서의 빛의 세기를 디지털화하여 수학적으로 해석하는 것에서 출발하게 된다.

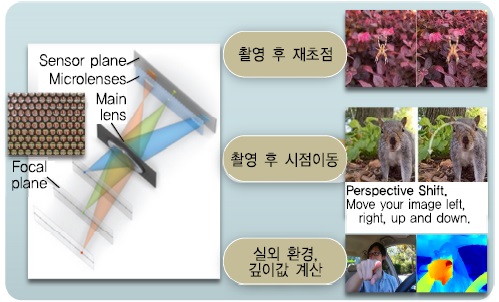

일반적으로 플렌옵틱 영상기술은 카메라 평면에 동일한 간격으로 배치된 복수의 입력 카메라의 초점 평면에서 생성된 플렌옵틱 정보를 디지털 광학적으로 처리하는 것을 이른다. 이러한 플렌옵틱 정보는 카메라의 기준점 좌표와 초점평면의 샘플링 위치좌표로 파라미터화되어, 응용 영상처리에 있어서 입력영상을 기반으로, 시점 변경 재초점 및 깊이감 조절기능 등을 부여할 수 있다[(그림 2) 참조]. 하지만, 현재 상용화된 카메라의 하드웨어 구조상 한계로 인하여, 이러한 기능의 실현에는 한계가 있는 실정이다.

Ⅲ. 플렌옵틱 영상기술 국내외 동향

1. 영상획득 기술동향

기본적으로 플렌옵틱 카메라는 기존 카메라와 달리 여러 방향에서 들어오는 광선의 방향, 빛 거리와 같은 정보를 모두 기록할 수 있는 기능이 요구된다.

영상을 촬영한 후 원하는 곳에 초점을 맞출 수 있는 카메라로 가장 대표적인 것은 ‘리트로(Lytro)사에서 출시한 ‘리트로일룸’이며, 사진 촬영 시 프레임 안에 있는 모든 피사체에 초점을 맞춰 방향과 색, 밝기, 거리 등의 정보를 기록하여 사진을 촬영한 후 원하는 곳에 초점을 맞출 수 있는 기능을 제공한다[(그림 3) 참조].

레이트릭스사의 라이드필드 카메라는 대중적으로는 널리 알려지지 않았으나, 성능면에서 리트로 카메라와 유사하며 다양한 제품군을 가지고 있다[(그림 4) 참조]. 리트로일룸에 비해 상대적으로 고가이며 휴대성이 떨어지는 단점이 있다.

애플사는 아이폰에 촬영된 이미지의 초점을 다시 설정할 수 있도록 특화된 기능을 지닌 카메라를 오래전부터 구상해왔으며, 이에 대한 특허를 출원하면서 한계에 이른 프리미엄 스마트폰 시장의 주도권 장악에 노력하고 있다.

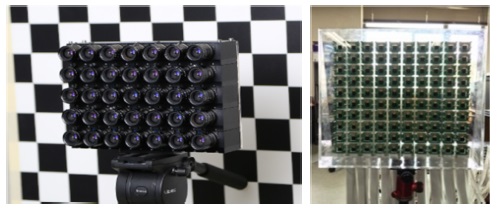

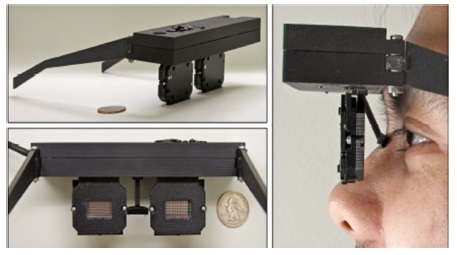

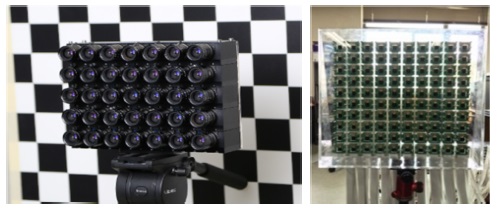

(그림 5)에서와 같이 스탠포드대학은 카메라 어레이를 구축해 플렌옵틱 영상을 획득하는 방법을 제안하였다[3]. 이런 방법은 카메라의 종류와 배치를 다양하게 구성할 수 있어 플렌옵틱의 범위를 자유롭게 조절할 수 있고 또한 고품질의 데이터까지 얻어낼 수 있는 장점이 있으나, 틀과 보드를 직접 개발해야 하므로 제작비용이 높고 여러 대의 PC를 사용하기 때문에 휴대가 불편한 단점이 있다.

2. 영상처리 기술동향

플렌옵틱 영상은 특성상 해상도 저하 및 에일리어싱(aliasing) 현상이 발생하는 단점이 있어 이를 해결하기 위한 재초점 기술 및 초해상도(super-resolution) 기술에 대한 연구가 국내외적으로 활발히 진행되고 있다.

마이크로소프트사와 워싱턴대학은 공동으로 영상의 깊이에 따라 인터폴레이션을 달리하는 방식으로 재초점하는 뎁스스플레팅 기법에 대한 연구를 진행하고 있다[4]. 호주 시드니대학은 플렌옵틱 영상을 주파수도메인으로 변환한 후, 필터링하여 좀 더 부드럽게 초점이 변할 수 있도록 하는 연구를 진행하고 있다[5].

일반 이미지에 적용되는 초해상도 기술은 오래전부터 연구되어 온 분야이나, 플렌옵틱 영상에 대한 초해상도 기술에 대한 연구는 아직 국내외적으로 활발하지 않다. 이것은 플렌옵틱 영상이 가지고 있는 데이터량과 고려해야될 파라미터가 많아 단순히 공간해상도를 증가시키는 것 외에 처리해야 할 요소가 많기 때문이다. 이와 관련하여 미국 Rice대학과 독일의 Heidelberg대학에서 각각 초해상도 연구를 진행하고 있으며[6], 스페인 ULL 대학은 FPGA를 사용하여 초해상도 처리 속도를 높이는 연구를 함께 수행하고 있다[7].

3. 영상재생 기술동향

플렌옵틱 영상을 시청할 때 눈의 초점거리와 수렴거리의 불일치 때문에 눈의 피로가 발생하게 된다. 이를 해결하는 재생기술로는 집적영상 방식과 Head-Mounted Display(HMD) 방식을 대표적으로 들 수 있다.

집적영상 방식은 수많은 렌즈들을 배열하여 만든 렌즈 어레이로 공간에 광선들을 집적시켜 만들어지는 복셀(voxel) 들의 조합으로 3차원 영상을 표시하게 된다. 집적영상 방식은 눈의 초점-수렴거리가 일치하는 것으로 알려져 있으나 올바른 3차원 영상을 관찰할 수 있는 시야각이 제한되어 있으며 영상해상도가 저하되는 단점을 가지고 있다.

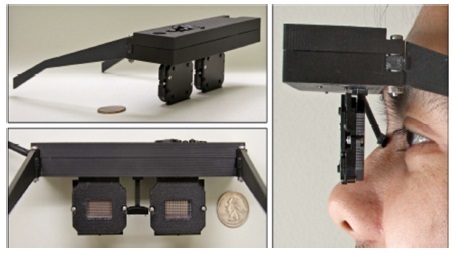

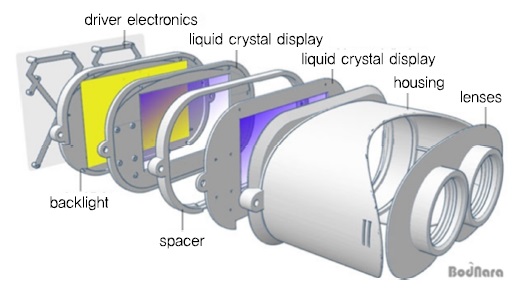

HMD방식은 안경형 디바이스 착용으로 플렌옵틱 영상을 관찰 가능한 기술로 2013년 NVIDA의 Near-Eye Light Field Display(NELFD)를 시작으로 다수의 제품이 발표되었다[(그림 6) 참조].

NELFD는 복잡한 HMD 구조를 단순화시켜 디스플레이와 초박형 렌즈를 통해 이용자가 가상현실이나 증강현실 콘텐츠를 볼 수 있는 디스플레이 장치로, 1024×720 해상도를 가진 두 개의 소니 Organic Lighting-Emitting Diode(OLED) 이미지 센서와 초박형 렌즈를 붙인 안경 형태의 디스플레이 구조이다. NELFD에도 렌즈 어레이를 사용하고 있어 해상도 저하문제는 집적영상 방식과 동일하게 발생하는 단점이 있다.

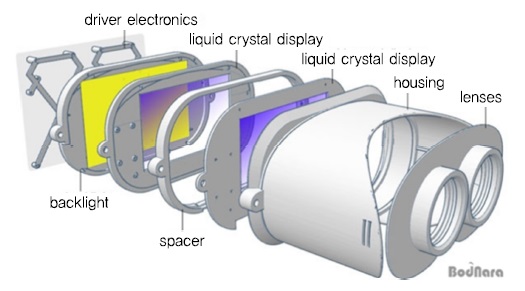

2015년 스탠포드대학이 발표한 Light-Field Stereo-scope HMD(LFS HMD)는 NELFD를 보다 정교하고 실용적으로 만든 디스플레이로써, 기존의 입체 영상기술과 같은 시차에 의한 원근감뿐만 아니라 초점 거리 조정을 통해서도 원근감을 느낄 수 있는 것이 특징이다[(그림 7) 참조]. HMD 구조는 약간의 틈새를 두고 두 장의 액정 패널을 겹친 구조로 한 쌍의 디스플레이를 작동하는 PCB를 두 개 탑재하고 있으며, 2개의 투명한 LCD 스크린을 이용해 플렌옵틱을 형성한다.

(그림 8)은 꽃과 배경의 건물로 초점을 이동시켰을 때의 좌-우 영상을 나타내며, 꽃에 초점을 맞추었을 때는 뒤의 건물이 흐릿하게 나타나며, 반대로 건물에 초점을 맞추면 꽃이 흐릿하게 나타나는 결과를 보여준다.

두 방식을 비교해보면 NELFD는 해상도 146×78, 시야각(Field of View: FOV)이 30°인 것에 비해 LFS-HMD는 256×320 해상도에 100° 정도의 시야각을 가지고 있다.

NVIDA사의 NE-LFD는 2016년 GTC에서 후속 시제품이 발표될 예정이다.

Ⅳ. 플렌옵틱 영상처리 기술개발 이슈

1. 플렌옵틱 영상 획득 및 저장 기술

가. 플렌옵틱 영상 획득 기술

플렌옵틱 영상을 획득하기 위해서는 기본적으로 단일 위치에 대해서 여러 개의 서로 다른 각도에서 입사된 빛의 정보를 분리하여 획득할 수 있어야 한다. 다음 (그림 9)는 이러한 플렌옵틱 영상획득 체계의 개념도를 나타낸다. 그림과 같이 각도별로 분리하여 획득한 물체의 빛 정보를 이용하여, 사후에 임의의 시점이나 초점위치에서 보이게 되는 상의 모습을 재구성할 수 있다.

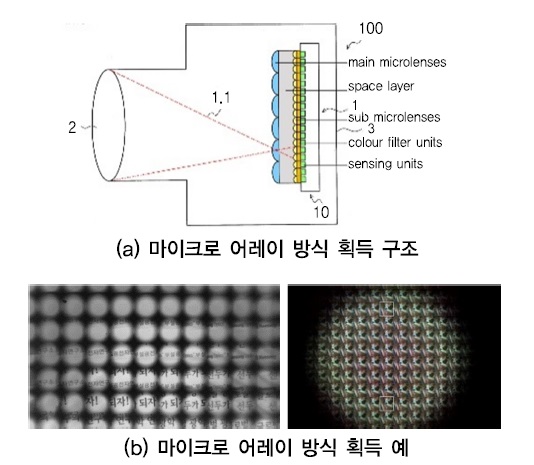

이렇게 위치와 각도별로 빛의 정보를 분리, 획득하는 플렌옵틱 영상획득 시스템은 대표적으로 마이크로렌즈 어레이 기반의 방식과 카메라 어레이 기반의 방식이 있다.

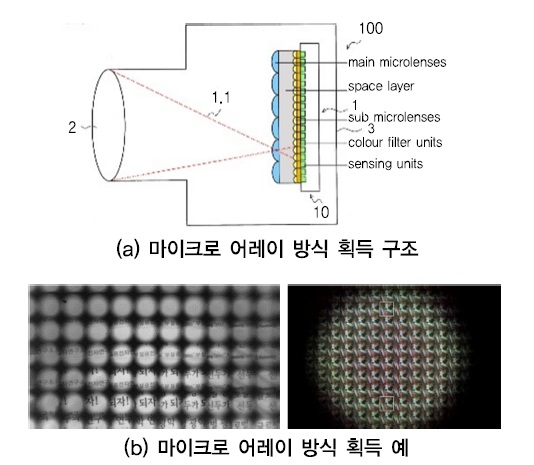

(그림 10)에서와 같이 마이크로렌즈 어레이 방식은 카메라의 포토센서와 밀착한 위치에 매우 작은 렌즈가 집합적으로 모여 있는 렌즈 어레이 필름을 추가하여, 서로 다른 각도에서 입사된 빛의 정보를 독립적으로 획득하는 플렌옵틱 영상획득 방식이다.

또한, 카메라 내부에 위치한 센서를 사용하게 되므로 획득된 플렌옵틱 영상의 픽셀값들이 동일한 광학계와 센서를 공유하게 된다. 따라서 기본적으로 여러 각도에서 획득한 영상을 동시에 처리하는 알고리즘에서 필수처리 부분인 위치보정과 카메라 특성차이 보정작업이 필요없어진다. 그러나 기존의 단초점 방식 렌즈에서 사용되는 센서 해상도를 각해상도 구분을 위한 용도로 재배분하여 사용하므로 최종적으로 획득되는 영상의 해상도가 크게 줄어드는 단점이 있다.

카메라 어레이 기반 방식은 서로 다른 각도에서 입사된 광학정보를 독립적으로 획득하기 위하여 위치별로 구분된 여러 대의 카메라를 동시에 활용하여 촬영하는 방식이다.

(그림 11)에서와 같이 카메라 어레이 기반 방식은 각 시점에 해당하는 영상들이 독립적인 고해상도를 지니므로 마이크로렌즈 어레이 방식과는 다르게 일반 영상과 동일한 수준의 고해상도 영상을 얻을 수 있는 장점이 있다. 그러나, 카메라 어레이 시스템을 구성하는 각각의 카메라가 각자 독립적인 렌즈특성과 센서특성을 가지고 있어 기본적으로 이들의 차이로 인한 편차가 있는 영상 들을 얻을 수 밖에 없으며 플렌옵틱 영상처리 알고리즘의 수행을 위해 이들 영상 간 위치보정과 카메라 특성보정을 위한 추가적인 고정밀 영상처리 단계를 거쳐야 되는 단점이 있다.

나. 플렌옵틱 영상 저장 기술

플렌옵틱 영상은 각 위치별 픽셀에 대해 추가적으로 서로 다른 각도에서 들어온 영상정보를 가지므로 기존 단초점 기반 영상에 비해서 평균적으로 10배 이상의 데이터 용량을 지닌다. 따라서 플렌옵틱 영상데이터를 콘텐츠 서비스 애플리케이션에 활용하기 위해서는 이러한 대용량 영상데이터를 압축하는 기술개발이 필수적이다.

그러나 현재 플렌옵틱 영상 압축 기술은 영상획득 방식에 따라 시스템에 의존적인 각각 다른 압축 방식을 선택하여 사용하고 있으며, 주로 정지영상에 대한 압축/저장 방식에 국한되어 있다. 정지영상 저장의 경우 사용되는 애플리케이션의 특성에 따라 손실압축 또는 무손실압축 방식을 선택적으로 사용하며 기존 ISO/IEC의 JPEG 및 PNG 압축기법 등을 차용하고 있다.

또한, ISO/IEC MPEG에서는 다양한 시점을 가지는 자유시점 비디오 서비스를 위한 표준화를 Free-Viewpoint Television(FTV)의 명칭으로 진행하고 있다. 이는 동영상 서비스까지 가능한 플렌옵틱 영상 저장기술의 개발 및 표준화를 목표로 하고 있으며 다음과 같은 요구사항을 기반으로 진행하고 있다.

- 매우 넓은 뷰 영역(view range) 지원

- 수평 및 수직방향에 대한 패럴랙스 지원

- 인접한 뷰와 동영상 패럴렉스에 대한 부드러운 천이(transition) 가능

- 시각적 피로감 완화

플렌옵틱의 특성을 가지는 자유시점 영상을 저장하고 이를 활용하는 서비스를 제공하기 위한 표준화 논의가 최근 시작되었다. ISO/IEC MPEG에서는 플렌옵틱 데이터를 활용한 서비스 분야의 표준화 추진을 위한 Ad-Hoc 미팅이 2016년 2월 개최되어, 플렌옵틱 영상의 표준화 기술 분야를 선정하기 위한 작업이 시작되었다.

2. 플렌옵틱 영상처리 알고리즘

가. 플렌옵틱 영상 가시화 기술

플렌옵틱 카메라로부터 획득된 영상이 기존 카메라에서 획득된 영상과 비교하여 가장 큰 차별성을 갖는 부분은 가시화이다. 기존 카메라에서 획득된 영상은 화면에 출력하여 사용자가 눈으로 볼 수 있다. 하지만, 플렌옵틱 카메라에서 획득된 영상은 사용자가 원하는 초점과 시점의 영상을 선택하여 볼 수 있다. 즉, 기존 영상 가시화는 사용자의 인터랙션이 허용되지 않는 반면에, 플렌옵틱 영상에서는 허용된다.

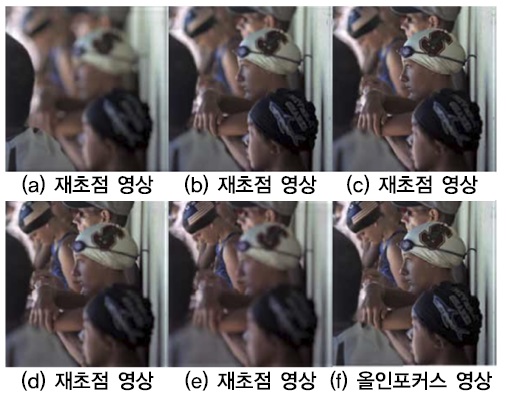

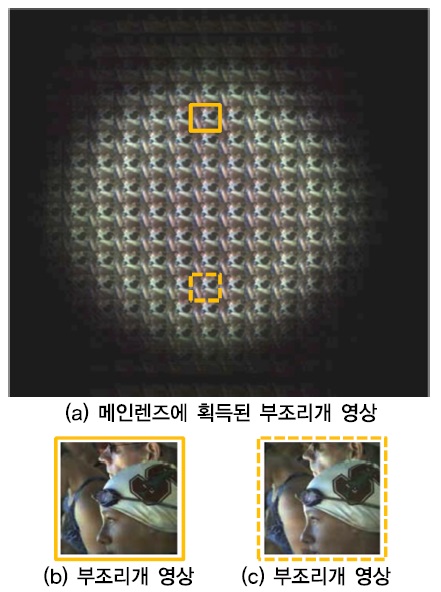

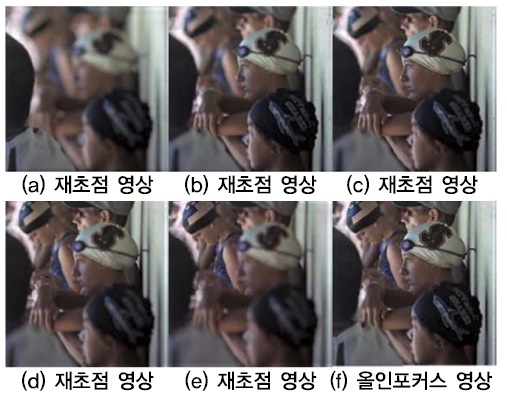

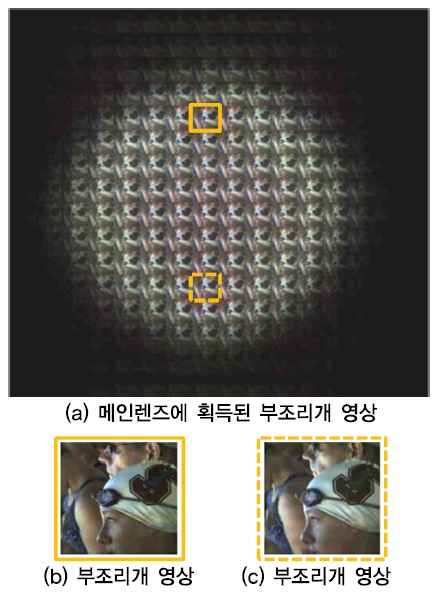

플렌옵틱 영상 가시화 기술에서 사용자가 원하는 위치에 초점을 맞추는 재초점 기술은 실생활에서 많이 사용될 수 있다. 실제로 사진을 촬영할 때 초점이 맞지 않아서 버려지는 영상이 많은데, 플렌옵틱 카메라를 사용하게 되면 사용자가 원하는 위치에 초점을 맞출 수 있으므로 비초점 때문에 버려지는 영상은 더 이상 존재하지 않게 된다. 재초점이 가능해짐에 따라, 원하는 위치에 초점을 맞추는 것 외에 모든 위치에 초점이 잘 맞는 올인포커스(all-in-focus) 영상을 만들어 낼 수도 있다. (그림 12)는 재초점 및 올인포커스 영상의 예시이다. 플렌옵틱 영상의 시점이동 기술을 이용하여 사용자는 원하는 시점의 영상을 획득할 수 있으며, 이러한 시점이동 영상은 부조리개(sub-aperture) 영상을 통하여 획득된다. 부조리개 영상이란 가상적으로 임의의 개수만큼의 조리개가 카메라 메인렌즈 전반에 걸쳐 위치에 있다고 가정하면, 각 조리개를 통하여 획득되는 영상이 서로다른 시점의 영상이다. (그림 13)은 메인렌즈에 획득된 부조리개 영상[(그림 13a) 참조]과 부조리개 영상들 중에서 임의로 선택한 두 개의 부조리개 영상[(그림 13b, c) 참조]을 나타낸다.

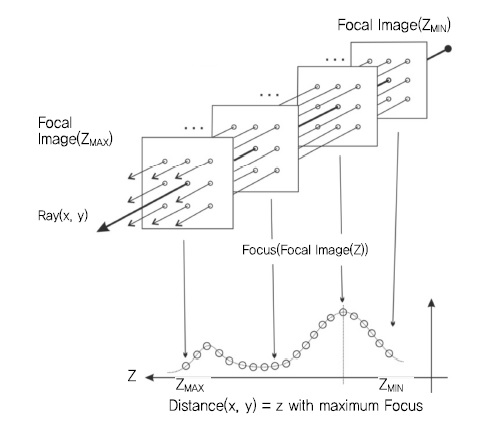

나. 플렌옵틱 영상처리 기술

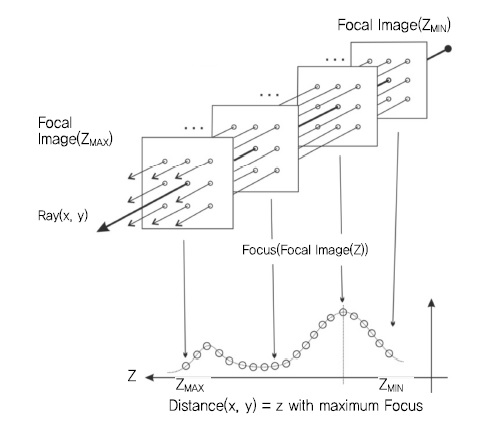

플렌옵틱 영상은 기존 카메라로부터 획득된 영상저작과는 다르게 깊이정보를 이용할 수 있다. 재초점 과정과 연결된 플렌옵틱 영상에서 깊이정보 획득은 다음과 같다. 우선, 플렌옵틱 영상 재초점 기술을 이용하여 다양한 초점위치에서의 영상을 생성한다. 이를 초점스택(focal stack)이라 부른다. 깊이맵의 각 픽셀(x, y)에 대하여 초점스택 내 초점영상(focal image)의 픽셀(x, y)에 대한 초점값(focus)을 획득한다. 이때 각 픽셀의 초점값은 주변 픽셀들과의 대비도를 이용하여 계산한다. 초점스택 내에서 최고의 초점값을 지닌 초점영상을 선택하고 이 때 초점위치를 해당 픽셀의 깊이로 정의한다. (그림 14)는 플렌옵틱 영상으로부터 재초점 과정을 통하여 초점스택을 만든 후, 이를 이용한 깊이맵을 계산하는 과정을 나타낸다.

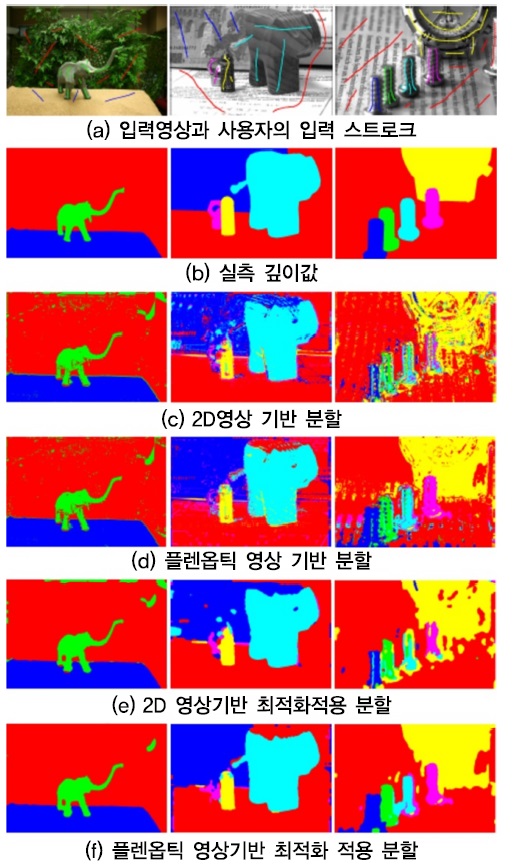

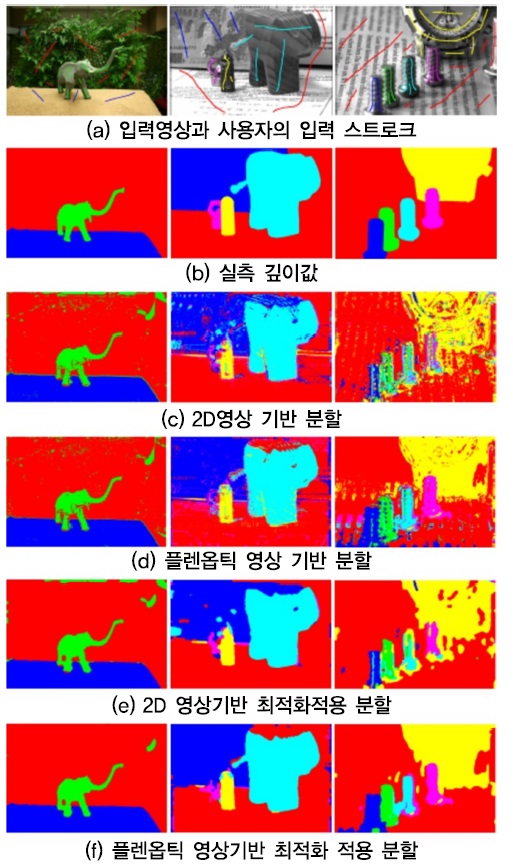

또한, 플렌옵틱 영상에서는 깊이맵을 이용하여 좀더 정확하게 사용자가 원하는 객체를 분할할 수 있다. 영상에서의 객체분할은 컴퓨터 비전이나 영상처리 분야에서 많이 연구되고 있는 기술이다. 기존 영상에서는, 특정 객체를 분할하는 과정에서 영상 내에서 서로 모양이 비슷하거나 동일한 객체들로 인해 구분하기 힘든 경우가 많이 있다. 이 경우 깊이정보를 활용하면 쉽게 구분이 가능하다. (그림 15)는 깊이정보를 이용하여 플렌옵틱 영상에서 객체분할을 수행하는 과정을 보여주고 있다.

3. 플렌옵틱 영상 응용 기술

기존의 플렌옵틱 영상 관련 연구는 영상장비 캘리브레이션, 영상획득, 재초점, 시점이동, 깊이정보 추출 등 주로 플렌옵틱 영상 데이터 획득 및 기본 요소기술 개발에 집중되어 왔다. 획득한 플렌옵틱 영상 데이터는 일반 영상 데이터와 비교하여 추가 정보를 제공하기 때문에 객체 검출, 객체 분리, 객체 추적 등을 포함한 다양한 분야로의 응용이 가능하다.

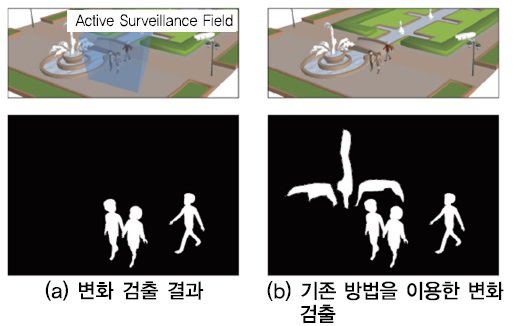

실제로는, 주로 플렌옵틱 동영상(light field video) 데이터로부터의 변화 검출(change detection), 2차원 객체 정위(object location) 및 3차원 위치 추적(object tracking) 분야의 연구가 진행되어 왔다.

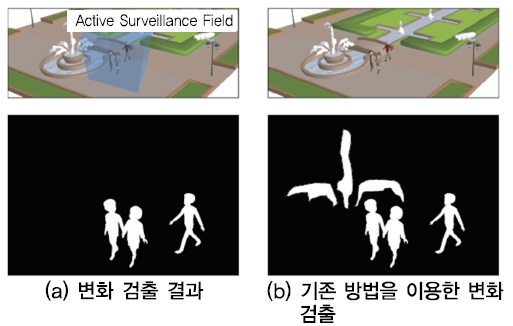

동영상 데이터 분석에 있어서 핵심은 움직이는 객체의 변화를 검출하는 것이다. 변화 검출을 위해서는 배경영역과 객체영역을 분리하는 것이 필요하다. 이 과정에서 배경을 구성하는 객체들의 움직임에 의해 오류가 발생하게 되는데[(그림 16) 참조], 플렌옵틱 영상정보를 이용하여 이를 최소화하기 위해 변화 검출 알고리즘에 관한 연구가 진행되었다. 이 방법을 활용하게되면 플렌옵틱 영상정보가 제공하는 재초점 기능을 이용하여 영상내의 객체들을 초점에 따라 분리함으로 배경과 객체를 분리한다[14].

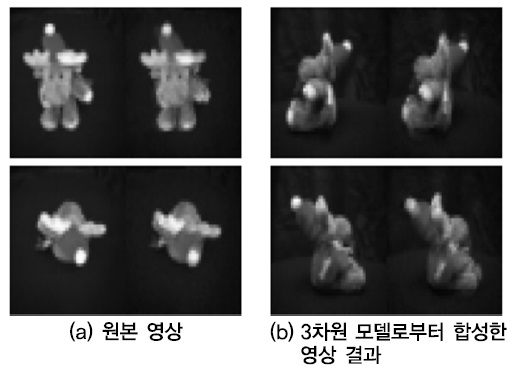

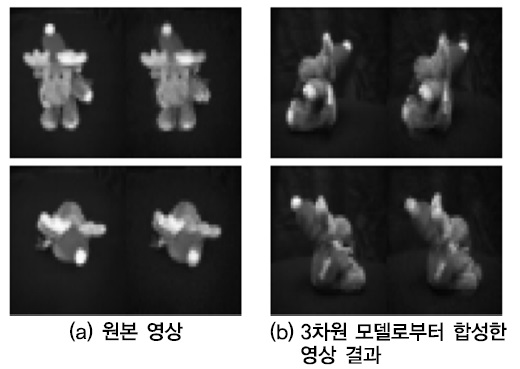

동영상 내의 각 영상 프레임에서 특정 객체의 위치를 검출하는 2차원 객체 정위 기술개발에 플렌옵틱 영상정보를 이용하는 연구도 진행되고 있다. 객체 정위에 있어서 가장 중요한 것은 객체의 회전에 따라 객체의 형태가 프레임마다 달라 보이는 것을 해결하는 것이다. 이를 위해 검출하고자 하는 객체의 3차원 모델을 구축하고, 해당 3차원 모델의 각 시점으로부터 보여지는 2차원 정보를 합성한 후 객체 정위를 위한 원본 영상의 객체와 비교하게 된다. 이를 위하여 플렌옵틱 영상으로부터 3차원 모델을 구축하여 객체 정위의 문제를 극복할 수 있다. (그림 17)은 객체 정위를 위한 원본 영상과 플렌옵틱 영상으로부터 구축한 3차원 모델로부터 생성된 합성영상을 보여주고 있다[15][16].

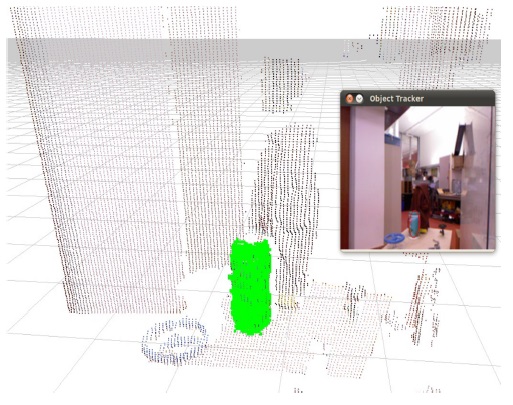

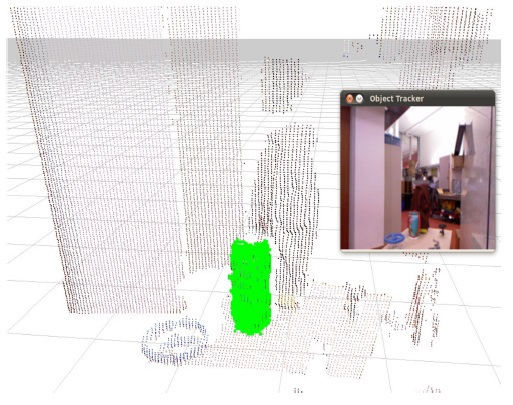

플렌옵틱 영상정보로부터 획득한 영상 내의 깊이정보는 3차원 객체 추적에도 이용된다. 3차원 객체 추적은 동영상 데이터로부터 특정 객체의 3차원 공간상의 위치를 추적하는 것으로써 풀렌옵틱 영상에서 추출된 깊이정보를 활용한다. (그림 18)은 깊이정보를 적용한 물체 추적 시스템의 실행 예를 보여준다[17].

이상에서 살펴본 바와 같이 플렌옵틱 영상정보 구축 및 활용을 위한 새로운 기술들이 진행되고 있다. 즉, 플렌옵틱 영상정보를 직접활용하는 저작을 위한 소프트웨어 도구의 개발, 자동 객체 추적을 통한 특정 객체의 자동 리포커싱 기술, 유체 움직임 분석을 위한 3차원 정보 획득 기술 등 다양한 응용분야에서의 연구개발이 더욱 활성화 되고 있다.

Ⅴ. 플렌옵틱 영상 서비스

플렌옵틱 기술은 특정 분야에 국한되지 않고 영상을 기반으로 하는 다양한 서비스에 모두 활용될 수 있는 기반 기술로써, 기존 단일초점 영상 기반 서비스의 공간 내 영상정보를 확장하여 다양한 신규 서비스 창출이 가능하다. 예를 들어, 플렌옵틱 영상의 특징인 재초점 기능, 시점이동 기능, 그리고 실외환경에서의 깊이값 계산 기능에 따라, (그림 19)와 같이 새로운 신규 서비스 창출이 가능하다.

우선, CCTV 동영상 촬영 후, 사용자가 동영상에 대한 초점 조정을 통해 특정 객체의 검색을 용이하게 하는 서비스가 가능하다. 두 번째로, 시청각도 및 시점수에 구애 받지 않는 임의의 시점 디스플레이에 대한 콘텐츠 생성에 활용할 수 있다. 또한, 실내외에서의 자유로운 깊이정보 획득 및 조정이 가능함에 따라 실외 환경에서 획득된 객체에 대한 3D 프린팅 서비스가 가능하다.

일반적으로, 플렌옵틱 기술은 공간 내 영상처리를 필요로 하는 다양한 분야에 모두 활용될 수 있는 기반 기술로써 다양한 분야에서의 적용성이 매우 높아 연계 산업의 파급효과와 원천성이 높다고 할 수 있다. 실제로, 카메라 모듈 및 영상처리 관련 기반기술을 활용하여 실외 입체 데이터 획득이 가능하므로, 보안, 국방, 스마트 카드 등의 분야에서 기존 기술을 고도화하거나 신규 서비스 도출이 가능하다.

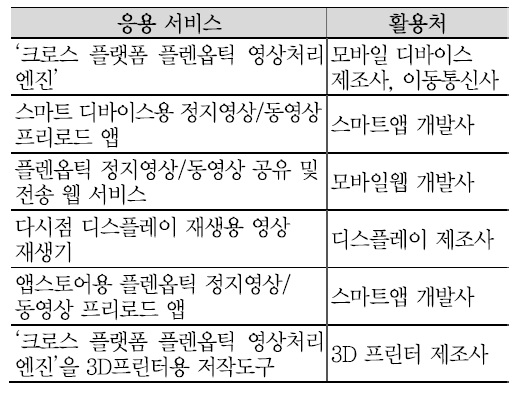

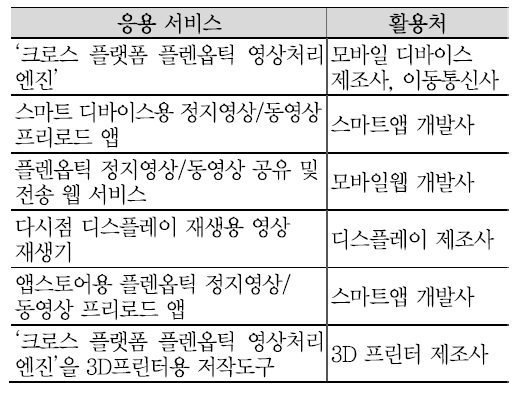

예를 들어, 플렌옵틱 영상기술이 현미경과 같은 마이크로스케일, 스마트 다바이스 및 DSLR과 같은 라이프스케일을 비롯하여 천문 망원경과 같은 매크로스케일 등과 같은 모든 응용에 적용 가능하다. 특히. 스마트 디바이스상에서 촬영한 영상을 단순하고 직관적인 기능으로 즉시적인 수정, 편집, SNS상에서 온라인으로 다른 사용자와 공유하는 행동양식을 보이는 최근의 프로슈머의 형태를 볼 때, 디바이스의 스케일 및 형태와 상관없이 3D 입체영상 콘텐츠를 촬영, 수정, 편집할 수 있는 기능이 지원될 시, <표 1>과 같이 스마트 디바이스 상에서의 무궁무진한 응용 서비스 발굴이 가능할 것이다.

Ⅵ. 결론

최근 방향정보 및 깊이정보를 동시에 처리하는 신차원의 3차원 영상기술인 플렌옵틱 영상기술이 대두되고 있다. 방향 및 깊이정보를 동시에 지니고 있는 플렌옵틱을 기반으로 하기에, 기존 3차원 영상기술 보다 더욱 자연스러운 3차원 객체 표현에 적합한 기술이라 할 수가 있다. 하지만, 현재의 플렌옵틱 영상입력 및 출력장치 기술의 한계 및 대용량 데이터 처리에 대한 이슈 등으로 인해, 향후 심도있는 추가 연구개발과 실용성 있는 응용 서비스 발굴이 시급한 실정이다.

본고에서는, 플렌옵틱 기술을 방향정보 및 깊이정보 처리 관점에서의 기본적인 개념과 기술개발 현황을 파악하였다. 특별히, 플렌옵틱 영상획득, 처리, 재생 측면에서 관련 기술개발의 현 이슈들을 살펴봄으로써 향 후 지향해야 될 연구개발 방향에 대해 탐구를 해 보았으며, 나아가 기존 영상기술과는 다른 플렌옵틱 영상의 특성을 반영한 유망 응용 기술 발굴을 통하여 신 서비스 분야 개척을 시도하였다.

현재, 국내의 플렌옵틱 영상처리 기술개발은 한국전자통신연구원, 대학교 등에서 기초 및 원천핵심연구개발의 형태로 진행되고 있다.

플렌옵틱 영상기술이 기존 스마트폰 상에서의 신규 영상서비스를 창출하는 등, 향 후 활용성은 더욱 극대화될 것이다. 향 후 수년 내로 스마트 디바이스 및 노트북에 플렌옵틱 카메라 센서모듈이 탑재될 것으로 예상되고 궁극적으로는 기존의 컬러 카메라 기반의 영상처리 기술은 대부분 플렌옵틱 영상처리 기술로 모두 대치됨에 따라, 기존의 영상 관련 서비스 및 산업 생태계는 모두 큰 변화를 맞이하게 될 전망이다.

용어해설

플렌옵틱(Plenoptic) 3차원 물체 표면의 각각의 점은 모든 방향으로 해당되는 광선을 내보내는데, 이러한 3차원 물체에 해당하는 광선의 분포로써 임의의 기준면에서 위치별/방향별 분포로 나타냄. 라이트필드(light field, 光場)와 동일한 의미로써 사용됨

깊이정보(Depth Information) 영상에서 객체의 표면과 사용자 뷰포인트 간의 거리정보

공간영역(Spatial Domain) 영상에서 2차원 또는 3차원 정보 위치정보로 나타낼 수 있는 영역

각영역(Angle Domain) 영상의 2차원 또는 3차원 공간에서 방향정보로 나타낼 수 있는 영역

HMD 사용자가 머리에 착용하여 콘텐츠를 시청하게 되는 휴대형 폐쇄형의 VR 디스플레이 장치

약어 정리

CCTV

Closed-circuit Television

CMOS

Complimentary Metal-Oxide-Semiconductor

DSLR

Digital Single-Lens Reflex Camera

FOV

Field of View

FTV

Free-Viewpoint Television

HMD

Head-Mounted Display

JPEG

Joint Photographic Experts Group

LFS HMD

Light- Field Stereoscope HMD

MPEG

Motion Picture Experts Group

NELFD

Near-Eye Light Field Display

OLED

Organic Lighting-Emitting Diode

PNG

Portable Network Graphics

RGB

Red, Blue, Green

B. Wilburn et al., “High Performance Imaging Using Large Camera Arrays,” ACM Trans. Graph., vol. 24, July 2005, pp. 765-776.

J. Fiss et al., “Refocusing Plenoptic Images using Depth-Adaptive Splatting,” ICCP, vol. 34, no. 4, May 2014.

D.G. Dansereau and L.T. Bruton, “A 4D Frequency-Planar IIR Filter and Its Application to Light Field Processing,” Proc. Intl. Symposium on Circuits and Systems, vol. 4, , May 2003, pp. 476-479.

B. Goldlücke et al., “A Super-Resolution Framework for High-Accuracy Multiview Reconstruction,” Int. J. Comp. Vision, vol. 106, Jan. 2014, pp. 172-191.

J. Pérez et al., “Super-Resolution in Plenoptic Cameras Using FPGAs,” Sensors, vol. 14, no. 5, May 2014, pp. 8669-8685.

D. Lanman and D. Luebke, “Near-Eye Light Field Displays,” ACM Transactions on Graphics, vol. 32, no. 6, Nov. 2013, Article no. 220.

F.-C. Huang, K. Chen, and G. Wetzstein, “The Light Field Stereoscope,” SigGraph, vol. 34, no. 4, Aug. 2015, Article no. 60.

R. Ng, “Digital Light Field Photography,” A Dissertation Submitted to the Department of Computer in Stanford University, 2006.

J.G. Marichal-Hernandez, “Obtención de Infor mación Tridimensional de una Escena a partir de Sensores Plenópticos usando Procesamiento de Señales con Hardware Gráfico,” PhD Thesis, University of La Laguna, 2012.

S. Wanner, C. Straehle, and B. Goldluecke, “Globally Consistent Multi-label Assignment on the Ray Space of 4D Light Fields,” Proc. International Conference on Computer Vision and Pattern Recognition, 2013, pp. 1011-1018.

A. Shimada et al., “Change Detection on Light Field for Active Video Surveillance,” Advanced Video and Signal Based Surveillance(AVSS), Aug. 2015, pp. 25-28.

J. Denzler et al., “Plenoptic Models in Robot Vision,” Künstliche Intelligenz, vol. 17, no. 3, 2003, pp. 62-68.

M. Zobel, M. Friz, and I. Scholz, “Object Tracking and Pose Estimation Using Light-Field Object Models,” Vision, Modeling, and Visualization, Erlangen, Germany, 2002. pp. 371-378.

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.