김기홍 (Kim K.H.) VR기술연구실 책임연구원

Ⅰ. 서론

다수의 미디어와 기술시장 보고서는 2016년을 가상현실(Virtual Reality: VR) 기술이 재부흥기를 맞이하여, 다수의 응용 제품들이 일반 소비자 시장에 확대 보급되는 시기로 전망하고 있다. 주기적으로 기술시장에서의 투자 현황 및 활성화가 전망되는 주제를 정리하는 가트너(Gartner, Inc.)의 신기술 하이프 사이클(Hype Cycle for Emerging Technologies)을 보면, 2014년에 이어서 2015년[1]에도 VR이 주요 키워드로 등장했고, 차세대 제품과 서비스의 출시를 위한 투자가 증대되는 등 기술의 재조명기에 진입하고 있음을 알리고 있다. UPLOADVR의 보도[2]에 따르면, 2015년말을 기준으로 공개된 자료만을 기준으로 한 가상현실 투자 규모는 $384M(약 4,600억원)이 되었다. 세계 최대 규모의 소비자 가전제품 및 기술 전시회인 Consumer Electronics Show(CES) 2016[3]에는 2015년 행사에서 주요 이슈가 되었던 VR 기술이 본격적인 시장을 형성하는 주요 제품군으로 분류되어서 전용 전시장이 마련되었다. 대중화된 ICT 플랫폼인 스마트기기를 중심으로 열리는 Mobile World Congress(MWC) 2016[4]에서도 가상/증강현실(Virtual Reality/Augmented Reality)은 대표 기술로 이슈화되었고, 다수의 특집분석 기사[5][6]들과 같이 국내에서도 일반인에게 VR기술을 소개하는 사례가 증가하고 있다.

연구적인 측면에서 VR 콘텐츠는 다음의 3대 요소가 조화를 이룰 때 이상적인 수준의 사용자 경험(가상 세계에서의 존재감; virtual presence)을 제공할 수 있다. 즉, 컴퓨터로 시뮬레이션 되는 가상환경(virtual environment), 현실세계와 가상세계를 이질감 없이(seamless) 연결하는 인터페이스(interface), 그리고 앞의 구성 요소가 인간의 인지 과정에 기반한 휴먼팩터(human factor)를 고려해서 이질감 없이 최적화된 제어 기술들로 융합되어 서로 조화를 이룰 때, 우리는 만족감이 높은 VR 콘텐츠 서비스를 제공할 수 있다. 실감 체험 기술이 사실적이지만 수동적인 체험을 전달하는 영상 콘텐츠 환경(예, 영화)에서, 사용자와 콘텐츠 세계의 상호작용 시나리오가 강화되는 VR 콘텐츠로 발전함에 따라서 인간의 감각 기관에 능동적으로 대응하는 인터페이스 기술의 중요성이 부각되고 있다. 특히, 인간이 외부 세계와 통하는 대표적인 감각인 시각에 대응하는 몰입형 디스플레이는 VR 인터페이스 기술의 중심에 위치하고 있다. MIT Technology Review의 분석 사례[7]를 보면, 2015년에 발생된 VR 기술 분야의 주요 사건 Top 6 중에서 5가지가 머리 착용형 디스플레이(Head Mounted Display: HMD)와 관련되었고, 2016년에 VR 분야에서 기대되는 4대 이슈[8] 중에서도 첫 번째가 HMD로 선정되었다.

VR/AR을 위한 착용형 디스플레이는 양산 제품 수준으로 품질이 향상된 완전 몰입형(see-closed type) HMD와 아직 상대적으로 소규모 생산이나 연구개발 단계에 있는 투시(see-through) 안경형 디스플레이(Eye Glasses-type Display: EGD)로 분류할 수 있다. 선행 보고서[9][10]의 사례와 같이 완전 몰입형 HMD의 주요 구성 요소 중 광학부, 영상 출력부, 그리고 영상 생성부의 기술은 일반 소비자 시장에 제품이 공급될 수준의 품질에 도달한 상태이다. 그리고 각각의 제품이 적용될 환경의 특성을 고려하여 상호작용 처리부 기술이 다양하게 구현되고 있으며, 게임과 원격지 체험 시나리오를 중심으로 다양한 콘텐츠와 함께 VR 체험 생태계를 조성하려는 준비가 진행되고 있다. 그러므로, 본고에서는 2016년 5월을 기준으로 HMD 기술의 최신동향을 정리하고, VR 기술의 활성화와 함께 기대되는 AR 기술의 대표 사례인 EGD 기술의 연구동향을 정리한다.

Ⅱ. VR HMD 기술

1. 재조명된 완전몰입형 HMD 기술

사용자의 두 눈에 각각 영상을 제시하는 방법으로 개인형 입체 디스플레이를 구현할 수 있다는 아이디어는 지금으로부터 70여 년 전에 HMD 특허(1945년 McCollum, 1957년 Morton L. Heilig)로 출원되었다. 현대의 HMD 시스템을 구성하는 전반적인 기술 구성 요소는 1968년 MIT의 이반 서덜랜드(Ivan E. Sutherland)[11]의 연구에서 정리되었다. 즉, VR 시스템에 연계된 입출력 정보를 통합하여 사용자에게 제시할 콘텐츠 정보를 시뮬레이션하는 운영부(예, 그래픽워크스테이션, PC), 시각 정보를 출력하는 영상 출력부(예, CRT모니터, 디스플레이 패널), 영상 출력부의 이미지가 사용자의 시야 범위 내에서 확대된 크기의 가상 스크린 이미지로 인식될 수 있도록 처리하는 영상 확대부(예, 광학 모듈, 렌즈), 그리고 가상과 현실 세계가 양방향으로 정보(예, 사용자 신체 움직임 정보, 인터페이스 장치 동작 정보)를 교환하기 위한 상호작용 처리부로 구성되어 있다. 그러나 앞의 구성 요소들이 융합되어 현실과 가상 세계의 차이를 인지하기 불가능한 수준으로 VR 콘텐츠를 제시하는 시각 인터페이스는 아직 완성되지 못한 상태이다. 1979년 Eric Howlett는 인간의 입체 시야 범위를 140°까지 가득 채우는 광시야각 영상 확대 기술인 LeepVR[12]를 발명했으나, 당시의 영상 출력부기술은 현재의 초고해상도(예, 휴대전화 화면에서 FullHD/UHD급 이상의 해상도 구현 사례) 영상을 출력하는 디스플레이 패널의 수준에 미치지 못했기 때문에 HMD가 널리 활용되기 어려웠다. 이후 영상 프로젝터 기술의 발전으로 1인치 내외의 크기를 가진 마이크로 디스플레이 패널 부품을 활용해서 수 백 PPI(Pixels Per Inch) 이상의 고해상도 영상 구현이 가능해지자, 선행 보고서[9]와 같이 2010년대 까지는 최소화된 영상 출력부와 확대부를 통합하는 기술들이 다양한 HMD들로 제품화되었다. 하지만, 2010년대 초반까지 앞의 기술들은 단안 모듈당 제시할 수 있는 시야각(Field Of View: FOV)이 약 40° 내외 수준에 머무르고 있었다. 이러한 기술 발전의 정체는 2010년 Apple사의 iPhone4 사례와 같이 326PPI 이상의 초고해상도 이미지 출력이 가능한 영상 출력부 기술, Unity3D 및 Unreal과 같이 3D 콘텐츠 개발이 용이한 S/W 플랫폼 기반의 운영부 기술, 그리고 스마트폰에 내장된 센서를 기반으로 사용자 상호작용 처리부 기술의 구현이 용이해지면서, 과거에 제안된 LeepVR과 같이 단순한 광학계 기반의 완전 몰입형 HMD 개발 기술이 부활하게 되었다. 상대적으로 저렴하고 수급이 용이한 하드웨어 부품과 개발 진입 장벽이 낮아진 소프트웨어 플랫폼을 기반으로 재조명된 HMD 기술은 2011년 VR 기술을 연구하는 USC MxR Lab.[13]과 2012년 신생 벤쳐기업 OculusVR의 시작품[14]으로 개선되어, 2016년 현재 가상현실 기술 시장을 대표하는 제품의 주류가 되었다.

2. 몰입형 HMD 기술 현황

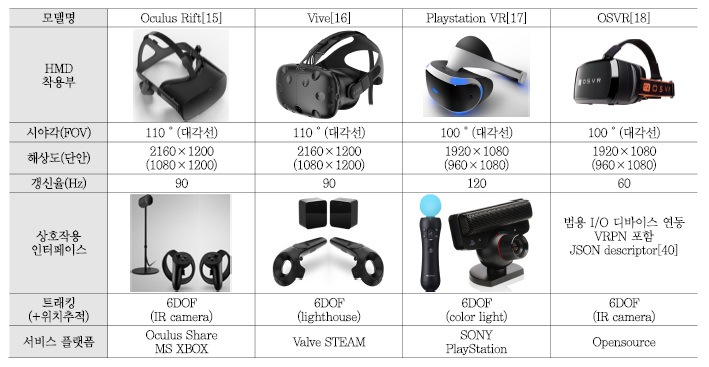

현재 몰입형 HMD는 콘텐츠 운영부를 제외한 시각 인터페이스 형태의 장치를 중심으로 하는 고급형 버전(예, OculusVR RIFT)과 모든 기능을 착용형 장치 내부에 통합시키는 보급형/모바일 버전(예, Samsung GerVR)으로 분류되고 있으며, 2절에서는 고급형 버전에 대한 기술동향을 정리한다. <표 1>과 같이 시장에 공개된 몰입형 HMD의 대표 사례들은 하드웨어를 구성하는 부품의 특징과 지원하는 기능이 서로 유사한 수준으로 개발되고 있다. VR 기술의 대중화 측면에서 과거 HMD 기술의 보급을 어렵게 했던 주요 원인은 다양하고 최적화된 VR 콘텐츠의 부재와 높은 투자 비용에 있었기 때문에, 최근 소비자 시장을 목표로 하고 있는 기업들은 신제품 출시와 함께 충분한 VR 콘텐츠 서비스를 제공하려는 생태계 구축에 노력을 기울이고 있다.

다음은 현재 시장의 주류를 구성하는 몰입형 HMD 제품에 적용된 기술 수준을 분석한다. 사용자에게 시각적으로 완전히 몰입된 가상 공간을 제시하기 위해서는 HMD의 시야각(FOV)을 최대화시켜야 한다. 확대된 가상 이미지의 크기는 영상 출력부(예, 디스플레이 패널)의 면적과 확대부의 배율 간에 비례적인 상호관계에 의해서 결정된다. 단순한 비례 관계이지만, 패널의 부피와 무게 증가에 따른 부작용과 고배율 렌즈 활용에 따른 이미지 왜곡 및 색수차 발생 등의 광학적 부작용 문제를 해결할 수 있는 범위 내에서 설계 파라미터를 최적화시키는 수준으로 기술이 적용되고 있다. 현재 몰입형 HMD에는 휴대폰 부품 산업을 기반으로 수급이 용이한 약 5~6인치 크기의 영상 패널 부품을 활용해서 약 100° 내외의 시야각을 구현한 확대 광학계가 적용되고 있다. 영상 확대 기능을 활용하는 HMD는 가상 이미지에서 단위 면적당 출력되는 영상 화소(예, PPI)의 수가 적어지기 때문에, 일반적으로 수백 PPI 이상으로 최대한 높은 해상도를 출력하는 영상 패널 부품을 적용한다. 그러나, 높은 해상도에 따른 전력 소모 및 데이터 처리량의 증가는 실시간 처리가 필요한 운영부(예, CPU, APU, GPU)에도 부담으로 작용하기 때문에, 현재는 fullHD (1920×1080) 수준의 해상도를 가진 영상을 양안에 독립적으로 제시하는 수준이다. 그리고 영상 패널의 화소-활성화 정도(fill factor) 때문에 발생하는 ‘화소 사이의 간격이 두드려져 보이는 현상(screen door effect)’을 단위 화소의 배치 패턴(예, RGB stripe type, PenTile type)을 변화시켜서 화소-활성화 정도를 높이거나 광확산 필터(diffusion filter)를 추가해서 감소시킴으로써 부드러운 영상 이미지가 제공되도록 한다. 실시간 양방향 상호작용을 지원하기 위해서는 콘텐츠 외부의 이벤트(예, 헤드 트래킹을 포함한 사용자 동작 입력)를 입력받아서 새로운 콘텐츠의 상태를 시뮬레이션하고, 그 결과를 출력하기까지의 시간(latency)을 사용자가 인지하기 어려울 정도로 짧게(예, 10~20ms[19]) 유지해야 자연스러운 영상 제시가 가능하다. 몰입형 HMD는 현실의 3차원 공간에 적응된 사람의 눈에 인공적으로 2장의 2차원 이미지를 출력해서 입체감을 제공해야 하므로, 착용자 개인의 휴먼팩터(human factor) 특성에 최대한 대응하려는 노력으로, 시력 조절부(diopter adjustment)와 두 눈 사이의 거리(Inter Pupil Distance: IPD) 조절부를 내장하는 사례가 많다.

‘현재 상황 입력→시스템 인지→가상 환경 정보 갱신→인터페이스 출력→사용자 인지’의 사례와 같이 인공적인 시뮬레이션의 결과로 제시되는 VR 콘텐츠는 필연적으로 발생되는 지연(latency) 효과를 줄이기 위해서, 운영부(PC)에 내장되는 그래픽카드에도 대용량 고품질의 VR 콘텐츠를 실시간에 처리할 수 있도록 지원하는 기술이 개발되고 있다. NVIDIA사는 GameWorks VRTM[20]을 통해서 병렬 Graphic Processing Unit (GPU)을 활용하는 VR Scalable Link Interface(SLI) 기술, 광시야각 출력에 대응하는 이미지를 선행 왜곡(pre-distortion, wrap)시키는 과정에서의 처리량을 감소시키는 다중 해상도 가시화(Multi-Res Shading) 기술, 실시간 헤드 트래킹 정보를 기반으로 다른 GPU의 작업들과 별도로 선취적(preemptive)으로 처리되는 우선순위를 반영하고, 최종 프레임 렌더링 결과를 비동기적으로 변형(timewarp)시키는 방법으로 HMD 착용자의 지연 현상의 인지를 감소시키는 기법을 적용한 Context priority 기술, 연결된 HMD를 Operating System(OS)가 외부 모니터(바탕 화면 확장)로 인식하는 단계를 생략하고, 직접 VR 애플리케이션이 HMD에 영상 결과를 출력함으로써 렌더링 속도를 향상시키는 Direct Mode 기술, 그리고 직접적으로 front buffer rendering이 가능한 렌더링 모드를 지원해서 지연 효과를 감소시킬 수 있도록 지원한다. AMD사는 동일한 목적을 가진 LiquidVRTM[21]에서 사용자의 입력(예, 헤드 트래킹)에 따른 갱신된 결과의 출력 지연 시간을 최소화시키려는 목적으로, 헤드 트래킹 속도를 높이는 Latest data latch 기술, 사용자의 최신 헤드 트래킹 정보를 기반으로 출력 이미지를 변형(timewarp)시키는 Async shader기술, 다수의 GPU를 기반으로 양안식 스테레오 영상 이미지의 생성 속도를 높이는 Affinity multi-GPU 기술, 그리고 GPU와 HMD 장치가 직접 데이터를 통신함으로써 처리시간을 단축시키는 Direct-to-Display 기술을 지원한다. 앞의 기법 외에 VR 및 네트워크 기술 분야에서 연구되는 방법으로, 초고속 네트워크망과 고성능 서버급 컴퓨팅 파워를 활용하는 실시간 가시화 기술이 있다. 즉, 고품질 영상을 위한 대용량의 데이터를 실시간으로 처리하기 위한 하드웨어 리소스(예, 높은 소비 전력과 부피를 차지하는 고성능 CPU 및 GPU기반 렌더링 서버)를 HMD에 내장하지 않고, 소형 통신과 전원 모듈만을 내장한 후 대부분의 연산을 원격에서 처리하고 그 결과만을 실시간 통신을 지원하는 네트워크 기술을 기반으로 스트리밍(streaming)으로 처리하는 기술이 개발되고 있다.

3. 모바일 몰입형 HMD 기술 현황

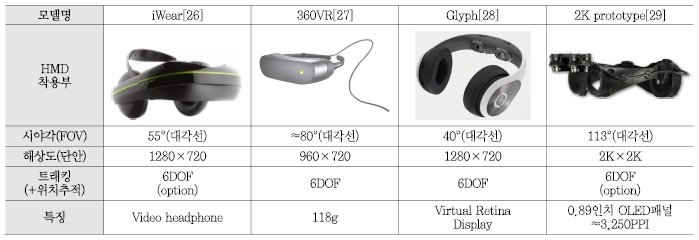

앞에서 정리된 내용과 같이 고품질의 VR 콘텐츠 체험을 얻기 위해서는 고성능 컴퓨터와 별도의 입출력 인터페이스 장치들이 필요하므로, 아직 수 백만원 이상 수준의 초기 비용 투자가 필요한 상황이다. 그래서 상대적으로 보급이 용이한 스마트기기 인프라를 활용하는 방법으로 모바일 기반 몰입형 HMD 기술이 개발되고 있다. 몰입형 HMD 시스템을 구성하기 위한 대부분의 주요 기능은 모바일 기기(예, 고성능 스마트폰)가 구비하고 있으므로, 몰입 체험을 위한 광학부 및 추가적인 상호작용 지원부를 패키징한 제품이 소개되고 있다. <표 2>의 사례와 같이 다수의 제품들에 적용된 기술들이 유사한 수준의 사용자 경험을 제공하고 있으므로, 최종 소비자 가격 및 콘텐츠 서비스 플랫폼의 사용성 등이 제품 차별화의 기준으로 제시되고 있다. 광학계를 중심으로 하는 영상 확대부는 2절에서 소개된 고성능 장비에 적용된 것과 동일한 수준의 기술이 적용되고 있다. 몰입형 HMD는 일정한 크기 이상의 렌즈와 시각적 몰입 환경(暗室; dark room) 조성을 위한 외부 시야 차단형 구조가 필요하지만, 모바일 환경을 위해서 휴대성 기능을 강화시킨 디자인으로 접이식 구조를 적용한 사례도 있다. 그리고 나머지의 영상 출력부, 콘텐츠 운영부 및 일부 상호작용 처리를 위한 센서부는 대부분 스마트 기기이 성능에 의존하고 있으므로, 모바일 VR용 콘텐츠는 일정한 데이터 처리량을 예측할 수 있는 동영상이나 상대적으로 가벼운 수준의 그래픽 리소스를 활용하는 3D 콘텐츠로 제작되고 있다.

<표 2>는 하나의 디스플레이 패널에 좌우(Side by Side: SbS) 시야 영상을 출력하는 방식이지만, <표 3>은 전통적으로 양안 독립형 모듈을 적용한 몰입형 HMD의 사례이다. Vuzix[26]는 1인치 미만의 초소형 디스플레이 패널을 기반으로 경량형 HMD를 개발하고 있다. LG는 360VR HMD[27]에 1.8인치크기의 고해상도(639PPI, 960×720) In-Plane Switching(IPS) 패널을 적용해서 영상 출력부의 크기를 확대시키는 방법으로 가상 이미지의 크기를 증가시켰다. Avegant사의 Glyph[28]는 Texas Instrument사의 720p HD급 초소형 Digital Light Processing(DLP) 모듈을 기반으로 가상 영상이 착용자의 망막에 프로젝션되는 Virtual Retinal Display 기술을 구현한 헤드폰 형태의 HMD를 상용화시켰다. eMagin[29]사는 약 1인치 크기의 마이크로 디스플레이 OLED 패널의 해상도를 각각의 눈에 2K×2K로 높이고, 대각시야각(diagonal FOV) 약 113°를 제공하는 HMD 시작품을 개발함으로써, 초고해상도의 광시야각 HMD를 소형 고글 형태로 구현할 수 있는 기술을 제시했다.

4. 기타 몰입형 HMD 기술개발 사례

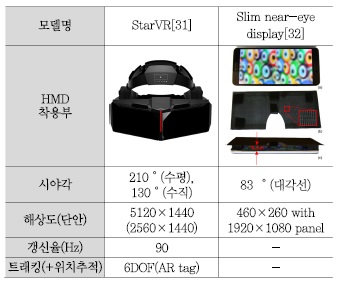

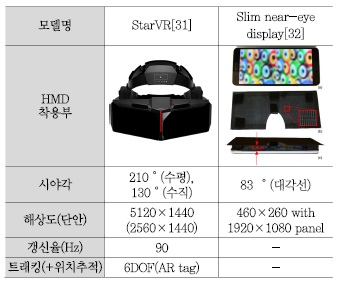

인간의 양안시 입체 시야각 범위를 측정한 연구데이터[30]에 따르면, 정면을 응시하는 경우 수평 방향으로 약 140° 이상의 시야각을 지원해야만 양안 시야 범위를 완전히 채울 수 있다. 이런 광시야각 요구 조건에 대응하는 기술의 사례로, <표 4>와 같이 StarBreeze의 StarVR HMD[31]는 WQHD(2560×1440) 해상도의 패널 2장으로 좌우 시야 영상을 출력하고, 부피를 적게 차지하는 프레즈넬 렌즈(Fresnel Lens) 기반의 광학계를 사용해서 수평 시야각을 210°까지 제공한다.

착용부의 부피와 무게가 증가하는 경향과는 반대로, 단순한 구조로 착용부의 부피를 감소시키면서 시야각을 높이려는 아이디어가 연구분야에서 시도되고 있다. <표 4>와 같이 2015년 NVIDIA 리서치는 핀홀 배열 구조(pinhole aperture arrays)를 활용해서 광학부가 1cm 미만의 두께를 가진 몰입형 HMD의 구현 기술[[32]을 공개했다.

Ⅲ. AR EGD 기술

1. 광학 투시형 디스플레이 기술 발전동향

착용형 디스플레이의 미래를 상상하는 다수의 미디어의 사례를 보면, 차세대 VR/AR 디스플레이의 형태는 가볍고 슬림한 안경 형태의 인터페이스 장치로 묘사되고 있다. 특히 AR 콘텐츠 환경을 위해서는 외부의 환경을 시각적으로 인지하는 과정을 최대한 방해하지 않는 투시(see-through) 기능 구현이 중요하다. 카메라를 활용하는 비디오 기반 투시(video-based see-through) 기술은 영상 획득과 처리 및 출력에 있어서 휴먼팩터 기반의 요구 조건을 충족시키기에는 현재 기술의 한계가 명확하기 때문에, 광학적 투시(optical see-through) 기술을 적용한 제품 개발이 주류를 이루고 있다.

(그림 1)과 같이 광학 투시형 디스플레이 기술은 1960년대 후반 MIT Ivan E. Sutherland의 광학 투시형 HMD의 사례[33]처럼 탄생 초기부터 시도된 방법이지만, 인간의 시야 범위를 가득 채우는 영상을 전달하기 위해서는 매우 큰 반사형 광학계를 눈앞에 위치시켜야 하는 단점이 있었다. 그래서 L-3 Link Simulation & Training사의 AHMD[34]와 같이 특수 목적의 HMD에서만 광시야각 기술이 구현됐으며, 연구 및 소비자용 AR 시스템을 위해서는 ETRI의 EGD[35] 사례와 같이 소형/경량화가 가능한 광학계 기술이 적용되고 있다. 최근에는 LUMUS의 DK-50[36]처럼 안경 렌즈와 같이 얇은 광학 모듈 내부에 영상을 반복해서 반사시키는 방법으로 사용자의 눈(동공)에 영상을 전달하는 광경로 가이드형 기술이 다양한 형태로 시도되고 있다.

2. 광학 투시형 EGD 기술개발 현황

2010년대 이후 최근에 광시야각을 제공하는 완전 몰입형 HMD 기술에 관심이 집중되고 있을 때, 1절의 내용과 같이 광학 투시형 EGD를 개발하는 기업들은 시각 인터페이스의 중요한 요소인 시야각과 해상도의 감소를 수용하면서, 모바일 사용환경에서의 사용자 경험 요소를 원활하게 지원할 수 있는 착용형 인터페이스 장치를 개발했다.

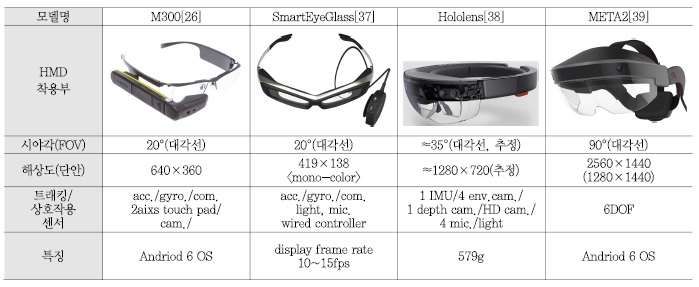

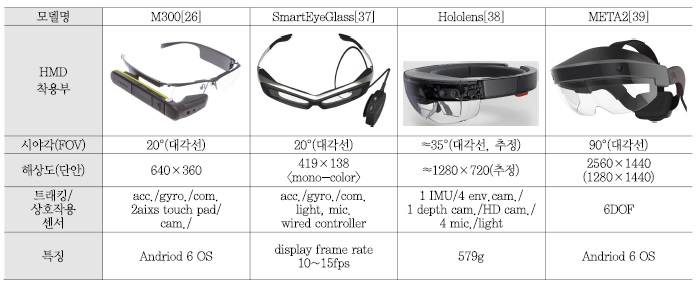

Google의 GoogleGlass, Recon Instruments의 Recon Jet 및 <표 5> Vuzix의 M300 Smart Glasses 사례와 같이, 최근 다수의 사례가 안경에 부착하면 약5인치 내외의 크기를 가진 휴대폰 영상을 눈앞에 위치시켜서 양손의 자율성을 확보할 수 있는 보조 정보 디스플레이 기기로 활용하는 경험을 제공하고 있다.

SONY의 SmartEyeGlass SDK 사례를 보면, mono color display이지만 착용성과 즉각적인 정보의 접근성 및 휴대성의 이점을 강조하면서, smart watch 및 smart band 형태의 착용형 인터페이스 기기와의 연동성을 강화시킨 사용자 경험 향상 기술/애플리케이션 개발에 기술을 집중하고 있다.

Microsoft는 2015년 초 Hololens 프로젝트 공개 이후에 AR콘텐츠 생태계 강화를 위한 킬러 애플리케이션 발굴의 일환으로 2016년 3월부터 development edition을 외부에 공급하고, 진행 중인 Galaxy Explorer 프로젝트의 내용을 공개하고 있다. Hololens는 [(그림 1)의 사례와 같이 광경로 가이드형 광학계를 적용시켜서 가시화 모듈의 경량화/슬림화를 구현하고, 1개의 Inertial Measurement Unit(IMU), 3종류 총 6개의 카메라, 4개의 마이크로폰 및 1개의 조도센서(ambient light sensor)로 구성된 다중 센서 기반 상황 정보 트래킹 모듈, 그리고 모바일 환경에서 사용자 상호작용 입출력 및 Windows 10 기반으로 Unity 3D엔진 콘텐츠 운영을 담당하는 프로세서 모듈을 내장하고 있다.

META사는 2015년 KickStarter 프로젝트로 EPSON사의 BT-100와 Creative사의 Senz3D 카메라 센서를 개조한 META Dev Kit 1과 LUMUS사의 시야각 40°를 지원하는 광경로 가이드형 광학 모듈을 활용한 META Pro를 개발해서, 모바일 AR환경을 위한 킬러 콘텐츠를 발굴하려는 노력을 진행하고 있다. 2016년2월에는 스마트기기용 패널을 상단에 배치하고 시야각 90°를 구현한 반사형 광학계를 적용한 META2를 공개했다. MS, Meta 및 Seebright의 사례와 같이 최근 광학 투시형 EGD는 시야각이 확장된 광학계와 함께 소형화된 depth camera를 기반으로 다수의 센서를 융합한 상호작용부로 구현되는 사례가 증가하고 있다.

Ⅳ. 결론

완전 몰입형 HMD를 중심으로 하는 H/W플랫폼은 경쟁 기술들이 유사한 수준으로 평준화되는 추세이므로, 콘텐츠를 중심으로 소비자 가격 대비 차별화된 사용자 경험을 제공할 수 있는 서비스가 중요해지고 있다. 가트너사의 Technology Hype Cycle 2015에서도 Virtual Reality 기술의 대중화 시점을 여전히 5~10년 이후로 전망하는 점은 내실 있는 생태계 구축의 필요성을 강조한다고 분석되며, SONY PlayStationVR[17], Oculus Experiences[41], SteamVR[42], Google VR Daydream[43] 등의 사례들과 같이 소비자용 HMD를 대중화시킨 선도 업체들은 콘텐츠 서비스 플랫폼을 구축하고 있다. 광학-투시형 EGD는 필요에 따라서는 간단한 구조변경을 통해서 완전 몰입형 HMD로 변경이 용이해서 폭 넓은 활용성이 기대 되므로, 소비자의 기대 수준에 대응하기 위한 다수의 기술들이 연구개발 중에 있다. 그리고, 완전 몰입형 HMD를 중심으로 열리는 가상현실 콘텐츠 시장이 증강현실 콘텐츠 시장으로 확대되는 시점에서 핵심기술로 기여할 것으로 전망된다.

용어해설

HMD(Head Mounted Display)머리에 착용하는 헬멧/고글 형태의 디스플레이 장치, 사용자의 양쪽 시야 범위를 가득 채우는 입체 영상을 제시하는 장치로 시각적으로 완전히 몰입된 VR 콘텐츠 인터페이스 기술

EGD(Eye Glasses type Dislplay)안경/경량형 고글과 같은 형태로 상대적으로 가벼운 HMD를 분류해서 지칭하는 용어. 부가적인 장치 없이 외부 환경을 직접 관찰할 수 있는 광학적 투시(optical see-through) 기능이 특징. 외부 시야 확보가 용이하므로 모바일 환경에의 적용이 용이한 기술

약어 정리

CES

Consumer Electronics Show

DLP

Digital Light Processing

EGD

Eye Glasses-type Display

FOV

Field Of View

GPU

Graphic Processing Unit

HMD

Head Mounted Display

IMU

Inertial Measurement Unit

IPD

Inter Pupil Distance

IPS

In-Plane Switching

MWC

Mobile World Congress

OS

Operating System

PPI

Pixels Per Inch

SbS

Side by Side

SLI

Scalable Link Interface

VR

Virtual Reality

References

<표 1>

완전 몰입형 HMD 제품 사례 및 특징

<표 2>

모바일 몰입형 HMD 제품 사례 및 특징

<표 3>

독립 모듈 기반 양안식 몰입형 HMD 사례 및 특징

<표 4>

광시야각, 슬림형 HMD 사례

(그림 1)

광학 투시형 EGD의 광학계 및 특허 기술 발전 사례

<표 5>

광학 투시형 EGD 사례 및 특징