김가규 (Kim G.G.) 웨어러블컴퓨팅연구실 책임연구원

노경주 (Noh K.J.) 웨어러블컴퓨팅연구실 선임연구원

임지연 (Lim J.Y.) 웨어러블컴퓨팅연구실 선임연구원

정승은 (Chung S.E.) 웨어러블컴퓨팅연구실 연구원

Ⅰ. 머리말

우리나라는 2026년 이후 초고령 사회로 진입할 것으로 전망되고 있다. 이로 인하여 예상되는 국가적인 사회비용 지출문제, 고령자의 빈곤이나 신체∙정신건강 문제 등을 해결하기 위한 기술 확보가 시급한 실정이다. 이에 정부는 선제적 미래대비를 위하여 ‘ 중점분야 중 국민행복 실현을 위해 미래 세대와 함께 지속 가능한 사회를 가능케 하는 연구 지원 강화’ 를 발표하여 고령화 등 사회적 이슈 해결을 위한 과학기술의 역할을 요구하기에 이르렀다[1]. 미래의 초저출산∙초고령 사회에서는 노동인구의 변화가 불가피하여 고령자의 생산활동 참여가 중요하게 될 것으로 보인다. 한편으로는 고령자의 부양과 관련된 사회비용 증가 문제, 인지력 저하에 따르는 고령 운전자의 교통사고 문제 등 최근 대두되고 있는 사회문제도 함께 해결해야 할 것이다.

이미 이러한 문제를 겪고 있거나 직면한 선진국들은 사람처럼 배우고 판단하는 인공지능 기술 연구에 집중하고 있다. 널리 알려진 유럽의 휴먼 브레인 프로젝트(Human Brain Project[2])와 미국의 브레인 이니셔티브(Brain Initiative[3]) 프로젝트 등이 대표적인 사례이다. 이러한 지능형 기술은 최근 음성 인터페이스 기술에서 볼 수 있듯이 사용자의 정서와 의도까지 이해하여 감성적인 대화가 가능할 정도로 연구가 발전되고 있다. 대화형 로봇을 이용하여 사용자의 고독감과 불안감을 치유하는데 적용하거나, 다양한 생체신호를 이용하여 사람의 의도를 파악하기 위한 다수의 연구가 진행되고 있는 것도 이러한 기술의 흐름을 시사한다.

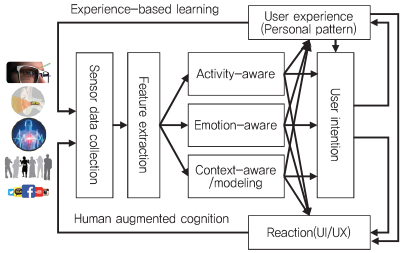

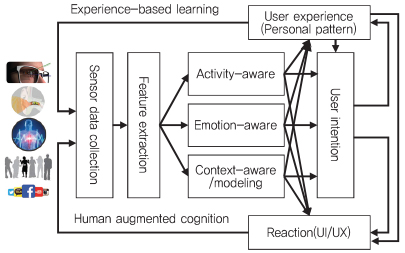

이처럼 고령화에 따르는 인지저하 문제 해결을 위하여 노인의 행동 및 신체변화를 분석하고 자립적 삶을 유지하도록 보조하는 지능화된 기술의 필요성이 어느 때보다 높아지고 있으나, 현재의 기술들은 고령자의 건강을 모니터링하고 관리하는 비교적 간단한 서비스 수준에 머물고 있다. 따라서, 앞으로의 인지증강 기술 (그림 1)은 신체적, 심리적, 경제적 변화 및 사회적 관계 변화로 인해 삶의 질이 낮아지는 고령층의 자존감을 고취하여 이들의 건강한 사회 참여를 유도하고 세대 간 삶의 질 불평등을 해소하는 방향으로 연구되어야 할 것이다.

본고에서는 인간의 인지력 저하로 발생하는 문제 해결을 위한 서비스 기술 동향과 생체신호/행위/감정 인식 기술, 경험학습을 위한 데이터 모델 및 상황인지 기술 동향을 파악하고, 이를 통해 향후 연구에 집중해야 할 기술 분야를 살펴보고자 한다.

Ⅱ. 인지증강 서비스

최근 의료산업은 ICT 기술의 접목을 통해 병원 중심의 진단과 치료에서 벗어나 건강관리의 범위가 병원 밖까지 확장되고 있다. 이와 같은 ICT 기반의 의료산업은 헬스케어와 웰니스라는 전문분야로 성장할 만큼 보편화된 의료서비스로 발전하고 있다. 특히, 인지력 저하로 지속적인 관리가 필요한 고령자의 독립적인 일상생활을 도와주는 기술 서비스로 그 활용범위를 넓혀가고 있다.

국내 업체인 Ybrain은 지적능력, 언어능력에 문제가 있는 치매환자를 대상으로 뇌에 전기 자극을 주어 만성적 뇌질환을 완화시켜주는 휴대용 헬스케어 기기인 Y Band를 개발하여 임상실험을 진행하고 있다[4]. 또한, ZIKTO Walk는 사용자의 보행 시 수집되는 데이터를 통해 걸음걸이를 분석하여 자세교정을 코칭하는 교정밴드와 관련 분석정보를 제공하는 앱을 출시하였다[4]. 한편, 노인의 신체 및 오감 능력을 보완하는 제품들도 많이 출시되고 있다. Liftware는 손 떨림이나 파킨슨병으로 식사를 할때에 어려움이 있는 사람을 위해 전자숟가락 Liftware Steady와 그 후속 제품 Liftware Level을 내놓았다. Liftware Level은 복합 센서 데이터를 기반으로 사용자의 움직임을 인식하고 추적하며, 유연하게 동작하는 연결부분을 통해 사용자가 음식을 떨어뜨리거나 흘리지 않도록 도와주는 제품이다[5], [6]. 이외에도 노인들의 불편한 보행을 보조하기 위하여 보행기 및 전기 휠체어 제품이 있으며, 주변의 잡음을 제거하여 고령자가 듣고자 하는 상대방의 목소리를 또렷하게 듣도록 도움을 주는 스마트 보청기에 해당하는 제품들이 있다. 대표적으로, Soundhawk는 무선마이크, 무선이어폰을 스마트폰 앱과 연동시켜 생활 소음과 잡음을 없애고 주변 사람의 이야기를 더 잘 들을 수 있도록 해준다[5].

고혈압, 당뇨 등을 앓는 만성질환자를 위한 복약 알림 및 복약여부를 감지하는 제품들은 인지력이 저하된 고령자에게 중요한 서비스를 제공한다. Nvolve 스마트 약통은 일정 시간 간격으로 복용이 필요한 약을 사용자가 제때 복용할 수 있도록 알려주는 알람 기능 및 사용자가 약통을 들어 올렸을 때를 감지하여 복약 여부를 실시간으로 점검할 수 있는 기능이 있다[5]. Glowcaps는 복약 시간 알람 기능뿐 아니라 약이 떨어졌을 때 약국으로 전화를 걸어 약을 주문할 수 있게 하는 기능도 있다[5]. 미국의 의약품기업 Proteus는 환자가 약을 복용했는지 여부를 점검할 수 있는 스마트 알약인 Helius를 연구하고 있다. Helius는 환자가 약을 복용하면 소화가 되면서 전기적 신호가 환자의 배에 부착된 패치로 전송되고, 패치는 다시 블루투스를 통해 스마트폰으로 데이터를 전송하게 되어 약 복용여부를 점검할 수 있게 해준다[5]. 미국 건강관리서비스 회사인 WellDoc은 당뇨병 관리를 돕는 BlueStar를 개발하였다. 이 서비스는 사용자에게 혈당 측정 시간, 혈당 조절 약의 복용 시간에 대한 알람을 보내며, 혈당 수치에 따른 적절한 실시간 대응 방안에 대해서도 안내한다[5], [7]. 이러한 서비스들은 인지력 저하로 독립적인 일상생활이 어려운 노인부터 생활 습관 교정이 필요한 일반인에게까지 유용한 헬스케어, 웰니스 제품 및 서비스를 제공하여 향후 다양한 형태로 발전될 가능성이 크다.

Ⅲ. 경험정보 인식 기술

인지력 저하로 인해 발생하는 문제 해결을 위해서는 사용자의 장기간 경험정보를 분석할 필요가 있다. 경험정보 분석 결과를 바탕으로 사용자가 겪게 될 인지저하로 인한 문제 상황 예측 및 분석을 시행하여 사용자가 적시에 인지저하에 대처할 수 있도록 해야 한다. 이 장에서는 사용자의 경험정보를 생체 신호, 감정, 행위로 나누고 각각의 인식 기술 동향을 살펴보고자 한다.

1. 생체 신호 인식 기술

최근 여러 가지 생리적(Physiologic) 신호와 관련된 바이오센서(Biosensor)를 사용하여 인간의 생활과 관련된 다양한 측면을 인식하려는 연구가 진행되고 있다. ECG(Electrocardiography, 심전도), EMG(Electro-myography, 근전도), EEG(Electroencephalogram, 뇌전도), 체온 등을 측정하는 개인용 생체신호 측정 센서의 성능이 향상되었을 뿐만 아니라 호흡, 혈압, 생체 임피던스, 맥파 전달 속도 등을 측정하는 새로운 형태의 센서들도 등장하면서 이에 관련한 연구의 범위도 확대되고 있다[8].

Scanadu의 Scout, iHealth와 Masimo의 맥박 산소 측정기, Basis의 B1과 Peak 스마트 워치 등 웨어러블 디바이스 또는 휴대용 디바이스를 통해 심박수, 혈중 산소 포화도(SpO2), 피부 온도와 같은 생체 신호를 추출한 연구에서는 생체 신호와 더불어 신체 활동과 관련된 데이터(움직임의 종류, 움직임의 가속도, 칼로리 소모 등)를 사용하여 사용자의 24시간 주기 생활 리듬 분석, 행동에 따른 생리학적 반응, 라임병 또는 염증 반응의 조기 진단, 피로도와 혈중 산소 포화도의 상관관계 등을 연구하였다[9].

또한, 귀마개에 부착된 전극 센서를 사용하여 비침습적인 방법으로 수면 중 뇌와 안구, 얼굴 근육의 생체 전기 신호를 추출하여 사용자의 수면의 질과 수면의 단계를 모니터링한 연구에서는 EOG(Electro-oculography, 안전도), EEG, EMG를 분석하여 수면의 단계를 REM (Rapid eye movement) 수면과 4단계의 비 REM 수면으로 분류하는 방법을 제안하였다[10].

이외에도 목걸이 형태의 압전기(Piezoelectric) 기반의 마이크로폰 센서를 통해 20Hz에서 1,300Hz 사이 주파수 대역의 비 음성의 소리(Non-speech body sound)를 감지하여 사용자의 섭식 상태(음식 또는 음료 섭취), 호흡기 관련 질병(잦은 기침, 후두염 증상 등), 호흡기 상태(심호흡, 숨가쁨, 재채기)를 사용자의 개입 없이 자동으로 지각하는 연구가 진행되었다[11].

이러한 연구를 통해 개발된 휴대용 웨어러블 디바이스는 전문가의 도움 없이 사용자가 손쉽게 자신의 건강 상태를 실시간으로 모니터링 하고 주기적인 관리가 가능하도록 한다. 또한, 장시간 동안 수집된 생체 신호 데이터의 이상 징후를 분석함으로써 질병의 조기 진단에 도움을 줄 수 있다. 나아가 경제적으로 소외된 계층이나 지리적인 요건으로 인해 의료 서비스를 받지 못하는 집단에도 저비용으로 건강 관리를 가능하게 할 수 있다는 점에서 사회적으로도 의미가 있다.

2. 행위 인식 기술

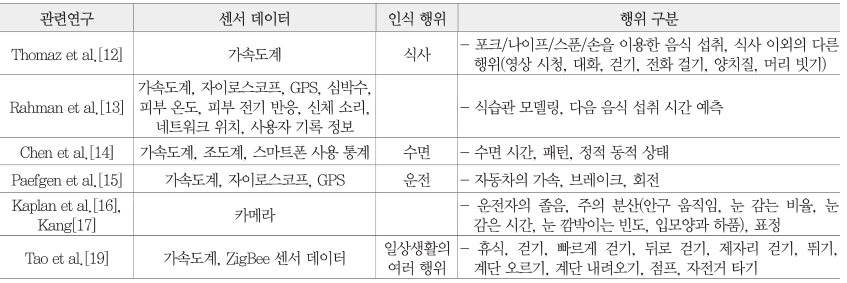

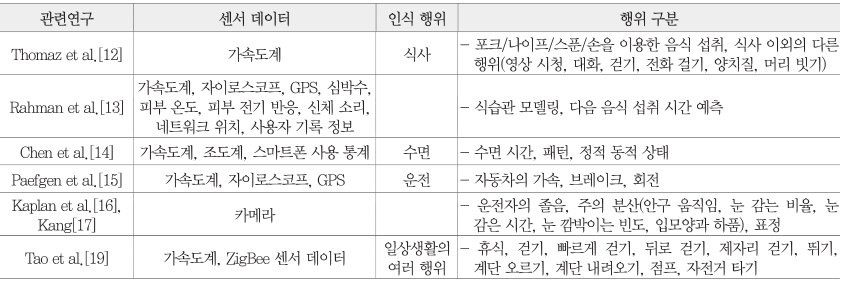

여러 센서들을 사용하여 일상 생활에서의 다양한 행위를 인식하고 각 상황에 적합한 서비스를 제공하려는 연구는 주로 경량의 휴대용 디바이스를 채택하고 있다. 이는 사용자가 시간과 장소에 구애 받지 않고 소지가 가능하며 일상 생활을 제약하지 않기 때문에 기반시설을 사용하는 방법보다 더 실용적으로 데이터를 수집할 수 있기 때문이다[<표 1> 참조].

식습관이 건강 지표에 큰 영향을 미친다는 연구 결과는 널리 알려진 사실이다. 이로 인해 식습관을 모니터링 하고 기록하려는 연구는 꾸준히 이어져 왔다. 그 한 예로 스마트 워치의 3축 가속도 센서 데이터를 분석하여 팔과 손의 움직임에 따른 음식 섭취 행위를 인식하고, 어떤 식기(포크, 나이프, 스푼, 손)를 사용하여 얼마나 오랫동안 어느 정도 양의 음식을 섭취하는지를 자동으로 기록하거나[12], 관성 측정 센서(IMU: Inertial measurement unit) 데이터뿐만 아니라 심박 수, 피부 온도 등의 생체 신호까지 고려하여 식습관 패턴을 인지하고 예측하는 연구가 이루어지기도 했다[13].

수면 또한 건강 상태를 측정하는 데 중요한 요인으로 작용하기 때문에, 센서들을 사용하여 수면 시간과 패턴, 수면의 질을 측정하려는 연구와 다양한 서비스들이 제안되고 있다. 스마트폰과 웨어러블 디바이스(Jawbone, Zeo headband)들의 조도 센서, 가속도 센서, 디바이스 사용 패턴 등을 분석하여 사용자의 정적 동적 상태를 파악하고 수면 패턴을 모니터링 하는 시스템[14]이 그 대표적인 예이다.

최근 자율주행 자동차 관련 기술이 크게 주목받기 시작하면서 운전 행위를 인식하고 운전 중 사용자의 상태를 인식하려는 연구가 활발하게 진행되고 있다. 이들 연구에서는 스마트 디바이스의 IMU 센서들을 사용하여 사용자의 운전 습관을 분석하거나[15], 카메라에 감지된 사용자의 표정이나 눈의 깜빡임 정도를 인식하여 운전자의 피로도나 집중도를 탐지한다[16], [17].

이상의 특정 행위 모니터링을 포괄하는 라이프로깅(Life-logging)[18] 관련 연구는 수치화된 데이터를 통해 개인의 식습관, 운전 패턴, 수면 패턴, 운동 패턴 등의 행위를 인식하고 예측하려는 시도를 하고 있다.

이처럼 행위 인식의 경우 이미 많은 연구가 진행되어 영상 데이터 및 휴대용 디바이스의 센서 데이터를 이용한 행위 인식 기술이 다양하게 제안되었으나[19], 개인의 경험정보를 바탕으로 하여 좀 더 복잡하고 다양한 행위를 인식하고 예측하는 연구는 아직 부족한 실정이다. 따라서 이 분야의 지속적인 추가 연구가 필요할 것으로 보인다.

3. 감정 인식 기술

감정 인식 기술은 인간의 감정을 정량적·정성적으로 측정하고 과학적으로 분석·평가하는 기술이다. 이 기술은 비디오(표정, 행동) 및 오디오(음성) 데이터를 기반으로 하는 기존 연구와는 차별화하여 현재는 스마트폰과 웨어러블 디바이스 등의 다양한 센서에서 획득한 데이터를 복합적으로 활용하려는 노력이 진행 중이다. 이렇게 인식한 감정 상태는 궁극적으로 더 지능적인 인간-컴퓨터 상호작용(Human-Computer Interaction) 기술에 활용하는 것을 목표로 하고 있다. 사람의 감정을 인식하고자 하는 시도는 심리학, 컴퓨터 공학, 인지 과학, 신경 과학, 정신 생리학, 사회학 등의 여러 분야와 밀접하게 연관되어 있다.

심리학 분야에서는 정서 연구를 위하여 기본정서인 표정을 체계적으로 정리한 얼굴자극세트 구축이 이루어져 왔다. 한국인 표정자극세트로는 안면 인식 알고리즘 개발을 위한 Korean Face Database 및 POSTECH Face Database가 있으며, 정서 관련 신경과학 연구를 위해 제작된 Facial Expression for Affective Neuroscience와 한국인의 정서와 표정 관련 연구를 위한 Korea University Facial Expression Collection이 있다[20].

카네기멜론대 로봇연구소가 개발한 감정 인식 프로그램 IntraFace는 스마트폰 카메라를 통해 실시간으로 사용자의 슬픔·혐오·중립·놀람·기쁨 등 5가지 감정을 인식하는 기술로[21], 스마트폰 카메라 앱으로 배포되었다. 또, 우울증 진단에 IntraFace를 사용하여 음성과 표정의 시차를 인식하여 우울증의 정도를 파악하는 임상실험도 진행되고 있다[22]. 마이크로소프트는 프로젝트 옥스퍼드(Project Oxford)를 통해 머신 러닝을 이용하여 분노·멸시·공포·혐오·행복·슬픔·놀람·중립 등 8가지 감정의 상대적인 강도를 수치화하여 분류하는 Emotion API를 공개하였다[23].

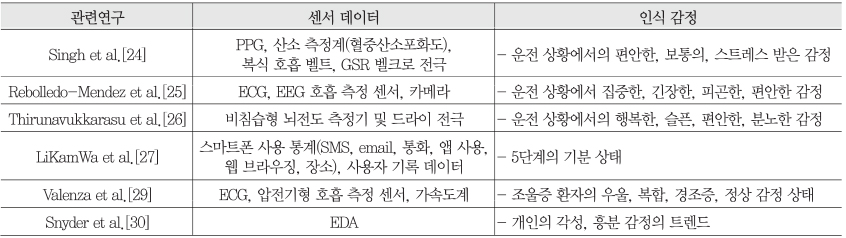

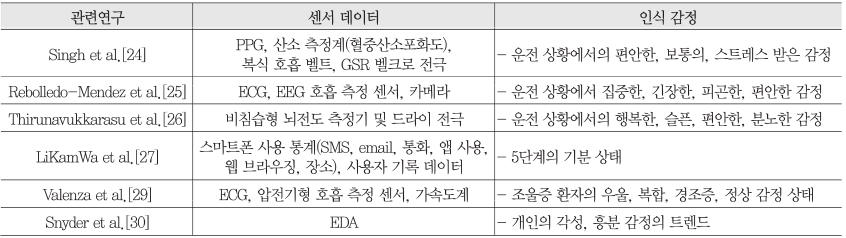

운전 상황에서 사용자의 감정 상태 인식을 목표로 하는 연구에서는 PPG(Photo-plethysmography, 광 혈류 측정도)와 GSR(Galvanic skin response, 전기 피부 반응)과 같은 생리적 신호를 분석하여 운전자의 세 가지 감정 상태(relaxed, moderate, stressed)를 분류하고 예측하였다[24]. 또 다른 연구에서는 ECG, EEG, 호흡 측정 센서와 얼굴을 촬영한 비디오를 사용하여 실제 운전 상황에서 운전자의 네 가지 감정 상태(concentrated, tension, tired, relaxed)를 감지하는 바디 센서 네트워크를 구축하기도 하였다[25]. 또한, EEG와 전극 센서를 사용하여 뇌파 분석 기반 운전자의 감정 상태를 인식하는 기법이 제안되기도 했다[26]. 이러한 연구들은 센서 및 생체신호 데이터로 운전자의 감정 상태를 분석하여 위급한 상황을 예측하거나 안전을 보장하는 서비스를 제공하기 위해 활용될 수 있다.

최근 많은 연구가 스마트폰의 라이프로깅 서비스 방식을 활용하여 사용자의 일상생활 중의 데이터를 수집·분석해 왔다. LiKamWa 등은 스마트폰 앱으로 사용자의 감정 상태와 활동성 상태를 5단계로 로깅 할 수 있도록 하고, 이 데이터를 분석하여 사용자의 감정을 인식하는 MoodScope API를 제안하였다[27]. 기존 라이프로깅 연구들이 스마트폰과 웨어러블 디바이스에서 수집한 데이터를 분석해 사용자의 현재 상황 인식에 주력하였다면, 최근 연구는 기분, 행위, 수면에 대해 직접 기록할 수 있는 라이프로깅 앱을 배포하여 자료를 수집하고, 주목 받고 있는 딥러닝 기법 중 하나인 RNN(Recurrent neural network)을 적용하여 우울의 가능성을 예측하기도 하였다[28].

또한, 뇌파 데이터를 수집한 연구들의 경우에도 조울증[29], 스트레스 관리 등에 활용할 수 있는 개인의 흥분 정도 인식[30]과 관련한 연구도 진행되었다. 이처럼 감정을 인식하기 위해서는 다양한 센서 데이터 및 사용자 로그뿐만 아니라 의료 목적으로 활용되는 뇌파 데이터까지 사용자로부터 수집하여 분석하고 있다[<표 2> 참조]. 향후에는 인간의 감정이 가진 개인 특성과 복잡성 등을 반영한 데이터 선정을 비롯하여 감정 특성 및 요인을 정의하기 위한 다양한 연구가 필요할 것으로 보인다.

Ⅳ. 경험정보 모델링 기술

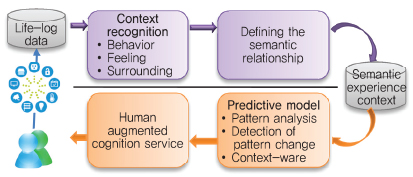

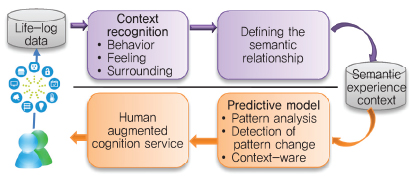

사용자 경험기반 인지증강 서비스는 경험데이터로부터 추출되는 유용한 정보를 활용하게 된다. 따라서 사용자의 경험데이터는 서비스에서 요구하는 정보를 추출하기에 용이한 구조로 관리되어야 하고, 의미 있는 경험데이터를 정확하게 검색할 수 있어야 한다. 또한, 사용자의 인지증강 서비스를 목적으로 경험데이터 기반의 사용자 특정 패턴분석 및 예측을 할 수 있도록 하기 위해서는 경험데이터 간의 관계를 포함하는 질의를 처리할 수 있는 (그림 2)와 같은 구조를 지원해야 한다.

본 장에서는 사용자의 경험데이터로 구성되는 라이프로깅 데이터 관리 방식 중 자동 태깅을 지원하는 이벤트 기반 자동 태깅 방식, 높은 질의 처리 성능을 지원하는 관계 데이터 모델 기반 방식 및 다양한 의미적 관계 표현을 지원하는 시멘틱 네트워크 기반의 경험데이터 관리 방식에 대해 살펴본다.

1. 이벤트 기반 자동 태깅

다수의 센서로부터 수집되는 이질적인 경험데이터를 효율적으로 관리하고 검색하기 위해서는 데이터의 연관성을 추출하고 이를 함께 기록하는 방법이 필요하다.

Doherty등은 수집한 라이프로깅 데이터를 이용하여 이벤트에 따라 자동으로 라이프로깅 데이터를 분류하고 사용자가 전체적으로 로그를 요약하여 확인할 수 있도록 하였다[31]. 또한, 상황인지(Context-aware) 서비스[32]를 위해 모바일 라이프로깅 데이터의 상황 정보를 분석하고 이를 태그로 사용하여 데이터를 관리하는 방법도 제안되었다[33]. 이 방법에서는 라이프로깅 데이터를 일화(Episode) 중심으로 분할하고 저장하여 사용자의 상황을 추론한다. 이를 위하여 라이프로깅 데이터를 이동활동, 청각활동, 시각활동, 기록활동, 말하기 활동 등의 사용자 활동으로 분류하고, 이동상황, 지속상황, 감지상황, 선택상황 등의 상황정보 컨텍스트 정보로 추상화시켜서 자동 태깅하여 저장한다. 라이프로깅 데이터에 대한 일화는 시간과 이동활동의 레코드로 구성하고, 동시출현 객체로 시간 동기화를 수행한다. 즉, 사용자의 다양한 활동으로 상황을 표현하고, 다수의 일화에서의 주제를 나타내는 키워드로 자동 태깅하는 방식이다[33]. 그 밖에도, 라이프로그의 이벤트 추출 방법의 하나로, 사용자의 웨어러블 장치를 통해 수집한 사진데이터의 위치 및 시간 정보와 내용을 분석하여 사용자의 상황 이벤트 키워드를 자동으로 추출하는 방법도 제안되었다[34].

2. 관계 데이터 모델 기반 모델링

라이프로깅 데이터를 효과적으로 관리하기 위한 기법 중에는 관계 데이터 모델 기반으로 데이터를 분석 관리함으로써 복잡한 질의 처리를 가능하게 하고, 질의 처리 성능을 높이고자 하는 연구가 있다[35]. 이 연구에서는 라이프로깅 데이터를 종류별로 Web, GPS, Email, Audio, Video, Picture, Document, Contact 테이블로 관리하고, 각 데이터 간의 관계기술을 위한 관계 테이블을 생성한다. 이 테이블은 소스 데이터를 위한 ‘ source’ 속성, 타겟 데이터를 위한 ‘ target’ 속성, 소스와 타겟 간 관계의 의미를 나타내는 ‘ relationship type’ 속성을 갖는다. 이러한 관계 테이블의 관계 정보를 통해 라이프로그 간의 다양한 관계를 기술하고 관리한다[35].

3. 시멘틱 네트워크 기반 모델링

시멘틱 관계를 포함하는 시멘틱 네트워크 기반의 방식에 관한 선행 연구 중에는 베이지안 네트워크를 기반으로 데이터를 관리하는 방식이 있다. 이 방식은 과거의 경험데이터를 이용하여 중요한 단서 사건을 추출하고, 중요사건을 토대로 경험데이터를 계층적으로 관리함으로써 사용자의 기억을 보완해주는 방식을 채택했다[36], [37]. 다수의 이질적인 데이터를 갖는 사용자 경험데이터를 기반으로 특정 상황을 인지하고 추론하기 위해서는 기존의 단일 데이터를 기반으로 하는 단순한 기계학습을 그대로 적용하는 대신 베이지안 네트워크를 기반으로 하여 확률적 상황인지 기법을 적용하는 방법들을 많이 이용하고 있다[38]–[40].

이러한 시멘틱 네트워크 기반 모델링 방식에는 불확실하고 불충분한 질의어를 처리하기 위해, 연관검색을 통해 데이터를 찾기 위한 의미기억 기반 모바일 라이프로그 연관검색 방법이 있다[41].

시멘틱 네트워크 기반 모델링 방식에서는 사람의 의미 기억 방법에서 단서를 이용하여 기억을 회상하는 방식에서 착안하여, 특정 과거 사실에 집중할 때 그것과 시공간을 넘어서 집중된 사실과 연관된 다른 기억들을 떠올리는 활성화 확산 기반 점화(Priming) 방식이 있다[42]. 이러한 방식들은 공통으로 질의어가 불확실한 정보로 이루어진 질의어를 통해서도 사용자가 원하는 과거 정보를 찾을 수 있는 가능성을 높이는 성과를 보여주었다.

시멘틱 기반 그래프를 구성하는 라이프로깅 데이터와 그들 간의 관계를 표현하기 위한 온톨로지 모델을 활용하는 기법이 있다[43]. 온톨로지 모델을 통하여 구성된 라이프로깅 데이터는 데이터간의 넓은 범위의 관계까지 기술하고 포함함으로써 사용자의 라이프스타일 패턴에 따른 의미를 분석하기 용이하게 하는 이점이 있다.

또한, 사용자의 경험데이터를 기반으로 특정 패턴 변화를 인지하기 위한 방식으로 사용자의 라이프로깅 데이터를 임의의 시간 구간으로 데이터를 분할하고, 각 시간 구간에서의 엔트로피값을 구하여 이를 다차원 공간에 사상시킨다. 이와 같은 패턴 변화 모델(Drifting model)을 생성하고, 다차원 공간에 사상된 모델 간의 유사도를 측정하고 비슷한 변화 패턴을 갖는 모델을 통하여 목표하는 모델의 변화 상황을 예측한다[44].

위에서 살펴본 것처럼 경험데이터 간의 관계를 찾고, 효율적인 검색을 위한 데이터 관리, 패턴 변화를 감지하기 위한 연구들이 진행되었지만, 인지증강 서비스를 위한 다수의 이질적인 경험데이터 기반 사용자 특정 패턴분석과 패턴변화 분석을 위한 모델링 및 기법에 관한 연구가 많지 않아 이에 대한 지속적이고 폭넓은 연구가 필요하다.

Ⅴ. 맺음말

본고에서는 인간의 인지력 저하로 생기는 문제 해결을 위한 인지증강 서비스, 생체신호/행위/감정 인식 기술, 경험 학습을 위한 데이터 모델 및 상황인지 기술에 관한 동향을 파악하였다. 인지력이 저하된 고령자 등을 대상으로 한 헬스케어 및 웰니스 분야에서 인지증강을 위한 다양한 서비스가 등장하고 있다. 사용자의 다양한 경험 데이터로부터 감정 및 행위를 인식하고자 하는 연구와 이벤트 자동 태깅, 관계 데이터 모델 및 시멘틱 네트워크 기반 모델링에 대한 다양한 연구들이 진행되고 있다. 향후에는 경험정보 기반 인지증강 서비스를 위해 기존의 인식 분야별 대표적인 센서 데이터 중심의 인식 기술과 더불어 개인 경험상황의 특징을 고려한 인식 기술에 대한 심화 연구가 필요하다. 또한, 사용자 개인의 특정 패턴분석을 위해 다수의 이질적인 경험 데이터를 기반으로 한 경험정보 모델링 및 분석 기법에 관한 연구의 중요성도 커질 것이다. 이와 같은 기술들은 다가오는 미래 사회의 문제에 선제적으로 대응하고 해결하는 데 중요한 역할을 할 것으로 기대되므로, 이러한 연구분야에 노력과 역량을 집중하여야 할 것이다.

약어 정리

ECG

Electrocardiography, 심전도

EDA

Electrodermal Activity, 피부 전기 활동

EEG

Electroencephalogram, 뇌전도

EMG

Electro-myography, 근전도

EOG

Electro-oculography, 안전도

GSR

Galvanic Skin Response, 전기 피부 반응

IMU

Inertial Measurement Unit, 관성 측정 센서

PPG

Photo-plethysmography, 광 혈류 측정도

REM

Rapid Eye Movement

RNN

Recurrent Neural Network

References

(그림 1)

경험기반 휴먼 인지증강 기술 개념

<표 1>

행위 인식에 활용되는 센서

<표 2>

감정 인식에 활용되는 센서

(그림 2)

인지증강을 위한 경험정보 모델링