스마트폰 대체재로서의 신뢰증강보는통신용 스마트안경 기술

Smart Glasses Technologies for Trustworthy, Augmented Reality, See-Through Eyes-Direct Communications as Substitute for Smart Phones

- 저자

-

송기봉미래원천연구본부 kbsong@etri.re.kr 이준경뇌휴먼인터페이스연구실 leejk@etri.re.kr 김광용뇌휴먼인터페이스연구실 kwangyk@etri.re.kr 김건우신인증·물리보안연구실 kimgw@etri.re.kr 박소희신인증·물리보안연구실 parksh@etri.re.kr 김태연지능네트워크연구실 tykim@etri.re.kr 윤호선지능네트워크연구실 yhs@etri.re.kr 이재호고성능디바이스SW연구실 bigleap@etri.re.kr 김도형고성능디바이스SW연구실 kimdh@etri.re.kr

- 권호

- 34권 5호 (통권 179)

- 논문구분

- 일반논문

- 페이지

- 58-70

- 발행일자

- 2019.10.01

- DOI

- 10.22648/ETRI.2019.J.340506

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.- 초록

- In this paper, we present the R&D status of ETRI’s Trusted Reality (TR) project and its core technologies. ETRI's TR project focuses on the next-generation paradigm of smart phones, ETRI-TR Smart Glasses, which aims to provide the same features as those of smart phones without the involvement of any handheld device. Furthermore, they are characterized by additional features enabled by trustworthy VR/AR/MR/XR, such as privacy masking/unmasking, distributed structure of thin-client computing/networking among TRGlasses, TR-LocalEdge, and TR-RemoteEdge, with novel see-through eyes-direct communication between IoT real/virtual objects and human eyes. Based on these core technologies of the ETRI’s TR project, the human-held ETRI-TR Smart Glasses is expected to aid in the realization of XR vision with particularly more XR's safe_privacy on social life in the near future.

Share

Ⅰ. 서론

본 고는 ETRI 전자통신동향분석지 2018년 10월 ‘Trusted Reality (신뢰현실) 기술, 포스트-스마트폰 관점에서’ 출고 이후 두 번째로 ETRI-TR 과제에서 바라보는 포스트 스마트폰 세상에서의 국내·외 기술 동향과 TR의 차별화, TR 분야별 상세 세부기술들에 대해 다루고자 한다. 본 ETRI-TR 기술은 미래 세상에서 웨어러블 기기를 손으로 잡지 않고 눈앞에 착용하여 두 손이 자유로우며 다양한 소통방식(예, 시선을 통한 사물제어통신, 시력교정 혹은 개 코 수준 냄새의 오감을 증강시키는 웨어러블 기기 등)으로 인간이 가급적 자유롭게 주변 환경과 안전하게 ‘보는통신’을 제공하는 데 주안점을 두고 있다.

일반적으로 VR/AR/MR 스마트 가상/증강/혼합현실 매직안경은 다음과 같은 4가지 주요 디바이스 기술범주와 몰입감/현실감 향상을 위해 5G통신과의 초연결성(Hyper-Connectivity)을 강조하고 있다.

-

• 디스플레이(Dispaly) 기술: AR/VR 속 몰입콘텐츠를 사용자가 감각적으로 경험할 수 있게 만드는 화상 기술로 현재 시각, 청각에 주안점을 두지만, 향후 촉각, 후각, 미각 및 디지털트윈을 통한 미래예측 인공지능 가능 타진

-

• 트래킹(Tracking) 기술: 몰입 콘텐츠에서 사용자 생체데이터를 인지하여 실시간으로 추적하는 기술로 현재 전 세계 스타트업 회사 중심으로 손동작, 발동작, 골격추적을 연구

-

• 정합(Rendering) 기술: 몰입콘텐츠를 고해상도/고화질로 정합·구현하는 HW/SW 통합기술로 콘텐츠의 사실적인 표현을 나타내는 게임회사의 VR콘텐츠 제작과 AR가상객체 생성을 연구

-

• 사용자 인터페이스 상호작용(UI Interaction)기술: 몰입콘텐츠를 지각/인지/조작/입력하는 웨어러블 상호작용 및 인터페이스 기술로 적외선/자이로-센서를 내장하여 모션 플랫폼과 연동을 연구

그러나 ETRI-TR 과제는 ‘보는통신’에 주안점을 두고, 기존 XR 접근과 다른 핵심연구 방향을 수행하고 있다.

본 고에서는 좀 더 구체적으로 기술들을 언급하며, TR은 포스트-스마트폰에 대한 대안 기술 제시로, 보이는 상태에서 개인 정보보호의 프라이버시 보호기술, 보이는 상태에서 연결하는 ‘보는통신’의 각종 플랫폼 기술 및 보이는 상태에서 연결의 통신인프라 구축 등을 위한 핵심기술 개발을 목표로 하고 있다.

따라서 ‘포스트-스마트폰’이 될 수 있는 혁신적인 5G+ICT기기 및 4차 산업혁명의 핵심 기반기술이 될 수 있는 TR 기술이 추구하는 방향성 제시와 TR에서 개발하고자 하는 연구 개발 내용의 상세 소개와 함께 5G+ICT기술의 새로운 흐름에 시사점을 제시하고자 한다.

II. 5G+VR/AR/MR/XR 기술 동향

본 절에서는 글로벌 스마트안경의 VR/AR/MR/XR 기술적 동향과 이들 콘텐츠의 몰입감 향상 기술과 5G의 고성능, 고품질의 연결성(Connectivity)기술 동향[7]을 살펴보고자 한다.

1. 현재 VR/AR/MR/XR 기기동향

가. 초고화질 광시야각 오감형 디스플레이

-

• VR HMD의 시야각은 90°(Google의 Card-board)에서 최대 210°(Starbreeze의 StarVR)까지 기술 개발이 이뤄졌으며, 제품별 평균 110°의 시야각을 보임

-

• AR HMD의 시야각은 14.7°(Google glass)에서 35°(Microsoft-Hololens), 60°(ODG-R9), 90° (Meta-Meta2) 등 제품별로 시야각에 큰 편차를 보임

-

• AR/VR HMD는 대부분 HD(720p) 또는 full HD(1,080p = 2K) 수준의 해상도를 양안 디스플레이를 통해 제공하고 있음

-

• AR/VR 분야의 디스플레이 패널은 기존 액정 기반 디스플레이(LCD: Liquid Crystal Display)에서 얇은 두께로도 높은 해상도를 제공할 수 있는 OLED(Organic Light Emitting Diode) 기반의 디스플레이로 전환되는 추세이며, Oculus Rift(2018), HTC Vive pro(2018), HMD Odyssey(2017) 등에 적용됨

-

• 동일 시간에 얼마나 많은 화면 프레임을 표시할 수 있는지를 나타내는 재생빈도 지표는 높을수록 사용자의 가상멀미(Virtual-sickness)를 최소화하며, 현재 VR 기기 중 LCD 기반 제품의 재생빈도는 65Hz, OLED 기반 제품의 경우 약 86Hz의 수준까지 개발됨

-

• 16K급 고해상도, 140°~250°에 이르는 광 시야각, 고속 주사 방식, 밝기 최적화, 착용 편의성, See-through 기술 개발 방향 진화 중

나. 초정밀 이미지센서 트레킹

-

• 최근 6DoF(Degree of Freedom) 구현을 위해 GPS, 가속도센서, 자이로스코프, RFID, 무선센서 등이 결합된 하이브리드 위치 추적 기술이 연구 개발 중

-

• Microsoft社는 추적 대상이 시야에서 벗어나거나 장애물에 가려도 트래킹을 유지할 수 있는 인사이드-아웃 트래킹 기술을 연구 개발함으로써 일상생활 속 가상현실 기술의 활용 편의성을 대폭 향상

-

• Google社의 ‘Tango Project’는 적외선 카메라를 활용해 3D 환경을 탐색하거나 공간의 특징을 파악할 수 있는 비전트래킹 기술 개발

다. 초저지연 정합(Rendering) HW/SW

-

• NVIDIA社는 고품질 가상현실 콘텐츠에 대해 사용자가 경험하는 지연시간을 단축시킬 수 있는 Direct Mode 기술 및 실시간 처리 기술을 연구 개발

-

• AMD社는 HMD를 통해 사용자에게 제공되는 AR/VR 콘텐츠의 지연시간 단축을 위해 헤드 트래킹 속도를 높이는 Latest data latch 기술, 이미지의 생성 속도를 높이는 기술 등을 개발

-

• 5ms 이내 갱신 속도, 50ppd(pixel per degree) 이상의 해상도, Ray-tracing과 영상 접합 기술에 의한 실시간 렌더링 기술 개발로 진화 중

-

• NVIDIA社는 고품질 가상현실 콘텐츠에 대해 사용자가 경험하는 지연시간을 단축시킬 수 있는 Direct Mode 기술 및 실시간 처리 기술을 연구 개발

라. 인터랙션 및 UI/UX

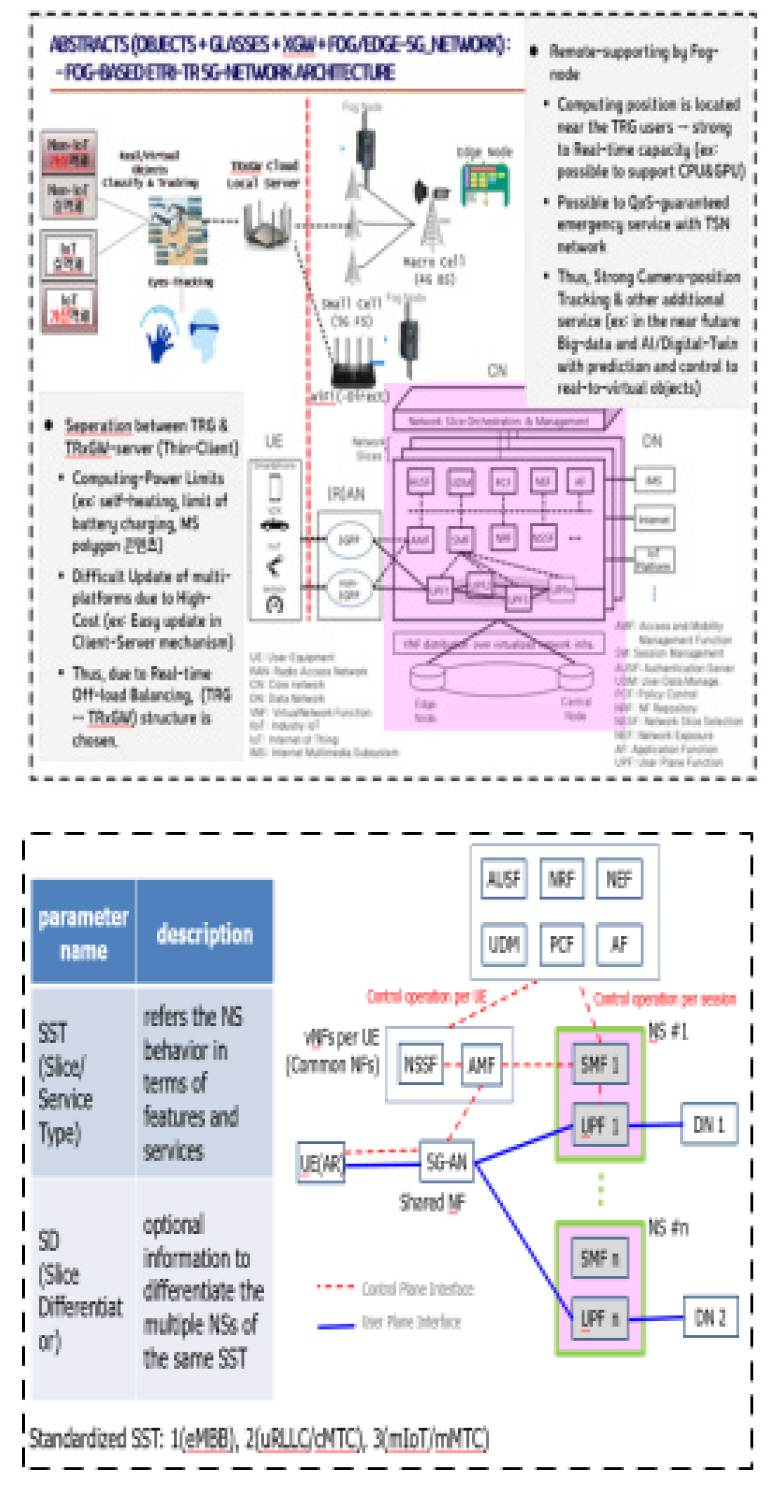

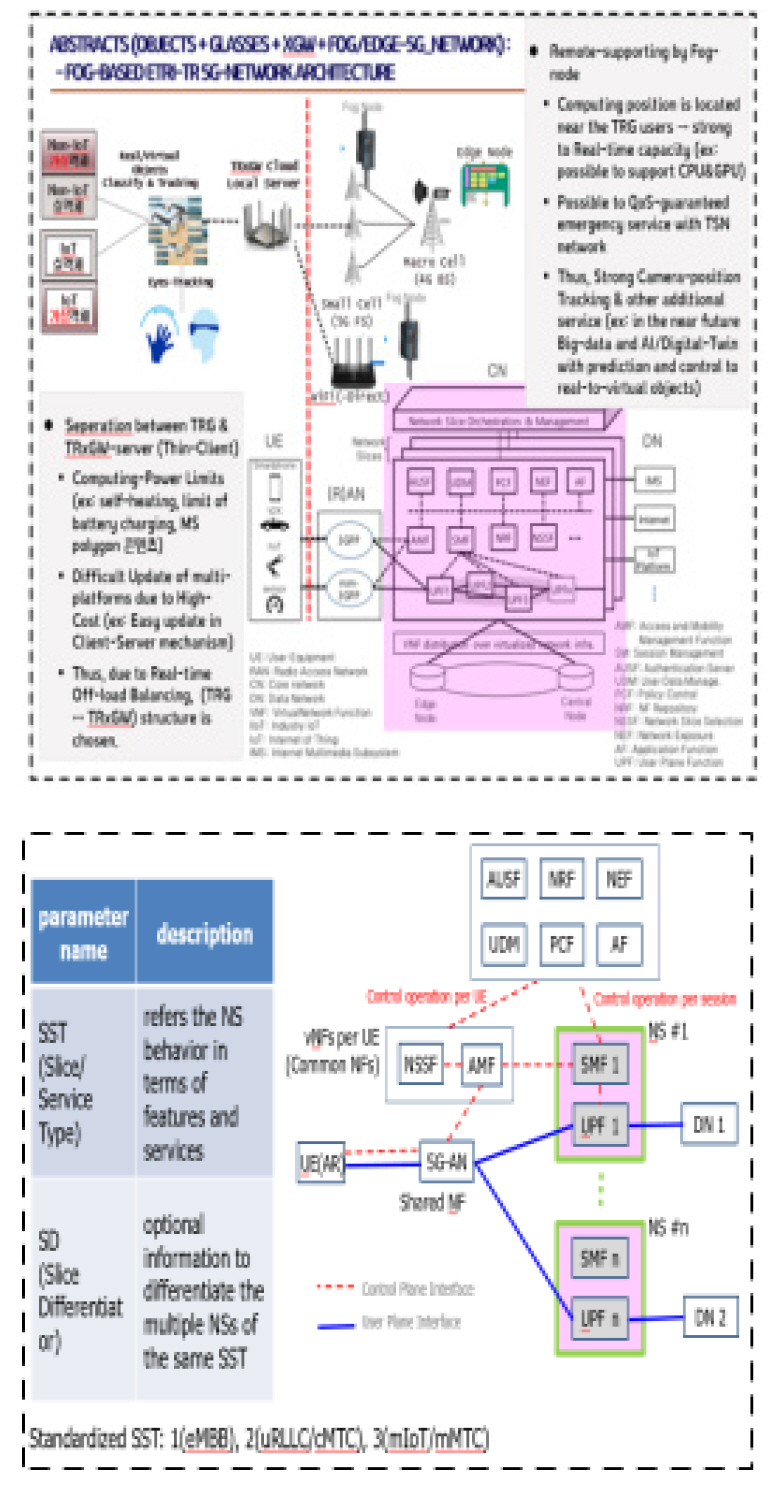

2. 5G+스마트안경(TR) 연동

현재 VR/AR 스마트안경의 네트워크 연동 방식으로는 페어링(pairing, Wi-Fi로 기기/LocalEdge AP와 연결하여 유선망과 연동), 테더링(tethering, Wi-Fi 연결 후 LocalEdge의 5G 모뎀 칩을 통해 5G와 연동) 등이 있다.

미국 퀄컴社에서는 SnapDragon 칩을 사용하면 스마트안경의 Stand-alone 방식으로 직접 Small-cell(5G안테나) & Macro-cell(4G안테나)로 Multi-path 방식의 28G 대용량 스펙트럼 통신을 할 수 있다고 선전하고 있다[5].

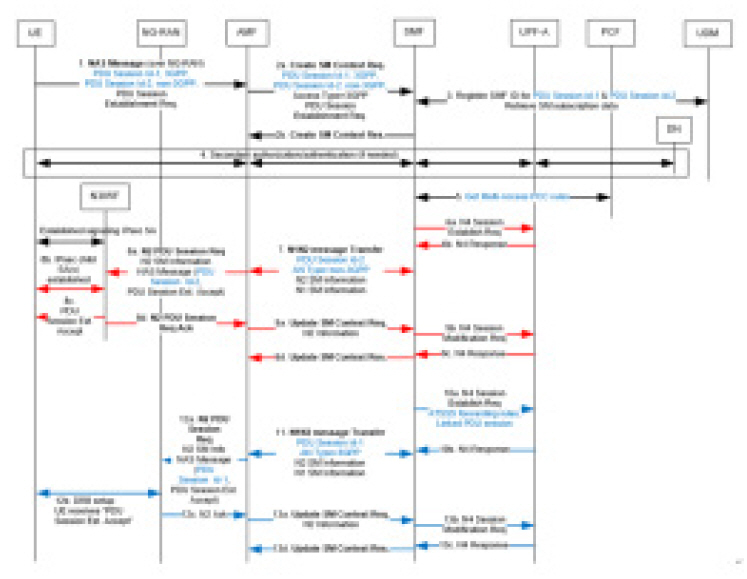

5G의 선두주자인 중국 화웨이社는 2016~2017년경 “코어 네트워크 슬라이스뿐만 아니라 RAN 슬라이스, D2D 슬라이스”가 제공되어야 한다고 주장하였다. 노키아社는 ‘RAN 슬라이스’ 개념 구조만을 논문 등을 통해 발표하였다. 그 이후 국제표준화(3GPP) 과정에서 2019년 현재 ‘코어 네트워크 슬라이스’만을 표준화 완성단계에 도달하였다.

‘네트워크 슬라이스’ 개념은 통신사업자가 과거 전용선 제공 임대료를 받는 것처럼, 4차 산업혁명 스마트산업체에 ‘가상화 전용선 임대료’를 받겠다고 출발한 것이다.

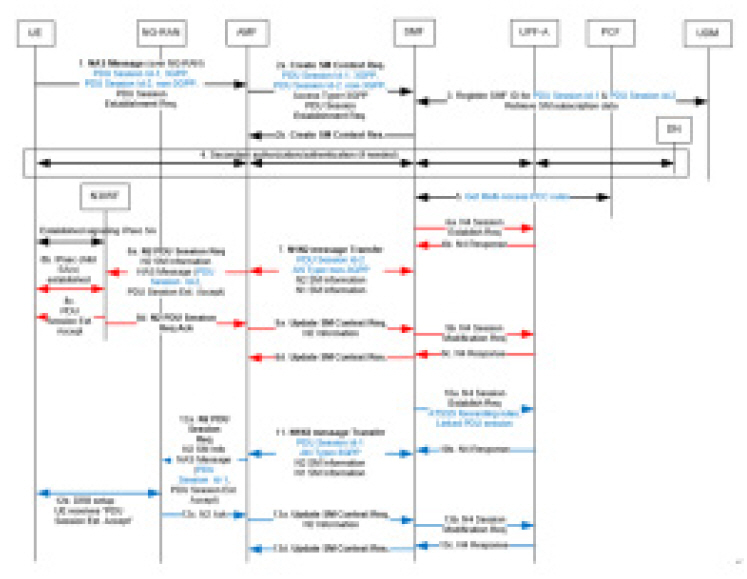

그러나 진정한 5G 네트워크 슬라이싱을 통한 VR/AR의 고품질 서비스를 받기 위해서는 다음과 같은 TRG 기기와 5G Core 네트워크 간의 연동 메커니즘이 제시되어야 한다[6,8].

III. 현 ETRI-TR 주요 핵심기술들

1. TR 글라스 소프트웨어 플랫폼

스마트폰은 손가락 터치 방식으로 전화, 문자, 이메일, 카메라 등 여러 기능들과 앱 기반 서비스를 제공한다[2]. 또한, 현재 HMD 등의 스마트 글라스는 카메라를 이용하여 실상에 가상의 콘텐츠를 정합하여 서비스를 제공한다[3]. 이러한 정보통신 방식은 인간이 두 손을 사용하여 단계적 절차에 따라 데이터를 전송해야 하므로 그 절차 및 진행이 까다롭기 때문에 손쉽게 데이터를 전송하는 방식이 필요하게 되었고, 그 한 예로서 QR코드 방식으로 이미지 전송을 통해 비교적 쉽게 연결 정보를 한 번에 보내는 방식이 연구되고 있다. 그러나 현존하는 스마트 VR/AR 글라스는 유리라는 안경에 가상의 이미지를 정합하는 기술 자체에만 치중하고 있어 보이는 정보와 지식정보를 소통하는 측면에서 바라볼 때, 현재의 증강현실(AR), 가상현실(VR) 및 혼합현실(MR) 기술은 제약된 콘텐츠 정보를 보이는 정보를 통해 수동적으로 소통하는 수준에 머무르고 있다. 따라서 TR 안경은 보이는 정보뿐만 아니라 스마트폰 기능이 지니는 전화, 문자 전송 및 이메일 등 전통적인 정보교환 기능까지 포함한다[1,4].

가. TR의 소프트웨어 플랫폼

-

• 스스로 다양한 정보를 생성하고 인간 간에 능동적으로 정보가 전달될 수 있도록 인간 중심의 능동적 소통방식을 지원하는 ‘보는통신’이 가능한 소프트웨어 플랫폼 구조 제시

-

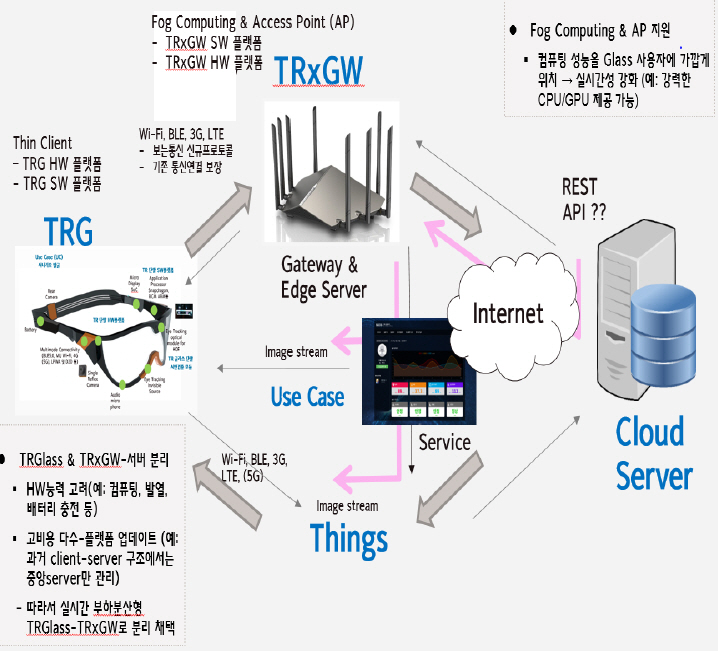

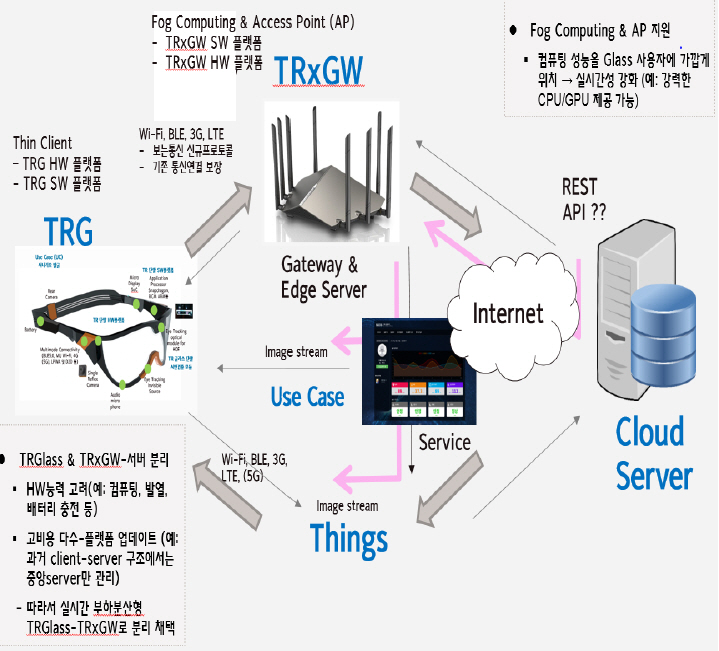

• 크게 스마트폰 기능뿐만 아니라 스마트 글라스의 기능을 동시에 만족하는 TR 글라스 플랫폼 구조와 데이터 통신 처리 기능의 TRXGW(TR eXtensible GateWay) 플랫폼 구조로 구성

-

• 스마트 글라스상의 스마트폰 기능 제공

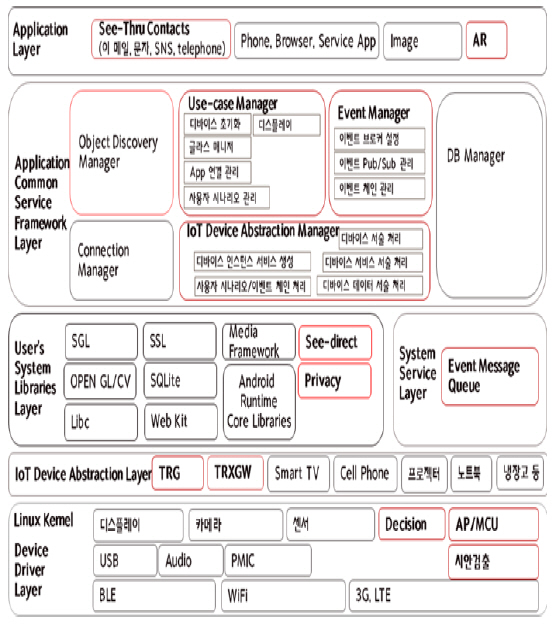

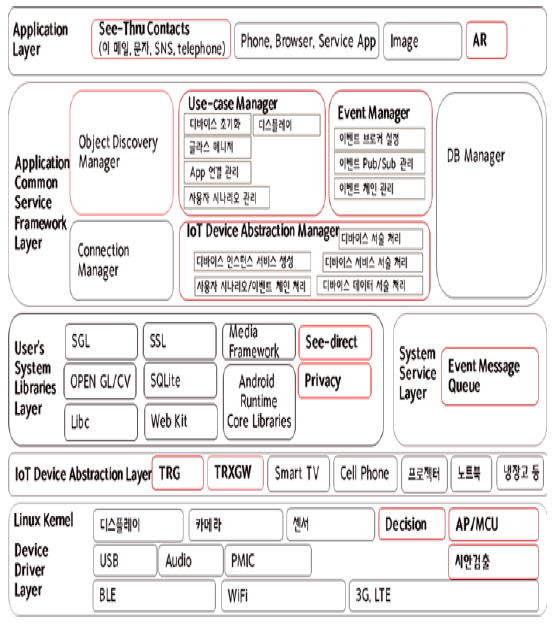

1) TRG 소프트웨어 플랫폼 구조[4]

TRG 소프트웨어 플랫폼의 계층은 하드웨어에 대한 의존성 없이 TRG 단말의 운영 응용개발 및 사용자 시나리오에 집중할 수 있도록 계층을 분할하였으며, IoT Device Abstraction Layer에 Use-Case와 Event Chain, TRXGW와 같은 다른 단말과의 통신 데이터 서술로 즉시 동작하는 특징을 가지고 있도록 설계되었다.

또한 Device 자원들의 스케줄링과 제어가 가능하도록 서비스를 제공하는 계층과 데이터 수신, 데이터 분석, 데이터 전송 등 일련의 상태를 처리하는 프로세스를 관리하는 구조로 설계된다. 또한, Application Layer의 응용개발을 하드웨어와 상관없이 일관된 방법으로 구현 가능하도록 추상화하는 계층이 존재하도록 구성된다. 각 계층의 역할은 다음과 같다.

-

• Application Layer: TRG 사용자를 위한 작동뿐만 아니라 개발자에게도 TRG의 기능을 제공할 수 있도록 관리하는 계층

-

• Application Common Service Framework Layer: TRG의 서비스 기능 제공을 가능하게 하는 서비스 프레임워크 요소 계층

-

• User’s System Libraries Layer: TRG에 필요한 각종 라이브러리를 포함하는 계층

-

• IoT Device Abstraction Layer: Application Layer 응용개발을 하드웨어와 상관없이 일관된 방법으로 구현 가능토록 추상화한 계층

-

• System Service Layer: 이벤트 데이터를 전달하는 기본 시스템 서비스를 제공

-

• Device Driver Layer: IoT Device Input/Output 관련 인터페이스 객체들을 정의

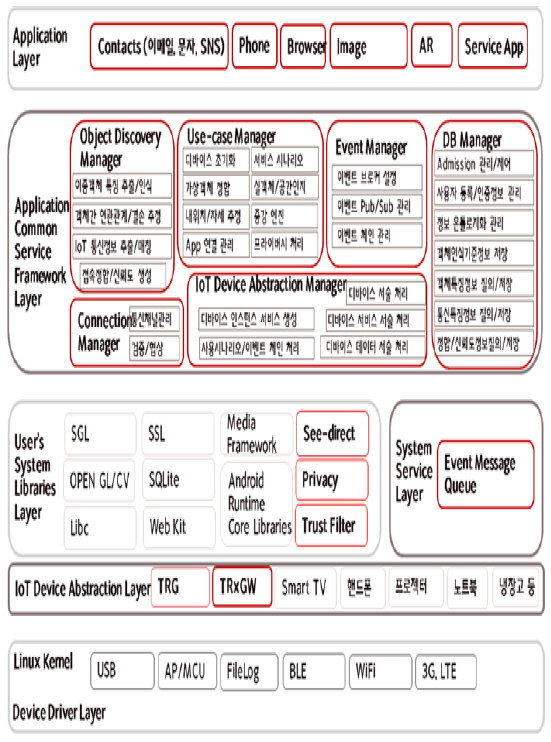

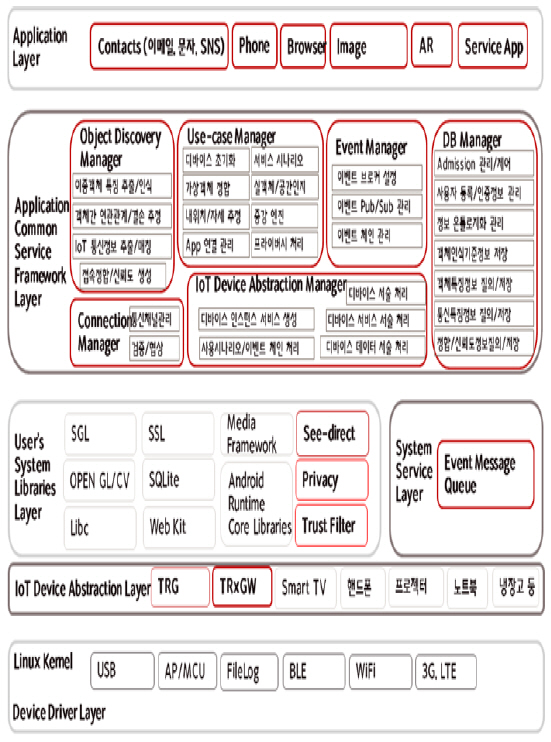

2) TRXGW 소프트웨어 플랫폼 구조[4]

TRXGW 소프트웨어 플랫폼 또한 하드웨어에 대한 의존성 없이 TRG 및 기타 IoT 기기와의 운영 응용개발 및 사용자 시나리오에 집중할 수 있도록 계층을 분할하였으며, IoT Device Abstraction Layer에 Use-Case와 Event Chain, TRG와 같은 다른 단말과의 통신 데이터 서술로 즉시 동작하는 특정을 가지고 있도록 설계된다. 또한 Device 자원들의 스케줄링과 제어가 가능하도록 서비스를 제공하는 계층과 데이터 수신, 데이터 분석, 데이터 전송 등 일련의 상태를 처리하는 프로세스를 관리하는 구조로 설계된다. 또한, Application Layer의 응용개발을 하드웨어와 상관없이 일관된 방법으로 구현 가능하도록 추상화하는 계층이 존재하도록 구성된다.

즉, TRXGW 소프트웨어 플랫폼은 TRG 플랫폼과 비슷하게 Application Layer, Application Common Service Framework Layer, User’s System Libraries Layer, System Service Layer, IoT Device Abstraction Layer, Device Driver Layer로 구성된다. TRG 플랫폼과 TRXGW 플랫폼은 상호연동이 가능한 시스템의 구조를 지향하고 있으며, TRG에서 처리가 필요한 컴퓨팅 기능을 처리하는 방식으로 구조·설계된다. TRXGW는 각각 Object Discovery Manager, Use Case Manager, DB Manager 등과 각종 라이브러리 계층이 차별적 기능으로 설계된다. 각 계층의 역할은 다음과 같다.

-

• Application Layer: TRG 사용자를 위한 작동뿐만 아니라 개발자에게도 TRG의 기능을 게이트웨이에서 제공하도록 관리하는 계층

-

• Application Common Service Framework Layer: TRG의 서비스 기능 제공을 가능하게 하는 서비스 프레임워크 요소 계층

-

• User’s System Libraries Layer: TRXGW에 필요한 각종 라이브러리를 포함하는 계층

-

• IoT Device Abstraction Layer: Application Layer의 응용 개발을 하드웨어와 상관없이 일관된 방법으로 구현 가능하도록 추상화한 계층

-

• System Service Layer: 이벤트 데이터 전달 기본 시스템 서비스 제공

-

• Device Driver Layer: IoT Device Input/Output 관련 인터페이스 객체들이 정의

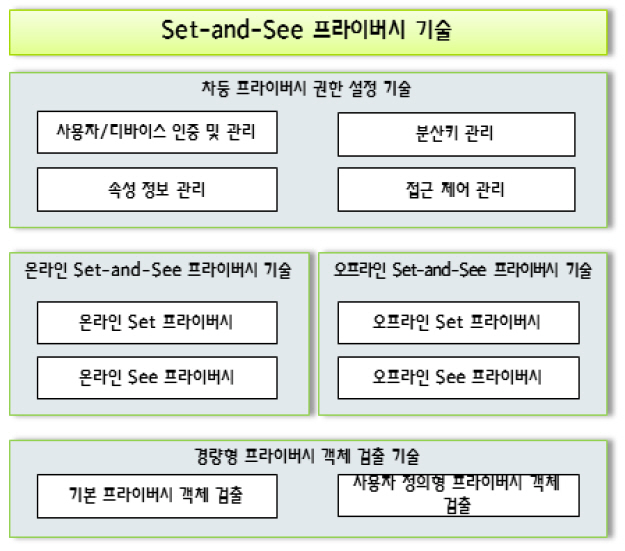

2. Set-and-See 프라이버시 기술

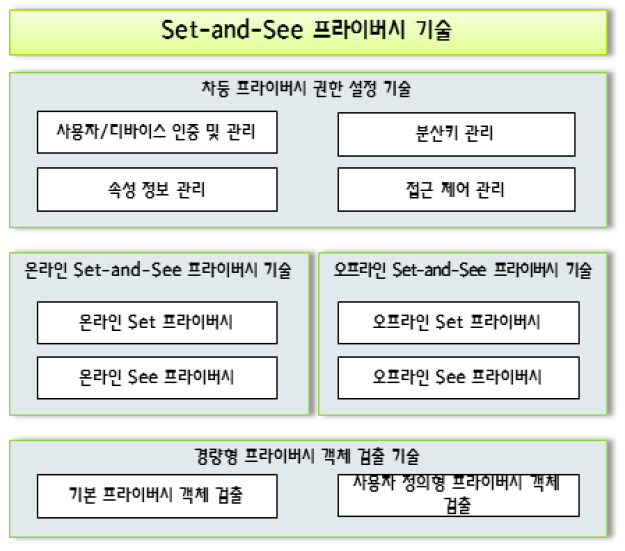

본 절에서는 TR 기기를 통해 ‘보이는 세상’의 개인정보를 사용자 관점에서 차등적으로 보호하는 Set-and-See 프라이버시 기술의 개념과 기존 온라인 객체(예, 텍스트, 이미지, 동영상 등)를 포함하여 오프라인 객체(예, 출력물, 문서 등) 내에 존재하는 개인정보를 보호하는 기술을 소개한다.

가. Set-and-See 프라이버시 개념

TR 기기를 통해 보이는 영상은 개인의 사생활 보호를 위해 프라이버시 보호기술 적용이 필요하다. 현재는 주로 영상 내 일부 사생활 영역을 원영상 복원을 고려하지 않고 비식별화하는 기술이 주를 이루고 있으며, 온라인 영상 내의 개인정보에만 초점이 맞추어져 있다. 개인의 사생활 보호에 대한 사회적 요구는 온라인 영상뿐만 아니라 오프라인상에서 유통되는 출력물, 문서 등에 포함된 개인정보에 대한 보호로 확대되고 있는 실정이다[9,10].

ETRI-TR 과제에서 개발하는 Set-and-See 프라이버시 기술은 이러한 사회적 요구를 반영하여 온라인뿐만 아니라 오프라인상에서 유통되는 개인정보를 보호하며, 사용자 관점에서 획일화되지 않은 다양한 프라이버시 제공이 가능하다. 본 기술은 영상 내 개인정보 영역을 보호하는 Set 프라이버시 기술과 보호된 프라이버시 영역을 원영상으로 복원하는 See 프라이버시 기술로 구성된다. 또한 차등 프라이버시 기술을 통해 사용자의 속성 정보를 기반으로 차별적인 프라이버시 서비스를 제공한다.

Set-and-See 프라이버시 기술은 적용 대상에 따라 다음과 같이 크게 두 가지로 구분한다.

-

• 온라인 Set-and-See 프라이버시 기술: 온라인 영상 내의 사생활 영역을 대상으로 프라이버시 서비스를 제공하는 기술

-

• 오프라인 Set-and-See 프라이버시 기술: 오프라인 객체 내의 사생활 영역을 대상으로 프라이버시 서비스를 제공하는 기술

나. Set-and-See 프라이버시의 세부 기술

Set-and-See 프라이버시 기술은 경량형 프라이버시 객체 검출 기술, 온라인 Set-and-See 프라이버시 기술, 오프라인 Set-and-See 프라이버시 기술 및 차등 프라이버시 권한 설정 기술로 구성된다.

1) 경량형 프라이버시 객체 검출 기술

TR 기기 영상을 위한 프라이버시 객체 자동 검출 기술은 TR 기기의 성능 한계 및 지속적이며 연속적인 환경 변화를 고려한 경량형 프라이버시 객체 검출 기술이다. 기존 객체 검출 기술과 달리 프라이버시 객체 검출 기술은 실시간 적용이 가능해야 하며, false negative rate가 0에 가까워야 한다.

검출의 대상이 되는 프라이버시 객체는 얼굴, 자동차번호판, 주민등록번호와 같은 기본 개인정보 객체와 차등 프라이버시 서비스를 위한 사용자 정의형 프라이버시 객체가 있다.

2) 온라인 Set-and-See 프라이버시 기술

코덱독립형 전주기 프라이버시 마스킹/복원 기술을 이용하여 온라인 영상의 코덱 종류에 무관하게 프라이버시 보호 서비스를 제공하는 기술이다.

경량형 프라이버시 객체 검출 기술에 의해 검출 된 개인정보 영역을 온라인 Set 프라이버시 기술을 통해 비식별화하고, 권한 정보(키 정보)를 가진 사용자만이 온라인 See 프라이버시 기술을 통해 비식별화된 개인정보 영역을 원영상으로 복원할 수 있다.

3) 오프라인 Set-and-See 프라이버시 기술

오프라인상에서 유통되는 개인정보를 보호하기 위한 기술로써, 사용자 정보가 포함된 출력물, 택배송장, 계약서 등에 적용이 가능하다.

문서에 개인정보가 포함될 경우, 오프라인 Set 프라이버시 기술을 통해 개인정보 영역을 비식별화한 후 출력물을 생성한다. 비식별화된 오프라인 문서는 TR 기기를 통해 온라인 영상으로 변환되고, 오프라인 See 프라이버시 기술을 통해 비식별화 영역이 복원된다.

4) 차등 프라이버시 권한 설정 기술

분산형 차등 권한 설정을 통해 사용자 특성 및 서비스 종류에 따라 차등 프라이버시 서비스를 제공하는 기술이다. 사용자, 디바이스 연계형 속성 기반 접근통제 모델을 기반으로 접근제어 권한 설정을 하며, 사용자 속성, 사용자/디바이스 연계 속성, 프라이버시 객체 속성에 따라 서로 다른 프라이버시 보호 서비스를 제공할 수 있다[11].

차등 프라이버시 권한 설정 기술은 사용자/디바이스 인증, 사용자/디바이스 관리, 분산키 관리, 속성정보 관리와 접근제어 관리로 구성된다.

3. TR 시점 기반 네트워킹 기술

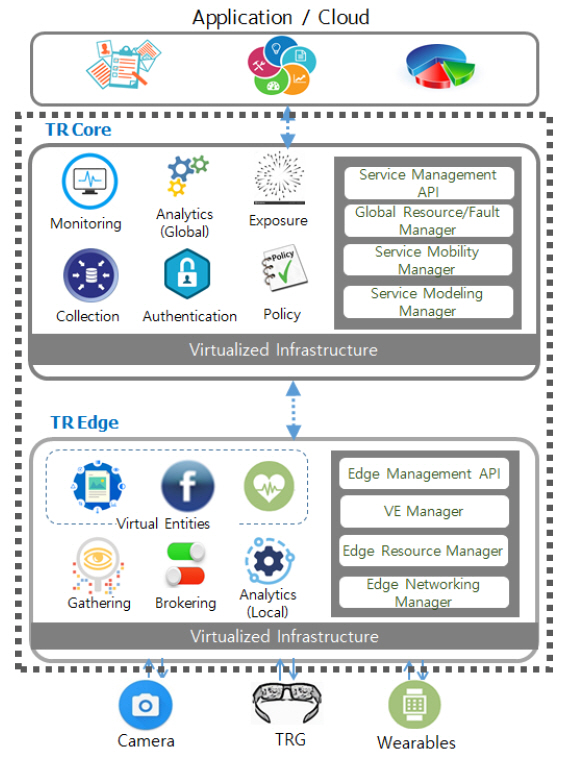

본 절에서는 물리세계와 사이버세계가 자동으로 연결되어 사용자 맞춤형 서비스 환경을 동적으로 제공하기 위한 시점 기반 네트워킹(TRVN: TR Viewpoint Networking) 기술을 소개한다.

가. TRVN 개념 및 프레임워크

TR 시점 기반 네트워킹(TRVN)은 사전적 해석의 Viewpoint 개념의 중복적 의미, 즉 어떤 주제에 대한 논리적 관점의 의미와 실제로 무엇을 바라보는 물리적 시점의 의미를 모두 포함한다. 따라서 TR 시점 기반 네트워킹은 관점 차원에서 사용자 맞춤형의 서비스 환경을 동적으로 제공하기 위한 기술이며, 이와 동시에 시점 차원에서 눈에 비치는 개체들 간의 네트워크를 구성하고 물리개체와 가상개체 간의 연동을 통해서 실-가상 환경을 실시간으로 제공하는 기술적 개념을 포함한다[12].

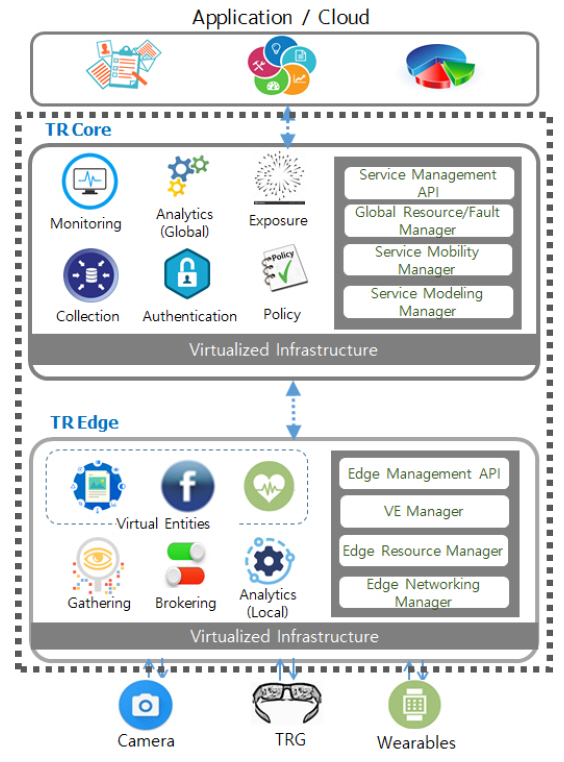

TRVN 프레임워크는 사용자의 시점에 기반하여 동적으로 맞춤형 서비스를 제공하기 위해서 위에서 보는 바와 같이 에지노드와 코어노드로 구분된다. 에지노드에서는 사용자에게 직접적으로 서비스를 제공하기 위한 VE(Virtual Entity)들과 PE(Physical Entity)들이 합류되는 PoP(Point of Presence)로서 사용자에게 가장 가까운 위치에 배치된다. 코어노드는 분산된 에지노드들과 통신하여 전체 서비스를 제어관리하며, 분산된 에지노드로부터의 의미 있는 데이터들을 수집하여 전체 서비스의 정책을 결정하고 외부 클라우드나 응용서비스와 연동하는 역할을 수행한다.

TRVN 프레임워크는 또한 관리평면과 응용평면으로 구분이 가능하다. 관리평면은 사용자의 맞춤형 서비스를 발견하고 서비스에 필요한 기능 및 자원을 배치하고 실행하며, 전 주기에 걸쳐서 구성, 상태, 이동 및 장애관리 기능을 수행한다. 반면에 응용평면은 배치된 서비스의 컴포넌트들과 물리개체들 간의 연동 및 컨텍스트에 기반한 연계 기능을 수행한다. 또한 응용서비스의 실행 중에 발생하는 데이터를 수집하여 분석하고 필요한 정책을 결정하여 응용서비스가 상황에 기반하여 동작할 수 있도록 제어한다.

나. TRVN 요소 기술

TRVN에서 이루고자 하는 사용자의 시점에 기반하여 동적으로 서비스를 구성하고, 실-가상 연동을 통하여 AR/VR/MR과 같은 실감형 서비스 제공을 위한 개방형 네트워킹에 필요한 핵심 요소 기술은 다음과 같다.

1) 마이크로서비스 아키텍처 기술

흔히 레고에 비유되는 마이크로서비스 아키텍처는 단독으로 실행 가능하고 독립적으로 배치될 수 있는 작은 단위(모듈)로 기능을 분해하여 서비스하는 아키텍처로서, 각 마이크로서비스는 공유나 프로세스 간 통신 없이도 독립적으로 실행되며 운영 관리된다. TRVN에서는 마이크로서비스 아키텍처 기술을 기반으로 사용자의 환경에 맞추어 조합하여 원하는 서비스를 제공하는 기술을 개발하여 적용하고자 한다.

2) 이벤트 기반 브로커링 기술

실시간으로 실-가상 개체를 연결하고 개체 간의 네트워크를 구성하기 위해서는 순간순간 발생하는 이벤트들에 따라서 실개체와 가상개체를 연동하고 개체들 간의 상황변화에 대응하기 위한 기술이 필요하다. TRVN의 이벤트 기반 브로커링 기술은 개체들과 개체들 간의 이벤트, 이벤트에 따른 실행관계를 모델링하고, 이를 적용하여 이벤트의 수집, 변환, 전달, 액추에이팅 기능을 수행한다. 또한 관리평면과 연동하여 관리체계 상에서의 이벤트에 대해서도 연동하여 응용서비스를 최적 관리 기능도 포함한다[13,14].

3) TRVN 통합 오케스트레이션 기술

네트워크에 분산된 에지노드에서 발생하는 관리 측면에서의 상태 정보, 장애 정보 등을 수집하여 통합적인 자원 및 기능이 연결된 하나의 서비스로 관리하기 위한 운영 측면에서의 통합 오케스트레이션 기술이 필요하다. 서비스에서 필요한 기능들의 체이닝, 스케일링 또는 마이그레이션 등의 정책을 결정하고, 에지노드들로 전달하여 이를 수행·관리한다.

또한 응용 관점에서 이벤트들 간의 원격 브로커링을 위해서 분산된 에지노드들 간의 이벤트를 수집 관리하며, 특정 이벤트 발생 시에 이를 감지하여 분산 에지들 간의 이벤트 브로커링을 위한 응용평면에서의 통합 오케스트레이션 기술을 포함한다.

4. TRG를 위한 통신 인터페이스

본 절에서는 TRG를 통해 사용자가 바라보며 연결하는(Look-and-Connect) 방식으로 주변 IoT 장치를 직관적으로 접속하는 새로운 UX의 필요성과 이를 지원하기 위한 관련 기술 및 ETRI에서 개발 중인 See-Direct 프레임워크 기술을 소개한다.

가. 시선 인터페이스의 필요성

Wi-Fi 또는 블루투스를 지원하는 IoT 장치에 접속하는 방법은 일반적으로 검색 및 선택(Scan-and-Select) 방식의 접속절차를 따르며, 이는 사용자가 미리 통신 식별자를 알고 있는 상태에서 검색된 주변장치 목록으로부터 연결할 대상장치를 직접 선택해야만 한다. 만약, 검색된 목록이 많을 경우, 스마트폰과 같은 터치 인터페이스가 없는 TRG와 같은 안경 형태의 장치에서 주변장치와 연결하려면 보다 편리한 사용자 인터페이스가 필요할 것이다.

관련 연구로서 스마트폰에서 Wi-Fi 또는 Bluetooth 연결을 위해 추가적인 보조통신(예, NFC, IrDA 등)을 활용하여 태깅하거나 리모컨을 사용하듯 통신대상을 가리키는 자연스러운 동작으로 장치 페어링을 위한 정보(예, MAC 주소 등)를 획득함으로써, 검색 목록으로부터 통신대상을 선택하는 사용자 개입을 최소화하려는 시도가 있다[15,16]. 그러나 IrDA는 분해능이 떨어지고 장애물에 민감하며, NFC는 통신대상에 가까이 다가가서 직접 터치해야 하는 불편함이 있다.

한편, 안경형 단말에서 바라보는 인터페이스로 주변장치의 통신식별자를 획득하기 위해서는 통신대상을 인식하는 기술이 필요하다. 최근 딥러닝을 이용한 영상인식 기술이 각광받고 있으나, 카테고리 분류 또는 증강정보 표시를 위한 이미지 정합이 주요한 목적으로 활용되며, 이미지 촬영조건에 따라 정확도가 떨어지는 단점이 있다. 인식대상 후보가 많을 경우, 제한된 성능을 가진 모바일/웨어러블 단말에서 빠른 영상처리가 어렵고, 서버에서 영상처리를 할 경우에도 네트워크 대역폭에 의존하므로 실시간 인식에 어려움이 있다. 또한, AR/VR/MR 기술을 활용한 SNS/광고서비스들은 공간 모델링 및 DB 구축을 위한 과부하가 존재한다.

한편 블루투스 5.1 규격에 포함된 방향 탐지(Direction Finding) 기술은 멀티 안테나에 입사된 전파의 위상차를 계산(AoA: Angle of Arrival)하여 블루투스 장치들 간 상대각을 측정할 수 있는 기능을 제공한다[17]. See-Direct 프레임워크에서는 통신대상을 식별하기 위해 이미지 분석과 다양한 공간분석(예, AoA를 통한 상대위치 추정, 비콘 분석 등)을 모두 활용하고자 한다.

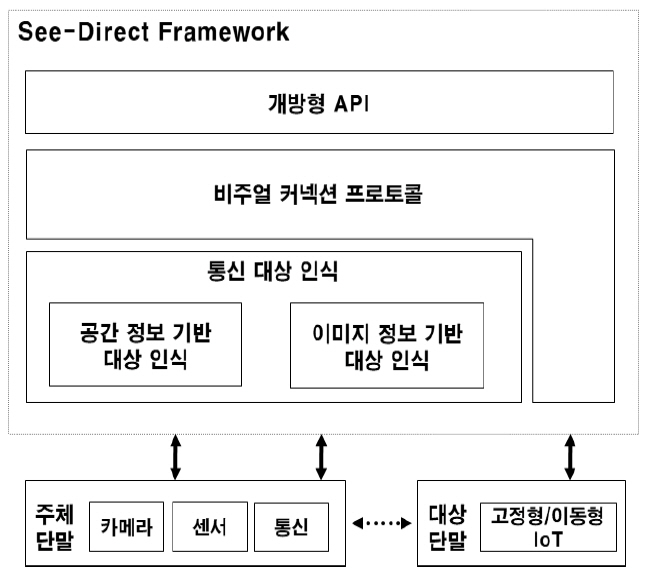

나. See-Direct 프레임워크 구조

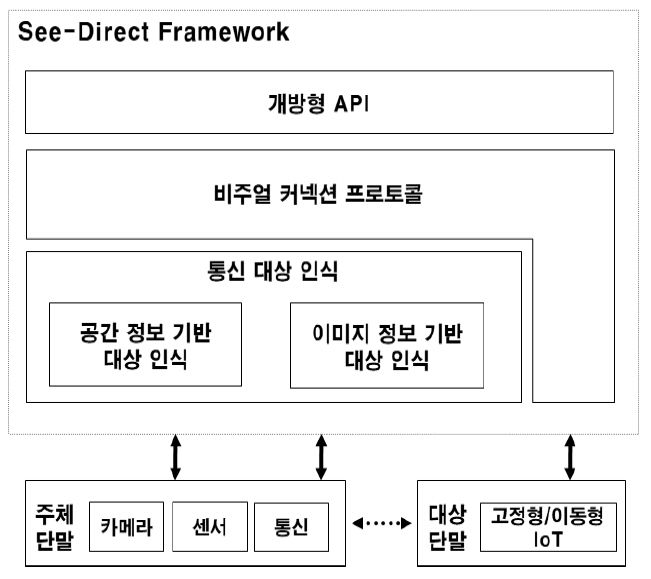

See-Direct 프레임워크는 다음과 같이 크게 통신대상 인식, 비주얼 커넥션 프로토콜, 개발지원 기술로 구성된다.

통신대상 인식은 TRG 단말에서 주변 IoT 장치의 이미지 분석, 설치된 위치, 상대각 추정(AoA)등을 통해 사용자가 바라보는 대상장치를 인식한다. 비주얼 커넥션 프로토콜은 TRG 단말에 부착된 센서들을 활용하여 영상분석 의존도를 낮추면서 목표장치로 연결할 수 있는 통신절차를 정의한다. 가장 상위층은 See-Direct 서비스 개발지원을 위해 개방형 API를 제공한다.

1) 통신대상 인식 기술

See-Direct 통신대상 인식은 크게 이미지 정보 기반과 공간 정보 기반의 대상 인식으로 구성된다. 이미지 정보 기반의 대상 인식 기능은 통신대상 객체 인식에 객체의 이미지를 정보로 활용한다. 공간 기반 대상 인식은 통신대상의 위치 및 센서 정보 등을 활용하여 통신대상을 인식한다.

-

• 이미지 기반 통신대상 인식: TRG 단말의 카메라를 통해 얻은 시선의 정면에 위치한 통신대상을 인식한다. 사용자는 카메라를 통해 대상을 촬영하고 이를 이미지 분석 서버로 전송한다. 서버에서는 주어진 이미지가 기존에 등록된 통신대상들 중의 하나인지를 판독하고, 결과를 TRG 단말로 보낸다. 대상 인식을 위한 이미지 매칭 엔진으로 IoT 장치 인식에 특화된 CNN 기반 딥러닝 신경망을 활용한다.

-

• 공간 정보 기반 통신대상 인식: 통신대상이 존재하는 공간에 대한 정보를 획득하여 See-Direct 대상을 인식한다. TRG 단말의 블루투스 비콘을 이용하여 통신대상이 위치한 장소 정보를 알아내거나, 블루투스 장치 간 상대각 추정기능을 이용하여 사용자가 바라보는 대상을 선정할 수 있는 기능을 제공한다.

2) 비주얼 커넥션 프로토콜

통신대상 객체를 인식하기 위한 전반적인 동작 절차를 정의한다. 비주얼 커넥션 프로토콜은 하부의 통신대상 인식기술을 이용하여, 특정 통신(예, Wi-Fi, Bluetooth)에 필요한 통신식별자를 획득하는 일련의 절차를 정의하며, 다음과 같은 기능을 갖는다.

-

• 객체 인식 정보 설정: 객체 인식의 오차 범위, 객체인식 기술들 간에 우선순위 및 가중치 등을 설정할 수 있는 기능을 제공

-

• 객체 인식 절차 제어: 통신대상 객체의 통신 ID를 획득하기 위한 세부 동작 절차를 제어하는 기능을 제공

3) 개방형 API

응용 개발자가 See-Direct 커넥션 프레임워크의 내부 기능을 사용할 수 있도록 다음의 다양한 인터페이스를 제공한다.

-

• 프레임워크 코어 및 설정 인터페이스: 코어 인터페이스는 See-Direct 서비스 시작, 상태 모니터링 및 종료 등을 담당한다. 설정 인터페이스는 통신대상 인식 및 통신프로토콜에 참여할 TRG 단말의 센서를 포함하거나 제외하는 기능을 제공한다.

-

• 통신대상 인식 인터페이스: See-Direct 통신대상 인식을 위해 TRG 단말 카메라를 통해 IoT 장치의 이미지를 분석하거나, TRG 단말에 부착된 센서를 통해 통신대상의 상대위치를 추정하는 인터페이스를 제공한다.

-

• 비주얼 커넥션 프로토콜 인터페이스: 기존 단말 및 서비스 발견 프로토콜들을 확장 및 결합하는 인터페이스를 제공한다. TRG 단말은 주변 IoT 장치와의 직접통신(D2D) 또는 IoT 장치 정보를 관리하는 서버를 경유하여 See-Direct 서비스를 제공한다. IoT 장치 식별과 서비스를 지원하는 서버는 로컬 또는 원격지 서버에 위치한다.

Ⅳ. 결론

현재의 이동통신 스마트폰 단말은 화면을 터치하거나 손끝으로 드래깅함으로써 두 손을 사용하는 불편함을 갖는다. 이러한 두 손 사용의 한계를 뛰어넘는 인간의 새로운 소통방식이 없을까? 그리고 무엇을 더 해 줄 수 있을까? 에 대한 새로운 돌파구로써 터치, 드래깅 없이 사물을 단지 바라보는 상태만으로도 전화할 수 있고, 실시간 장편영화도 볼 수 있으며, 컴퓨팅 보드로도 사용할 수 있는 ‘증강현실 글라스 컴퓨팅 폰’을 통한 두 손이 자유로운 소통 방식을 본 TR과제에서 출발하고자 한다.

AT&T Foundry, "Enabling Mobile Augmented and Virtual Reality with 5G Networks," AT&T, Jan. 2017.

3GPP TR 22.864, "Feasibility Study on New Services and Markets Technology Enablers - Network Operation - Stage 1," Feb. 2016.

J. P. Pesce, D. L. Casas, G. Rauber, V. Almeida, "Privacy attacks in social media using photo tagging networks: A case study with Facebook," Proc. ACM PSOSM, 2012.

V. C. Hu et al., "Guide to attribute based access control (ABAC) definition and considerations (draft)," NIST Special Pub., vol. 800, no. 162, pp. 15-26, 2013.

Q. Liu, S. Huang, J. Opadere and T. Han, "An Edge Network Orchestrator for Mobile Augmented Reality," IEEE Infocom 2018.

K. Ha, Z. Chen, W. Hu, W. Richeter, P. Pillai and M. Satyanarayanan, "Towards Wearable Cognitive Assistance," MobiSys, June. 2014.

C.-B. Park, C. Ryu, M.-H. Yun, and J.-H. Lee, "A Wi-Fi direct access technique for smartphones using NFC," in Proc. 7th International Symposium on Embedded Technology, (ISET 2012), 2012, pp. 168-171.

T. Clifton, D. D. Joos, C. D. Knutson, and R. W. Woodings, "Rapid Heterogeneous Ad Hoc Connection Establishment: Accelerating Bluetooth Inquiry Using IrDA," 2002.

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.