휴먼 케어를 위한 초실감 감성 상호작용 기술

Affective Interaction Technologies for Human Care

- 저자

-

김진서감성상호작용연구실 kjseo@etri.re.kr 박창준CG/Vision연구실 chjpark@etri.re.kr 이기석VR/AR콘텐츠연구실 mvr_lks@etri.re.kr 김명규지능형지식콘텐츠연구실 mgkim@etri.re.kr 유원영콘텐츠인식연구실 zero2@etri.re.kr 지형근홀로그래픽콘텐츠연구실 hkjee@etri.re.kr 정일권콘텐츠연구본부 jik@etri.re.kr

- 권호

- 36권 1호 (통권 188)

- 논문구분

- ETRI 기술발전지도 2035: 신개념형상을 중심으로

- 페이지

- 43-53

- 발행일자

- 2021.02.01

- DOI

- 10.22648/ETRI.2021.J.360105

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.- 초록

- Super-realistic content technology has recently attracted attention as a core of the “new normal” that can overcome the spatial constraints caused by pandemics. It is moreover the core that allows users in remote locations to meet and engage in various social, cultural, and economic activities based on a network. Content technology is rapidly spreading beyond the existing entertainment area to various industries as an innovative tool that can be used to overcome space-time constraints and improve the productivity of industrial sites, because reality and virtual reality are now super-connected with ultra-low latency. However, existing services such as teleconferencing and tele-collaboration do not provide a level of realism that replaces face-to-face services, and various technical requirements have been proposed to overcome this. The trends in core technologies such as XR twins, hyper-realistic reproduction, sensory interaction, and emotional recognition technology, which are necessary for interactive realistic content that leads to feelings, from reproduction to experience and emotion, are explained. In this article, our aim is to present the future of realistic content that enables human care and can even overcome psychological difficulties such as the “Corona blues”.

Share

Ⅰ. 서론

최근 전 세계적으로 팬데믹이 지속되는 상황에서 디지털 트랜스포메이션(Digital Transformation)이 빠르게 가속화됨에 따라 네트워크 기반으로 실감 콘텐츠를 활용하여 사회적 문제를 극복하기 위한 다양한 서비스 모델 개발이 확산되고 있다.

실감콘텐츠 기술은 현실과 가상이 초저지연, 초연결되어 시·공간 제약 극복, 산업 현장의 생산성 향상 등에 활용 가능한 혁신 도구로 자리 잡고 있으며, 기존 VR/AR 콘텐츠의 활용도를 증가시키는 3차원 실감 표현을 가능하게 하는 볼류메트릭 비디오(Volumetric Video)와 실세계의 물리적인 객체들이 가상화되는 디지털 트윈(쌍둥이, Twin)을 기반으로 XR, IoT, AI, 5G 기술을 결합한 XR 트윈 기술 등의 적용이 증가하고 있는 추세이다. 기존에는 실감 콘텐츠가 대부분 엔터테인먼트 분야에서 활발하게 이용되어 왔으나, 디지털 전환이 빠르게 이루어지면서 문화/산업/경제적 측면에서 다양한 변화들을 이끄는 뉴노멀의 핵심기술로 주목받고 있다.

하지만, 비대면 서비스의 질적 수준은 아직까지 물리적 활동의 완전한 디지털 대체를 위한 대면 수준의 소통과 체험을 따라잡지 못하는 실정이다. 우리가 체감하고 있는 가장 대표적인 비대면 서비스로서 원격 회의를 들 수 있으며, 코로나 발생 이전에 비해 주요 원격 화상회의 이용 규모는 2020년 3월 이후 10배 이상 성장하였다고 한다. 또한, 세계적인 시장조사기관인 IDC에 따르면 원격근무 솔루션 시장의 경우에도 2018년 24억 달러(3조 원)에서 2023년 430억 달러(52조 원)로 성장이 예상되는 등의 폭발적인 성장이 이루어지고 있는 실정이다.

이러한 변화의 이면을 살펴보면 아직도 기술적으로 해결해야 하는 문제가 많이 존재하는 것을 알 수 있으며, 대부분이 실감 콘텐츠 기술 분야에서 전통적으로 고민하고 있는 핵심 주제임을 알 수 있다.

실감 콘텐츠 기반 디지털 감성 인터랙션을 활용하는 비대면 서비스의 대표적인 문제점들과 핵심기술의 발전 방향은 다음과 같다.

첫 번째로, 원격 비대면 서비스는 비언어적 정보 전달력의 부족으로 공간에 함께 존재하기만 해도 얻을 수 있는 정보의 부재로 자연스러운 공감대 형성에 필요한 비언어적 표현인 표정, 제스처, 움직임, 거리와 공간 조절, 감정 전달 등이 부족하다. 현재의 화상 기반 비대면 서비스들은 사용자를 찍는 카메라 영상과 음성 등을 제한적으로 전송하기 때문에 부족한 정보를 확보하기 위한 스트레스가 존재하며, 대면 서비스를 완전하게 대체할 수준이 되지 못하는 문제점이 존재한다. 이를 극복하기 위해 복합 구조 인식 기반 다수 사용자 인터랙션과 초실감 감성 표현을 지원하기 위한 핵심기술 개발이 필요하다.

두 번째로, 원격 사용자에게 실제와 동일한 실재감을 전달하기 위한 오감 기반 감성 상호작용에 대한 기술적 한계이다. 원격지의 사용자들을 실감 콘텐츠를 기반으로 이어주어 교감할 수 있도록 AI 기술을 통한 사람 수준의 단위 객체/비정형 장면구성 인지 기술과 이를 기반으로 하는 콘텐츠 구성요소의 관계 연관 분석을 통한 의미론적 검색 및 추론 수행 및 인간의 세분화된 미세 감정 인식을 통한 환경/상황 인지 기반 핵심기술 개발이 요구되고 있다.

세 번째로, 원격 정보의 불완전성 극복을 위한 XR 트윈 기반 초실감 재현기술의 필요성이다. IoT, 5G 기술을 연계하여 현실에 존재하는 사물에 대한 3차원 시각적·물리적 복제품을 만들어 실감 콘텐츠 기술을 통해 실제 사물을 대하듯이 다양한 활용을 가능하게 하는 기술이 요구되고 있다.

XR 트윈은 현실에서 발생할 수 있는 상황을 실가상이 융합(XR)된 환경에서 시뮬레이션하여 미리 예측하고 최적화하는 기술로서 단순히 형상만을 표현하는 것이 아니라 물리적으로 동일한 실세계 사물의 복사본을 만드는 것으로 초실감 재현을 위한 핵심기술로서 필요성이 증가하고 있다.

본 고에서는 실감 콘텐츠 기반의 XR 트윈(쌍둥이)을 활용하여 원격지에 존재하는 사용자들 간의 오감을 활용한 감성 상호작용을 가능하게 하는 기술적 발전 방향과 주요 서비스 모델을 제시하고자한다.

Ⅱ. 초실감 감성 상호작용 기술

초실감 감성 상호작용을 기반으로 한 휴먼 케어를 제공하기 위해서는 다음에서 소개하는 세 가지 쌍둥이(Twin) 구현 기술(실공간 거울 쌍둥이, 디지털 체감 쌍둥이, 디지털 감정 쌍둥이)의 개발이 필요하며[1], 다음에서 세 가지 기술에 대하여 설명하고 있다.

1. 실공간 거울 쌍둥이

내가 공간 속에서 보는 것과 동일하게 재현하는 것을 디지털 거울 쌍둥이라고 하며, 인간의 감각 중 가장 많은 정보를 습득하는 수단인 시각을 모사하여 공간의 정보를 저장하고 다시 재현해 내도록하는 기술이다. 디지털 거울 쌍둥이를 효과적으로 실현하기 위해 최소의 사진 촬영만으로도 실제 조명환경에서 사람이 보는 것과 동일한 수준으로 공간 조명을 재현하고, 사람의 외형과 표정, 움직임과 사물의 질감까지도 재현해 내야 한다.

사물의 외형을 획득하기 위해 활용되는 공간 센서들은 스마트폰과 자율주행차 등의 수요 확대를 기반으로 고해상도 RGB 센서와 함께 TOF(Time Of Flight), LiDAR(Light Detection And Ranging) 등이 빠르게 발전하고 있으며, 실시간 공간정보 획득을 통해 실감 콘텐츠화하는 기술의 고도화가 빠르게 이루어지고 있다. 원격 실내·외 공간을 3D 공간정보 획득을 통해 실감 콘텐츠화하면 사용자의 시·공간적 한계가 극복되어 네트워크를 기반으로 사용자 경험을 확장시키기 위한 실감 미러 쌍둥이 구현이 가능해진다. 이를 활용하면 내가 보고 즐기는 것을 그대로 저장한 후, 원할 때 실감 재현하여 다시 보며 즐길 수 있도록 하는 것뿐만 아니라, 원격에 존재하는 실제 사용자들을 현실감 있게 구현하고 실시간 인터랙션을 제공함으로써 현실감 있고 시각적으로도 완벽히 교감할 수 있는 콘텐츠와 서비스를 제공할 수 있다.

실공간 거울 쌍둥이는 실제 사물에 대한 시각·물리적으로 동일한 복사본을 만들기 위해 외형적으로는 3D 스캔을 통하여 확보하며, 물리적인 모델링을 위해서는 뉴턴 역학 기반의 시뮬레이션 모델을 적용하거나 빅데이터 기반의 인공지능 모델을 접목하여 생성하게 된다.

생성된 실공간 거울 쌍둥이를 제작하면 원격지 사용자가 각 원격 사물에 대해 마치 현장에 존재하는 것과 같이 물리적 상호작용을 가능하게 하는 기반이 마련되며, 다양한 산업 분야에서 실감 콘텐츠 활용을 가능하게 한다.

구체적인 기술로는 단위 객체 외형, 재질 및 질감 정보 획득 및 초실감 재현, 인체에 대한 고정밀 외형, 표정, 움직임 획득 및 디지털 휴먼 재현, 공간 조명에 대한 획득과 재현 및 실시간 렌더링 기술 등이 있다.

사람이 등장하고 실감 영상을 필요로 하는 영화, 게임, VR/AR/MR, 관광, 광고 등 대부분의 디지털콘텐츠 분야에 필요한 기술이며, 디지털콘텐츠 분야의 미래인 감정 케어에서도 시각적인 부분을 담당하는 중요한 기술이다.

2. 디지털 체감 쌍둥이

최근 가상 현실 기술은 발전을 거듭하여 실재감과 몰입감을 느낄 수 있는 방향으로 진행되고 있다. 또한, 다양한 분산 센서들을 연결하여 많은 정보를 취득하고 지능적으로 처리하여 사용자에게 복합 감각을 제공하는 기술들이 적극적으로 활용되고 있다. 여기에는 직접 만져보고 느껴볼 수 있는 기술을 포함하고 있으며, 물리적으로 같은 공간뿐 아니라 멀리 떨어진 원격지에서도 같은 감각을 공유하고 체감할 수 있어야 한다.

이러한 초실감 가상 현실을 가능하게 하는 것 중 하나는 실감 상호작용 기술이다. 실감 상호작용 기술은 시·청각 외에도 촉각과 경험을 포함하는 다중 감각을 공유하는 기술로서 컨트롤러나 버튼 없이 사용자의 움직임이 그대로 컴퓨터와 상호작용하는 수단이 되고, 청각을 통해 소리의 공간감과 입체감을 느낄 수 있으며, 압력, 온도, 진동, 질감과 같은 촉각을 느낄 수 있는 실감체험 기술로 발전해 나갈 전망이다.

구체적인 기술로는 실내·외 복합 구조 공간에 대한 정밀 트윈 생성을 통해 물리적 세계와 디지털 플랫폼 간의 완벽한 실시간 양방향 통합 및 대규모 연결을 지원하는 기술, 컨트롤러 등 제한된 인터페이스 기기를 탈피하여 음성, 동작, 표정, 터치, 텍스트 등 인간 친화적인 다차원 입력 인식 기술, 체감적 감각(시·청·촉각)을 제공하기 위해 주변 환경·외부 정보를 센싱/가공/분석/저장하여 처리하는 스마트 인터랙션 및 인터랙션 동기화 지원 다자간 체감 인터랙션 기술, 영상 콘텐츠 내 단위 객체 자동 구분 및 식별을 통해 대상 객체 요소들의 속성/상태를 유지하며 어떻게 작동하는지 성질을 묘사하는 기술 등이 있다.

디지털 체감 쌍둥이 기술은 가상세계에서 초실감 상호작용을 대표하는 개념으로 떠오르고 있으며, 게임, 엔터테인먼트 분야 외에도 스마트 제조, 헬스케어, 의료, 재활, 스마트시티, 국방 등으로 대중화와 활용 확장성이 보편화되면서 인간-기기 간 상호작용 기술이 점차 진화할 전망이다.

3. 디지털 감정 쌍둥이

기술의 발전으로 사회가 고도화되고 규모가 커짐에 따라 개인의 휴식과 치유를 위한 환경이나 시간이 상대적으로 줄어들고 있으며, 이로 인한 스트레스를 해소하기 위해 힐링의 시간이 절실해지고 있다.

디지털 감정 쌍둥이는 앞서 설명한 디지털 체감 쌍둥이 기술에 후각과 미각을 포함한 오감 상호작용 기술과 감성 인지 기술을 더해 휴먼 케어와 치유가 가능한 휴먼 트윈을 의미한다.

구체적인 기술로는 인간의 외형과 내부를 동일하게 모사하고 재현하는 휴먼트윈 생성 기술, 시·청·촉각에 후각과 미각을 포함하는 오감 재현 기술, 극사실적 디지털 체감을 위한 휴먼 트윈에 사람의 사상이나 생각을 투영하기 위한 서술형 의미론적 인지 분석 기술로 구성된다.

오감 재현 기술은 고감도 나노센서 기술을 기반으로 인간의 후각이 인식하는 수준과 유사한 수준으로 냄새를 인식하며, 단맛, 짠맛, 쓴맛, 신맛, 감칠맛을 구분하고, 맛의 세기를 디지털로 부호화하여 전송하고 원격에서 맛을 재현하는 기술개발을 포함한다.

서술형 의미론적 인지 분석 기술은 사람과의 감정 교류를 위해 사용자가 처한 상황, 환경, 감성적 요소를 분석/인식하고, 사용자에게 마치 사람과 대화하듯이 서비스를 제공하는 에이전트 그리고 대화 과정에서 감성적인 교감을 이끌어 내고 대화를 이끌어가기 위한 교감형 커뮤니케이션 기술을 포함한다.

Ⅲ. 기술별 동향

이 장에서는 휴먼 케어를 실현하기 위해 필요한 세 가지 기술의 국내·외 동향에 대하여 살펴보기로 한다.

1. 실공간 거울 쌍둥이

실공간 거울 쌍둥이를 구현하기 위해서는 공간 획득을 통한 가상공간 구성 및 디지털 휴먼 구성 및 실시간 사용자 인터랙션 기술 등의 핵심기술이 필요하다.

국내 공간지도 업체 티랩스는 수집한 공간 정보를 인공지능 서버에 입력하면 자동으로 3D 공간을 스캔하는 자율주행 로봇인 ‘티스캐너(TeeScanner)’를 출시하였다. 티스캐너는 성인이 걷는 속도보다 빠른 속도로 주행할 수 있으며, 약 5,000m2 (1,500평) 정도의 건물 한 층은 1~2시간 촬영으로 공간 전체를 입력할 수 있다.

위지윅스튜디오는 2019년 6월에 SK텔레콤과 협력하여 가상증강현실 개발 플랫폼인 T real을 이용해 롯데월드에서 일어나는 불꽃놀이와 같은 이벤트들을 가상공간에서 친구들과 만나 즐길 수 있는 국내 최초의 소셜 VR 서비스를 개발하였다.

SK텔레콤은 2019년 3월에 5G 기술을 사용하여 프로야구 개막전에 증강현실 기술을 접목하여 SK 와이번스의 상징 비룡을 실제 경기 중인 경기장에 합성하여 스마트폰 앱, TV 등을 통해 볼 수 있는 서비스를 개발하였다.

한국전자통신연구원은 그림 1과 같이 실내·외 공간에서 사용 가능한 단일 카메라 기반 모바일 증강현실 엔진을 개발하여 중국 북경 751 D-Park에서 실공간 기반 증강현실 기술을 시범 서비스하였다[2].

미국 트림블(Trimble) 사는 softGNSS 수신기와 Google ARCore 기술 접목하여 도면이나 지도를 분석할 필요 없는 고정밀 AR 시스템 ‘사이트 비전’을 제작하였다. AR 기반 ‘사이트 비전’을 장착한 스마트폰을 통해 3D 공간 설계도와 시·공 정보 등을 증강현실로 제공한다.

실공간 거울 쌍둥이 핵심 기술 중 디지털 휴먼 외형 재현에 대한 기술 동향은 다음과 같다.

최근, 사실적인 디지털 휴먼의 표정, 자세, 움직임 생성과 재현에 관한 연구가 활발히 진행되고 있다. 사실적인 디지털 휴먼의 자세와 동작 표현을 위한 조명 제어와 관련하여 구글 연구소에서는 다양한 조명 환경하에서 자연스러운 사람의 움직임을 캡처하는 시스템을 개발하였다[3]. 실시간으로 조명 환경을 재현하고 사실감도 매우 뛰어나다.

UC San Diego 대학에서는 인물 사진을 조명 변화에 따라 자연스럽게 바꾸는 연구를 수행하였다[4]. 실제 야외에서 시간 흐름에 따라 사진을 촬영하여 얻은 결과와 같은 효과를 사실적으로 만들어 내었다.

독일 Max Planck 연구소에서는 미리 학습한 범위 내에서 객체의 스타일을 변형하는 연구를 진행하였으며, 3D 스캔된 의상 착용 데이터를 학습하여 바디 형태와 의상 정보를 복원 스타일로 전이시킴으로써 디지털 휴먼에 3D 스캔된 의상을 용이하게 착용시킬 수 있도록 하였다[5]. 디지털휴먼에 착용할 의상을 손쉽게 만들 수 있을 뿐만 아니라, 여러 디지털휴먼에 착용된 결과를 자연스럽게 재현함으로써 디지털휴먼의 실제 활용 가능성을 크게 높일 수 있도록 하였다.

프레임마다 사실적인 디지털 휴먼 형상과 포즈 영상 및 표정을 생성하는 연구도 활발히 진행 중이다. 대표적인 예로써, 워싱턴대학에서는 음성에 맞춰 입모양을 포함한 얼굴의 움직임을 GAN 기술로 자동 생성하는 연구를 진행하였다[6]. 미국 오바마 전 대통령의 사진을 활용하여 학습하고, 음성에 맞춰 말하는 모습들을 정확히 재현함으로써 실제와 같은 모습을 가상으로 정확히 만들어 낼 수 있도록 하였다.

또한, 실시간 반응형 인공지능 캐릭터를 생성하고 나이를 바꿔 새로운 캐릭터를 생성하는 연구도 진행되었다[7]. 촬영 현장에서 연기를 하는 배우의 얼굴을 캡처하여 얻은 움직임 데이터와 배우가 과거에 연기했던 장면들을 학습하여 얻은 텍스처링 정보를 합성함으로써 젊은 날에 연기를 하는 배우의 모습을 재현해 낸 영화 ‘아이리시맨’의 디에이징 기술이 대표적이다.

산업계에서도 디지털 휴먼을 생성하고 응용으로 활용하기 위한 연구를 활발히 진행시키고 있다. 핀스크린은 모바일 기기에서 사용자의 얼굴 사진을 인공지능으로 인식하여 사용자의 개인화된 3D 아바타를 생성하고, 표정 애니메이션, 바디 애니메이션을 수행하는 기술을 발표하였다[8].

삼성은 Core R3(Reality, Realtime, Responsive) 엔진을 이용하여 사람과 대화 가능한 가상의 2D 영상 생성기반의 인공인간 네온(Neon)을 발표하였다[9]. 실제 사람과 구분하기 힘들 정도의 고품질로 인공인간의 외형을 재현하였다.

대학과 연구소뿐만 아니라 산업계에서도 디지털 휴먼 생성과 재현을 위한 기술을 개발하고 활용하는 사례가 점점 늘어나는 추세이며, 머지않아 우리 생활 가운데에 여러 형태의 제품으로 접하게 될 것으로 전망된다.

2. 디지털 체감 쌍둥이

디지털 체감 쌍둥이 핵심 기술 중 오감(시·청·촉·후·미각) 인터랙션 기술 동향은 다음과 같다.

테슬라수트(TeslaSuit)에서는 외골격계를 갖추어 포스피드백 전달이 가능하고 손끝의 3×3 디스플레이 장착으로 질감표현이 가능한 글러브를 개발하였다[10].

싱가포르국립대학(NUS) 연구팀은 인텔 뉴로모픽 칩을 활용하여 감각기능이 인간 신경계보다 1,000배 빠른 ‘전자피부’를 개발하였다. 전자피부는 물체 모양, 질감, 경도 등도 식별할 수 있고 내구성도 강해 센서 하나로도 물체 감지가 가능하다[11].

MIT의 컴퓨터 과학 및 인공지능 연구소(CSAIL)에서 만든 사람처럼 시각과 촉각을 사용해 물체를 집어 드는 2종의 로봇 집게손(그리퍼)을 개발하였다. 또한 소프트 로봇에 활용할 수 있는 감각 기능을 갖춘 로봇 피부(소프트 센서)를 개발하였다. 로봇 피부를 통하여 소프트 로봇이 자신의 동작과 위치를 3D 환경에서 인식할 수 있다[12].

한국과학기술원 안드리아 비앙키 교수팀은 VR 속 가상 물체의 강성을 인지할 수 있는 VR 컨트롤러 ‘엘라스틱(ElaStick)’을 개발 인간-컴퓨터 상호작용 분야 최우수 국제학술대회 ‘ACM UIST 2020’에서 최우수논문상을 수상했다. 엘라스틱은 기존 VR 컨트롤러와 달리 사용자가 가상 물체를 쥐고 휘두를 때 발생하는 진동이나 갑작스럽게 움직임을 멈출 때 생기는 반동 표현이 가능하다[13].

ETRI는 그림 2와 같이 주위 소리와 자신 목소리의 음높이를 분석해 촉각 패턴으로 변환해 주는 ‘촉각 피치 시스템’을 개발하였다[14].

한국과학기술원은 가상·증강현실 촉각 기술에 활용 가능한 세라믹 소재를 개발했다. 3D 나노 구조체를 이용, 탄성 변형률을 3배로 향상시킨 압전 세라믹 소재로, 압전 재료는 전기 에너지를 기계 에너지로 변환하거나 기계 에너지를 전기 에너지로 변환할 수 있다. 촉각 증강 분야에서 사용자에게 촉각을 전달하거나 사용자의 움직임을 전기적 신호로 변형시키는 데 적합한 소재다.

촉각 증강 기술은 로봇 기술뿐 아니라 햅틱 디스플레이와 햅틱 장갑 등 촉각을 이용한 정보 전달 기술에 활용할 수 있다[15].

Facebook 리얼리티랩스(Reality Labs)는 주변 소음은 줄이고 듣고 싶은 소리는 키워주는 증강현실(AR) 글래스 시제품을 선보였다. AR글래스에 장착된 헤드폰과 마이크를 통해 주변의 소리를 들려주고, 착용자 머리와 눈 움직임을 추적해 듣고자 하는 대상의 소리를 감지하여 증폭해 준다[16].

서울대에서는 냉·열감 구현이 가능한 소프트 웨어러블 열적 햅틱(thermo-haptic) 소자를 만들어 신체에 부착 가능한 스트레쳐블 소재를 세계 최초로 개발했다. 가상현실에서 사용자가 가상 물체를 만지면 펠티어(Peltier) 원리를 이용해 사용자 손 피부의 온도를 물체 온도와 상응하게 바꿔줄 수 있도록 한다[17].

풀다이브 테크놀로지는 유사 촉감을 느낄 수 있는 VR, AR 글러브를 개발하여 부피감, 경도감, 통감, 손가락 관절의 반력감에 모두 전달할 수 있다[18].

Facebook 리얼리티랩스(Reality Labs)는 팔에 장착하는 촉각 피드백 장치 타스비(Tasbi)를 개발, VR/AR 환경에서 물건을 집거나 얼굴을 만지는 것과 같은 동작을 할 때 느낌을 재현하였다. 팔에 장착하면 진동에 의해 손끝으로 만지는 것과 같은 감각을 제공한다[19].

미국 노스트웨스턴대는 가상현실에서 실감나는 촉각 체험을 위해 피부 곳곳에 부착한 액추에이터를 통해 다양한 진동을 전달하는 VR 스킨을 개발하였다[20].

햅트엑스(HaptX)는 압력과 저항감을 느끼도록 하는 VR 햅틱 장갑을 개발, 밀리미터 이하의 정밀도로 힘 패드백과 동작 추적 기능을 제공한다.

공기 작동식 액추에이터 기반으로 미세 유체 기술을 통해 미세 기포가 장갑 내부에 물체 모양을 만들어 사용자에게 피드백을 제공하는 방식이다[21].

비햅틱스는 약 70개의 모터가 256단계까지 진동단계를 제공함으로써 진동으로 타격과 피격감 재현하는 무선 전신 햅틱수트 ‘TactSuit’를 개발하였다[22].

한국 테그웨이는 VR/AR 환경에서 사용자가 고온, 저온, 고통을 실시간을 느낄 수 있도록 하는 온도 촉각(햅틱)장치 ‘ThermoReal’을 개발하였다[23].

프랑스 CLARTE에서는 사람 대 사람 실감 상호작용을 위해 Real Human Body를 Segmentation하고 가상환경에 실시간 출력하는 연구결과를 발표하였다. 영상전송 시간을 제외하고, 비디오에서 User Segmentation 후 가상공간에 출력하는 데까지 720ms에서 Optimization을 통해 15ms까지 단축했다[24].

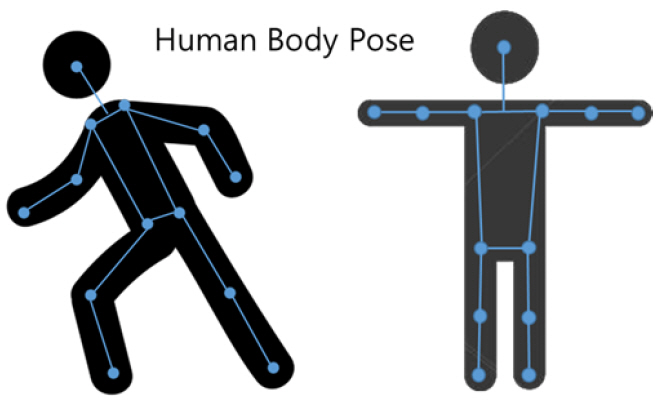

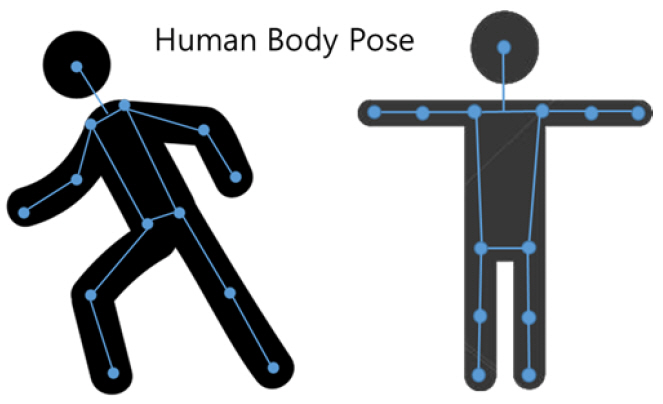

미국의 애플은 ARkit4에서 싱글 카메라와 LiDAR 센서를 이용하여 공간 구축과 사용자의 몸과 손 자세 추정 API를 제공하고 있다(그림 3 참조). 사용자 자세 추정과 공간인식을 통하여 가상객체와 다양한 인터랙션 가능성을 제공한다[25].

미국의 울트라립은 자사 제품인 Leap Motion과 Ultrahaptics STRATOS를 통하여 비접촉식 인터페이스 환경(10~60cm 환경 뎁스맵)의 초음파를 이용한 포스피드백(70cm 공간)을 제공한다[26].

미국의 Natural Point 사는 OptiTrack 카메라를 통하여 단일 OptiTrack 시스템에서 9m × 9m 넓이의 공간에서 정밀한 모션 캡처를 제공하며, 영화의 CG, 게임 및 애니메이션 등 다양한 범위에 사용된다[27].

전통적인 HCI 분야인 햅틱 인터페이스 기술은 보다 정밀한 촉각 인터페이스를 구현하여 사람의 피부로 느끼는 감각과 동일한 감각을 느낄 수 있는 센서 기술(초음파 햅틱, 냉열감 햅틱, 전자 피부 등)로 발전하고 있으며, 현실과 가상을 연결하는 대표적인 기술로서 비대면 시대에 적합한 원격교육, 원격진료, 홈트레이닝, 홈케어 등 산업 전 분야에 걸쳐 응용 기술과 제품이 출시되어 활용될 것으로 전망된다.

3. 디지털 감정 쌍둥이

사용자가 처한 환경이나 상황을 인지하고, 사용자와 감성적 교류를 위해 얼굴과 표정을 인식하고, 내재된 감성 상태를 추정하며 안경이나 헤어스타일, 표정과 같은 인식환경의 가변성을 반영하여 심리 상태를 해석하는 기술은 다양한 분야에서 활용되고 있다.

Affectiva사의 ‘Emotion Tracking AI’에서는 차량 탑승자의 복잡하고 미묘한 감정 및 인지 상태를 얼굴과 목소리를 통해 실시간으로 식별하는 기술은 운전자의 감정 상태와 졸음 상태를 판단하여 안전운전을 유도하는 데 이용되며, 사용자와 상호작용 시 얼굴의 감정표현이 가능한 아바타를 생성하는 기술은 인공지능 아나운서, 상담원, 영화나 캐릭터 제작 등의 분야에 다양하게 활용된다.

온라인 문서나 SNS 등의 비정형 빅데이터에서 감성을 분석하여 긍정/부정을 분석하는 기술은 제품을 출시한 기업의 고객 반응 모니터링에 활용되고 있고, 텍스트뿐만 아니라 이미지, 음성을 복합적으로 이용하여 감성을 인식하는 기술은 사용자와 다양한 상호작용이 가능하도록 로봇에 적용되고 있다.

인간을 대신하여 사용자와 상호작용하는 지능형 에이전트 기술은 금융, 법률, 의료, 유통 등 다양한 분야에서 기술 개발과 상용화된 서비스가 진행되고 있으며, 특히 고객 상담이 많은 분야에서 기술 도입이 빠르게 진행되고 있다.

USC의 심리상담 시뮬레이터(SimSensei)에서는 가상의 의사가 환자의 얼굴 표정을 통해 감정 상태를 추출하고 음성을 통해 심리 상태를 파악하여 환자와 대화를 나누거나 상담하는 기술을 개발하였고, 마인즈랩은 다양한 유형의 인공지능 기반 질의응답 기술을 개발하여 금융권을 위한 맞춤형 챗봇 솔루션을 개발하였으며, 조이코퍼레이션에서는 온라인 쇼핑몰용 마케팅 챗봇을 개발하여 자주 구매하는 제품을 먼저 추천하거나 장바구니에 물건만 담아둔 고객에게 적립금이나 쿠폰 등의 혜택 정보를 알려주고 있다.

사용자의 나이, 성별, 감정을 인식하고 주어진 상황을 인지하여 사람과의 대화의 흐름을 이끌어가는 대화 중심의 인간-로봇 커뮤니케이션 기술이 개발되고 있다.

IBM에서는 가상현실에서 사람과 직접 대화할 수 있는 지능형 인공지능 ‘빈센트’를 개발하였고, 삼성전자에서는 인간을 똑같이 닮은 아바타 형태를 가지고 사용자와의 소통을 통해 상대방의 특징을 스스로 배우고 진화할 수 있는 인공인간 네온(Neon)을 공개하였으며, 대만의 페이스미(FaceMe)에서는 사용자와 자연스러운 대화를 제공하는 온라인 예약 서비스용 디지털 휴먼 제노(Zeno)를 개발하였다.

인간의 감각을 모사 재현하거나 자극함으로써 보다 사실적이고 몰입감을 제공하는 디지털 콘텐츠 기술은 그간 시각, 청각, 촉각을 중심으로 계속 발전해왔다. 최근에는 고감도 후각 센서 기술의 발전에 따라 후각 정보의 센싱, 분석, 부호화, 전송을 통해 질병을 조기에 스크리닝하는 전자코(Electronic Nose) 기술과 향의 정보를 분석하여 실제와 유사한 냄새를 맡을 수 있게 해 주는 장치인 발향장치 기술이 출현하고 있다[28].

또한, 향기를 맡는 감각기관인 후각과 밀접하게 연관되어 맛을 느끼는 미각 기술을 활용한 미각 기반의 식생활 건강관리, VR 원격 요리 교육, 디지털 음식 레시피 등 새로운 형태의 감각 활용 응용 서비스에 대한 기술적 관심도 증가하고 있다.

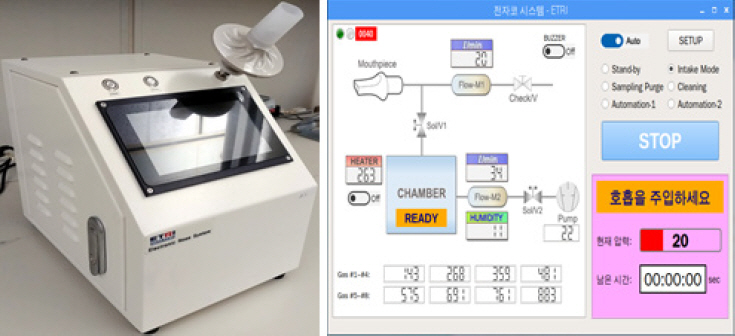

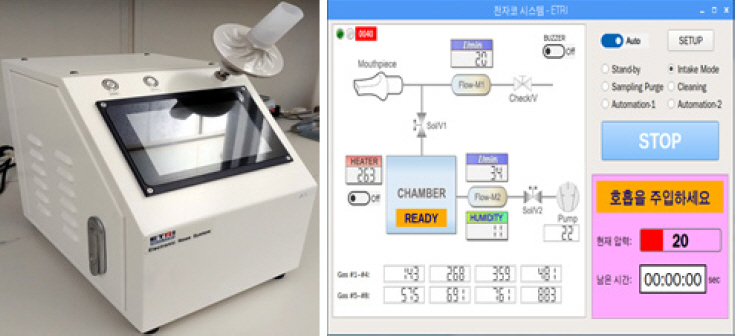

먼저, 인간의 생물학적 코의 개념을 인공적으로 모방한 전자코는 내뱉는 숨 또는 공기 중의 휘발성 유기화합물을 획득, 분석, 처리하는데, 최근 국내 한국전자통신연구원은 호흡에서 나오는 질병(당뇨)을 호기 바이오마커(아세톤) 정보로 빠르게 스크리닝하는 전자코를 통해 손쉽게 질병을 자가 검진할 수 있는 예방중심의 휴먼케어 환경 제공을 추진하고 있다(그림 4 참조).

다음으로, 발향장치(Scent Display) 기술은 향기로 후각을 자극함으로써 인터넷과 게임을 즐기면서 향을 맡을 수 있고, 방송, 영화 등을 감상하면서 장면에 맞는 향기를 맡을 수 있어, 몰입감과 사실감 있는 콘텐츠 체험이 가능하다.

최근에는 특정 냄새를 인지하지 못하거나 구분하지 못하는 후각 장애가 치매의 전조 증상임이 의학적으로 규명되면서, 그림 5와 같이 발향장치 기술을 이용하여 후각의 역치, 식별, 인식, 재연 측정 정보를 통해 치매를 선별하는 기술이 개발되고 있다[29].

이와 함께, 미각 기술은 크게 인간의 미각 지각 메커니즘을 모사하여 맛을 인식, 식별, 양자화하여 화학물질에 반응하는 전자혀(Electronic Tongue)와 VR, AR 기술에 맛을 단순히 오브젝트로 표현하는 수준의 미각 콘텐츠로 분류된다. 전자혀 기술은 단맛, 쓴맛, 신맛, 짠맛, 감칠맛 등의 맛을 측정하는 일본 Insent사의 TS-5000Z[30]와 프랑스 Alpha MOS사의 Astree[31] 제품이 출시되고 있다. 아직 전 세계적으로 개념 정립 단계인 미각 콘텐츠는 VR/AR 콘텐츠 융합하여 콘텐츠로 표현하기 위해 필요한 미각 대상 영상 객체, 미각 속성, 미각 정보 시계열 변화(예: 숙성, 발효) 등 맛 정보의 부호화 연구가 미진하여 아직은 제품화가 더딘 상태이다.

일본 메이지대학은 전기신호를 통해 뇌가 맛을 느끼도록 하는 ‘virtual taster’인 ‘노리마키 신시사이저’를 개발하였다. 용해성 전해질로 만든 5종류의 젤 덩어리에 전기적 신호를 가해 전하에 의해 활성화된 미세입자의 이동을 사용해 다양한 맛의 조합을 제공할 수 있다[32].

딥러닝을 기반으로 한 인공지능의 발전과 함께 인간의 동작이나 표정을 인식하는 기술을 넘어서 환경과 상황에 대한 인식을 통해 인간이 느끼는 감정을 인식하고 인간처럼 소통하는 기술로의 연구 개발이 활발하게 진행되고 있으며, 후각과 미각을 사실적으로 재현함으로써 진정한 디지털 쌍둥이를 실현하는 기술과 제품이 근 미래에 출현할 것으로 전망된다.

Ⅳ. 결론

본 고에서는 인간의 오감 및 감정 상호작용을 통하여 시·공간을 초월한 정서적 소통과 감정 치유를 제공하기 위한 초실감 감성 상호작용 기술의 세 가지 요소 기술인 실공간 거울 쌍둥이 기술, 디지털 체감 쌍둥이 기술, 디지털 감정 쌍둥이 기술에 대한 설명과 관련 국내·외 기술 동향을 소개하였다.

실공간 거울 쌍둥이 기술은 소규모 실제 공간을 가상화하고 나를 포함한 주변 사람들, 애완동물까지도 가상의 3차원 공간 내 완벽히 재현해내는 기술이다. 2024년경에는 실제 공간에 대해 실측 정보까지 포함하는 완벽한 3차원 실시간 취득과 재현이 가능해지고, 부가장비 없이도 영상만으로도 공간의 조명과 물체들의 재질 정보까지도 획득하고 인간 눈과 동일한 수준의 Dynamic Range로 재현해내는 수준으로 발전될 것으로 전망된다. 또한, 나와 구분이 안 될 정도의 나와 똑같은 디지털 휴먼 외형 뿐만 아니라 행동까지도 구분하기 힘들 정도로 만들고 재현하는 수준까지 발전할 것으로 전망된다.

디지털 체감 쌍둥이 기술은 감성 케어 서비스를 위한 핵심 요소 기술 중의 하나로, 접촉식 햅틱 장치를 제공하는 감각 인터페이싱 기술을 의미한다. 이를 세계적 수준으로 개발하여 영상 및 VR 기술과 연동된 서비스를 지속해서 개발한다면 중국/동남아를 시작으로 세계 시장 진출이 가능하다. 이와 같은 디지털 체감 쌍둥이 개발은 감성 케어 서비스를 위한 기술 도약의 시발점이 될 것으로 전망한다.

디지털 감정 쌍둥이 기술은 인간이 느끼는 오감과 동일한 느낌을 재현하는 극사실적 디지털 휴먼 트윈에 인간이 사물을 인식하는 것과 동일한 수준의 인식능력을 구현하고, 이를 통해 원격지에 계신 부모님, 친구들과 입체적인 통신을 하면서 실감 교류를 할 수 있고, 과거 추억의 사람, 애완동물까지도 완벽한 거울 쌍둥이로 저장해 두었다가 언제든 실감나게 재현하며 추억을 떠올리며 감정을 치유 받고 회복하는 시간을 누릴 수 있을 것으로 기대된다.

약어 정리

이헌주 외, “실세계 연계 실감형 e-레저 콘텐츠 서비스 기술 개발,” 2연차보고서, 2017, https://data.doi.or.kr/10.23000/TRKO201700005025

K. Guo et al., "The relightables: Volumetric performance capture of humans with realistic relighting," ACM Trans. Graphics, vol. 38, no. 6, 2019, doi: 10.1145/3355089.3356571

T. Sun et al., "Single image portrait relighting," ACM Trans. Graphics, vol. 38, no. 6, 2019, doi: 10.1145/3306346.3323008

B. Bhatnagar et al., "Multi-garment net: Learning to dress 3D people from images" in Proc. IEEE/CVF Int. Conf. Comput. Vis. Seoul, Rep. of Korea, 2020, doi: 10.1109/ICCV.2019.00552.

S. Suwajanakorn, S.M. Seitz, and I. Kemelmacher-Shlizerman, "Synthesizing obama: Learning lip sync from audio," ACM Trans. Graphics, vol. 36, no. 4, 2017, doi:10.1145/3072959.3073640

J. Light, "Here's how ILM de-aged 'The irishman' cast," No Film School, Dec. 4, 2019, https://nofilmschool.com/the-irishmande-aging-behind-the-scenes

D. Mikhalchuk, "TESLASUIT introduces its brand-new VRgloves," TESLASUIT, Dec. 27, 2019, https://teslasuit.io/blog/teslasuit-introduces-its-brand-new-vr-gloves/

E. Pezent et al., "Explorations of wrist haptic feedback for AR/VR interactions with tasbi," in Proc. Extended Abstract CHI Conf. Hum. Factor Comput. Syst. Honolulu, HI, USA, Apr. 2020, doi: 10.1145/3334480.3383151.

X. Yu et al., "Skin-integrated wireless haptic interfaces for virtual and augmented reality," Nature vol. 575, 2019, pp. 473-479.

P.-O. Pigny and L. Dominjon,"Using CNNs for users segmentation In video see-through augmented virtuality," in Proc. IEEE Int. Conf. Artif. Intell. Virtual Reality. Sandiego, CA, USA, Dec. 2019, pp. 229-234.

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.