손진희 (Son J.H.)

박혜숙 (Park H.S.)

이소연 (Lee S.Y.)

박상준 (Park S.J.)

이용태 (Lee Y.T.)

Ⅰ. 서론

군 비전 2050에 따르면 미래 지상군은 합동군의 일부로서 전 영역작전을 수행할 것이며, 이 중 지상군이 중심이 되어 수행하는 多영역전투(Multi-Domain Battles)의 핵심은 4차 산업혁명의 주요기술(AICBM1))을 덧입은 대대전투단이 될 것이다. 대대전투단이 임무를 수행할 미래 전장 환경은 작전지역이 확대될 것이며, 이로 인해 상대해야 할 적의 위협도 증가될 것이다. 이에 미래 전장 환경에서 대대전투단은 소부대 단위로 분산되어 동시다발적인 비선형 근접전투 수행이 불가피할 것이다2).

일반적으로 대대급 지휘관의 “실시간 전투지휘”는 METT+TC3)를 고려한 1) 정보수집 및 상황 인지 기능4)을 고려한 2) 지휘결심, 그리고 3) 대응의 3단계로 이루어진다. 따라서 상급, 인접 및 예하 부대와 전장에서 제공·획득한 전장·전투정보(METT+TC, 6대 전투수행기능)가 전투실시간 가시화(전장가시화)되어야 한다. 동시에 가시화된 전장·전투정보를 기반으로 최적의 방책이 전투실시간 제공되어 “先見→先決 →先打의 템포 가속화”로 전투력 극대화(전투효율성)를 통한 지휘관의 “실시간 전투지휘”를 보장해야 한다.

이에 따라, 지휘관의 실시간 전투지휘를 지원하는 인공지능 핵심 기술을 확보하려는 움직임이 국내·외에서 활발히 이뤄지고 있으며, 국방부는 또 4차 산업혁명 기술을 기반으로 한 ‘스마트 국방 혁신 강군’이라는 비전을 설정하고 국방운영·기술기반 혁신과 전력체계 혁신을 추진하여 실시간으로 투명하고 합리적인 국방정책을 추진할 수 있는 환경 조성을 목표로 하고 있다. 국방 AI 기술은 전 세계적으로 기초연구단계 수준이고, 국내 과제는 전무하며, 군사작전 데이터와 지휘통제/결심정보는 군 기밀사항으로 우리 군에 특화된 독자적인 기술 확보가 필요하다.

육군의 경우 고령화 및 인구감소로 지속적인 군 자원 감소로 전투상황인식 관리 대상만 50여만 Unit인 복잡해지는 미래 전장에서 지휘관 개인의 경험과 전문성에 의존한 지휘결심은 한계가 있으며, 최적의 신속 대응이 어렵고 무기체계의 고도화 및 복잡도 증가로 미래전장(Battlefield)에서는 지휘관 개인의 경험과 전문성에 의존한 지휘결심체계에 한계가 있고, 최적의 신속 대응이 어려우며, ArmyTiger4.0, 드론봇 전투체계 등 미래 유·무인 체계에 대응하기 위해 연구개발은 시급한 실정이다.

본 고에서는 지휘관들의 의사결정지원을 위한 AI 軍 참모 기술에 대한 연구동향을 기술하고자 하며, 상세하게는 AI 軍 참모 기술을 구성하는 핵심 기술 분야별로 세분화하여 살펴보고자 한다.

Ⅱ. AI 군 참모

1. 기술개요

지능형 지휘통제체계는 지휘관의 의사결정과 전장관리를 지원하는 핵심전력체계로 전장 인식, 지휘통제, 전력 운용을 위해 지휘소의 정보처리 및 의사결정을 지원하는 자동화 체계로서 다양한 감시·정찰 자산으로부터 적시 적절한 의사결정과 전장관리를 지원함으로써 합참, 작전사령부, 군단, 사단 등 지휘관의 작전지휘를 지원한다.

현재 수집된 전장 정보를 실시간 분석하여 적의 위협을 평가하고, 최적의 방어·공격 수단을 결정하여 명령을 하달·공유하는 무기체계로 전장상황인식을 위하여 네트워크 기반의 신속·정확한 정보의 수집, 처리, 전파 및 지식관리체계 구축과 의사결정자에게 작전환경에 대한 체계적 지식을 제공함으로써 전장을 가시화하고, 전장상황을 공유하고, 다차원 공간에서의 다양한 무인체계까지 연동되는 다차원 동시·통합전 수행을 위한 지휘통제 기능을 제공한다.

국내는 부대구조별 합동지휘통제체계(KJCCS: Korean Joint Command and Control System), 지상지휘통제체계(ATCIS: Amry Tactical Command Infomation System), 해상지휘통제체계(KNCCS: Korea Naval Command Control System), 공중지휘통제체계(AFCCS: Air Force Command and Control System) 등으로 분류되며, AI 軍 참모 기술은 이와 같은 지능형 지휘통제체계의 핵심 코어 기술로써 전장상황에서 수집되는 다양한 정보를 분석·요약하고 대응방책을 제공함으로써 지휘관이 올바른 상황인식을 통한 적시적인 전투지휘 및 결심을 할 수 있도록 지원하는 인공지능 기술이다.

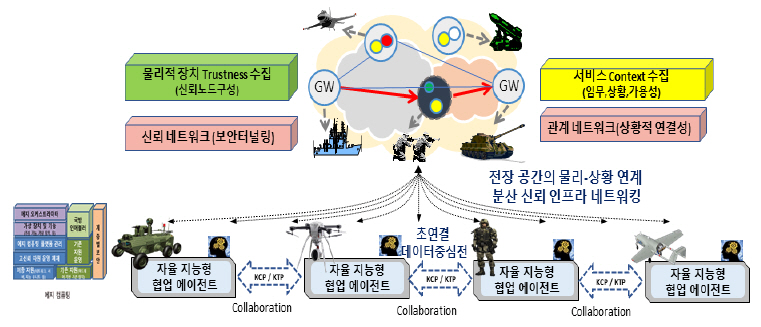

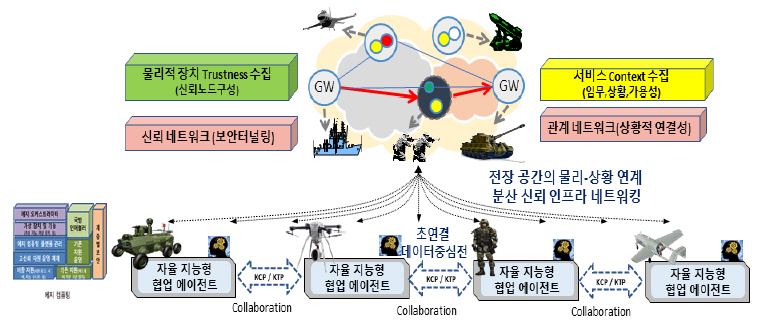

AI 軍 참모 기술은 전투력을 극대화하고 전투병과 무기체계들의 생존성을 향상시켜 전투에서 반드시 승리할 수 있는 인공지능 기반 작전지휘통제체계를 확보하는 목표 아래 1) 지휘관이 실시간으로 전장상황을 인식할 수 있도록 전장에 투입된 전투원, 무기체계, 센서 및 네트워크로부터 영상, 음성, 위치 정보 등 비정형 다양한 데이터들로부터 지식을 추출하는 열악한 환경에 강인한 전술맵 생성 기술, 2) 실시간 전투상황에서 수집된 정보를 바탕으로 단위 지식들 간의 상관관계 매핑을 통한 설명 가능한 다중 가설 생성 및 상황 인지 기술, 3) 실시간 전투상황에서 수집된 정보를 바탕으로 강화학습 기반의 시뮬레이션(M&S: Modeling and Simulation)을 통해 실시간 대안 도출 및 판단 근거를 제공하는 작전지휘 의사결정 방책 추천 기술, 4) 전장 공간의 물리-상황 연계 분산 신뢰 인프라 네트워킹 기술을 통해 지휘본부와 작전지역과의 실시간 정보 전달을 가능하게 하는 임무 관계 중심의 신뢰 에지 네트워킹 기술로 구성된다.

2. 형상발전 방향

1단계 목표인 AI 전장 분석관은 전장의 극한·열악한 환경에서 전투자원에 부착된 다양한 웨어러블 센서로부터 정보를 수집하고 교전상황을 실시간 분석·예측하여 지휘관의 의사결정을 지원해 주는 기술이다.

2단계 목표인 AI 대항군은 원격에서 수행되는 소규모 지역 전투상황의 맥락과 전장의 변화를 실시간으로 예측하는 AI 지휘관이 자율적 의사결정을 통해 무인 병기와 인간 병사를 지휘하여 교전(시뮬레이션)하고 실행에 옮긴 전술에 대한 근거를 인간 지휘관에게 실시간으로 보고하는 기술이다.

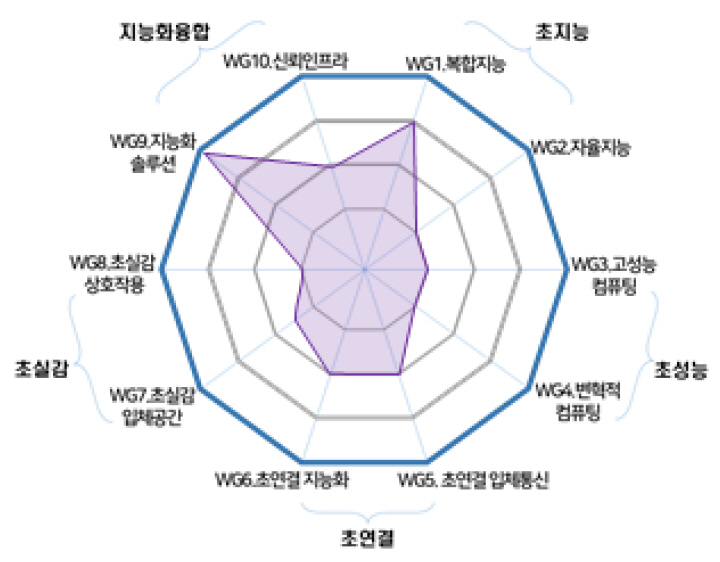

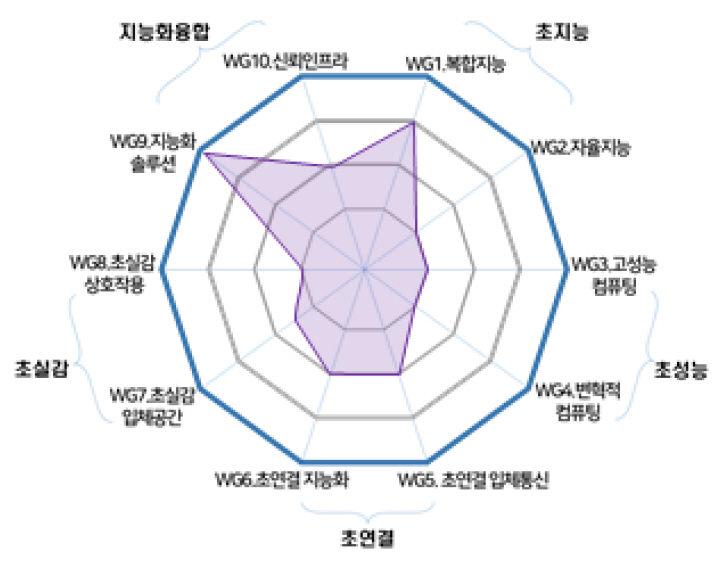

최종 3단계 목표인 AI 軍 참모는 전투 목적과 상황에 따라 다양한 분야의 AI 지휘관이 시·공간을 넘어 동적으로 연결되어 상호 협력하며 인간 지휘관과 자연스럽게 상호 소통하는 다국적 연합 전투 규모의 무인전술 수립 기술이며, AI 軍 참모 형상을 구성하는 기술분포는 다음과 같다.

다음 장부터는 AI 軍 참모를 구성하는 상기 네 가지 핵심 기술 분야별로 세분화하여 각 기술별 개용 및 국내·외 연구동향을 살펴보고자 한다.

Ⅲ. 열악한 환경에 강인한 전술맵 생성 기술

1. 기술개요

전장 공간에 대한 정보인지 능력과 지능화된 무기체계의 활용이 전쟁 승리에 미치는 영향이 나날이 증가하는 상황 속에서 무기체계뿐만 아니라 전투원들의 지능화를 통하여 잠재적 위협요인을 식별하고 신속하게 대응하기 위해서는 열악한 전장 환경하에서도 요구하는 기능과 성능을 만족시킬 수 있는 Robust 한 상황인식기술이 필요하다.

열악한 환경에 강인한 전술맵 생성 기술은 지휘관이 실시간으로 전장상황을 인식할 수 있도록 전장에 투입된 전투원, 무기체계, 센서 및 네트워크로부터 영상, 음성, 텍스트, 센서 정보 등 비정형의 멀티모달 데이터로부터 시각, 공간, 위치와 같은 단위 지능을 추출하는 전장 지식 생성 기술로 정의할 수 있다.

전장의 기본원칙은 ‘먼저 보고, 먼저 쏘고, 먼저 격파하라’이다. AI, 빅데이터, 양자컴퓨팅과 같은 최첨단 기술의 발달로, 전장 공간에 드론이나 로봇 등의 신무기체계가 도입되고 있으므로, 개별 전투원들이 얼마나 더 빨리 전장 공간을 인지하고 판단하여 대응하느냐에 따라 생존 및 승패가 갈리게 된다.

‘먼저 보는 것’을 가능하게 하는 시각지능은 비전센서로부터 수집된 센싱정보를 처리하여 적군/아군/민간인의 위치 및 피아식별, 무기 등 객체를 식별하는 기술로, 가려짐이 빈번한 전투현장에서 적군의 일부만 보이더라도 객체의 식별이 가능해야 한다. 또한 숨었다 나타나는 것이 반복되는 경우에도 지속적으로 분할 및 추적이 가능해야 한다. 이는 기존의 정상 데이터로 학습되어 있는 영상인식기술로 구현이 어렵기 때문에 전장상황에서 인식 가능하도록 행동인식의 전 과정을 완전히 새롭게 설계해야 한다.

공간지능은 앞서 시각지능에서 인식한 피아, 객체, 시맨틱 정보들의 연관관계를 분석하여 전투원 개인이 보는 시야 중심의 전장환경을 이해하는 기술로 정의된다. 이를 위해서는 모델 학습이 이루어져야 하는데, 현실적으로 장면이해를 위한 전투원의 훈련 및 실전 데이터를 획득하기가 매우 어려우며, 레이블링 작업 또한 엄청난 시간이 요구된다. 또한, 전장상황은 인공지능이 학습한 상황 그대로 실현되지 않으므로 새롭게 변화하는 전장상황을 현장에서 즉각적으로 이해하기 어렵다. 이를 해결하기 위해서는 소량의 데이터만으로 모델을 학습 및 업데이트 할 수 있는 메타학습을 적용해 볼 수 있다.

전투원 위치인식기술의 경우, 전장상황에서는 대개 GNSS-denied 환경, 즉 재밍에 의해 위성항법시스템을 사용하지 못하거나 건물 내부 또는 지하시설물에서의 운용을 전제로 한다. 위치지능은 전장과 같이, 동적 움직임이 심하고 환경적 변화가 심한 환경하에서도 최신 AI 기법을 접목하여 신뢰성 확보가 가능한 위치인식기술로 정의하였다. 영상기반의 비전 SLAM(Simultaneous Localization and Mapping)과 IMU센서기반의 보행항법기술의 융합이 실현 가능한 솔루션이나, 동적 움직임이 불규칙하고 빠르면 심각한 성능저하가 발생한다. 이를 해결하기 위해서는 기존에 시도되지 않은 새로운 위치인식기술의 연구가 시급한 상황이다.

2. R&D 기술동향

2018년 미 육군은 병사들의 인지증강을 위해 IVAS(Integrated Visual Augmentation System) 시스템을 도입하면서 마이크로소프트와 약 5,400억 원 상당의 홀로렌즈2 공급계약을 체결하였다. IVAS는 병사들이 훈련 및 임무 수행 중에 필요한 각종 정보 (환경정보, 작전 개요, 주변 지형도 및 건물 구조 등)를 증강현실로 제공하는 것을 목표로 하며, 2023년까지 병사의 눈, 손, 음성을 인식하는 AI 칩셋을 통합하여 보급하는 로드맵을 수립해놓았다. 미 육군에서는 IVAS를 ‘인공지능이 병사의 생존성을 향상시키는 데 어떤 역할을 하는지 잘 보여주는 예’라고 홍보한다[2].

ETRI에서는 2019~2020년 초까지 미래국방혁신기술개발사업의 일환으로 ‘비정형 환경에서의 개별 전투원 시각 공간 인지증강 기술 연구’ 수행을 통해 시각지능, 공간지능, 위치지능 관련 연구의 PoC를 검증하였다.

Ⅳ. 다중 가설 기반 전역 상황 인지 기술

1. 기술개요

AI에 기반한 지휘통제체계는 수집된 전장정보와 전술데이터들을 융합하여 상황을 자동으로 분석하고 판단하여 지휘관의 의사결정을 지원한다. 이를 위해서는 먼저 수집된 정형 또는 비정형 데이터를 정제/저장/전처리하여 전장 인식을 위한 학습데이터셋을 구축하여야 하며, 이를 이용하여 전장 전역의 상황 인지를 위한 모델을 학습하여 분석 및 판단에 활용한다. 국방 분야에서의 의사결정 지원을 위한 상황 인지 모델은 하나의 최적 해답을 제공해야 하는 다른 분야와는 달리 다양한 전장상황에서 적의 방책을 예측하기 위해 다양한 가설을 도출할 수 있어야 한다.

이러한 다중 가설에 기반한 전장 인식을 위해서는 먼저 지식베이스가 구축되어야 한다. 지식베이스를 이용한 다중 가설 생성의 최근 대표적인 접근 방법은 지식베이스를 지식 그래프로 표현하여 이전에 생성된 지식 그래프들을 새로운 상황의 추론에 이용하는 것이다[3]. 이를 위해 지식 그래프의 개체와 관계 정보를 잘 나타내도록 표현 학습을 통해 모델을 학습하거나, 논리 규칙을 결정하기 위해 지식 그래프에서 자주 나타나는 패턴의 동시출현(Co-occurrence) 정도를 분석하는 방법을 주로 사용한다.

지식 그래프를 생성하기 위해서는 먼저 주어진 비정형화된 데이터들을 정제하여 개체와 관계로 이루어진 트리플을 추출하여야 한다. 이를 위해 다양한 표현으로 이루어진 개체 및 관계들을 매핑시켜줄 수 있는 개체 추출 및 관계 추출 모델이 필요하다. 이렇게 추출된 트리플들로부터 지식 그래프를 생성하기 위해서는 국방 분야 특화 온톨로지가 정의되어야 하며, 실제 데이터로 얻은 각각의 트리플에 온톨로지를 적용하여 지식 그래프를 생성할 수 있다.

지식 그래프에서의 추론은 가장 높은 신뢰값을 갖는 서브그래프 찾는 방법으로 해결 가능하다. 또한 신뢰도에 따라 상위 K개의 서브그래프를 찾는 방법으로 상황에 대한 다양한 해석을 할 수 있는 가설들을 생성할 수 있다. 그러나 지식 그래프에서 최상위 및 상위 K개의 가설을 찾는 것은 NP-hard 문제로 매우 어려운 일이다. 따라서 이를 효과적으로 해결하기 위해 다양한 방법들이 시도되고 있다[4,5]. 또한 기존에는 대부분 텍스트만을 이용하여 지식 추출 및 이벤트 분석 등을 수행하였지만 최근 영상 등의 다양한 멀티미디어 소스로부터 온톨로지를 적용하여 지식베이스를 생성하여 더 복잡한 이 벤트들을 추출하는 방법들도 시도되고 있다[6,8].

국내에서는 민간 분야에서 상황 인지에 대한 일부 서비스를 개발하고 있으나, 질의응답 서비스와 같이 최적의 결과만 요구하는 경우가 대부분이기 때문에 국방 분야에서처럼 다양한 상황을 예측할 수 있는 다중 가설을 도출하는 기술 개발은 아직 미흡한 상황이다. 본 절에서는 전역 상황 인지를 위한 기술동향에 대해 살펴보고자 한다.

2. R&D 기술동향

미국 국방부 산하 DARPA에서는 의사결정지원을 위한 전역 상황 인지 기술들을 이미 개발하고 있다. COMPASS(Collection and Monitoring via Planning for Active Situational Scenarios)와 AIDA(Active Interpretation of Disparate Alternatives) 시스템이 가장 대표적인 의사결정지원 프로그램이다.

가. 미국 DARPA의 COMPASS 프로그램

COMPASS[9]는 최첨단 AI 기술을 활용하여 복잡하고 다계층적인 전장상황을 고려하여 지휘관의 판단을 지원한다. 이 시스템의 최종 목표는 지휘관에게 다양한 자극에 대한 적의 반응을 평가하여 제공하며, 불확실하며 모호한 적의 의도를 파악하는 데 있다. 이를 위해 COMPASS는 능동적 상황 시나리오 계획을 통한 실시간 데이터를 수집/모니터링하며, 인공지능 및 게임이론, 모델링 등의 기술을 이용하여 단기적으로는 적의 전술, 장기적으로는 적의 의도 및 전략 관점에서 분석하여 파악한다. 수집된 적의 정보와 의도를 종합하여 지휘관에게 각 가설의 증거와 분석에 대한 상황인식 정보를 제공한다.

COMPASS는 최근 인도-태평양 사령부 본부에서 시범 테스트를 통해 그 효용성을 입증하였다[10]. 인도-태평양 이 실험에서 COMPASS는 관측된 일련의 사건들, 예를 들어 군의 움직임, 사이버 침입, 시민들의 불안감 등의 관측들이 하나의 사건으로부터 야기된 것인지 아닌지를 파악하여 제공하였다.

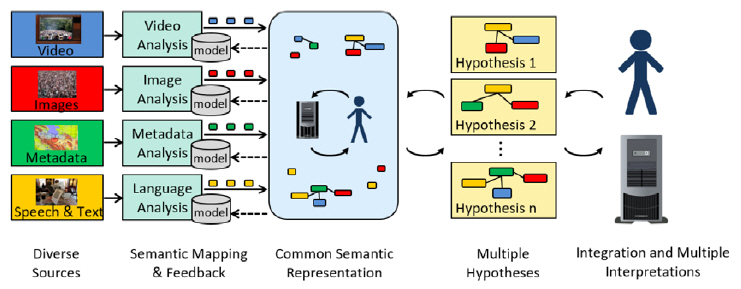

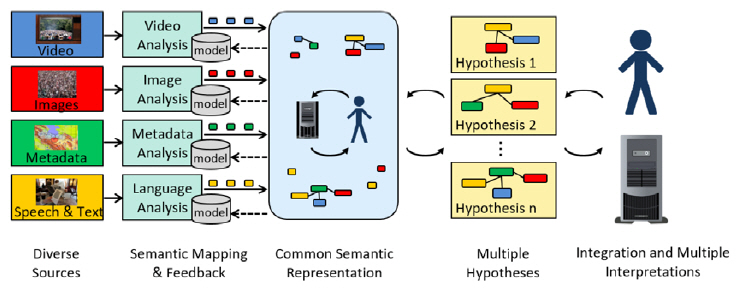

나. 미국 DARPA의 AIDA 프로그램

국방부 산하 DARPA에서는 멀티모달 데이터를 이용한 의사결정지원 프로그램인 AIDA[6] 프로젝트를 통해 다양한 멀티미디어 소스로부터 입력된 비정형화된 데이터를 동시에 분석하여 사건, 상황 등에 대한 다양한 가설을 생성하여 지휘관의 의사결정을 지원한다. 이 프로그램은 그림 3에 나타낸 바와 같이 다양한 멀티미디어 소스에서 자동으로 정보를 추출하고 매핑하여 공통된 표현으로 만들 수 있어야 하고, 여러 가설을 생성 및 검색할 수 있는 기술을 포함한다. 또한 생성된 다양한 가설에 대한 신뢰도를 제공해야 한다. AIDA 프로그램에서는 국가분쟁 등의 시나리오에 대한 다중 가설 데이터셋(SM-KBP: Streaming Multimedia Knowledge Base Population)[7]을 워크숍을 통해 제공하여, AIDA 프로그램에 참여 중인 팀들에 한하여 멀티미디어 소스로부터 생성되는 다중 가설을 검증할 수 있도록 하였다.

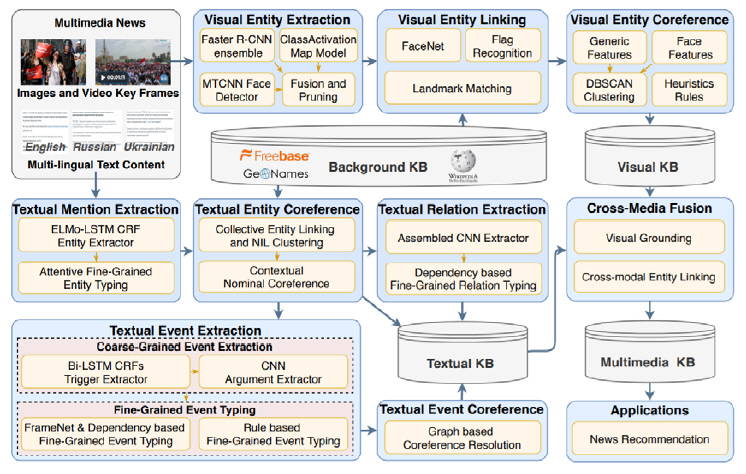

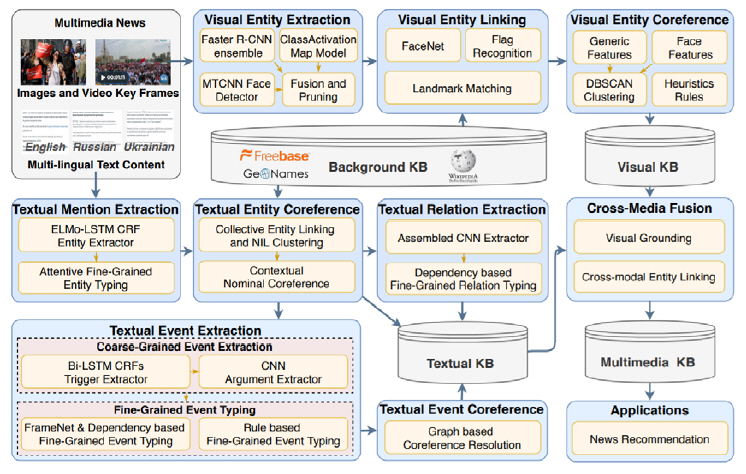

AIDA 프로그램 중 GAIA(Generating Alternative Interpretations for Analysis)[8]팀이 지난해 NIST TAC SM-KBP 2019에서 Task 1에서 1등을 차지하였다. GAIA 시스템은 특히 새로운 이벤트, 상황 및 관심 추세에 대한 통합적이고 이해 가능한 솔루션을 제공하는 데 목적을 두고 있다. 실시간으로 제공되는 텍스트, 음성, 영상 등의 멀티모달 및 다국어 정보들의 통합 분석을 위해 GAIA에서는 멀티모달 지식 추출, 의미 통합, 지식 그래프 생성 및 추론에 중점을 두고 연구 중이다. 그림 4에서 GAIA의 상세 시스템 구조를 확인해 볼 수 있다.

Ⅴ. 강화학습 기반 방책 추천 기술

1. 기술개요

전시와 같이 급박한 상황에서는 정확하게 상황을 인지한 후 최선의 방책을 제공할 수 있게 해 주는 기술 개발이 필요하다. 특히 지휘관이 놓치기 쉬운 빅데이터 간 상관관계 분석을 통해 잠재적 위협요인 식별 및 지휘관이 미처 예상하지 못한 적군 방책 후보들에 대한 이유가 도출되면, 인공지능을 통해 최적의 신속한 대응이 가능하다.

이러한 실시간 전투상황에서 수집된 정보를 바탕으로 강화학습 기반의 시뮬레이션(M&S)을 통해 실시간 대안 도출 및 판단 근거를 제공하는 작전지휘 의사결정 방책 추천 기술을 제공할 수 있다.

2. R&D 기술동향

가. 미국 DARPA의 Deep Green 프로그램

미국 국방부 산하 DARPA는 지휘관의 의사결심지원을 위한 시스템으로 Deep Green을 개발하였다. 이는 지휘관들에게 방책과 기타 판단에 필요한 정보를 제공하는 지휘관 주도의 시스템으로 현 작전 상황에 대한 평가, 다중 해상도의 시뮬레이션을 통한 미래상황 예측, 지휘관의 계획 작성, 그리고 지휘관의 상황판단 등 4가지 기능을 지원하였다. ‘CrystalBall’은 현 작전상황에 대한 평가, ‘Blitzkrieg’를 통한 다중 해상도의 시뮬레이션을 통해 미래 상황 예측, ‘Sketch-To-Plan’은 지휘관의 계획 작성, ‘Sketch-To-Decide’는 지휘관의 상황판단을 지원하는 기능이다[11].

나. 미국 DARPA의 XAI 프로그램

미국 국방부 산하 DARPA에서 개발하는 XAI는 AI의 역량을 예측정확도뿐만 아니라 AI가 갖춰야 할 새로운 역량으로 “설명능력(eXplainability)” 개념을 도입하고 XAI를 AI가 최종결론에 이른 이유와 그 과정을 사람이 이해할 수 있게 설명하는 새로운 AI 소프트웨어로 정의하고 있다. 이를 통해 사람이 차세대의 AI파트너를 이해하고, 적절하게 신뢰하고, 효과적으로 관리할 수 있도록 지원하는 중이다.

국내의 XAI(Explainable Artificial Intelligence) 프로젝트는 UNIST에서 주관하여 딥러닝(Deep Learning) 위주의 현 인공지능 기술의 한계를 극복하기 위해 의사결정 이유를 설명할 수 있는 인간 수준의 학습·추론 프레임워크와 불완전한 데이터로부터 학습이 가능한 프레임워크를 개발 중이며, 이를 바탕으로 사용자 수준에서 이해할 수 있도록 설명이 가능한 인터페이스를 개발하고 최종적으로 의료, 금융 등 전 문 분야에 실제로 적용하는 것을 목표로 하지만 군사목적을 위한 프레임워크는 제공되지 않고 있다.

Ⅵ. 전장 공간의 초연결 신뢰네트워크 기술

1. 기술개요

기존 플랫폼 중심의 전장 환경에서는 분산된 다수의 전장상황 데이터를 신속하게 수집·전달할 수 없으며, 야전 환경에서는 신뢰성 있는 대용량의 네트워크 인프라 구성이 어렵다.

따라서 지역별로 분산된 근접한 에지 노드에서 전장상황 정보를 관리하고 이를 효율적으로 AI 참모에게 전달하는 네트워크 및 인프라를 제공하는 기술이 필요하다.

이러한 전장 공간의 물리-상황 연계 분산 신뢰 인프라 네트워킹 기술을 통해, 지휘본부와 작전지역과의 실시간 정보 전달을 가능하게 하는 임무 관계 중심의 신뢰 에지 네트워킹 기술을 제공할 수 있다.

2. R&D 기술동향

미군은 네트워크 중심전 환경에 대비하여 전 세계 네트워크를 미 국방성의 안전한 가용네트워크로 만들기 위한 총체적 통신프로젝트로 GIG (Global Information Grid) 프로젝트를 추진하였다. 인터넷 등 보호되지 않는 네트워크를 경유하더라도 주요 비밀정보가 노출되지 않고 안전하게 유통하는 ‘Black Core Network’ 기술을 개발하여 2020년까지 국방 네트워크 고도화 추진하였다[12].

미군은 IoT 솔루션을 군 업무(Business)와 임무(Mission)에 맞게 도입하여 초연결된 스마트 군수, 경계, 에너지·환경 인프라를 구축하는 전략을 추진 중이며, 미군의 스마트 기지 구현 방안으로 활용하고 있다[13].

미 국방성의 CIO 비전에 따르면, DoD CIO는 모든 전술상에 연계된 유·무인체들의 연합 정보화를 위한 프레임워크를 제시하고, 구성 요소들의 생산 단계(구조/디자인/개발)부터 자율적으로 연합 동작 능력을 위한 인프라 포트폴리오를 제시하고 있다. 주요 특징으로는 상용 클라우드, 연합 파트너, 외부 네트워크와의 연결은 Gateway 및 Access Points를 통해서 신뢰성 있게 연동하는 방안을 제시하고 있다[14].

Ⅶ. 결론

본 고에서는 지휘관들의 의사결정지원을 위한 AI 軍 참모 기술에 대한 연구동향을 살펴보았으며, 상세하게는 핵심 구성요소인 열악한 환경에 강인한 전술맵 생성 기술, 다중 가설 기반 전역 상황 인지 기술, 강화학습 기반 방책 추천 기술, 전장 공간의 초연결 신뢰네트워크 기술에 대한 최근 기술동향과 전략을 분석하였다.

열악한 환경에 강인한 전술맵 생성 기술은 지휘관이 실시간으로 전장상황을 인식할 수 있도록 전장에 투입된 전투원, 무기체계, 센서 및 네트워크로부터 영상, 음성, 텍스트, 센서 정보 등 비정형의 다양한 데이터들로부터 단위 지식들을 추출하는 전장 지식 생성 모델링 기술로 진화하고 있다.

다중 가설을 기반으로 한 전역 상황 인지 기술은 민간 분야에서 상황분석에 대한 일부 서비스를 개발하고 있으나, 질의응답 서비스와 같이 최적의 결과만 요구하는 경우가 대부분이기 때문에 국방 분야에서처럼 다양한 상황을 예측할 수 있는 다중 가설을 도출하는 기술 개발은 아직 미흡한 상황이고, 다양한 멀티미디어 소스로부터 온톨로지를 적용하여 지식베이스를 생성하여 더 복잡한 이벤트들을 추출하는 방법들도 시도되고 있다.

강화학습 기반 방책 추천 기술은 전시와 같이 급박한 상황에서는 정확하게 상황을 인지한 후 최선의 방책을 제공할 수 있게 해 주는 핵심 기술로서 지휘관이 놓치기 쉬운 빅데이터 간 상관관계 분석을 통해 잠재적 위협요인 식별 및 지휘관이 미처 예상하지 못한 적군 방책 후보들에 대한 인공지능을 통해 최적의 신속한 대응을 가능하게 하는 향후 미래국방의 블루오션 기술이다.

전장 공간의 초연결 신뢰네트워크 기술은 역별로 분산된 근접한 에지 노드에서 전장상황 정보를 관리하고, 이를 효율적으로 AI 軍 참모에게 전달하는 네트워크 및 인프라를 제공하는 기술이 필요하며, 이러한 전장 공간의 물리-상황 연계 분산 신뢰 인프라 네트워킹 기술을 통해, 지휘본부와 작전지역과의 실시간 정보 전달을 가능하게 하는 임무 관계 중심의 신뢰 에지 네트워킹 기술개발로 가속화되고 있다.

결론적으로, AI 軍 참모 기술은 곧 다가올 미래 전장을 재정의할 핵심 기술로, 중국/일본 등 열강의 위협 속에서 정세를 판단하고 위기상황에 유연하게 대처할 수 있는 ‘증강된 정보’ 기반의 지휘통제 시스템으로써 전투력을 극대화하고 전투병과 무기체계들의 생존성을 향상시켜 전투에서 반드시 승리할 수 있는 작전지휘통제체계를 확보할 것으로 기대된다.

약어 정리

AFCCS

Air Force Command and Control System

AI

Artificial Intelligence

AIDA

Active Interpretation of Disparate Alternatives

COMPASS

Collection and Monitoring via Planning for Active Situational Scenarios

DARPA

Defense Advanced Research Projects Agency

GAIA

Generating Alternative Interpretations for Analysis

KJCCS

Korean Joint Command and Control System

KNCCS

Korea Naval Command Control System

M&S

Modeling and Simulation

SM-KBP

Streaming Multimedia Knowledge Base Population

참고문헌

그림 1

그림 2

그림 3

그림 4

그림 5