초실감메타버스 기술 동향 및 발전 전망

Hyper-reality Metaverse Technology Trends and Development Prospects

- 저자

-

조용성초실감메타버스기획팀 yscho73@etri.re.kr 현은희초실감메타버스기획팀 ehhyun@etri.re.kr 배성준미디어부호화연구실 sjbae@etri.re.kr 정혁감성디지털휴먼연구실 jay@etri.re.kr 안성덕실감소자연구본부 lovesky@etri.re.kr

- 권호

- 39권 2호 (통권 207)

- 논문구분

- 공간현실로 발전하는 초실감 메타버스 기술

- 페이지

- 1-11

- 발행일자

- 2024.04.01

- DOI

- 10.22648/ETRI.2024.J.390201

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.- 초록

- The metaverse is expected to evolve into an immersive environment based on photorealistic stereoscopic imaging to integrate real and virtual worlds. To transition from flat images to immersive stereoscopic images, such as light fields and holograms, a continuous cycle of technological development should be reached in media, content, and device technologies, ranging from acquisition and generation to transmission and synthesis as well as reproduction and interaction. Additionally, owing to the multitude of components involved in the metaverse, proper service realization will be challenging without concurrent advancements in computing and communication technologies that facilitate the integration of such components. We introduce research and development trends in media, contents, and devices at the Electronics and Telecommunications Research Institute toward the next generation of stereoscopic images.

Share

Ⅰ. 서론

메타버스는 현실 같은 가상세계를 구현하기 위한 다양한 기술과 서비스를 모두 포함하는 포괄적인 개념으로, 현실과 가상이 하나로 어우러진 융합 공간에서 디지털 정보를 공유하고 소통할 수 있는 현실 같은 가상의 공간이나 가상과 현실이 결합한 공간 또는 그 공간과 관련된 서비스로 정의할 수 있다[1,2]. 현실과 가상이 융합된 공간의 서비스에서 가장 중요한 부분은 디지털로 구현되는 현실세계의 수준이 현실과 가상이 구별되지 않을 정도의 수준으로 제공되어야 한다는 점이다.

현실과 가상의 구분이 어려운 수준의 서비스 제공을 위해서는 무엇보다도 실감성 강화 측면의 기술 발전이 가장 중요하다고 할 수 있다. 그러나, 현재의 메타버스 기술에서는 여전히 평면영상이 사용되고 있다. 스마트폰, 노트북, TV 등의 평면영상도 해상도가 높아짐에 따라 실감도가 더욱 높아지고 있지만, 진정으로 실상과 가상이 구별되지 않기 위해서는 입체영상으로의 진화는 필수적이다.

이에 본고에서는 입체영상 기반의 초실감 메타버스로의 전환을 위한 기술 발전 전망과 ETRI의 연구 개발 현황을 소개하고자 한다.

Ⅱ. 초실감 메타버스 기술 발전 전망

Jon Radoff는 메타버스의 구성 요소를 그림 1과 같이 인프라(물리적 단계)부터 경험(응용 단계)까지 7개의 계층으로 분류하고, 5G/6G 통신, 미디어 클라우드 등의 인프라와 3D엔진, VR·AR 디바이스 등을 통한 휴먼 인터페이스 기술을 기반으로 한 공간 컴퓨팅 서비스를 통해 진정한 메타버스를 실현할 수 있을 것으로 설명했다[3].

최근 애플의 비전프로, 메타의 메타퀘스트3 등 새로운 디바이스들이 연이어 출시되면서 혼합현실을 기반으로 한 ‘공간 컴퓨팅(Spatial Computing)’이 다시 주목받고 있다. 공간 컴퓨팅은 사람이 움직임에 따라 화면과 터치스크린 등이 있는 공간이 옮겨지면서 전자기기를 사용할 수 있게 하는 개념으로, 현실세계와 가상세계를 결합하여 사용자가 두 가지 모두와 상호작용하는 경험을 제공할 수 있다[4].

위와 같이 미래의 메타버스는 현실과 가상이 융합된 공간에서 정보를 공유하고 소통할 수 있는 서비스로 발전될 것으로 전망된다. 이러한 서비스 환경에서 가장 중요한 부분은 실감성이며, 이를 향상시켜줄 수 있는 기술의 발전이 가장 필요하다.

현재 실감성 향상을 위한 기술로 평면영상이 주로 사용되고 있다. 물론, 평면영상도 해상도가 높아지면서 실감도가 향상되고 있다. 그러나, 실상과 가상의 구별이 어려운 수준의 서비스 제공을 위해서는 라이트필드, 홀로그램 등의 기술을 기반으로 한 입체영상으로의 진화는 피할 수 없을 것이며, 이것이 가능해져야 메타버스 서비스의 활용도가 더 높아질 것이다.

입체영상 제공에 있어 중요한 물리적 요소로는 양안 시차, 운동 시차, 초점, 시점 네 가지가 있는데, 현재는 주로 평면영상에서 양안 시차를 이용한 입체영상이 제공되고 있고, HMD를 사용하는 경우는 운동 시차까지 제공하고 있다. 그러나, 현재의 입체영상 제공 기술은 여전히 어지럽고 불편한 상황이다. 이를 극복하기 위해서는 양안 시차 입체영상 기술에서 다시점 및 다초점까지 제공할 수 있는 입체영상 기술과 이를 기반으로 한 미디어 콘텐츠가 필요하다.

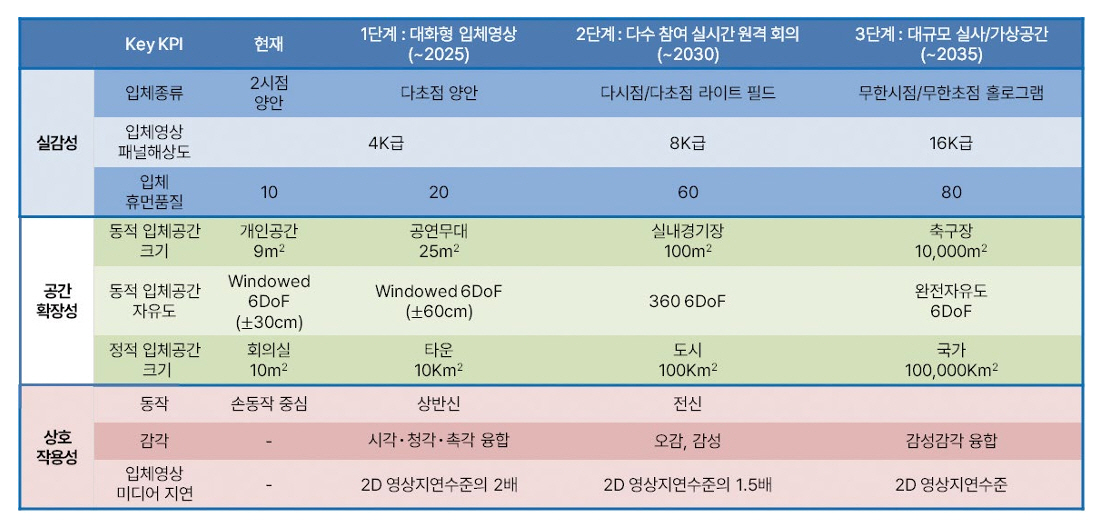

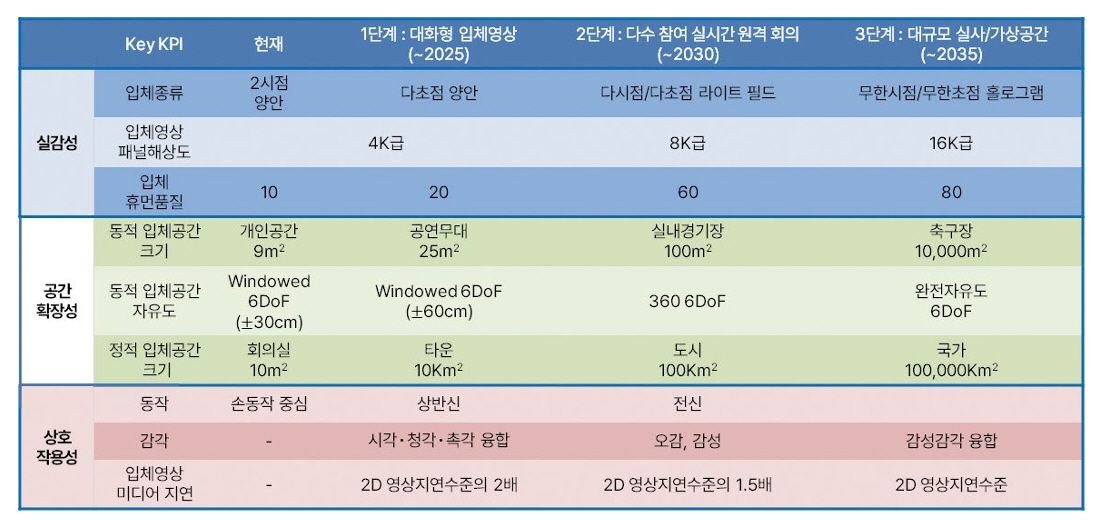

ETRI에서는 입체영상을 더욱 입체영상같이 만들어 주는 것을 ‘공간현실(Spatial Reality)’로 명명하고, 그림 2와 같이 공간현실로의 발전 목표 달성을 위한 세 가지 핵심 성과 지표로 실감성, 상호작용, 공간 확장을 설정하였다. 또한, 상호작용과 공간 확장 지표가 핵심이 되어 실시간 가상공연, 온라인 게임 등을 제공하는 가상공간형 서비스, 실감성과 상호작용 지표가 중심이 되는 실사형 원격회의 또는 의료, 제조 등의 산업 분야의 협업을 위한 커뮤니케이션형 서비스, 실감성과 공간 확장 지표가 중심이 되어 원격공간을 실시간으로 중계하는 공간공유형 서비스를 정의하였다[5].

실감성은 양안 시차 기반의 입체영상에서 시점이나 초점을 가변할 수 있는 라이트필드 또는 시점과 초점이 무한대로 연결되는 홀로그램 기술로 발전이 필요하다. 상호작용에 있어서는 시청각 및 촉각을 넘어서 오감을 이용한 체험으로 발전해야 하고, 결국에는 감성까지도 발전되어야 할 것으로 전망된다. 공간 확장의 경우는 대부분의 입체영상이 CG 영상들을 활용하고 있는데, 이것을 더욱더 현실적으로 만들려면 실사 영상도 함께 활용되어야 한다. 그러나 모든 세상을 실사 영상으로 찍어 적용하는 것은 간단한 일이 아니다. 그래서 일부 영상들을 찍어내고 그 영상에 담긴 공간을 좀 더 넓은 공간으로 확장하는 작업들이 적용되어야 한다.

그림 3은 앞서 언급한 세 가지 핵심 성과 지표를 기반으로 진행되어야 할 핵심 기술의 성과 지표와 개발 목표 시점에 대해 정리한 것이다.

실감성 관점에서는 입체의 종류, 입체영상 패널 해상도, 입체 휴먼 품질과 같은 세부 지표를 정의하였다. 입체의 종류는 현재 2개의 시점, 즉 양안 시차를 이용한 입체를 즐기고 있다면 앞으로는 다초점 양안 또는 다시점과 다초점이 동시에 적용되는 라이트필드로 발전하고, 궁극적으로는 초점과 시점이 무한히 연결되는 홀로그램으로 발전해 나가야 할 것으로 예상된다. 이를 위해서는 더욱더 높은 해상도의 디스플레이가 요구되는데 현재의 4K급, 8K급이 가까운 미래에 16K급까지 요구를 충족할 수 있어야 할 것이다.

공간 확장성 관점에서 실사를 이용한 동적 공간과 CG를 이용한 정적 공간으로 분류할 수 있다. 실사를 이용한 동적 공간의 확장에 많은 어려움이 있겠지만, 현재의 수준이 개인 공간의 크기라면 앞으로는 공연 무대나 실내 경기장 수준으로 축구장 정도 수준의 큰 공간까지 실사 공간을 확장해 나가야 할 것이다. 또한, 실사 공간 안에서 움직일 수 있는 동적 입체공간의 자유도가 현재의 제한된 3DoF에서 360 6DoF를 거쳐 자유도에 제한이 없는 완전자유도 6DoF까지 발전해야 할 것이다. CG 기반의 정적 입체 공간의 크기는 타운이나 도시에서 국가 공간 수준으로 확장하고, 실시간으로 변화가 연동될 수 있도록 하는 기술까지 발전이 필요할 것으로 예상된다.

상호작용을 동작과 감각으로 나누어 볼 때, 동작의 경우 센서 없이도 사람의 움직임을 정확하게 반영하는 기술을 추구하며, 헤드마운트 디스플레이나 헤드마운트 디바이스만으로도 온몸을 추적할 수 있는 기술이 발전해야 할 것으로 보인다. 감각에 대해서는 현재 시청각과 촉각을 일부 활용할 수 있는 수준이지만, 향후에는 오감까지 포괄하는 영역으로 확장되어 결국엔 감성까지 교감할 수 있는 상호작용으로 발전해 나가야 할 것이다. 입체 미디어 지연 측면에서는 원활한 상호작용을 위해서는 실시간으로 정보들이 공유되어야 하는데 감각이나 동작 데이터들의 실시간 공유는 비교적 용이하지만, 큰 데이터량을 가지는 초실감 영상 데이터를 실시간으로 공유하는 것이 매우 어려운 상황이다. 이런 문제를 해결하기 위한 영상 압축, 전송방식 및 송수신 지연과 관련된 문제도 반드시 해결되어야 한다. 결국 현재 어느 정도 이용에 불편이 없을 정도의 2D 영상 기반의 서비스와 유사한 수준의 전송 속도와 지연이 입체영상 기반의 서비스에서도 달성될 수 있어야 할 것으로 예상된다.

Ⅲ. 공간현실을 위한 ETRI 연구개발 현황

1. 공간현실(Spatial Reality)로의 발전

앞에서 살펴본 바와 같이 메타버스 서비스는 기존 현실에서 존재할 수 없는 경험을 새롭게 제공하거나 현실을 확장하여 추가적인 가치를 제공하는 서비스로 구성된다. 현실 공간과 같이 3차원의 활동 가능한 가상공간 제공이 필수적이며, 기술적으로 이 3D 공간을 경험할 수 있도록 해 주는 넓은 범주의 기술을 필요로 한다. 디바이스 측면에서는 전통적인 2D 평면형식의 디바이스를 확장하거나 3D 공간 경험을 가능하게 해야 한다. 이를 위해 TV, 스마트폰 등 기존의 2D 평면 디스플레이는 공간경험 제공을 위해 다시점을 제공하는 윈도우 6DoF 디스플레이나 자유로운 운동 시차를 제공하는 라이트필드 디스플레이 등으로 발전되고 있으며, HMD나 스마트안경처럼 양안 시차를 직접적으로 제공하여 추가적인 공간감을 제공할 수 있는 새로운 공간경험을 제공하는 디바이스가 꾸준히 상용화되고 있다.

메타버스에서 제공될 수 있는 서비스는 “추가된 3D 가상공간”이 활용될 수 있는 거의 모든 종류를 포함하므로 기술 개발의 관점에서 필요로 하는 기술범주의 폭이 매우 넓으며 많은 기존기술과 신규기술들의 동시 다발적인 진화가 요구된다. 광범위한 기술 범주에서 기술 요소별 중요도를 판단하고 기존 기술의 활용 가능성을 분석하기 위해서는 서비스 군(群)별로 서비스의 품질을 결정하는 대표적 기술 가치를 정의할 수 있다.

메타버스 서비스 경험의 품질을 결정하는 핵심 기술가치들을 사용자의 인지요소를 기준으로 분류하면 그림 2에서 각 축으로 표현된 세 가지로 대표할 수 있다. 첫 번째로 메타공간 내에서 가상으로 만나고 경험하는 다양한 인적, 물적 객체와의 상호작용이 현실과 동일한 수준으로 지연없이 제공될 수 있어야 하며, 이 경험가치를 위한 기술요소들을 실시간 상호작용성 그룹으로 묶을 수 있다(그림에서 높이 방향). 두 번째로 메타버스는 현실공간과 분리되거나 연동될 수 있는 추가적인 공간을 제공하는데, 이때 제공되는 공간의 물리적 범위 및 특성이 제공하려는 서비스에 제한을 가하지 않아야 하며, 이를 달성하기 위한 기술 요소들을 공간 확장 그룹으로 묶을 수 있다(그림에서 깊이 방향). 마지막으로 서비스 시 가상공간에서 사용자가 경험하는 시청각 및 감각이 물리현실에서 경험하는 수준에 가깝게 도달할 수 있도록 서비스되는 시청각 콘텐츠가 고품질로 제공될 필요가 있으며, 이러한 경험가치를 위한 기술요소들을 실감성 그룹으로 묶을 수 있다.

상기 세 가지 경험가치는 서비스 종류별로 요구받는 종류가 다른데, 예를 들어 가상게임이나 예술체험, 재난시뮬레이션과 같이 현실공간에서 발생하거나 재현이 불가능한 경험을 가상공간에서 제공하는 유형과 같은 가상공간형 서비스는 가상공간 내에서의 상호작용성과 공간의 규모가 경험품질의 수준을 결정하는 주요 경험가치이다. 또한, 실사형 가상회의나 가상 제조환경과 같이 원격으로 떨어져 있는 다수의 물리공간을 가상공간에서 공유하는 형태의 커뮤니케이션형 서비스는 가상공간 내에서 참여자 간의 상호작용이 저지연 실시간으로 보장되어야 하며, 각자의 물리공간의 전부 또는 일부가 최대한 그대로 가상공간에서 재현되도록 하는 실감성이 주요 경험가치가 된다. 이와 또 다른 형태로 스포츠 중계, 공연 또는 유명관광지의 이벤트 등을 방송형태로 가상공간 내에서 중계하는 공간공유형 서비스는 물리공간이 가상공간에 그대로 재현되도록 하는 실감성과 재현되는 가상공간의 범위가 서비스의 품질을 결정하는 중요한 경험가치이다.

2. 공간현실을 위한 ETRI의 연구개발

가. 실감성

“실감성(Reality)”은 메타버스 가상공간에서 사용자가 경험하는 시청각 및 감각이 물리현실에서 경험하는 수준에 최대한 가깝게 도달할 수 있는 실재감의 정도를 나타내는 지수이다. 실감성을 확보하는 필수적인 요소는 바로 현실세계에서처럼 3차원의 입체를 얼마나 잘 구현하고 제공하는가에 달려있다. 이를 위한 실감성은 제공하는 입체의 유형과 입체영상을 제공하는 기기의 해상도 수준, 그리고 가상세계에 제공되는 입체휴먼 품질과 연관성이 매우 크다고 볼 수 있다.

실감성은 입체영상의 송수신 및 합성 기술과 입체영상의 재현 기술에 따라 결정된다. 송수신 및 합성 기술에 의해 입체영상의 품질이 결정되고, 입체영상의 재현 기술에 의해 입체영상을 체험하게 하는 기기의 해상도와 제공하는 입체의 유형이 결정된다(그림 4 참고).

입체영상의 송수신 및 합성 기술은 입력 입체영상 신호를 압축/다중화한 후 비트스트림을 구성하여 네트워크를 통해 전송하고, 단말에서 이를 수신한 후 사용자의 움직임을 기반으로 입체영상 신호를 합성하기 위한 저장/전송 포맷 및 합성기술이다.

미디어의 화질이나 음질의 수준이 향상되고 입체 미디어로 서비스가 발전함에 따라 송수신되어야 하는 미디어 데이터의 양이 기하급수적으로 증가하고 있는데, 4K UHD는 최대 36GB, 8K인 경우 최대 144GB이며, 라이트필드나 홀로그램과 같은 입체 미디어는 수십 TB 이상의 크기를 가지게 된다. 따라서 이러한 막대한 용량의 미디어 데이터를 저장하고 효과적으로 전송하기 위해서는 데이터량을 줄일 수 있는 미디어 압축기술이 필수적이다.

미디어 압축기술은 입력 영상이나 음향 신호에 대해 시간적, 공간적, 통계적 중복성을 제거하여 데이터량을 줄이는 기술로 비디오의 경우 원본 대비 1/400, 오디오의 경우 1/11로 압축할 수 있다. 미디어 압축표준은 인코딩된 비트스트림 포맷 및 디코딩 절차를 규정하고 있는데 현재 AVC, HEVC, VVC 등 다양한 비디오 코덱과 HE-AAC, USAC, 3D Audio 등 오디오 코덱이 사용되고 있다. 하지만 IP Traffic이 폭증하고 있고, 대부분이 비디오 데이터이므로 비디오 압축기술에 대한 추가적인 성능향상 요구가 있으며 오디오 코덱 기술도 단일 코덱에서 저지연과 고품질을 동시에 제공할 수 있는 새로운 오디오 코덱의 필요성이 대두되고 있다.

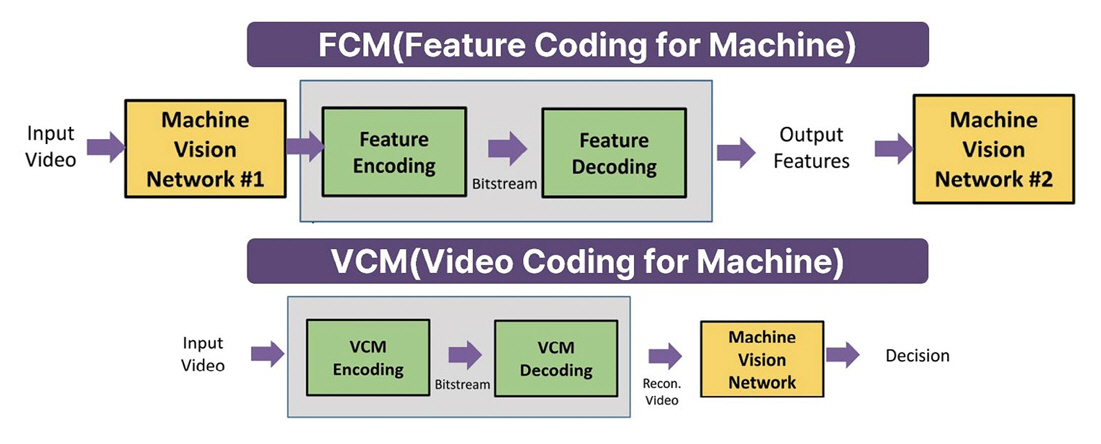

미래에는 이러한 요구사항을 기반으로 1/800 이상의 압축을 제공하는 PostVVC 기술, 저지연과 고품질을 동시에 제공하는 PostUSAC 기술, 기계를 위한 비디오 기술인 VCM, ACoM 등의 표준이 개발될 것이며 특히 AI 알고리즘이 많이 활용될 것이기 때문에 대용량 데이터에 대한 높은 연산량을 제공할 수 있는 AI 반도체 기술의 발전도 필수 요소라 할 수 있다.

ETRI는 이러한 문제점 및 요구사항을 해결하는 방향으로 미디어 압축 및 합성기술, 입체영상 재현기술에 대한 연구개발을 수행하고 있다.

첫 번째로 신호처리 기술을 기반으로 기존 미디어 압축툴의 성능 개선과 확장을 위한 연구가 진행되고 있는데, 4세대 비디오 부호화 기술인 HEVC와 5세대 비디오 부호화 기술인 VVC 분야에서의 표준특허 확보와 4세대 오디오 부호화 기술인 USAC과 5세대 오디오 부호화 기술인 3DA 표준특허 확보를 위한 연구가 진행 중이다. 특히 4세대/5세대 미디어 압축 표준 기술 개발에 대한 경험을 기반으로 현재 6세대 비디오 표준인 PostVVC 및 6세대 오디오 표준인 PostUSAC 관련 핵심원천 기술 확보를 위해 노력하고 있다.

두 번째는 AI 기술을 활용하여 기존 미디어 압축 툴을 대체하거나 확장하는 기술이다. 현재까지 5/6세대 비디오 표준 관련하여 1% 이상 성능개선 기술 10건, 3% 이상 성능개선 기술 3건을 개발하였고, 6세대 오디오 표준을 위한 원천기술로 AI 기반 MDCT 양자화 기술 등 8건의 성과를 달성하였으며 지속적인 연구개발이 진행 중이다.

세 번째는 AI 기술을 활용하여 종단간에 미디어 신호를 압축하는 것으로, 입력 비디오와 오디오 신호의 특성에 따라 AI 기술만을 활용하여 압축하는 기술이다. 종단간 미디어 압축과 관련하여 MPEG에서는 기계를 위한 비디오 부호화 기술에 대해 표준화를 진행하고 있다(그림 5 참고).

ETRI는 ’23년 10월, 144차 MPEG 표준화 회의에서 진행된 기계를 위한 영상부호화 표준 FCM에 대한 기술평가에서 세계 1위를 차지하였다.

네 번째로 합성기술은 사용자의 움직임에 따른 시점에 맞는 영상을 고속/고품질로 합성하여 실시간 재현하는 기술로, 사용자의 시점정보에 따라 가상시점을 합성하고 이를 기반으로 시점영상을 렌더링하여 사용자에게 실시간으로 제공하는 데 활용된다. 이를 위해 그림 6과 같이 전체 시청공간을 다수의 부분 공간인 그룹으로 분할하고, 사용자 위치에 따라 실시간으로 스위칭하는 VAS 기술을 개발하고 있다. 개발 중인 VAS 기술은 높은 합성 품질과 빠른 시점합성 속도를 동시에 제공할 수 있다.

마지막으로 입체영상 재현 기술은 그림 7의 예시와 같이 3차원 공간 콘텐츠와 미디어로 이루어진 메타버스 가상세계를 참여자에게 현실감 있게 제공하는 기술이다. 이를 위해서 시공간 경계를 허무는 실재감, 몰입감, 사실감을 제공해야 하며, 사실과 허구를 분간하기 어려운 완전한 입체영상과 장시간 사용 시 어지러움과 불편함이 없는 자연스러운 영상을 제공해야 한다.

현재 제공되고 있는 양안 시차의 입체영상의 경우, 수렴-초점 불일치로 인한 괴리, 움직임-영상 지연시간에 의한 괴리 및 입체영상 디바이스의 부피/무게로 인하여 실제 메타버스 기기로 사용하기에는 많은 문제점이 있다. 이러한 문제점을 해결하기 위해 ETRI에서는 다초점/다시점 제공, 초고해상도/고휘도/고색재현, 센서와 연동된 초고속 대용량 영상정보 처리 및 초경량/초박형/초저전력화가 가능한 라이트필드/홀로그램 기반 입체영상 재현을 위한 연구를 진행 중이다.

착용형 기반 입체영상의 경우, 그림 8과 같이 초고해상도화, 다초점/다시점화 및 초경량/초박형/초저전력화를 위한 연구를 진행하여 2025년에는 다초점 양안을 가능하게 함으로써 현재 대비 3배 품질을 향상시키고, 2030년에서는 다초점/다시점 라이트 필드기술을 적용하여 현재 대비 20배 품질 향상시키는 목표를 가지고 있다.

비착용형 기반 입체영상의 경우, 공간·객체 맞춤형을 위한 On-demand 프리폼 디스플레이 기술과 능동 메타 소자 기반의 광시야각/고화질 홀로그램 기술에 대한 연구가 진행 중이다.

나. 공간 확장성

“공간 확장성(Spatial Scalability)”은 메타버스에서 현실 공간의 3차원 구조를 가상공간으로 정확하게 투영하거나 가상의 환경을 창조하여 사용자가 그 안에서 자유롭게 활동할 수 있는 정도를 나타내는 지수이다. 이 지수는 메타버스가 현실세계의 공간적 특성을 얼마나 효과적으로 모사하고 확장하는지를 측정한다. 공간 확장성은 사용자가 메타버스에서 다양한 체험을 할 수 있도록 하는 중요한 특성 중 하나로, 다양한 환경에서 자유로운 이동과 상호작용 그리고 창조성 등을 허용함으로써 메타버스 경험의 현실성과 다양성을 향상시킬 수 있다.

높은 수준의 공간 확장성을 갖춘 메타버스는 사용자들에게 더 풍부하고 몰입도 높은 가상 경험을 제공할 수 있다. 이러한 공간 확장성은 가상현실(VR) 및 증강현실(AR) 기술, 그래픽스, 인공지능, 센싱 기술 등 다양한 기술의 진보와 결합하여 개발되고 있다. 이는 메타버스가 더욱 현실과 유사하게 사용자와 상호작용할 수 있도록 하며, 미래에는 더욱 발전된 메타버스 경험이 우리의 일상에 통합될 수 있을 것으로 기대된다.

메타버스 공간 확장은 실제 공간을 입체적으로 획득하거나 입체적인 가상공간을 생성하는 방식 또는 이들을 모두 포함하는 방식으로 이루어진다. 먼저 실제 공간을 입체적으로 획득하기 위해서는 자유시점 6DoF 재현이 가능한 실사 기반 고품질 라이트필드 입체영상 획득/재현 기술과 인간의 3차원 시각 인지 요건을 모두 만족시킬 수 있는 홀로그램 획득 및 재현 기술 개발이 필요하다(그림 9 참고).

여기서, 6DoF는 공간에서의 여섯 가지 자유로움을 의미하며, 이는 앞/뒤 이동, 좌/우 이동, 상/하 이동, 피치(회전), 롤(회전), 요(회전)로 나타낸다.

또한, 실사 기반 고품질 라이트필드 입체영상의 획득을 위해서는 현실 공간의 입체적인 모습을 정확하게 획득하기 위해 고해상도의 라이트필드 기술을 사용하는 것이 중요하다. 홀로그램은 광학적으로 생성된 입체영상을 말하며, 사용자가 입체적인 경험을 얻을 수 있도록 하는 기술로서, 현실과 상호작용하기 위해서는 사용자의 3차원 시각적 지각을 충족시키는 기술이 필요하다.

한편, 입체적인 가상공간의 생성을 위해서는 6DoF 라이트필드 입체영상 편집이 가능한 입체영상 저작 기술, 실세계 광역공간을 3차원 가상공간으로 복원하고 갱신하는 공간 생성 기술 및 인간 모습과 형태가 유사한 3차원 가상 인간을 만드는 디지털 휴먼 생성 기술의 개발도 필요하다.

6DoF 라이트필드 입체영상 편집은 공간 내의 입체영상을 자유롭게 편집하여 새로운 체험을 제공하는 기술이며, 공간 생성 기술은 실제세계의 광역 공간을 정확하게 모델링하고 가상공간으로 변환하거나, 컴퓨터 그래픽 기술을 통해 입체적인 공간을 생성하는 기술이다. 디지털 휴먼 생성 기술은 사용자와 유사한 형태와 동작을 가진 가상 캐릭터를 만들거나, 현실과 구분하기 어려운 디지털로 생성된 인간 형상을 만들어 내는 기술로, 메타버스 내에서 사용자의 상호작용을 보다 풍부하게 할 수 있다(그림 10 참고).

ETRI에서는 시점 간 고화질 영상 제공을 위한 4K 다시점 기반 라이트필드 획득, 장치 간 호환성 제공을 위한 MIV 표준 기반 라이트필드 생성, 클라우드 기반 라이트필드 입체영상 지능형 저작을 목표로 라이트필드 입체영상 획득/생성 및 저작 기술도 함께 개발하고 있다.

또한 AI를 활용한 실시간 자연광 기반 홀로그램 획득, 고해상도 홀로그램 생성이 가능한 프로세서 개발, 고밀도 깊이 표현과 홀로그래픽 HDR이 가능한 홀로그램 생성을 목표로 홀로그램 획득/생성 기술을 개발하고 있다.

다. 상호작용성

“상호작용성(Interactivity)”이란 용어는 메타버스에서 사용자 경험의 향상을 위해 다양한 감각 및 행동을 현실처럼 보고 듣고, 냄새를 맡고, 손이나 몸으로 느낄 수 있으며, 가상의 나를 움직이고, 다른 사용자와 교감하는 등의 행위를 포함하는 지수이다. 메타버스의 상호작용성 향상을 위해서는 사용자의 행위와 감정을 이해하고 의도를 파악하여 입체영상이 물리적/감성적으로 실시간 반응하고 사용자에게 실감 피드백을 주는 입체영상 상호작용 기술의 개발이 필요하다.

입체영상 상호작용은 다음과 같은 다양한 측면에서의 고려가 필요하다. 시각적 경험은 사용자가 메타버스 내에서 현실과 유사한 시각적 환경을 경험할 수 있는 능력으로서 고해상도 그래픽, 입체영상, 환경 효과 등이 포함된다. 청각적 경험은 현실과 유사한 사운드 및 음향 환경을 제공하여 사용자가 가상세계에서 소리를 경험할 수 있도록 하며, 냄새 및 감각 경험은 메타버스에서는 냄새, 터치, 온도 등과 같은 다양한 감각을 시뮬레이션하여 사용자에게 현실적인 경험을 제공한다. 손이나 몸의 움직임은 사용자의 실제 움직임을 추적하고 메타버스 내에서 가상의 캐릭터나 물체와 상호작용할 수 있도록 하는 기술이 상호작용성을 높인다. 또한, 가상의 나를 움직이도록 함으로써 사용자가 가상의 캐릭터로 변신하거나 가상공간에서 자유롭게 이동할 수 있게 한다. 사회적 상호작용은 다른 사용자와 교감, 즉 실시간으로 다른 사용자들과 소통하고 상호작용할 수 있는 능력을 나타낸다. 여기에는 음성 대화, 채팅, 공동 작업 등이 포함된다. 감정 인식 기술은 사용자의 표정, 목소리, 행동 등을 감지하여 가상세계 내에서 감정적 상호작용이 가능하도록 한다. 아울러 다양한 활동 및 경험은 사용자가 메타버스 내에서 다양한 활동을 자유롭게 체험할 수 있는 능력을 의미하게 되는데 가상 여행, 이벤트 참여, 게임 플레이 등이 포함될 수 있다(그림 11 참고).

이러한 경험을 향상시키기 위해 ETRI에서는 다음과 같은 세부기술을 개발하고 있다. 전신관절 추적 정확도의 오차 범위 50mm 이하를 목표로 전신 움직임을 표현하기 위한 동작 상호작용 기술과 가상 악수/시선맞춤 만족도 80% 이상을 목표로 설정하고 실재감 제공의 물리적 상호작용 기술을 연구하고 있으며, 이를 통해 1인칭 시점 뷰 기반 전신 동작 추적 및 실재감 제공의 물리적 상호작용이 가능할 것으로 기대된다.

한편, 냄새 및 맛을 가상으로 제공하기 위한 촉각/미각을 포함하는 오감 공감각 재현 기술 및 메타버스에서 사용자 간에 감정을 공유할 수 있는 사용자와의 교감 가능형 감성 상호작용 기술에 대한 연구를 진행 중이며, 이를 통해 시청촉후미각의 공감각 재현, 실시간 감정 인식 및 정량 평가 가능한 감성 인식/표현/공유등의 상호작용이 가능할 것으로 기대된다.

Ⅳ. 결론

미래의 메타버스는 현실과 가상의 경계를 허무는 사실감, 실재감, 몰입감을 제공할 수 있는 입체공간 및 입체영상 기반의 공간현실 기술로 발전할 것으로 예상된다. 현재보다 더욱 몰입감 있고 혼합된 상호작용을 통해 사람 간의 연결을 향상시키고, 현실과 가상이 혼합된 디지털 환경과 물리적 상호작용을 통해 교육, 의료, 엔터테인먼트 등 다양한 산업분야에서 이전과는 다른 새로운 경험을 제공할 수 있을 것이다[6-8].

하지만, 입체영상 기반의 공간현실로의 전환은 미디어, 콘텐츠, 디바이스 기술뿐만 아니라 통신, 클라우드 등의 안정적인 인프라 구축 등 수많은 기술과 서비스가 함께 발전해야만 가능한 일이다[9].

공간현실로의 발전을 위해 나가는 길에 많은 도전이 기다리고 있겠지만, 오늘의 작은 시작이 침체된 메타버스 분야 발전에 전환점이 될 수 있을 것으로 기대한다.

용어해설

공간현실 현실과 가상이 융합된 공간에서 디지털로 구현되는 현실세계의 수준이 현실과 가상이 구별되지 않을 정도의 수준으로 제공되는 리얼리티 기술

실재감 기술적 환경에 의해 매개된 경험의 기회를 실제 체험하고 있으면서도, 매체를 사용하고 있다는 사실을 잊고 매개된 환경 속에 몰입하는 것

약어 정리

AVC

Advanced Video Codec

CG

Computer Graphics

DoF

Degrees of Freedom

FCM

Feature Coding for Machine

HDR

High Dynamic Range

HEVC

High Efficiency Video Codec

HMD

Head Mounted Display

KPI

Key Performance Indicator

MPEG

Motion Picture Experts Group

USAC

Unified Speech and Audio Coding

VAS

Viewport-based Atlas Selector

VCM

Video Coding for Machine

VVC

Versatile Video Coding

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.