초실감 메타버스 시각화 기술 동향과 전망

Trends and Prospects in Super-realistic Metaverse Visualization Technologies

- 저자

-

염우섭실감디스플레이연구실 wsyoum@etri.re.kr 변춘원실감디스플레이연구실 cwbyun@etri.re.kr 강찬모실감디스플레이연구실 nkcm@etri.re.kr 김국주실감디스플레이연구실 kukjoo.kim@etri.re.kr 김용덕실감디스플레이연구실 yongduck@etri.re.kr 안대현실감디스플레이연구실 dha89@etri.re.kr

- 권호

- 39권 2호 (통권 207)

- 논문구분

- 공간현실로 발전하는 초실감 메타버스 기술

- 페이지

- 24-32

- 발행일자

- 2024.04.01

- DOI

- 10.22648/ETRI.2024.J.390203

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.- 초록

- Wearable metaverse devices have sparked enthusiasm as innovative virtual computing user interfaces by addressing a major source of user discomfort, namely, motion-to-photon latency. This kind of latency occurs between the user motion and screen update. To enhance the realism and immersion of experiences using metaverse devices, the vergence-accommodation conflict in stereoscopic image representation must be resolved. Ongoing research aims to address current challenges by adopting vari-focal, multifocal, and light field display technologies for stereoscopic imaging. We explore current trends in research with emphasis on multifocal stereoscopic imaging. Successful metaverse visualization services require the integration of stereoscopic image rendering modules and content encoding/decoding technologies tailored to these services. Additionally, real-time video processing is essential for these modules to correctly and timely process such content and implement metaverse visualization services.

Share

Ⅰ. 서론

메타버스 기술은 시간과 공간의 한계를 넘어 사용자에게 새로운 상호작용 방식과 경험을 제공할 수 있어 다양한 분야에 응용되어 엄청난 산업적 파급력을 가질 것으로 예상된다. 이에 메타버스 기술의 상용화를 위해 다양한 기업에서 초실감 시각화 기술을 중심으로 메타버스 서비스 플랫폼, 공간인식, 가상공간 내 상호작용 등에 관한 기술들이 경쟁적으로 개발되고 있다. 특히 최근에는 AI 및 기계학습을 통한 실시간 렌더링 및 인터페이스 기술 등도 선보이고 있어, 각 기술 분야에서 혁신적인 성과들이 보고되고 있다. 하지만 요소기술 간 통합의 어려움, 실제 응용 사례의 부족 등으로 인해 대중의 이목을 끌만한 매력적인 서비스 또는 디바이스가 출시되지 않아 대중의 메타버스 기술에 관한 관심이 점점 줄어들고 있었다.

지난 2023년 여름 애플의 비전 프로 공개는 이러한 상황을 반전시켜 대중의 메타버스 기술에 관한 관심을 다시 불러일으키는 계기를 만들었다. 이는 하드웨어와 iOS, mac OS 등의 운영체제 및 소프트웨어 개발환경, 그리고 앱스토어, iCloud 등의 서비스 플랫폼까지 애플 생태계로 통합하여 제공하고 있는 아이폰, 아이패드, 맥북 등 애플 대표 제품들의 성공 사례를 계승한 메타버스 시각화 디바이스로서 비전 프로가 개발 및 공개되었기 때문으로 해석할 수 있다. 비전 프로는 디바이스와 visionOS, 앱스토어 개발 환경을 잘 통합하고 Disney와의 콘텐츠 협력을 통해 완성도 높은 공간 컴퓨팅(Spatial Computing) 서비스를 공개하였고, 이는 소비자의 메타버스 디바이스에 대한 기대감을 다시 높일 수 있었다.

세계 최대 IT·가전제품 박람회인 CES 2024에서는 이러한 분위기를 바탕으로 애플의 비전 프로에 대항하기 위해 여러 XR(eXtended Reality) 제품이 발표됐다. 소니에서는 3D 콘텐츠 제작용 독립형 헤드셋의 출시 계획을 밝혔고, 퀄컴에서는 CES 개최 직전에 XR 디바이스 개발을 위한 차세대 XR 프로세서를 공개하였다. Xreal의 Air 2 Ultra와 TCL의 RayNeo X2 Lite 등의 AR(Augmented Reality) 스마트 글래스도 공개되어 업체별로 각자의 방식으로 메타버스 디바이스 기술을 대중에게 선보였다[1]. 이처럼 최근 공개된 다양한 메타버스 디바이스는 최근까지 개발된 초고해상도 마이크로 디스플레이 기술과 실시간 영상처리 기술을 중심으로 더욱 높은 현실감 그리고 초대형 가상화면 및 컴퓨팅환경 제공을 통해 소비자의 관심을 유도하고 있다. 애플 비전 프로에 대한 소비자의 관심을 새로운 메타버스 디바이스로 유도하려는 전략은 어느 정도 성공을 거두고 있는 것으로 보인다.

그러나 현재까지 출시된 착용형 메타버스 디바이스들은 모두 부피를 최소화해야 하는 특성상 디스플레이 패널과 사용자 눈동자 사이의 거리가 상당히 제한된다. 이러한 방식은 디스플레이 표면에 수정체의 초점을 맞춰 인지하는 거리와 두 눈동자를 관심 물체에 수렴시킴으로써 인지하는 거리에 큰 차이가 발생할 수밖에 없다. 이러한 수렴 초점 불일치(VAC: Vergence Accommodation Conflict)는 메타버스 디바이스가 제공하는 가상현실이 현실 세계의 시각 경험과 달라 현실감 및 몰입감의 저하를 유발한다. 그리고 이러한 깊이 인지 방식 사이의 부조화는 사용자에게 어지럼증, 피로감 등의 불편감을 유발하여 장시간 메타버스 디바이스를 사용할 수 없게 하는 가장 중요한 요인으로 알려져 있다[2]. 본고에서는 메타버스 디바이스 시각화 기술에 있어 수렴 초점 불일치 문제를 해결할 수 있는 기술에 대해 살펴보고자 한다. 나아가 장시간 사용에도 사용자가 수렴 초점 불일치로 인한 불편감 없이, 편안하게 활용할 수 있는 입체영상 생성 기술의 개발 현황과 전망에 대해 논하고자 한다.

Ⅱ. 메타버스 입체영상 구현 기술

1. 메타버스 디바이스 인지부조화 요인

최근까지 상용으로 출시된 착용형 메타버스 디바이스는 그림 1과 같이 눈동자와 일정 거리로 고정된 화면에서 양쪽 눈동자 각각이 표현하고자 하는 깊이에 해당하는 각도로 가상 물체를 바라보도록 눈동자별로 시점을 합성한 이미지를 표시함으로써 가상 물체의 깊이감을 표현해 왔다. 이는 사용자가 주시 물체까지의 깊이를 인지하는 두 가지 방법인 수렴, 초점 중 눈동자 수렴만을 이용하기 때문에 수렴 초점 불일치의 인지부조화가 발생할 수밖에 없는 구조이다[3].

하지만 그동안의 메타버스 디바이스 개발자들은 사용자에게 불편감을 유발하는 요인으로 이러한 수렴 초점 불일치보다는 사용자의 움직임과 이에 따른 표시 화면의 업데이트 사이에 발생하는 지연(MTP(Motion To Photon) Latency)을 더 주요한 원인으로 보고, 이를 해결하고자 했다[4]. 애플의 비전 프로에 대한 소비자들의 호평도 상당 부분 실시간으로 카메라, 센서 신호를 처리하고 화면을 업데이트 할 수 있는 전용 칩셋인 R1을 채용하여 12msec 이하로 줄어든 MTP latency를 실제로 체감할 수 있었기 때문이었다. 이러한 추세에 따라 최근 출시되는 대부분의 메타버스 디바이스들의 경우 이러한 MTP Latency를 기본적으로 12msec 이하로 유지할 수 있도록 개발되고 있다.

원리적으로 수렴 초점 불일치로 인한 인지부조화는 가상 물체와 사용자의 거리가 가까운 경우에 발생할 확률이 높아 Magic Leap에서는 바라볼 수 있는 가상 세계의 깊이를 37cm~무한대로 설정하여 이러한 수렴 초점 불일치 문제를 회피하고 있다[5]. 다른 메타버스 디바이스 제조사들도 명시적으로 초점거리 표현에 대한 성능을 밝히고 있지 않은 경우가 대부분이다.

2. 수렴 초점 불일치 저감 기술

수렴 초점 불일치로 인한 인지부조화를 줄이기 위해 연구되고 있는 기술은 가변초점(Vari-focal), 다초점(Multi-focal), Light Field 디스플레이 방식으로 분류될 수 있다[6].

가변초점 디스플레이는 안구추적을 통해 사용자가 응시하는 위치와 깊이를 측정, 디스플레이 화면을 사용자 응시 깊이에 맞게 이동하고 응시 깊이 밖의 물체는 흐리게 표시하는 방식이다. 다초점 디스플레이는 공간 또는 시간 등의 분할을 통해 사용자에게 한정된 초점면 수의 영상을 제공함으로써 안구추적 없이 사용자가 응시하는 깊이 밖의 화면은 광학적으로 자연스럽게 흐리게 인지되도록 표시하는 방식이다. 마지막으로 Light Field 디스플레이는 공간상 빛의 세기뿐만 아니라 방향까지 제어된 Light Field를 생성하여 입체영상을 사용자에게 제공하는 방식이다.

원리상으로는 Light Field 방식이 가장 완벽한 입체영상 생성 기술이지만 Light Field를 렌더링하기 위해 상기 언급된 세 가지 방식 중 가장 많은 연산량을 요구하며 구현 시점(위치, 초점) 수의 증가에 따라 디스플레이의 화소 수도 비례하여 증가해야 하는 기술적 어려움이 있다. 가변초점 디스플레이는 광학적 시뮬레이션이나 인공지능 알고리즘을 통해 응시 깊이 밖의 물체를 흐리게 표시함으로써 시각화한 화면의 현실감을 높이고 수렴 초점 불일치 문제를 해결하려는 방식이다. 그러나 시뮬레이션을 통한 렌더링으로 표현되는 영상의 현실감이 다초점 디스플레이 방식보다 현실감이 떨어진다는 연구도 있다[7]. 다초점 디스플레이의 경우 다초점 영상구현을 위해 구현 초점면 수에 비례하여 가변 광학계 및 디스플레이의 구동 속도를 높여야 하는 기술적 어려움이 있다. 그러나 비슷한 수준의 평면 해상도 구현을 기준으로 Light Field 디스플레이보다 구현이 쉬우며 가변초점 디스플레이 방식보다 현실감을 높일 수 있는 장점이 있는 방식이다. 따라서 본고에서는 다초점 입체영상 생성 기술을 중심으로 기술 현황을 소개하고자 한다.

Ⅲ. 다초점 입체영상 구현 기술

1. 다초점 입체영상 구현 방식

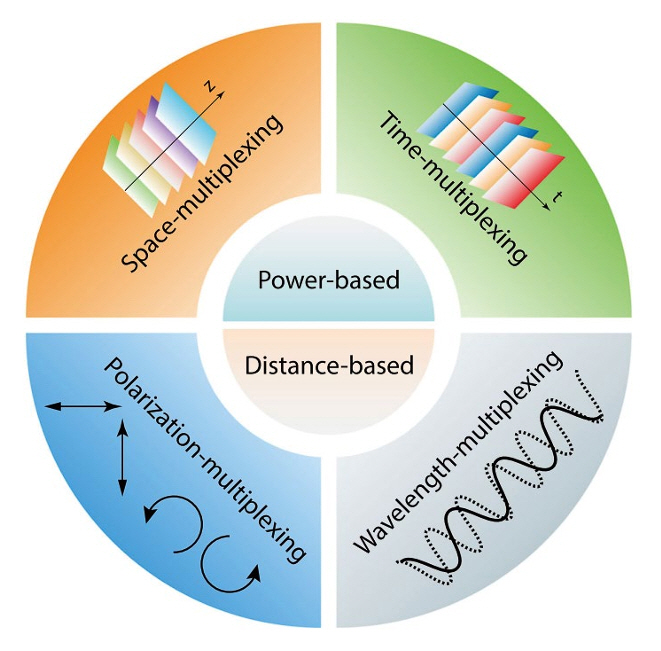

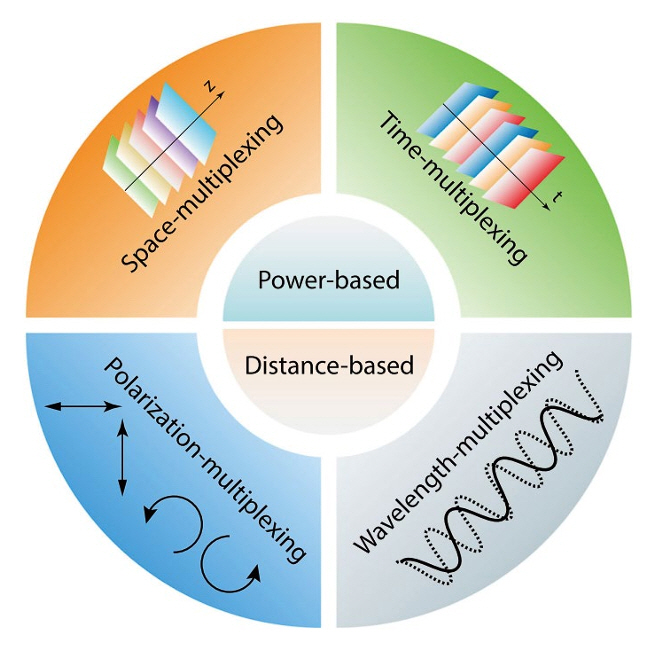

다초점 입체영상 디스플레이 구현 기술은 그림 2와 같이 크게 공간(Space), 편광(Polarization), 파장(Wavelength), 시간(Time)의 4가지 방식의 다중화(Multiplexing)로 분류될 수 있으며, 각 방식은 다시 굴절력(Power)과 거리(Distance) 기반의 방식으로 구분할 수 있다[8].

첫째, 공간 다중화 방식은 초점면별 이미지를 생성하는 화면을 각각의 공간에 배치, 광합성기를 이용하여 다초점 입체영상을 생성하는 방식으로 다수의 디스플레이와 광합성기의 구성으로 인해 디스플레이 모듈의 부피가 커져서 착용형 디바이스로 구현이 어려운 단점이 있다.

둘째, 편광 다중화 방식은 수평/수직 편광 또는 좌원/우원 편광별로 초점별 이미지를 생성, 조합하여 다초점 입체영상을 구현하는 방식으로 편광현상의 특성상 다수의 초점면을 구현하는 데 한계가 있다. 또한, 구현 초점면이 늘어날수록 색수차가 증가하고 구현 입체 화면의 밝기는 줄어드는 문제점이 있다.

셋째, 파장 다중화 방식은 초점면별로 파장이 다른 빛으로 이미지를 생성, 조합하여 다초점 입체영상을 구현하는 방식으로 2개 이상의 초점면 구현이 가능하지만, 파장으로 초점면별 이미지를 구분하기 때문에 초점면별로 표현되는 색상에 차이가 발생하고 색 재현율을 높일 수 없는 단점이 있다.

마지막으로 시간 다중화 방식은 한 프레임의 표시 시간을 구현 초점면 수로 분할된 시간 동안 개별 초점면에 해당하는 이미지를 디스플레이로 표시하고 동시에 사용자의 눈에 해당 초점면의 이미지가 제공될 수 있도록 가변초점 광학계를 구동하는 방식이다. 한정된 프레임 시간을 구현 초점면 수로 나누어 구동하기 때문에 디스플레이와 가변초점 광학계의 구동 속도를 높이는 것이 이 방식의 기술적인 이슈이다. 하지만 이러한 구동 속도 문제를 극복하면 입체영상 디스플레이 모듈의 소형화가 가능하여 착용형 메타버스 디바이스 구현에 가장 유리할 것으로 기대되고 있다.

2. 시간 다중화 다초점 입체영상 구현

시간 다중화 다초점 입체영상을 구현하기 위해서는 앞서 설명한 바와 같이 디스플레이에서 출력되는 이미지를 설계한 초점면에 위치시키기 위해 초점면의 제어가 가능한 가변초점 광학계를 구성해야 한다. 초점면 제어를 위한 부품으로 가변초점 렌즈 또는 가변초점 거울의 사용이 가능하지만, 가변초점 렌즈가 상용화된 제품이 다양하여 다초점 입체영상 구현에 더 유리하다.

가변초점 렌즈를 이용하여 다초점 입체영상을 구현한 연구로는 액정 방식[9], 전기 습윤(Electro-wetting) 방식[10-12], VCM(Voice Coil Motor) 구동 방식[13-16] 등으로 구분할 수 있다. 액정 방식, 전기 습윤 방식 가변초점 렌즈는 시간 다중화 다초점 입체영상 구현 방식 초기 연구에 사용되었고, 스위스의 Optotune社에서 VCM 구동 방식의 FTL(Focus Tunable Lens) 제품군을 상품화한 이후부터는 VCM 구동 방식의 가변초점 렌즈를 사용하여 다초점 입체영상 광학계를 구현한 연구가 주류를 이루고 있다.

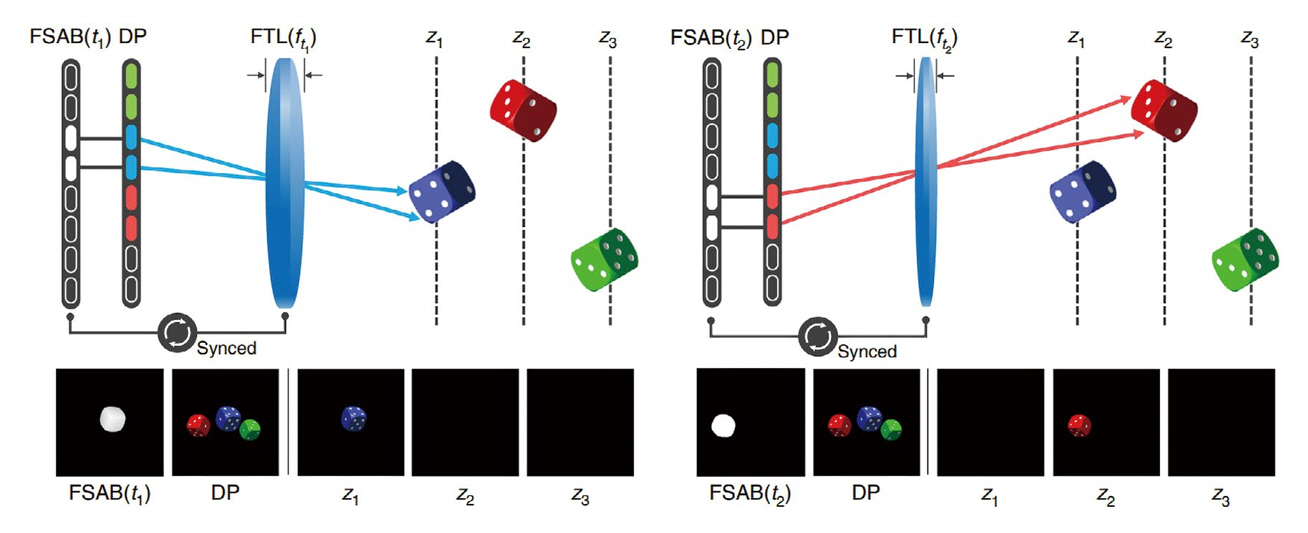

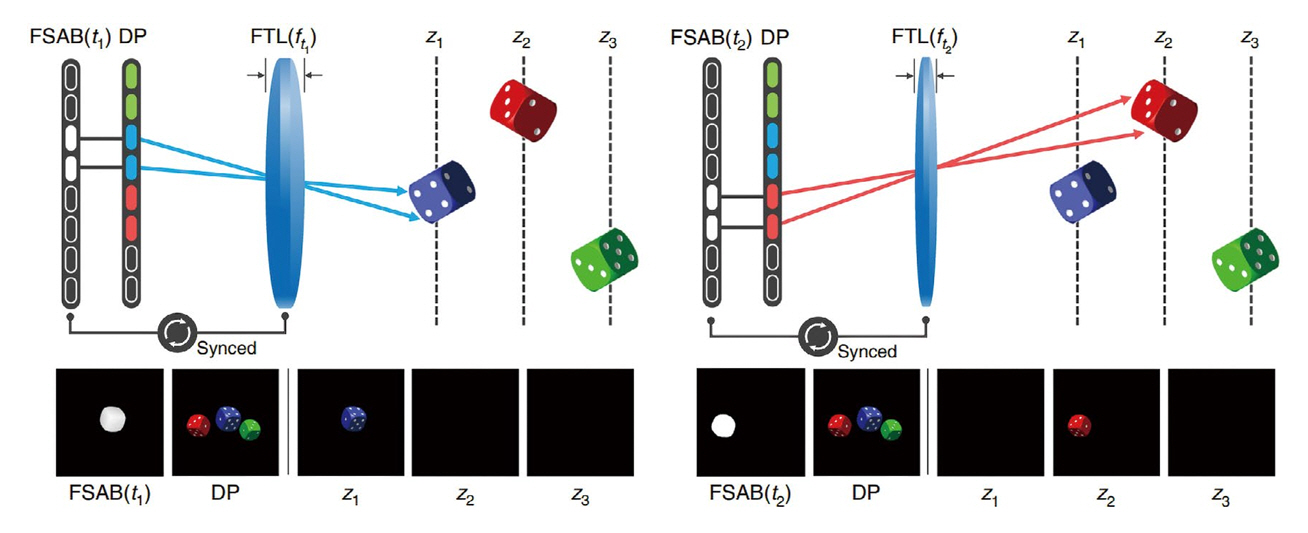

이러한 연구들의 시간 다중화 다초점 입체영상 광학계 구현 내용을 살펴보면 앞서 언급된 것과 같이 가변초점 렌즈의 구동 속도를 개선하기 위한 디스플레이-가변초점 렌즈 구동 기술에 집중되어 있다. 한 초점면에서 다른 초점면으로 구동 시 초점면이 안정화되는 데 시간이 길어 촬영된 다초점 입체영상의 이미지가 선명하지 않은 점을 해결하기 위해 초점면이 불안정한 시간 동안 디스플레이를 표시하지 않는 방법이 시도된 바 있다[11]. 이러한 방법 이외에도 초점면 간 변화가 일정하도록 렌즈 구동 파형을 최적화하거나[13], 가변초점 렌즈를 상대적으로 구동 주파수 대역폭이 낮은 삼각파로 구동하고 렌즈의 초점거리에 맞는 이미지를 실시간으로 디스플레이에 표시하여[14-16] 다초점 입체영상 이미지의 품질을 유지하면서 구현 초점면의 수를 늘리는 방식에 대한 연구도 진행되고 있다. 특히 고속으로 구동이 가능한 백라이트와 LCD 디스플레이 패널을 조합하여 초점면별 이미지를 고속으로 업데이트할 수 있도록 구성한 모듈에 VCM 방식 가변초점 렌즈를 적용한 Tomographic 근안 다초점 디스플레이의 경우 0.07dpt 해상도로 18cm~무한대 범위의 80 초점면 입체영상을 영상 프레임 주파수 60Hz로 구현한 결과가 보고되기도 하였다(그림 3 참고) [16].

Ⅳ. 입체영상 구현을 위한 영상처리 기술

1. 입체영상 구현 영상처리 기술

착용형 메타버스 디바이스에서 다초점 입체영상을 구현하기 위해서는 앞서 설명한 디스플레이와 가변초점 광학계를 조합한 다초점 입체영상 생성 모듈 기술뿐만 아니라 디스플레이에 입체영상 콘텐츠로부터 다초점 입체영상 구현에 적합한 이미지를 추출하여 표시할 수 있도록 해주는 영상처리 기술도 필요하다.

단순히 구현 초점면의 수를 늘리기보다 콘텐츠별로 사용자의 시선을 분석하여 적은 수의 초점면으로도 높은 품질의 다초점 입체영상을 구현할 수 있도록 구현 초점면을 설정하는 방법[17]이나, 초점면 사이에 존재하는 물체를 실제에 가깝게 렌더링하는 필터 관련 연구[18,19], 최적화기법을 적용한 렌더링 알고리즘[20] 관련 연구 등이 수행되고 있다. 이들 연구는 구현 초점면의 수를 제한하면서도 디스플레이에 표시되는 초점면별 이미지의 개선을 통해 현실감 높은 다초점 입체영상을 구현하기 위한 영상처리 방법을 제시하고 있으며, 부피와 연산능력이 한정된 제어시스템으로 입체영상을 구현해야 하는 착용형 디바이스의 필수 구현 기술 요소로 받아들여지고 있다. 여기에서 한발 더 나아가 다초점 입체영상 구현에 있어 사용자 눈동자의 회전 때문에 발생하는 이미지 왜곡을 실시간으로 해결하기 위한 영상처리 알고리즘에 관한 연구[21]나 입출력 파라미터 변경만으로 가변초점, 다초점, Light Field 디스플레이 방식 실시간 렌더링이 모두 가능한 콘볼루션 신경망 기반 영상처리 알고리즘[6]도 보고되고 있다.

2. MIV(MPEG Immersive Video) 표준

메타버스 디바이스 사용자에게 입체영상 시각화 서비스를 제공하기 위해서는 입체영상 생성 디바이스, 입체영상 구현 영상처리 기술에 더하여 입체영상 콘텐츠가 필요하다. 이러한 입체영상 콘텐츠를 생성, 전송, 재생하는 방식을 표준화하기 위해 ISO/IEC JTC1/SC29/WG04에서 제정한 표준이 MIV(MPEG Immersive Video)이다[22].

MIV는 다중시점 전방위 시점 영상으로부터 3D 공간상에서 중복되는 정보를 단일화하는 푸루닝(Pruning)과 영상전송 대역폭을 최소화하기 위한 패치 패킹(Patch Packing) 기능을 사용하여 영상 정보를 압축한다. 입체영상 시각화를 위해 영상 정보는 디스플레이에 표시되기 위한 이미지 정보인 텍스쳐 정보와 입체 표현을 위한 깊이 정보인 뎁스맵 정보가 각각 인코딩되어 전송될 수 있는 구조이다(그림 4 참고) [22].

이처럼 입체영상 콘텐츠의 용량을 최소화하기 위해 복잡한 영상처리 알고리즘을 사용하는 관계로 MIV 표준을 따르는 입체영상을 재생하기 위해서는 푸루닝된 원본 시점 영상을 복원하는 MIV 디코더와 분리된 패치들로부터 시청자의 시점에 해당하는 뷰포트 영상을 렌더링하는 MIV 렌더러를 통합한 플레이어의 개발이 필요하다. 이렇게 렌더링 된 뷰포트 영상은 다시 앞서 설명된 입체영상 구현 영상처리 알고리즘을 통해 적절히 처리되어 입체영상 디스플레이 모듈에 표시되어야 사용자에게 입체영상 서비스를 제공할 수 있게 된다.

Ⅴ. 최신 메타버스 디바이스 개발 동향

1. Meta社 메타버스 디바이스 개발 현황

사명을 Facebook에서 메타버스의 앞부분인 Meta로 바꿀 정도로 메타버스 기술 개발에 집중하고 있는 Meta社에서는 착용형 메타버스 디바이스를 위한 다양한 요소기술별로 연구를 진행하고 있으며 연구 결과를 Youtube 영상[23]이나 Meta Quest 블로그[24]를 통해 공개하고 있다. 이들 매체를 통해 Meta社에서는 개발된 요소기술들을 적절하게 조합하여 소비자용 및 연구용 시제품을 제작 시험함으로써 주목할 만한 메타버스 디바이스 연구 결과를 보고하고 있다. 최근에는 기존에 연구해 오던 스텝모터와 리드 스크루를 이용하여 화면을 이송하는 가변초점 방식의 입체영상 디바이스의 해상도를 인간이 거의 구별할 수 없는 60PPD(Pixel Per Degree)까지 끌어올린 시제품을 선보였다[25]. 높은 해상도를 위해 디바이스의 부피와 무게를 희생하였지만 필요하면 시장 상황에 적합하게 설계를 변경할 수 있는 점이 주목된다. 또한 메타버스 공간에서의 자연스러운 상호작용을 위해, 카메라로 촬영한 외부 환경을 사용자의 시선에 자연스럽게 제공할 수 있는 Light Field 광학계를 응용한 비디오 패스쓰루(Passthrough) 기술을 적용한 MR(Mixed Reality)을 위한 시제품[26]도 공개하였다.

2. 메타버스 시각화 관련 기술 연구 동향

최근 카네기 멜런 대학에서는 4f 광학계, SLM(Spatial Light Modulator), 그리고 split-lohmann 렌즈를 사용하여 SLM의 픽셀별로 표현 깊이를 각각 조절할 수 있어 50 초점면을 SLM의 프레임 구동 속도로 구현할 수 있는 다초점 입체 디스플레이 구조에 대한 연구결과를 발표하였다[27]. SLM의 화면 공간 선택적 특성을 이용하여 SLM과 조합한 단일 디스플레이만으로 시분할 없이 다초점 입체영상을 구현할 수 있어 구현 초점면의 수에 디스플레이의 밝기가 반비례하지 않고 높은 프레임 주파수의 구현이 가능한 획기적인 디스플레이 구조이다. 하지만 구현에 사용된 4f 광학계의 특성상 착용형 디바이스로 만들기 위해 부피를 최소화하기 어려운 단점이 있다.

일본의 쓰쿠바 대학에서는 렌즈 어레이와 Transmissive Mirror Device를 이용하여 Light Field 방식으로 가상 물체의 표현이 가능한 See-Through 디스플레이 및 렌더링 방법[28]을 공개하였고, 서울대학교에서는 렌즈 어레이와 팬케이크 광학계를 조합하여 8.8mm 두께의 얇은 VR(Virtual Reality) 시제품[29]을 선보였다. 이러한 연구 결과들은 마이크로 디스플레이와 마이크로 렌즈 어레이를 통합하여 메타버스 디바이스에 적용할 수 있는 가능성을 보여 주고 있다.

다초점 입체영상 생성을 위한 주요 부품인 가변초점 렌즈와 거울을 박막 유리와 압전(Piezoelectric) 액추에이터를 이용하여 구현, 부품 외경 대비 CA(Clear Aperture) 비율과 응답속도를 높이는 연구[30-32]도 진행되고 있다. Piezo-Glass-Piezo 샌드위치 구조의 가변초점 렌즈를 제작, 외경(9mm) 대비 CA(7.6mm) 비율 최대 84%, 초점 가변 응답시간 100~150μsec를 달성[31]하여 다초점 입체영상 구현 속도 및 영상 품질 개선에 적용이 가능할 것으로 기대된다. 하지만 이러한 구조의 가변초점 렌즈도 아이 박스(Eye Box)와 아이 릴리프(Eye Relief)의 확보를 위해 CA를 확대하여 제작할 때 기존 상용 가변초점 렌즈 대비 구동 속도가 어느 정도로 개선될지 검증이 필요하다.

가변초점 렌즈의 구동 속도를 개선하고 안정적인 광학 특성을 확보하기 위해 구동 파형을 동적 모델을 통해 최적화[33]하거나 실시간 렌즈 구동 시에 휴리스틱 알고리즘을 적용하여 최적 구동 파형을 생성하는 연구[34]도 진행되고 있다.

Ⅵ. 결론

초고해상도 마이크로 디스플레이와 실시간 영상 처리 기술을 중심으로 구현되어 출시되고 있는 최근의 착용형 메타버스 디바이스들은 사용자에게 불편감을 유발하는 가장 큰 원인이었던 MTP Latency를 실시간 영상처리 전용 칩셋을 적용함으로써 상당 부분 해결하여 새로운 가상 컴퓨팅 사용자 인터페이스로 기대받고 있다.

하지만 이러한 착용형 메타버스 디바이스의 현실감이나 몰입감을 더욱 높이기 위해서는 입체영상 표현에 있어 눈동자의 수렴 초점 불일치 문제를 해결해야 하며, 이를 위해 가변초점, 다초점, Light Field 디스플레이 방식으로 입체영상을 구현하는 연구가 진행되고 있다. 본고를 통해 다초점 입체영상 구현 기술을 중심으로 관련 연구 동향을 논의하였고, 단순히 마이크로 디스플레이와 광학계를 조합한 입체영상 렌더링 모듈 기술뿐만 아니라 입체영상 서비스를 위한 콘텐츠 표준화 기술, 그리고 이러한 콘텐츠를 입체영상 렌더링 모듈이 입체영상을 구현할 수 있도록 실시간으로 처리해주는 영상처리 기술까지 성공적으로 통합되어야 높은 몰입감을 제공할 수 있는 메타버스 시각화 서비스를 제공할 수 있음을 확인할 수 있었다. 최근에는 이러한 요소기술들이 점차 성숙되고 있어 이들을 효과적으로 통합하여 높은 몰입감으로 새로운 경험을 제공할 수 있는 초실감 메타버스 디바이스 및 서비스가 가까운 미래에 출현할 수 있기를 기대해 본다.

약어 정리

Computerworld, 2024 Will Be A Big Year For AR/VR, But Mainstream Adoption Will Lag, 2024, https://www.computerworld.com/article/3712164/2024-will-be-a-big-year-for-ar-vr-but-mainstream-adoption-will-lag.html

T. Shibata et al., "The zone of comport: Predicting visual discomfort with stereo displays," J. Vis., vol. 11, no. 8, 2011.

Wikipedia, Vergence-Accommodation Conflict, Sept. 2022, https://en.wikipedia.org/wiki/Vergence-accommodation_conflict

Y. Ryu and E. Ryu, "Overview of motion-to-photon latency reduction for mitigating VR sickness," KSII TIIS, vol. 15, no. 7, 2021, pp. 2531-2546.

Magic Leap 2 Overview, Distance to View Digital Content, https://www.magicleap.com/magic-leap-2

L. Xiao et al., "DeepFocus: Learned image synthesis for computational display," ACM Trans. Graph., vol. 37, no. 6, 2018.

J. March et al., "Impact of correct and simulated focus cues on perceived realism," in Proc. SA, (Daegu, Rep. of Korea), Nov. 2022, pp. 1-9.

S. Suyama et al., "Three-dimensional display system with dual-frequency liquid-crystal varifocal lens," Jpn. J. Appl. Phys., vol. 39, 2000, pp. 480-484.

S. Liu, D. Cheng, and H. Hua, "An optical see-through head mounted display with addressable focal planes," in Proc. IEEE Int. Symp. Mixed Augmented Reality, (Cambridge, UK), Sept. 2008, pp. 33-42.

S. Liu and H. Hua, "Time-multiplexed dual-focal plane head-mounted display with a liquid lens," Opt. Lett., vol. 34, no. 11, 2009, pp. 1642-1644.

S. Liu et al., "A novel prototype for an optical see-through head-mounted display with addressable focus cues," IEEE Trans. Vis. Comput. Graph., vol. 16, no. 3, 2009, pp. 381-393.

P. Llull et al., "Design and optimization of a near-eye multifocal display system for augmented reality," Imaging Appl. Opt., 2015, article no. JTH3A.5.

J.H.R. Chang et al., "Towards multifocal displays with dense focal stacks," ACM Trans. Graph., vol. 37, no. 6, 2018.

K. Rathinavel et al., "An extended depth-at-field volumetric near-eye augmented reality display," IEEE Trans. Vis. Comput. Graph., vol. 24, no. 11, 2018, pp. 2857-2866.

W. Wu et al., "Content-adaptive focus configuration for near-eye multi-focal displays," in Proc. ICME, (Seattle, WA, USA), Jul. 2016.

S. Liu and H. Hua, "A systematic method for designing depth-fused multi-focal plane three-dimensional displays," Opt. Express., vol. 18, no. 11, 2010, pp. 11562-11573.

S. Ravikumar et al., "Creating effective focus cues in multi-plane 3D displays," Opt. Express., vol. 19, no. 21, 2011, pp. 20940-20952.

R. Narain et al., "Optimal presentation of imagery with focus cues on multi-plane displays," ACM Trans. Graph., vol. 34, no. 4, 2015.

O. Mercier et al., "Fast gaze-contingent optimal decompositions for multifocal displays," ACM Trans. Graph., vol. 36, no. 6, 2017.

J.M. Boyce et al., "MPEG immersive video coding standard," Proc. IEEE, vol. 109, no. 9, 2021, pp. 1521-1536.

Y. Zhao et al., "Retinal-resolution varifocal VR," in Proc. SIGGRAPH, (Los Angeles, CA, USA), Aug. 2023, pp. 1-3.

G. Kuo et al., "Perspective-correct VR passthrough without reprojection," in Proc. SIGGRAPH, (Los Angeles, CA, USA), Aug. 2023, pp. 1-9.

K. Otao et al., "Light field blender: Designing optics and rendering methods for see-through and aerial near-eye display," in Proc. SA, (Bangkok, Thailand), Nov. 2017, pp. 1-4.

K. Bang et al., "Lenslet VR: Thin, flat and wide-FOV virtual reality display using fresnel lens and lenslet array," IEEE Trans. Vis. Comput. Graph., vol. 27, no. 5, 2021, pp. 2545-2554.

M.C. Wapler and U. Wallrabe, "Ultra-fast and compact varifocal lens," in Proc. MEMS, (Seoul, Rep. of Korea), Jan. 2019.

M.C. Wapler, "Ultra-fast, high-quality and highly compact varifocal lens with spherical aberration correction and low power consumption," Opt. Express, vol. 28, no. 4, 2020, pp. 4973-4987.

M.C. Wapler et al., "Aspherical high-speed varifocal mirror for miniature catadioptric objectives," Opt. Express, vol. 26, no. 5, 2018, pp. 6090-6102.

D. Iwai et al., "Speeded-up focus control of electrically tunable lens by sparse optimization," Sci. Rep., vol. 9, no. 1, 2019.

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.