Advanced Air Mobility를 위한 영상 기반 위치 추정 및 Geo-Referencing 기술 동향

A Survey on Vision-based Localization and Geo-Referencing Technology for Advanced Air Mobility

- 저자

-

최의환모빌리티인프라연구실 uhchoi@etri.re.kr 이대규모빌리티인프라연구실 lee.dk@etri.re.kr 위현중모빌리티인프라연구실 wjh4877@etri.re.kr 주인학모빌리티인프라연구실 ihjoo@etri.re.kr 장인성모빌리티인프라연구실 e4dol2@etri.re.kr

- 권호

- 39권 4호 (통권 209)

- 논문구분

- 지능형 미래사회를 위한 디지털 융합기술 전망

- 페이지

- 1-9

- 발행일자

- 2024.08.01

- DOI

- 10.22648/ETRI.2024.J.390401

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.

본 저작물은 공공누리 제4유형: 출처표시 + 상업적이용금지 + 변경금지 조건에 따라 이용할 수 있습니다.- 초록

- As Advanced Air Mobility (AAM) technologies evolve, ensuring accurate navigation and localization in complex urban airspaces has become crucial. Because the Global Navigation Satellite System (GNSS) is prone to vulnerabilities in urban flight environment, an alternative localization technique is required. This paper examines vision-based localization technologies to enhance GNSS-free navigation. In addition, we explore various geo-referencing studies that utilize pre-existing spatial databases to improve the accuracy of vision-based localization under GNSS-denied conditions. This paper discusses the various types of onboard vision camera sensors, vision-based localization, spatial information databases, feature extraction methods, and matching techniques that contribute to the development of a vision-based localization and geo-referencing system for AAM, ensuring safety and reliability in urban operations.

Share

Ⅰ. 서론

도심 상공의 차세대 이동 수단인 UAM(Urban Air Mobility) 및 도시 간 이동 개념으로 확장된 AAM(Advanced Air Mobility) 등 에어모빌리티 기술의 상용화가 미국, 유럽 등 eVTOL(electric Vertical Take-Off and Landing) 기체 제작 선진국을 중심으로 빠르게 현실화되고 있다. 한국 역시 K-UAM(한국형 도심항공모빌리티) 기술로드맵(2021) 발간 및 K-UAM Grand Challenge 등에 맞추어 2025년도에 K-UAM 상용화를 목표로 하고 있다. 도심지 에어모빌리티 안전 운용을 위해서 다양한 핵심 기술이 필요하며, 가장 중요한 기술 중 하나는 항법/측위 기술이다.

드론/무인항공기 분야와 마찬가지로 AAM에서의 항법 기능을 위한 가장 기본적인 센서는 GNSS(Global Navigation Satellite System)와 INS(Inertial Navigation System)가 있다[1]. 그러나 AAM의 항법 기능이 도심환경에서 끊김 없이(Seamless) 이루어지기 위해서는 GNSS 신호의 세기 감소로 인한 GNSS 기능 저하 또는 불능과 같은 상황에 대한 대처방안이 필요하다. 복잡한 도심 환경 비행 시 GNSS 신호가 불안정한 상황은 높은 건물, 복잡한 지형, 전파간섭, 외부 구조물에 의한 신호 차단 등으로 인해 발생한다. 고고도 운항 중에도 우주 날씨 등의 영향으로 GNSS 항법 오차가 발생할 수 있다. 또한, 2010년 이후 약 2,100여 대의 항공기가 GNSS 교란 피해 사례가 있음(국회교통위원회, 2020)[2]을 고려할 때 AAM 비행체도 GNSS 재밍(Jamming) 등 교란 위협이 있다.

이러한 GNSS 불능 상황(위성항법오차, 교란 등) 대응을 위한 다양한 보조 항법 기술이 개발되고 있으며, 특히 영상 기반 위치 추정 기술이 많은 주목을 받고 있다. 항공 분야에서 항공기의 조종사가 항공기 자체 계기를 참조하는 계기비행(IFR: Instrument Flight Rules)과 항공기 외부의 상황을 조종사가 직접 보고 조종하는 시계비행(VFR: Visual Flight Rules)을 병행하듯, AAM의 경우도 GNSS 불능 시 비상 상황 대응을 위한 영상 기반의 위치 추정 기술이 요구된다. 이를 위해 AAM 기체에 카메라와 레이더 등을 설치하여 센서 융합하여 주변 상황 탐지 및 항법 기능에 활용하고 있는 연구가 수행되고 있다[3,4].

하지만 영상정보에만 의존한 측위 기술은 장시간 사용 시 항법 오차 누적의 문제가 발생할 수 있기 때문에[5] 지리 참조된 데이터베이스(Geo-Referenced DB)와 연계하여 비행체 절대 위치를 추정(Absolute Localization)[6]하는 Geo-Referencing 기술에 대한 필요성이 증가하고 있다. 특히 AAM 비행체는 도심 공역에서 비행하므로, 비행영상 속에 수많은 도심 공간정보 객체들(건물, 도로 등)이 촬영되며, 이를 정밀도심 공간정보와 결합하면 보다 효율적인 위치 추정이 가능할 것으로 기대된다.

본고에서는 GNSS 불능 시 보조 항법에 활용하기 위한 영상 기반 위치 추정 기술 및 공간정보 연계 Geo-Referencing 기술을 서술한다. 이를 위해 비행체 측위에 활용 가능한 공간정보 유형, 매칭/정합 기술, 관련 연구사례들 및 향후 방향성을 논의한다.

Ⅱ. 기술동향

본 장에서는 AAM 비행체에서 활용 가능한 영상 기반 위치 추정 기술을 소개하고, 이어 절대 측위 성능을 개선하기 위한 공간정보 연계 Geo-Referencing 기술을 서술한다.

1. 영상 기반 위치 추정 기술

AAM 비행체 온보드 비행영상을 토대로 위치 추정 시, 적절한 영상 센서를 선정하는 것이 중요하다. 본 절에서는 영상센서 종류, 장단점 및 센서 융합 가능성을 살펴본다.

가. 영상 센서 종류

1) RGB 카메라

RGB 카메라에는 단안(Monocular) 카메라, RGB-D(Depth) 카메라 및 스테레오(Stereo) 카메라 등이 있으며, 각각의 카메라는 이미지를 획득하고 처리하는 방식에서 차이가 있다.

• 단안 카메라: 가장 전통적인 형태의 카메라로, 이미지를 2D로 투영하여 깊이정보를 추정한다. 그러나 이 방식은 깊이 추정의 정확성에 한계가 있다.

• RGB-D 카메라: RGB 이미지 데이터와 함께 깊이정보를 제공하는 적외선/레이저 센서를 결합하여 사용한다. 이러한 카메라는 단안 카메라보다 향상된 깊이정보를 제공하지만, Microsoft Kinect는 약 6m, Intel Realsense D455는 최대 20m까지의 거리를 추정할 수 있어 AAM과 같은 높은 고도에서 사용하기에는 제한적이다.

• 스테레오 카메라: 두 대의 카메라를 사용하여 각각의 2D 이미지로부터 깊이정보를 추출한다. 이 시스템은 두 이미지 사이의 차이점을 찾아내고 삼각측량과 유클리드 기하학을 이용하여 깊이를 계산한다. 그러나 스테레오 카메라의 카메라 간격이 너무 좁은 경우, AAM이 운용되는 300~600m 고도에서는 설치된 카메라의 간격이 추정해야 할 깊이에 비해 너무 짧아 단안 카메라와 비슷한 한계를 보일 수 있다.

2) EO/IR 카메라

EO/IR 카메라는 전기적 및 광학적 수단을 사용하여 이미지를 획득하는 센서로, EO/IR 카메라로 획득된 이미지는 별도의 추가 처리 과정 없이도 사람이 이해하기 쉬운 형태로 정보를 제공한다. 따라서 기존 RGB 데이터를 처리하는 다양한 알고리즘에도 약간의 수정을 통해 적용 및 직관적인 피드백이 가능하다는 장점이 있다. 그러나 EO/IR 센서는 DVE(Degraded Visual Environment) 상황에 가장 민감한 센서 기술 중 하나로 어둠, 먼지, 연기 또는 강수 등의 환경에서 성능이 저하될 수 있다.

3) 카메라와 LiDAR 센서 융합

자율주행 차량/모바일 로봇에서는 카메라와 함께 LiDAR 센서를 병행하여 센서융합 및 위치 추정하는 경우가 많다. 하지만 최근 출시되는 Velodyne, Ouster 등 제품군의 최대 인식 거리는 약 250~400m로, AAM의 항로(En-route) 비행고도인 300~600m 환경에서는 사용의 제한점이 있다. 한편 가까운 미래에 LiDAR 센서의 기술력이 발전하여 인식 거리가 300~600m까지 충분한 점군(Point Cloud) 데이터 획득이 가능하다면 이를 바탕으로 LiDAR를 활용한 정밀 항법 시스템을 운용하여 LiDAR, 카메라, GNSS 등을 활용한 Multi-Modal 센서 기반의 강건한 항법 시스템[7]을 구현할 수 있을 것으로 기대된다.

나. Visual Odometry 기술

Odometry란 로봇이나 다른 이동식 장치가 상대적으로 얼마나 이동했는지를 추정하는 기술을 의미한다. 이 기술은 주로 로봇이나 자동차와 같은 이동 수단에서 사용되며, 차량에 부착된 바퀴의 회전수와 조향각을 통해서 이들이 얼마나 먼 거리를 이동했고 어느 방향으로 움직였는지를 추정하는 기술이다.

Visual Odometry(VO)는 영상 기반의 Odometry 기술로써 카메라로 취득한 연속적인 이미지 정보를 활용하여 차량/비행체의 위치 변화량을 누적 및 계산하여 현재 위치를 추정하는 기술이다[8]. 이 기술은 위성 항법이 불가한 화성에서 NASA 탐사 로봇이 2004년에 적용[9]되었으며 이러한 영상을 활용한 위치 추정 기술은 GNSS/INS의 한계점을 극복하기 위한 용도로 로보틱스, 자율 주행, 드론 분야에서 꾸준히 활용되고 있는 기술이다[10].

그러나 고속으로 비행하는 AAM의 경우 영상정보만을 활용하여 위치를 추정하는 데 있어 큰 오차가 발생할 수 있다. 이를 보완하기 위해 센서의 주기가 빠르고 자세정보를 획득할 수 있는 관성 센서인 IMU(Inertial Measurement Unit)를 영상정보와 융합한 Visual Inertial Odometry(VIO) 연구가 활발히 진행 중이다[11]. VIO는 VO로 추정하는 연속적인 위치 사이 간격을 관성 센서의 자세정보를 활용해 예측 및 누적하여 오차를 줄일 수 있다는 장점이 있다.

따라서 VIO를 활용해 영상 기반의 위치 변화량 계산을 통해 GNSS를 통해 계산된 위치 변화량과 비교하여 GNSS의 불능 상황을 판단하고 이를 기반으로 위치 변화량을 정밀하게 추정함으로써 GNSS에 의존하지 않고 AAM의 위치 추정 정확도를 지속적으로 유지할 수 있다.

한편 VO 또는 VIO를 통해 추정한 위치정보를 활용하여 각 위치에서 취득한 영상정보 또는 특징점을 누적함으로써 비행 경로에 대한 지도를 생성할 수 있다. 이 과정을 Visual SLAM(Simultaneous Localization And Mapping)이라 한다[12,13]. 특히, 지도 생성 과정에서 동일한 장소를 재방문하는 경우 지도에 저장된 특징점 및 위치정보의 유사도를 판단하여 VO 또는 VIO 과정에서 발생한 오차를 보정하는 Loop Closing 알고리즘을 활용해 위치를 보정하여 누적된 오차를 줄일 수 있다. 이러한 기술은 AAM과 같이 동일한 항로를 반복해서 비행하는 응용 사례에서 영상 기반 위치 추정 기술의 오차를 점차 줄이는 데 활용될 수 있다.

다. Visual Servoing 기술

비주얼 서보잉(Visual Servoing)이란 영상 이미지를 이용해 시스템의 위치나 자세 등의 정보를 추출하고, 이를 피드백으로 활용하여 시스템을 제어하는 기술이다. AAM의 경우 도심 환경에서의 이착륙을 위한 정거장인 버티포트(Vertiport)를 통해 탑승 및 하차할 수 있는데, 이러한 버티포트에는 헬기 이착륙장에 설치된 H 마커와 같이 국제 표준의 버티포트 마커가 존재한다. 이러한 마커 형태의 상징물(Landmark)을 활용하여 버티포트 근처에서는 상대적인 위치를 추정하는 Visual Servoing 기술을 활용할 수 있다[14,15].

2. Geo-Referencing 기술 동향

하지만 앞서 언급된 VO, VIO 등 영상 기반의 위치 추정 기법만으로 장시간 위치 변화량을 예측하는 경우, 오차가 누적되는 누적 오차(Drift) 현상이 발생한다. 장시간, 장거리, 고속비행하는 AAM 비행체 특성을 고려했을 때 이런 누적 오차는 GNSS 불능 상황 대응에 한계를 가져올 가능성이 높다. GNSS 불능 시 영상 기반 위치 추정 기술의 누적 오차 문제를 해결하기 위해 비행체의 절대 위치 추정치를 산출하는 추가적인 기술이 필요하다.

이를 위해 사전 구축된 공간정보를 활용한 Geo-Referencing 연구가 수행되고 있다. 비행체 영상 기반 위치 추정 관점에서의 Geo-Referencing 기술은 현재 촬영된 비행영상을 지리 참조된(Geo-Referenced) 공간정보와 대조하여, 현재 비행체의 위치 및 자세를 추정하는 기술을 의미한다.

비행체 영상 기반 위치 추정 관점에서의 Geo-Referencing 기술은 다음의 세부 기술 요소를 포함한다.

• 특징 추출(Feature Extraction): 비행체 온보드 카메라 영상에서 점(Point), 선(Edge), 텍스처, 패턴 등 해당 영상 고유의 유의미한 특징을 추출한다.

• 특징 매칭(Feature Matching): 추출된 영상 특징들을 기구축된 참조용 공간정보의 특징들과 비교, 매칭 및 정합한다.

• 위치 및 자세 추정(Localization, Pose Estimation): 특징 매칭 결과를 토대로 해당 비행영상과 참조용 공간정보가 정합되는 비행체 위치 및 자세를 추정한다.

가. Geo-Referencing을 위한 공간정보

기존 항공기 및 드론 분야에서 영상 기반 위치 추정 목적으로 전통적으로 활용하는 참조용 공간정보로는 수치 표고 모델(DEM), 위성사진, 항공사진이 있다. 이들은 획득이 용이하고 사용자가 비교적 쉽게 활용 가능하다는 장점이 있어 많은 연구가 진행된 바가 있다[5].

그러나 비행영상과 지형/2D지도를 단순 직접 매칭하는 경우, 특징 추출 및 정합 과정에서의 성공률과 수렴률에 대한 안정성을 보장하기 어렵다.

도심 환경에서 비행하는 AAM 비행체의 경우, 비행영상 내의 상당 부분이 도심 객체(건물, 도로 등)로 구성되어 있어, 의미론적(Semantic) 또는 시불변적(Time-invariant) 공간정보를 특징으로 활용할 경우 측위 및 Geo-Referencing을 위한 정합 성공률과 안정성을 높일 수 있다. 의미론적 또는 시불변적 특징을 가지는 공간정보로는 3차원 건물 모델 정보, 토지피복도 등이 있다(그림 1).

그림 1

Geo-Referencing을 위한 공간정보 DB 유형 및 예시: (a) 위성사진/항공사진, (b) 수치 표고 모델(DEM), (c) 3차원 건물 모델, (d) 토지피복도

수치 표고 모델, 위성사진, 항공사진, 3차원 건물 모델, 토지피복도 등 다양한 공간정보는 개방형 공간정보 플랫폼으로부터 얻을 수 있으며, 대표적으로 OpenStreetMap[16], VWorld[17] 등이 있다.

• 위성사진/항공사진

위성사진은 인공위성을 이용하여 지표면을 촬영한 이미지이다. 국토의 체계적인 이용 및 관리에 활용하기 위한 공간정보이며, 0.5~2m 급의 해상도로 촬영된다.

항공사진은 카메라가 탑재된 항공기로 지상을 중복으로 촬영하여 지표면상에 나타난 객체를 표현한 이미지이다. 12~25cm 급의 해상도로 촬영된다.

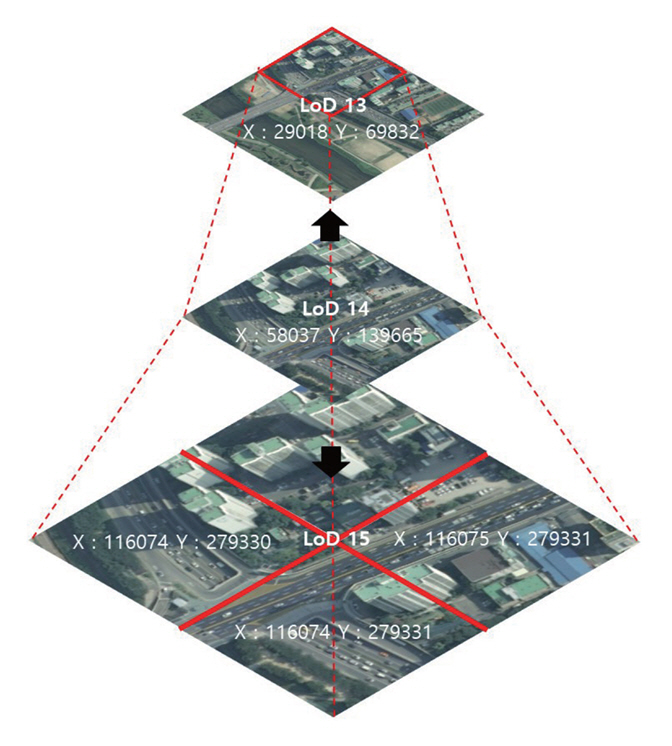

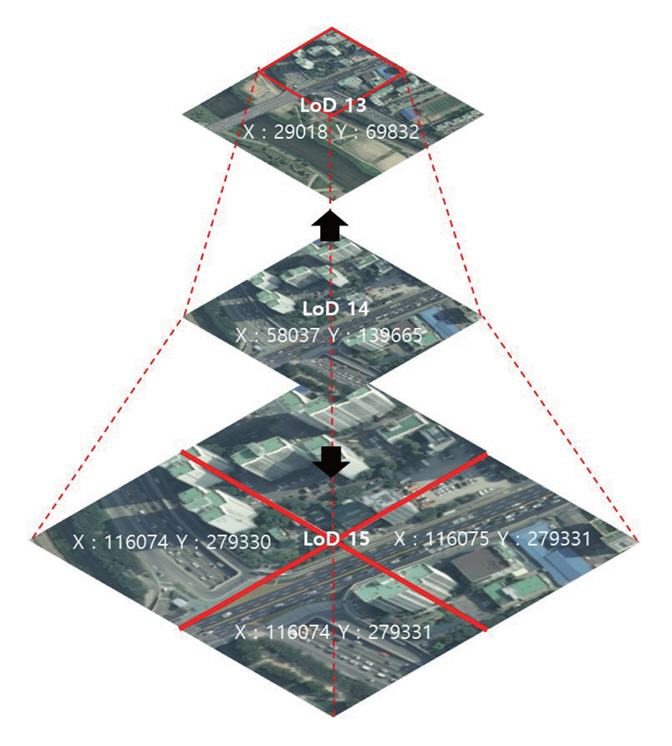

위성사진/항공사진은 공간 영역을 분할한 타일 체계로 관리되며, Level of Detail(LoD)을 표현할 수 있다(그림 2).

• 수치 표고 모델(DEM)

수치 표고 모델(DEM: Digital Elevation Model)은 지표면의 고도 값을 일정 간격의 타일 형태로 기록한 공간정보로, 위성사진/항공사진 등을 입체화한 지형 모델이다. 한국의 경우 1/5,000 수치지도를 이용하여 한반도 전역으로 구축되어 있다.

• 3차원 건물 모델

3차원 건물 모델은 현실 건물을 디지털 공간에서 활용할 수 있도록 3차원 메쉬(Mesh)로 모델링된 데이터이다[20]. 3차원 건물 모델은 형태를 정의하는 메쉬 정보와 건물의 주소 등 속성정보를 가지고 있고, 위도/경도 등 위치정보를 포함한다.

• 토지피복도

토지피복도(Land Cover Map)는 지구표면 지형지물의 분포 형태를 일정 기준에 따라 분류하여 동일한 특성을 가진 지표면을 색상 인덱싱을 하여 지도 형태로 표현하는 공간정보이다. 토지피복도는 의미론적이고 시불변적인 지형지물 속성을 분석하는 데 활용도가 높다. 표 1[21]은 환경부에서 지정한 토지피복도의 분류체계이다.

표 1 토지피복도 분류체계

| 유형 | 색상 | 종류 |

|---|---|---|

| 시가화 | 주거, 공업, 상업, 교통 | |

| 농업지역 | 논, 밭, 과수원, 재배지 | |

| 산림지역 | 활엽수림, 침엽수림 | |

| 초지 | 자연초지, 인공초지 | |

| 습지 | 내륙습지, 연안습지 | |

| 나지 | 자연나지, 인공나지 | |

| 수역 | 내륙수, 해양수 |

나. Geo-Referencing을 위한 영상 내 특징 추출 및 정합 기술

앞서 설명한 바와 같이, 공간정보는 이미지 데이터, 벡터 데이터, 수치, 3차원 메시(Mesh), 점군(Point Cloud) 데이터 등 다양한 형태로 표현될 수 있다. 이러한 다양한 공간정보 데이터는 영상 데이터와 직접적으로 또는 변형을 거쳐 매칭/정합에 활용될 수 있다. 한편 LiDAR나 레이더에서 취득된 3차원 데이터를 기존 지도정보와 매칭하는 연구도 활발히 진행 중이다[22]. 이처럼 어떠한 센서 데이터와 어떠한 공간정보 데이터 유형을 서로 정합하는지에 따라 다양한 형태의 매칭 기술 연구가 가능하다. 본고에서는 이미지 형태로 변환된 공간정보와 이미지 형태로 촬영되는 실시간 비행영상을 매칭하는 기술(Image-to-Image)을 중점적으로 서술한다.

Image-to-Image 매칭 기술은 카메라 촬영 영상과 사전에 구축된 지도정보 간 이미지 매칭[23]을 통해 비행체의 절대 위치를 추정하는 기술이다(표 2). Image-to-Image 매칭을 위해 고전적인 특징점 추출 방법[24]을 주로 활용해 왔으나, 최근 제안되고 있는 학습 기반의 특징점 추출 및 매칭 기법을 활용할 수 있으며, 대표적으로 SuperGlue[25], DeDoDe[26] 등이 있다.

표 2 Image-to-Image 특징 추출 및 매칭

| 유형 | 설명 | 주요 예시 |

|---|---|---|

| 고전적 특징점 매칭 | 비행영상의 특징점과 참조용 DB 영상의 특징점을 매칭 | • SIFT |

| • ORB | ||

| • SURF | ||

| 딥러닝/학습 기반 | 영상 내 특징 추출, 매칭, 정합 과정에 딥러닝 기술 활용 | • SuperGlue |

| • DeDoDe |

한편, 학습을 통해 추출된 특징점들을 DB에 저장하고, 이를 활용해 저장된 데이터 내에서 빠르게 특징점을 검색하여, 방대한 지도정보 속에서 카메라 이미지와의 대조를 수행하는 기술[27]에 대한 연구가 수행되고 있다. 이 방법은 특히 대규모의 공간정보를 신속하게 처리할 필요가 있는 상황에 유용하다.

하지만 사전에 구축된 지도를 변화하는 환경에 맞게 지속적으로 업데이트 및 관리하는 방법에 대한 연구가 필요하다. 또한, AAM의 온보드 환경에서 이미지 형태로 구축된 방대한 데이터베이스를 효율적으로 관리 및 접근하여 실시간으로 위치를 추정하는 기술에 대한 추가적인 연구가 요구되며, 유사도 검색 라이브러리 연구[28] 등을 참고한 연구가 필요하다.

다. 비행영상 내 의미론적/시불변적 특징

비행영상과 참조용 공간정보 간 정합 성공률을 높이기 위해서는 영상 내의 어떠한 특징을 비교하여 매칭할 것인지를 선정하는 것이 중요하다. 비행영상은 촬영 카메라 센서 제원, 촬영 고도, 촬영 시간, 촬영 각도, 해상도, 날씨, 지상 환경의 변화, 지상 구조물 변경 등 많은 요인에 의해 공간정보와의 차이가 크게 발생할 수 있다. 이는 특징 추출 및 매칭 성능을 감소시켜 위치 추정 및 Geo-Referencing의 안정성이 저하되는 원인이 된다.

따라서 단순 특징점 매칭 방식보다는, 의미론적이고 시불변적인 특징을 추출하여 비교하는 것이 정합 성공률과 절대 위치 추정 안정성을 높이기 위해 필요하다. 비행영상 내에서 의미론적/시불변적 공간정보를 추출하여 매칭에 활용한 다양한 기존 연구 사례들이 있다[29-37]. 이들 연구에서는 건물, 도로, 교차로, 산악 지형 배수 패턴, 잔디, 나무, 도심 랜드마크, 강변 등 다양한 의미론적/시불변적 공간정보를 활용하였으며, 이들을 정리하면 표 3과 같다.

표 3 비행영상 내 의미론적/시불변적 공간정보 추출 및 정합 연구 사례

| 문헌 | 특징 매칭용 공간정보 | 주요 내용 |

|---|---|---|

| [29] | 건물, 도로, 배경 등 | cGAN을 이용한 segmentation 수행, 템플릿 매칭 정합 |

| [30] | 도로 교차로 정보 | 이진 영상에 대한 필터링으로 도로 추출 |

| [31] | 산악 지형 배수 (Drainage) 패턴 | Wave transform 등 이용 특징 추출 |

| [32] | 잔디, 나무, 도로, 건물 등 | SURF, ORB로 특징점 추출, Particle Filter 기반 정합 |

| [33] | 도심 랜드마크 | Exact Histogram Matching 이용 랜드마크 추출 |

| [34] | 건물 정보(면적, 반경, 위치 등) | U-Net 활용 건물 특징 추출 |

| [35] | Aut oencoder로 임베딩된 잠재 특징 (Latent Feature) | 인코딩된 참조용 위성지도 활용 Image registration 수행 |

| [36] | 도로, 강 | U-Net 활용 추출, SIFT로 정합 |

| [37-39] | 건물, 도로 등 | VWorld 지리 데이터셋 학습 신경망 기반 의미론적 분할 |

비행영상 및 공간정보를 활용한 Image-to-Image 매칭 시, 영상정보 속에 존재하는 동적인 객체들(예: 차량, 보행자 등)로 인해 발생할 수 있는 오차를 줄여 나가야 한다. 기체가 비행함과 동시에 영상에 존재하는 다양한 동적 객체의 위치 변화로 인해 매칭 오차가 발생할 가능성이 있다. 따라서 영상 내 동적 객체의 정보를 식별하고 이를 영상 기반 위치 추정 알고리즘에서 제외함으로써 매칭 오차를 최소화하는 연구가 필요하다. 특히 도심환경에서의 높은 운항 고도(최대 고도 600m)에서 고속비행(100km/h 이상)하는 AAM 비행영상의 경우, 이러한 도심 고고도/고속비행 데이터에 특화된 특징점 인식 및 매칭 기법에 대한 연구 개발이 필요하다. 또한, AAM 획득 비행영상/공간정보를 활용하고 융합하는 딥러닝/AI 기반 측위 기술 개발이 필요하며, AAM에 탑재되는 임베디드/온보드 연산 환경에서의 실시간 절대 측위 솔루션의 최적화 및 경량화가 필요하다. 보다 구체적으로는 공간정보에 따른 연산 리소스 최적화가 필요하며, 대량의 공간정보 이미지 저장 및 관리 기술 확보가 필요하다. 또한, 공간정보 탐색 방식의 효율화가 필요하다.

Ⅲ. 결론

본고에서는 AAM 비행체의 안전 운용을 위해 GNSS 불능 상황 시 활용 가능한 비행영상 기반의 위치 추정 기술 및 Geo-Referencing 기술에 대한 기술 동향을 서술하였다. 비행체 카메라 영상에 대한 Odometry 기반 위치 추정 기술과 비행영상-공간정보 간 매칭 기술 전반에 대한 분석을 제시하였다. 이를 토대로 AAM을 위한 영상 기반 위치 추정 및 Geo-Referencing 기술에 대한 후속 연구 필요성을 논의하였다.

용어해설

Advanced Air Mobility 도심에서 이용할 수 있는 항공 교통 수단인 도심항공모빌리티(UAM: Urban Air Mobility)의 상위 개념으로, 도심을 비롯해 지역(Regional) 거점 간 이동까지 포함하는 에어모빌리티 개념

Visual (Inertial) Odometry Odometry란 로봇이나 다른 이동식 장치가 얼마나 이동했는지를 추정하는 기술을 의미하며 Visual Odometry 기술은 카메라로 취득한 연속적인 이미지 정보를 활용하여 차량/비행체의 위치 변화량을 누적 및 계산하여 현재 위치를 추정하는 기술. 이때 정확도를 향상하기 위해 회전/가속도의 관성 정보(Inertial)를 활용

Geo-Referencing Geo-Referencing이란 실제 세계에서 센싱한 정보와 기 구축된 지리 참조(Geo-Referenced) 공간정보를 매핑 및 탐색하는 기술을 의미. 실제 세계에서 센싱한 정보를 공간정보(위치정보, 속성정보, 형태정보 등)와 매핑하여 센싱한 장소의 공간 특성을 획득

약어 정리

AAM

Advanced Air Mobility

DEM

Digital Elevation Model

DVE

Degraded Visual Environment

EO/IR

Electro-Optical/Infra-Red

eVTOL

electric Vertical Take-off and Landing

GNSS

Global Navigation Satellite System

LiDAR

Light Detection And Ranging

SLAM

Simultaneous Localization And Mapping

UAM

Urban Air Mobility

V. Stepanyan et al., "Adaptive multi-sensor information fusion for autonomous urban air mobility operations," in Proc. AIAA Scitech Forum, (Virtual Event), Jan. 2021.

C.A. Ippolito et al., "Concepts for distributed sensing and collaborative airspace autonomy in advanced urban air mobility," in Proc. AIAA Scitech Forum, (Oxon Hill, MD, USA), Jan. 2023.

K.H. Shish et al., "Survey of capabilities and gaps in external perception sensors for autonomous urban air mobility applications," in Proc. AIAA Scitech Forum, (Virtual Event), Jan. 2021.

A. Couturier and M.A. Akhloufi, "A review on absolute visual localization for UAV," Robot. Auton. Syst., vol. 135, 2021.

A. Yol and Delabarre, "Vision-based absolute localization for unmanned aerial vehicles," in Proc. IEEE/RSJ IROS, (Chicago, IL, USA), Sept. 2014, pp. 3429-3434.

D. Lee et al., "Enhancing state estimator for autonomous racing: Leveraging multi-modal system and managing computing resources," IEEE Trans. Intell. Veh., 2024.

D. Nistér, O. Naroditsky, and J. Bergen, "Visual odometry," in Proc. CVPR, (Washington, DC, USA), June 2004.

Y. Cheng et al., "Visual odometry on the mars exploration rovers," in Proc. IEEE SMC, (Waikoloa, HI, USA), Oct. 2005.

M. Aqel et al., "Review of visual odometry: Types, approaches, challenges, and applications," SpringerPlus, vol. 5, 2016, pp. 1-26.

C. Forster et al., "On-manifold preintegration for real-time visual-inertial odometry," IEEE Trans. Robot., vol. 33, no. 1, 2016, pp. 1-21.

T. Taketomi, H. Uchiyama, and S. Ikeda, "Visual SLAM algorithms: A survey from 2010 to 2016," IPSJ Trans. Comput. Vis. Appl., vol. 9, 2017, pp. 1-11.

I.A. Kazerouni et al., "A survey of state-of-the-art on visual SLAM," Expert Syst. Appl., vol. 205, 2022, article no. 117734.

R. Acuna and V. Willert, "Dynamic markers: UAV landing proof of concept," in Proc. LARS/SBR/WRE, (João Pessoa, Brazil), Nov. 2018.

P.H. Nguyen et al., "Remote marker-based tracking for UAV landing using visible-light camera sensor," Sensors, vol. 17, no. 9, 2017.

OpenStreetMap Foundation, https://openstreetmap.org

공간정보산업진흥원, 대국민 지도서비스 브이월드, https://www.vworld.kr

국토지리정보원, 국토정보 서비스, https://www.ngii.go.kr/kor/content.do?sq=237

환경부, 환경공간정보서비스-토지피복지도 맵 서비스-‘개요’ 탭, https://egis.me.go.kr/intro/land.do

J.H. Kim et al., "3D viewer development to support 3D building modeling," J. Korean Soc. Geospat. Inf. Sci., vol. 29, no. 4, pp. 47-53.

환경부, 환경공간정보서비스-토지피복지도 맵 서비스-‘MAP 소개’ 탭, https://egis.me.go.kr/intro/land.do

S. Jiang et al., "Unmanned aerial vehicle-based photogrammetric 3D mapping: A survey of techniques, applications, and challenges," IEEE Geosci. Remote Sens. Mag., vol. 10, no. 2, 2021, pp. 135-171.

M.P.S. Tondewad and M.M.P. Dale, "Remote sensing image registration methodology: Review and discussion," Procedia Comput. Sci., vol. 171, 2020, pp. 2390-2399.

S. Karim et al., "Comparative analysis of feature extraction methods in satellite imagery," J. Appl. Remote Sens., vol. 11, no. 4, 2017.

P.-E. Sarlin et al., "Superglue: Learning feature matching with graph neural networks," in Proc. IEEE/CVF. CVPR, (Virtual), June 2020.

J. Edstedt et al., "DeDoDe: Detect, don’t describe-describe, don’t detect for local feature matching," arXiv preprint, CoRR, 2024, arXiv: 2308.08479.

J. Johnson, M. Douze, and H. Jégou, "Billion-scale similarity search with GPUs," IEEE Trans. Big Data, vol. 7, no. 3, 2019, pp. 535-547.

M. Schleiss, "Translating aerial images into street-map-like representations for visual self-localization of UAVs," in Proc. ISPRS XLII-2, (Enschede, Netherlands), June 2019, pp. 575-580.

H.M. Ali, A. Boshir, and I.M. Ariful, "Automatic extractions of road intersections from satellite imagery in urban areas," in Proc. ICECE, (Dhaka, Bangladesh), Dec. 2010, pp. 686-689.

T. Wang, K. Celik, and A.K. Somani, "Characterization of mountain drainage patterns for GPS-denied UAS navigation augmentation," Mach. Vis. Appl., vol. 27, 2016, pp. 87-101.

A. Masselli, R. Hanten, and A. Zell, "Localization of unmanned aerial vehicles using terrain classification from aerial images," in Intelligent Autonomous Systems 13, vol. 302, Springer, 2016, pp. 831-842.

Z. Jin et al., "Multi-region scene matching based localisation for autonomous vision navigation of UAVs," J. Navig., vol. 69, no. 6, 2016, pp. 1215-1233.

A. Nassar et al., "A deep CNN-based framework for enhanced aerial imagery registration with applications to UAV geolocalization," in Proc. CVPR, (Salt Lake City, UT, USA), June 2018, pp. 1513-1523.

M. Bianchi and T.D. Barfoot, "UAV localization using autoencoded satellite images," IEEE Robot. Autom. Lett., vol. 6, no. 2, 2021, pp. 1761-1768.

A.P. Tanchenko et al., "UAV navigation system Autonomous correction algorithm based on road and river network recognition," Gyrosc. Navig., vol. 11, no. 4, pp. 293-299.

K. Hong et al., "Particle filters using gaussian mixture models for vision-based navigation," J. Korean Soc. Aeronaut. Space Sci., vol. 47, no. 4, 2019, pp. 274-282.

K. Hong et al., "Vision-based navigation using gaussian mixture model of terrain features," in Proc. AIAA Scitech Forum, (Orlando, FL, USA), Jan. 2020.

그림 1

Geo-Referencing을 위한 공간정보 DB 유형 및 예시: (a) 위성사진/항공사진, (b) 수치 표고 모델(DEM), (c) 3차원 건물 모델, (d) 토지피복도

표 1 토지피복도 분류체계

| 유형 | 색상 | 종류 |

|---|---|---|

| 시가화 | 주거, 공업, 상업, 교통 | |

| 농업지역 | 논, 밭, 과수원, 재배지 | |

| 산림지역 | 활엽수림, 침엽수림 | |

| 초지 | 자연초지, 인공초지 | |

| 습지 | 내륙습지, 연안습지 | |

| 나지 | 자연나지, 인공나지 | |

| 수역 | 내륙수, 해양수 |

출처 Reproduced from [21].

표 2 Image-to-Image 특징 추출 및 매칭

| 유형 | 설명 | 주요 예시 |

|---|---|---|

| 고전적 특징점 매칭 | 비행영상의 특징점과 참조용 DB 영상의 특징점을 매칭 | • SIFT |

| • ORB | ||

| • SURF | ||

| 딥러닝/학습 기반 | 영상 내 특징 추출, 매칭, 정합 과정에 딥러닝 기술 활용 | • SuperGlue |

| • DeDoDe |

표 3 비행영상 내 의미론적/시불변적 공간정보 추출 및 정합 연구 사례

| 문헌 | 특징 매칭용 공간정보 | 주요 내용 |

|---|---|---|

| [29] | 건물, 도로, 배경 등 | cGAN을 이용한 segmentation 수행, 템플릿 매칭 정합 |

| [30] | 도로 교차로 정보 | 이진 영상에 대한 필터링으로 도로 추출 |

| [31] | 산악 지형 배수 (Drainage) 패턴 | Wave transform 등 이용 특징 추출 |

| [32] | 잔디, 나무, 도로, 건물 등 | SURF, ORB로 특징점 추출, Particle Filter 기반 정합 |

| [33] | 도심 랜드마크 | Exact Histogram Matching 이용 랜드마크 추출 |

| [34] | 건물 정보(면적, 반경, 위치 등) | U-Net 활용 건물 특징 추출 |

| [35] | Aut oencoder로 임베딩된 잠재 특징 (Latent Feature) | 인코딩된 참조용 위성지도 활용 Image registration 수행 |

| [36] | 도로, 강 | U-Net 활용 추출, SIFT로 정합 |

| [37-39] | 건물, 도로 등 | VWorld 지리 데이터셋 학습 신경망 기반 의미론적 분할 |

- Sign Up

- 전자통신동향분석 이메일 전자저널 구독을 원하시는 경우 정확한 이메일 주소를 입력하시기 바랍니다.