나기인 (Na K.-I.)

신호철 (Shin H.C.)

Ⅰ. 서론

인공지능 연구의 발달로 다양한 종류의 센서에서 얻어진 정보로부터 현재 상황에 대한 판단 능력이 향상됨에 따라 이를 활용한 감시 및 보안을 무인으로 처리하고자 하는 연구들이 증가하고 있다. 특히, 공장과 같은 큰 규모의 산업현장에서 보안, 이상상황 감지 및 감시와 같은 경비 업무를 수행하기 위해서 고정형 CCTV(Closed-Circuit Television)와 함께 이동형 로봇을 이용하면 사각지대를 줄일 수 있으며 적용 범위를 효율적으로 늘릴 수가 있다. 또한, 기존의 CCTV를 기반으로 하는 연구들은 영상정보만을 사용하기 때문에 다양한 상황에 적용하기에는 한계가 있었다. 경비로봇을 활용하는 연구에서는 이러한 한계를 극복하기 위해서 멀티모달 센서기반으로 다양한 환경(야간, 안개, 화재 등)에서도 인식 및 판단이 가능하도록 한다.

서로 다른 센서를 활용하여 정확한 판단을 하기 위해서는 각 센서 데이터 간의 정렬, 데이터 처리및 처리된 정보 융합이 중요한 부분이다. 또한, 센서 수가 증가함에 따라서 많은 양의 데이터를 실시 간으로 처리해야 하고, 이에 대한 결과 및 센서 데이터를 지역 서버나 클라우드에 전송하여야 한다. 다수의 고정형/이동형 에이전트로부터 데이터가 전송되므로, 통신 네트워크 부하를 줄여줄 수 있는 데이터 구조와 함께, 에이전트 간의 동작이 유기적으로 이루어지도록 관제 시스템에서 효율적인 경비 계획, 통제 및 운용이 필요하다.

본고에서는 경비로봇에 대한 산업 동향과 이상 상황 판단에 관련된 연구 동향에 대해서 살펴보고, 멀티모달 센서로 구성된 로봇을 이용한 지능형 정보분석 플랫폼의 연구를 소개하고자 한다. Ⅱ장에 서는 최근까지의 경비로봇 연구 및 산업 동향에 대해서 살펴본다. Ⅲ장에서는 이동/고정형 로봇, 감시 카메라 등을 관리하기 위한 멀티에이전트의 지능형 관제 시스템 및 멀티모달 센서 플랫폼에 대해서 소개한다. Ⅳ장에서는 에이전트에서 이뤄지는 인식기술과 효율적인 데이터 전송 및 처리를 위한 환경지도 기반의 판단 기술을 소개한다. Ⅴ장에서는 결론과 함께 전반적인 향후 전망을 기술하였다.

Ⅱ. 산업 & 연구 동향

1. 경비로봇 동향

SHARP사에서는 2016년 9월에 실외경비로봇인 INTELLOS A-UGV[1]에 대해 소개하였는데, 영상, 음성, 열영상 등의 다양한 센서를 사용하여 창고와 같은 시설에 대한 보안과 건물의 문과 창문 그리고 침입자에 대한 감시 등의 임무를 수행하고, 중앙시스템에서 이를 관리할 수 있도록 구성되었다.

OTSAW O-R3[2]는 거리, 통로 및 열린 공간을 순찰하고, 동적 장애물을 피하고, 자동으로 기지로 복귀할 수 있고, 얼굴 인식 기능이 있는 지능형 자율 보안로봇이다. O-R3는 감시를 위해 360° 카메라, HD 카메라 및 2개의 LiDAR(Light Detection And Ranging)를 사용하여 실시간으로 데이터를 수집하며, 상황에 따라서 머신러닝 감시 기술을 활용하여 경비원에게 이상 징후를 경고한다. 현재, 두바이의 공공장소와 싱가포르의 공원에서 적용되고 있다.

Knightscope사는 K3, K5 등의 이동형 경비로봇을 제안하였으며[3], 쇼핑몰, 학교 캠퍼스 및 대형 주차장에서 발생하는 보안 상황에 대해서 중앙시스 템에 통보하는 것을 목표로 하고 있다. 이동형 경비로봇은 영상, 음성, 3D 거리 센서, 온도 및 공기 측정 센서를 가지고 자동차 번호판 인식, 이산화탄소 농도 및 이상행동 감지나 늦은 시간 사람의 움직임 등을 인식할 수 있다. 그리고 2017년도부터 실리콘밸리의 웨스트필드 쇼핑몰과 삼성전자 미국 캠퍼스에서 운용되어 실내외에 대한 순찰 기능을 수행하고 있다.

시크센스의 자율주행 로봇 SQ-2[4]는 도쿄도청에 배치되어 지정한 경로를 자율 순회하면서 이상 유무를 파악하고 자동제세동기(AED)와 소화기의 손상 등을 확인한다. 경비원은 로봇이 실시간으로 보내오는 동영상을 보면서 원격감시업무를 수행할 수 있다. SQ-2 경비로봇은 LiDAR와 각종 센서를 이용하여 자율주행을 수행하며 공간을 인식해 3D 지도를 생성할 수 있다. 또한, 환경 변화 감지를 통해서 이상을 발견하거나 고정형 CCTV 카메라에선 잡기 어려운 사각지대에 대한 영상인식 및 모니터링 작업도 할 수 있다. 직원 및 방문객의 얼굴을 인식하고 데이터베이스에 없는 사람을 감시하는 것도 가능하다.

현대자동차그룹은 공장 안전 서비스 로봇[5]을 기아 광명공장에 배치하고 시범 운영을 시작하였다. 보스톤 다이나믹스에서 개발했던 4족 보행 로봇 스팟(Spot)을 자체 개발한 AI 프로세싱 서비스 유닛과 조합하여 기아 광명공장에 야간 경비 임무를 맡게 하고, 이를 통해 축적한 데이터를 바탕으로 다양한 산업현장에도 적용할 계획이라고 한다. 로봇의 RGB 카메라, 열화상 카메라와 LiDAR를 사용하여 출입구의 개폐 여부 인식, 고온 위험 감지, 외부인 무단침입 감지, 내비게이션을 통한 순찰, 영상 전송 및 원격 조작기능을 주기능으로 하고 있다.

상기의 경비로봇들은 연구단계 또는 시범운영 단계에 있고, 대체로 한 개의 이동형 에이전트만을 운영하고 있다. 또한, 전체 영역에서 복잡한 상황에 대한 인식보다는 개별 에이전트에서 획득한 센서 데이터에 영상인식 기술을 활용하여 변화된 점을 감지하거나 외부 출입자 인식 정보를 기반으로 영상을 전송하여 관제실에 상황을 보여주는 데 주목적이 있다고 할 수 있다.

2. 인식 및 상황 판단 연구 동향

경비로봇은 센서의 구성이 조금씩 다르지만 대체로 RGB 카메라, LiDAR 등을 사용하여 사람 및 물체 검출을 수행하며, 적용되는 환경에 따라 IR(Infrared) 카메라, 열화상 카메라 등 추가적인 센서를 사용하여 감시 대상을 확대하거나 성능을 높이도록 구성한다. 이처럼 본 절에서는 인식 및 상황 판단을 하는 연구에 대해서 기술하였다.

Meghana 등[6]은 대규모 영역의 중요 시설 주변 및 국경 등과 같은 야외 환경에서 RFID(Ra-dio-Frequency Identification) 태그를 이용하여 감지된 사람의 영역 허가 사항을 파악하며 금속 탐지기 센서를 사용하여 금속 폭탄을 감지한다. 로봇에 장착된 무선 카메라는 360° 방향으로 회전하며 실외 영역을 지속적으로 스트리밍하고 적외선 조명을 사용하여 완전한 어둠 속에서도 감시가 이루어지도록 하였다.

Chakravarty 등[7]의 논문에서는 수동으로 훈련된 경로를 반복하며 훈련 중에 존재하지 않았던 시각적 이상을 감지하는 모바일 로봇을 제안하였다. 복잡한 실험실, 복도 및 사무실 환경에서 파노라믹 영상을 획득하도록 구성하여 자율주행 중 캡처된 이미지와 훈련 실행 중 캡처된 참조 이미지 간의 차이를 추출하는 방법으로 이상을 감지하여 침입자와 같은 이동성 이상과 고정된 이상을 모두 감지하도록 하였다.

상기의 응용들은 인식 및 이상상황 검출을 위해서 각 상황에 맞는 단일 센서만을 사용하였지만, 멀티모달 센서들의 정보로부터 결과를 융합하여 향상된 결과를 얻기도 한다. Paola 등[8]은 실내 환경에서 감시를 위한 자율 이동 로봇을 제안하였는데, 단안 카메라와 레이저 스캐너 및 RFID 센서를 포함하는 다중 센서 플랫폼을 구성하였다. 이 센서 플랫폼을 사용하여 지도 작성, 위치인식, 자율주행 및 탐색과 관련된 기본 기능과 함께 감시 기능 수행을 위해 환경 내 물체의 변화검출, 센서 간의 융합을 통해 상기의 기능들의 성능이 높아지는 것을 보였다.

앞 절에서 경비로봇을 시범 운용하는 것과는 다르게 좀 더 다양한 상황에 대한 연구가 진행되고 있으며, 이종 센서 간의 결합을 통해 정확도 향상을 목표로 하는 연구도 있으나 대체로 환경에 맞는 단일 센서를 활용한 연구가 많으며, 산업계와 마찬가지로 다수의 멀티에이전트를 활용하거나 효율적인 데이터 처리 및 전송에 관련된 연구는 부족하다.

Ⅲ. 멀티에이전트 정보분석 플랫폼

멀티모달 센서기반의 고정형/이동형 에이전트를 다수 사용하는 멀티에이전트 상황에서 효율적인 이상상황 검출 및 에이전트 운용을 위한 연구에 대해 소개한다. 다양한 이상상황 검출을 하는데는 에이전트에서 바로 확인되는 지역적인 상황뿐만 아니라 전역적인 상황을 고려한 판단을 하는 것이 필요하다. 이 장에서는 멀티모달 센서기반의 학습을 위한 데이터 수집과 테스트베드에서 멀티에이 전트 운용을 위한 서버측 프로그램 등 전체적인 플랫폼에 대해 기술한다.

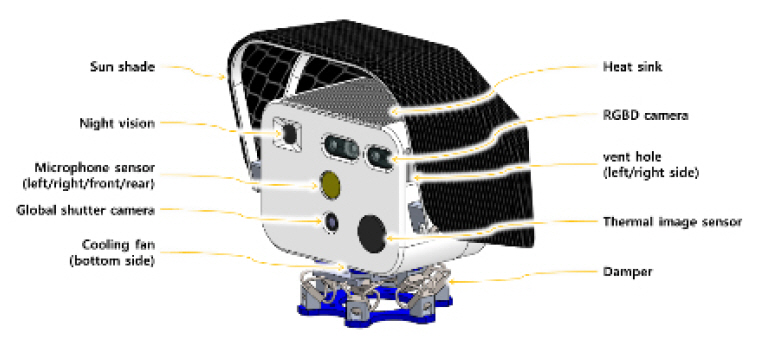

1. 멀티모달 센서

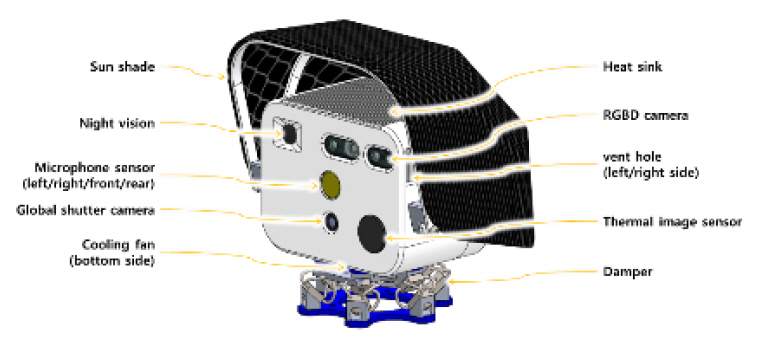

멀티모달 센서 모듈은 총 7종의 센서(RGB 카메라, IR 카메라, Depth 카메라, Thermal 카메라, Nightvision 카메라, 다채널 마이크, LiDAR)를 사용하여 10fps 동기화된 데이터를 획득 가능하도록 제작되었다. 실외 경비로봇의 특성상 외부의 설치 및 우천 시에도 사용 가능하도록 방수 및 내식성, 내화학성을 위한 불소 소재를 케이스의 내부 씰에 적용하였다. 추가적으로 로봇이 이동하면서 발생하는 진동으로 인해서 센서데이터가 부정확하게 획득되는 것을 방지하고자 이동형 모듈에 장착 시에는 완충기를 사용하였다. 센서 데이터 간의 시간 동기화와 캘리브레이션이 수행된 멀티모달 센서 모듈은 물체인식 및 검출에 사용하였다[9]. 그리고 센서 데이터를 저장 및 전달하기 위해서 추가적인 소형 PC가 사용되었다. 그림 1은 멀티모달 센서 모듈의 구성도를 나타낸 것으로 센서의 구성과 함께 발열 및 진동을 억제하기 위한 기구부를 확인할 수 있다.

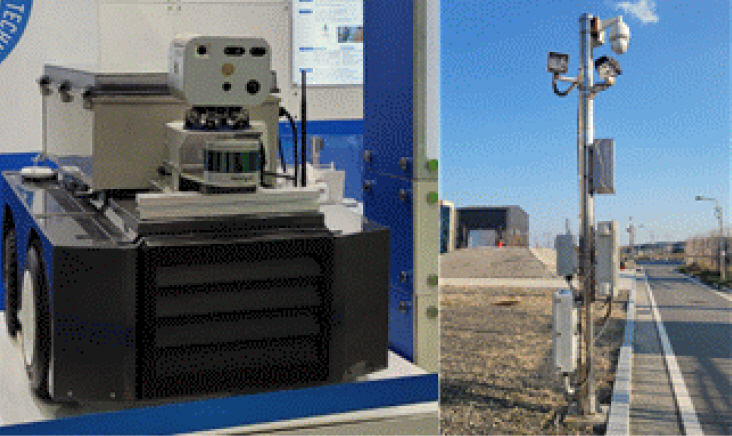

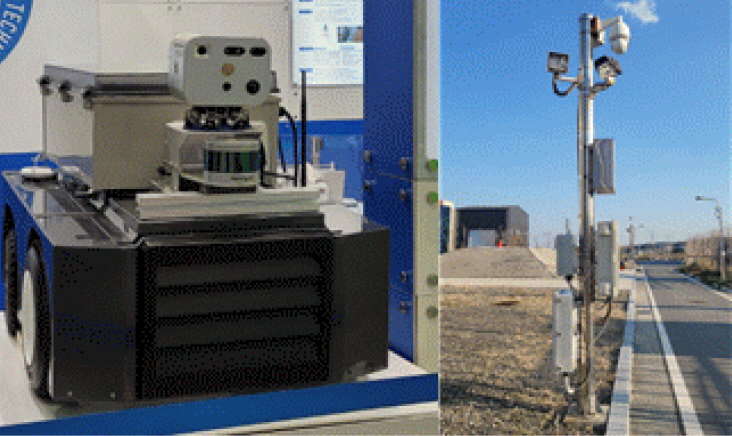

그림 2는 멀티모달 센서 모듈이 이동형/고정형 에이전트에 각각 적용된 사진이다. 고정형 에이전트에는 LiDAR는 제외되고 각 위치에 따라 센서 구성이 다르게 주요 감시지점에 설치된다.

2. 테스트베드 및 데이터 수집

실외 경비로봇 기술의 성능 검증 및 테스트를 위해서 포항(안전로봇실증센터)과 광주(나노산업단지 주변)를 테스트베드로 선정하여 고정형 에이전트 설치 및 이동형 에이전트를 운용하였다. 상기 테스트베드 지역에서 멀티모달 센서 모듈을 이용한 다양한 상황에 대한 동기화된 데이터를 취득하였다. 주간, 야간, 폭우, 연기(화재상황) 등의 환경에 대한 50만 장 이상의 데이터베이스를 구축하였다. 그림 3은 테스트베드로 활용 중인 포항 안전로봇실증센터와 광주 나노산업단지 주변으로 안전로봇실증센터에서는 다양한 이상상황을 재현하여 데이터 수집 및 테스트를 진행하였으며, 광주 나노산업단지는 포항에서 얻어진 데이터를 활용하여 실환경 적용 결과를 파악하고자 하였다.

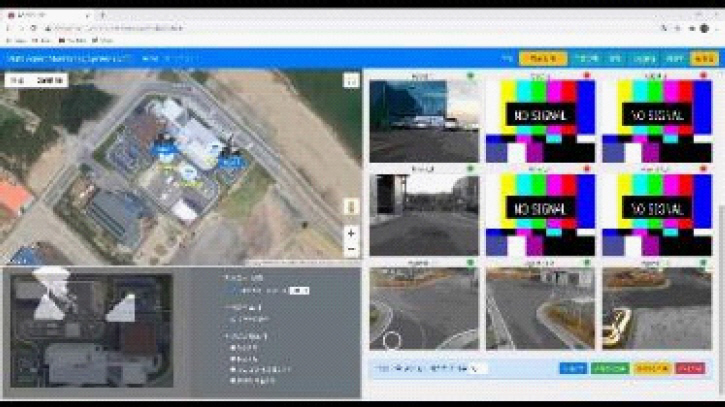

3. 멀티에이전트 관제 시스템

테스트베드 장소의 멀티에이전트의 효율적인 모니터링과 제어를 위해서 감시 관리자에게 적합한 UI(User Interface)를 가진 관제 시스템이 필요하다. 또한, 이상상황 판단에 대해서 정확성을 검증하고 이를 다시 학습에 반영하는 지능 분석 플랫폼이 필요하다.

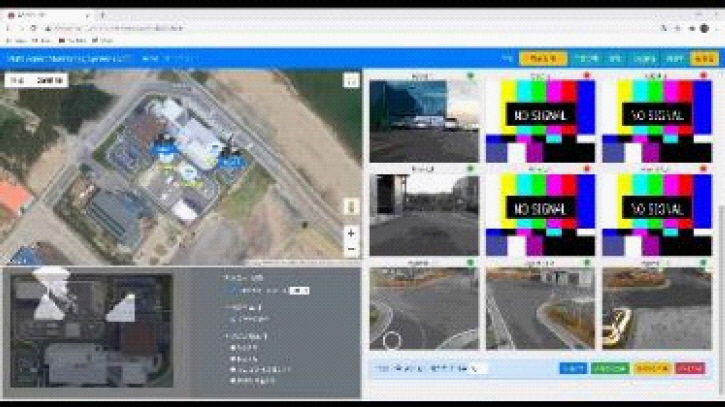

그림 4는 관제 모니터링 시스템 UI로서 에이전트 위치 기반 지도표시, 환경지도 연동 데이터 화면 표시, 이동 에이전트의 감시 경로 계획 기능 충전상태 표시 기능, 드론 출동/복귀/제어, 실시간 영상 모니터링 및 이상상황 알림 기능을 포함하고 있다.

또한, 이상상황 인식 모듈의 성능 향상을 위한 점진적 학습을 위한 Human-in-the-loop 인터페이스, 이상상황 발생 시 알림 기능 및 이동형 에이전트의 재배치 기능을 제공한다. 그리고, 각 테스트베드 사이트에 위치한 서버와 MQTT 통신을 이용하여 이상상황 및 환경지도 데이터 등을 전송한다.

Ⅳ. 인식 및 이상상황 판단 기술

1. 사람, 사물 및 행동 인식 기술

화재 등 특수한 상황을 제외하고 대부분의 이상 상황은 사람과 같은 객체와 관련하여 발생한다. 따라서, 이상상황 판단을 위해서는 멀티모달 센서에서 얻어지는 데이터로부터 물체를 인식하고 추적하며, 사람의 경우 행동을 인식하는 것이 우선적으로 이루어져야 한다.

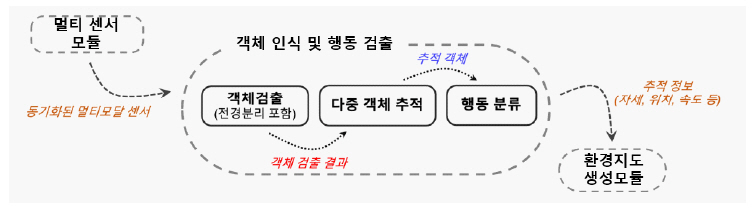

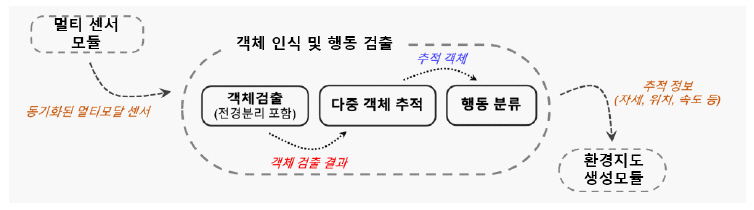

그림 5는 이를 위해서 구성된 알고리즘 흐름도로서 성능 향상을 위해서 이동형 에이전트에서는 먼저 RGB 영상을 입력으로 DeepLab V3+ segmen-tation 네트워크 구조를 통해 전배경 분리를 하였다. 이를 통해서 오검출률을 줄일 수 있으며, 거리 측정이 어려운 먼 물체보다 가까운 물체에 더욱 집중하여 판단할 수 있다.

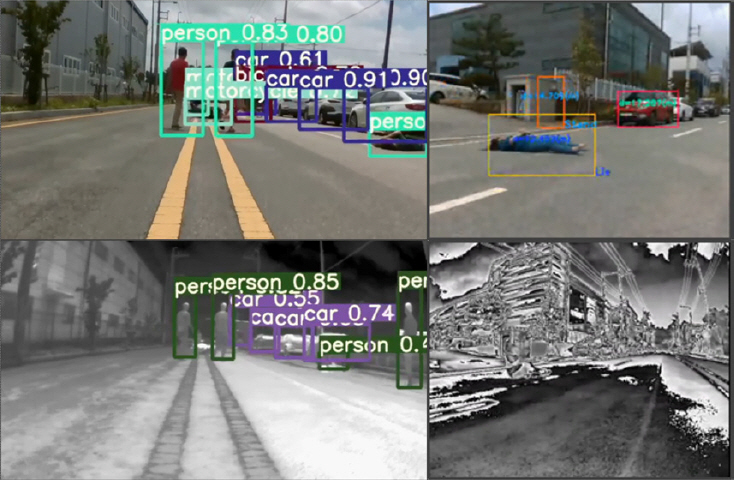

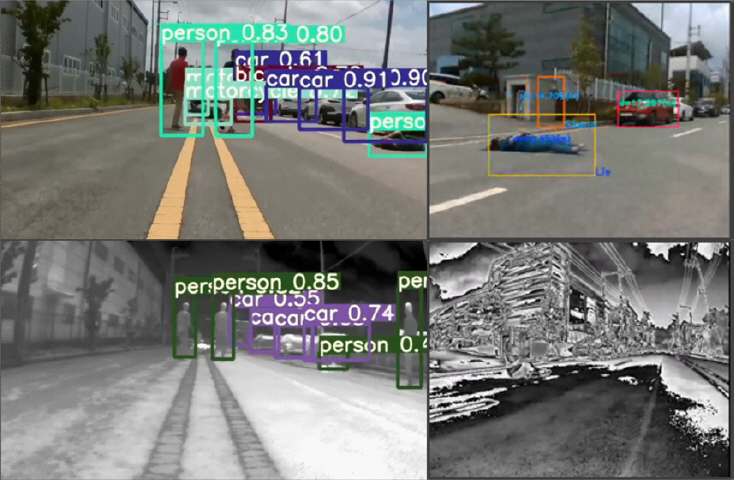

멀티모달 센서 데이터로부터 사람, 자동차, 이륜차 등을 검출하기 위해서 포항 실증 단지와 광주 나노산업단지에서 제작한 멀티모달 데이터셋 및 MS-COCO 데이터셋을 활용하여 객체 검출기를 학습하고 그 성능을 측정하였다[10]. 개발된 알고리즘은 고정형 및 이동형 에이전트에 탑재하여 에이전트 운용 시 관심 객체를 검출하며 RGB 카메라와 열화상 카메라의 센서를 활용하여 주/야간 모두에 대해 객체 검출이 강인하게 가능하도록 구성하였다.

이를 위해서 미리 계산된 날짜 기반의 일출/일몰 시간을 불러오고, 해당 시간을 기준으로 주/야간을 판별하였다. 객체 검출 모듈은 주/야간 상황에 모두 강인한 객체 검출기 학습을 위하여 RGB 영상과 열화상 영상 데이터를 모두 사용하여 학습하였다.

주/야간 상황에 강인한 객체 검출 결과는 다중 객체 추적과 행동 분류 모듈의 주/야간 성능을 모두 강인하게 해준다. 행동 분류 모듈은 주간에는 RGB 영상 데이터를, 야간에는 열화상 영상 데이터를 이용하여 사람의 행동을 분류하도록 학습하였다.

검출기를 통해 물체의 글로벌 좌표를 구하기 위해서 물체의 특징 정보를 매 프레임마다 지속적으로 업데이트하는 방법을 활용하였다. 이전에 추출된 특징 정보와 업데이트 특징 정보 간의 채널별 유사도를 기반으로 하여 유사도가 높은 채널의 특징들을 interpolation하여 효과적으로 물체의 좌표를 획득했다[11].

이렇게 취득된 물체 정보 중에 사람과 관련된 경우 현재 어떤 상태인지 또는 어떤 행동을 하는지에 대한 인식 기술도 필요하다. 두 개의 temporal-wise attention 기반의 LSTM(Long Short-Term Memory) 네트워크를 활용하여 각 입력 프레임에서의 가중 치를 차등적으로 적용하고 앙상블 기법을 사용하여 객체의 행동을 인식하였다. 두 개의 LSTM은 각각 ImageNet 데이터셋에서 미리 학습된 VGG-16과 ResNet-101에서 획득한 특징값을 입력으로 하였다.

장착된 멀티모달 센서 종류가 다른 고정형과 이동형 에이전트에 대해 객체 인식 및 행동 판단 모듈로 입력되는 ROS 센서 메시지 종류를 모듈 내에서 자동으로 감지하여 고정형/이동형 프로그램 구분 없이 하나의 모듈로써 탑재되도록 구현하였다. 단일한 파이프라인 프레임워크로 구현된 통합 모듈은 이동형과 고정형 에이전트에 모두 시스템적으로 연동되어 탑재되었으며, 그림 6은 물체 검출과 행동 인식의 결과를 보여주고 있다.

2. 환경지도 기반 이상상황 판단 기술

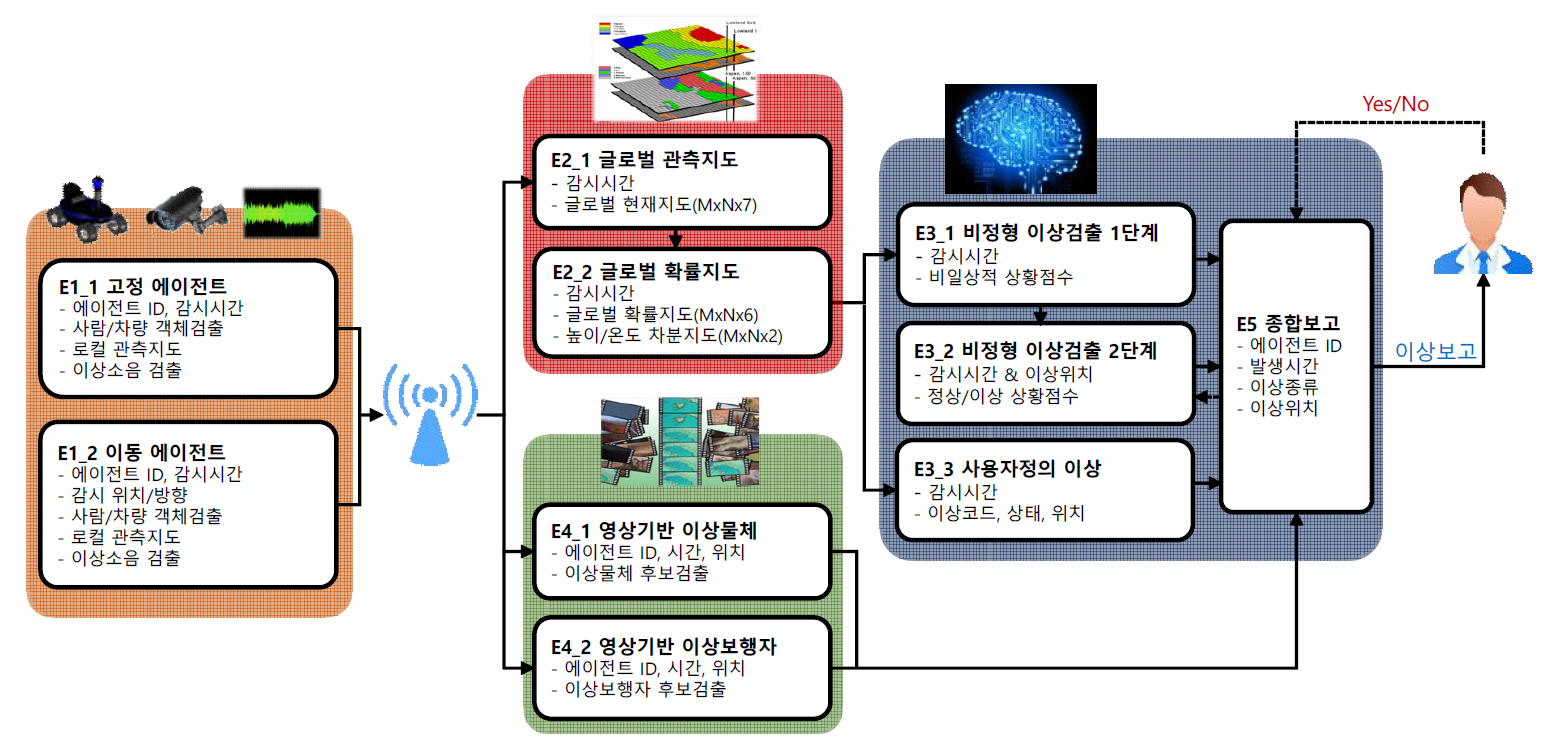

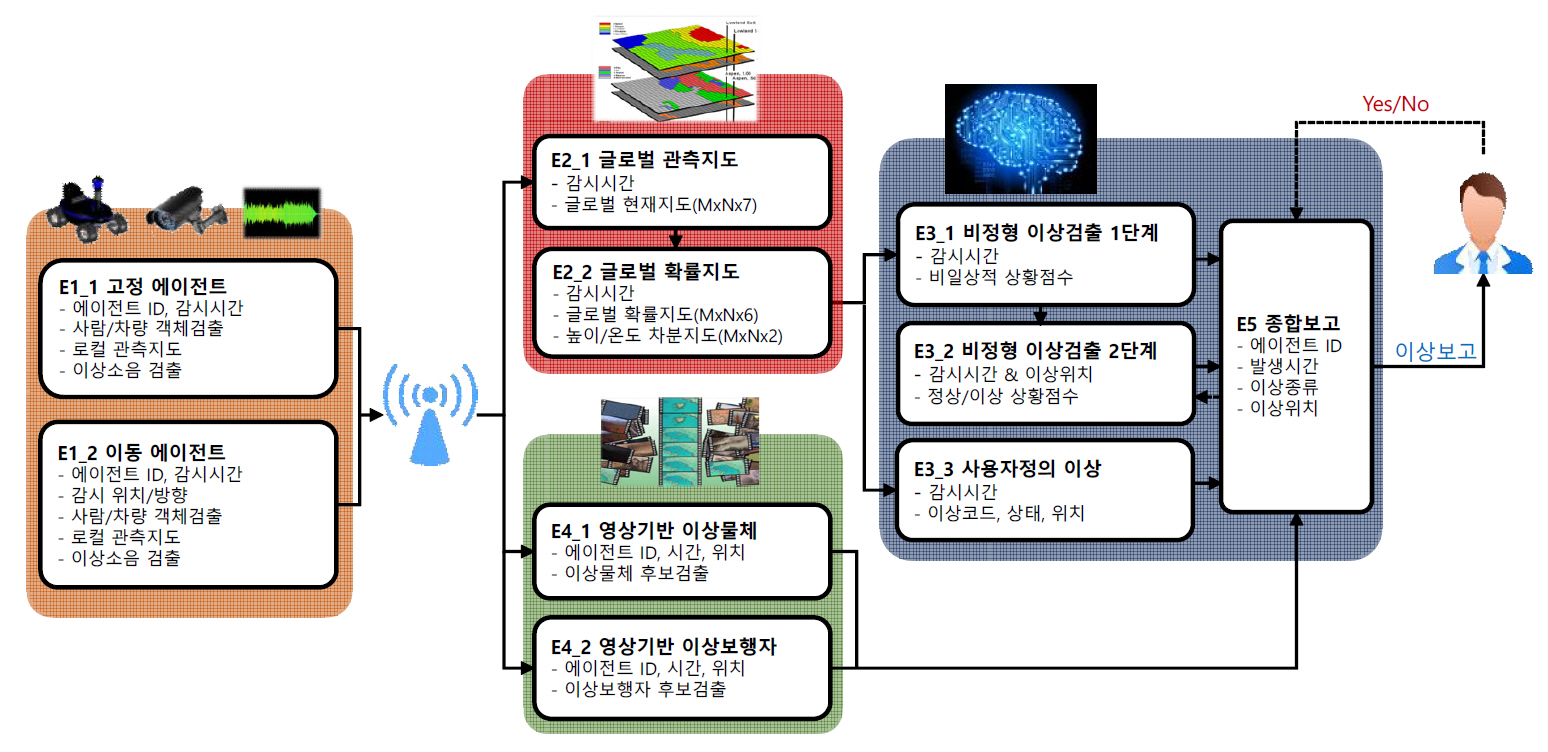

영상으로부터 이상상황을 바로 판별하는 것이 아닌 감시 대상 전역에서 이상상황을 판단하기 위해서 환경 정보를 지도 형태의 데이터로 변환하는 것이 필요하다. 각 에이전트의 감시 센서로부터 입력된 멀티모달 데이터에 대하여 다계층 지역 환경 지도를 작성하고, 각각의 에이전트들이 감지한 사람과 차량의 위치, 속력, 방향, 자세 등의 특징을 인코딩하여 객체 지역 환경지도를 1Hz 주기로 생성한다. 지역 환경지도는 고정형 에이전트의 경우 지표면에 대한 좌표변환을 수행하여 전역 환경지도에 투영하고 이동형 에이전트의 경우 로봇 자율 주행에서 계산된 위치 및 방향을 바탕으로 전역 환경지도에 투영한다[12]. 이 과정에서 시공간적 오차를 최소화하기 위하여 좌표변환 최적화 과정을 수행한다.

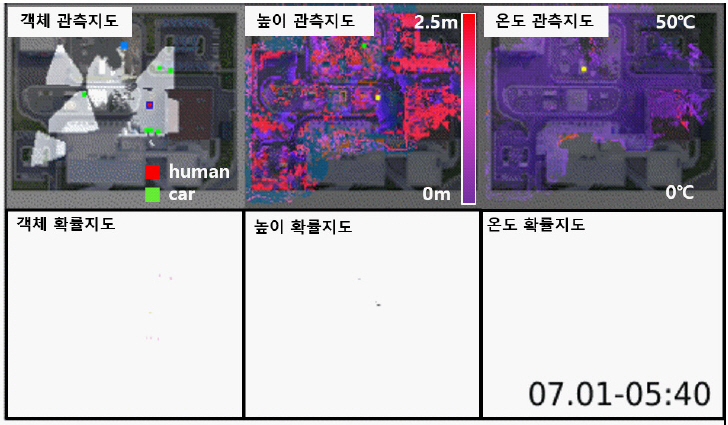

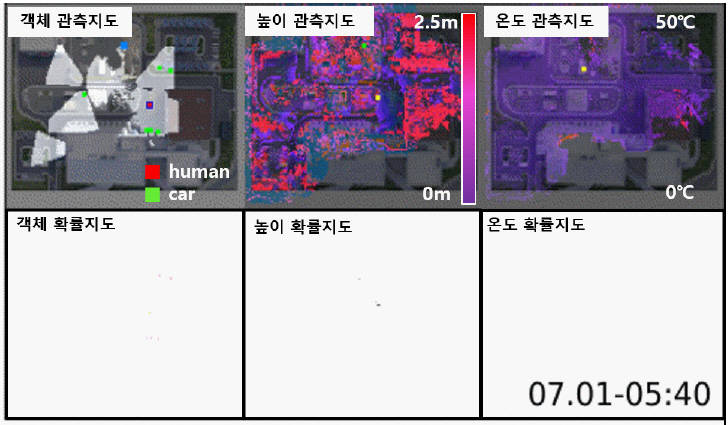

정보분석 서버에서는 각각의 고정/이동 에이 전트들로부터 수집된 로컬 환경지도에 대해 글로벌 환경지도 생성을 수행한다. 글로벌 환경지도는 1.0m/pixel의 해상도로 샘플링되며, 각각의 에이전트들에 대한 업데이트 여부, 위치/속력/방향/자세 등의 사람과 차량의 동적 객체 상황, 높이분포 상황, 온도분포 상황 등의 다층 글로벌 관측지도를 1Hz 주기로 생성한다.

정보분석 서버에서 생성된 글로벌 관측지도는 현재 감시지역 내의 사람과 차량의 유동량, 위치, 이동방향, 속력 등의 정보를 포함하고 있으며, 동시에 높이 및 온도분포 상황 등의 정보가 격자맵 형태로 인코딩되어 있다.

예를 들어 감시지역에 시동이 걸린 차량이 있을 경우 차량의 위치, 해당 지점의 높이분포, 엔진과 배기가스 등으로 인한 해당 지점의 최대온도 등을 실시간으로 시각화할 수 있으며, 온도변화의 경우 시간대별로 흐린 날에 비해 맑은 날에 더 높은 온도분포가 발생한다.

정보분석 서버에서 생성된 전역 관측지도는 과거의 전역 관측지도 DB에 기반하여 현재 관측값에 대한 확률점수를 계산하여 글로벌 확률지도를 생성한다. 확률지도는 0~100의 값을 가지며, 점수가 낮을수록 발생확률이 낮음을 의미하며 확률지도는 사람과 차량에 대한 객체 확률, 높이분포 확률, 온도발생 확률지도로 구성되어 있다. 각각의 관측지도와 확률지도를 병합하여 환경지도를 생성하고 생성된 글로벌 환경지도에 기반하여 현재 상황을 판단·수행한다. 그림 7은 사람/차량의 객체의 위치 및 현재 에이전트의 감시지역, 높이 및 온도에 대한 환경지도와 확률지도를 도시한 그림이다.

고정/이동 에이전트의 멀티모달 정보로부터 생성된 환경지도에 대하여 분류되지 않고 라벨링되지 않은 DB(Database), 정상 DB, 이상 DB, 합성이상 DB를 구축한다. 비레이블 DB의 경우 실시간 입력되는 환경지도의 샘플링을 통해 자동적으로 구축되는 DB이며, 이를 기준으로 확률지도를 계산한다. 정상 DB와 이상 DB의 경우 사용자 정의 및 사용자 피드백을 통해 분류되어 레이블된 DB이며, 합성이상 DB의 경우 랜덤모션 등을 통해 생성된 예기치 못한 상황에 대응하기 위한 합성 DB를 구축한다. 합성이상 DB를 제외한 나머지 DB는 환경지도 입력과 사용자의 피드백에 의해 실시간으로 갱신되는 DB로서, 이를 기준으로 이상판단을 수행한다. 이상판단의 경우 확률지도와 오토인코더 구조를 이용하여 1차적으로 이상후보를 추출하며, CNN과 레이블 DB를 활용하여 2차 필터링을 수행하고 2단계 판단을 거쳐 사용자에게 상황판단 결과를 보고한다. 그림 8은 이런 전체적인 이상상황 판단/보고/피드백을 포함한 흐름도를 나타낸다.

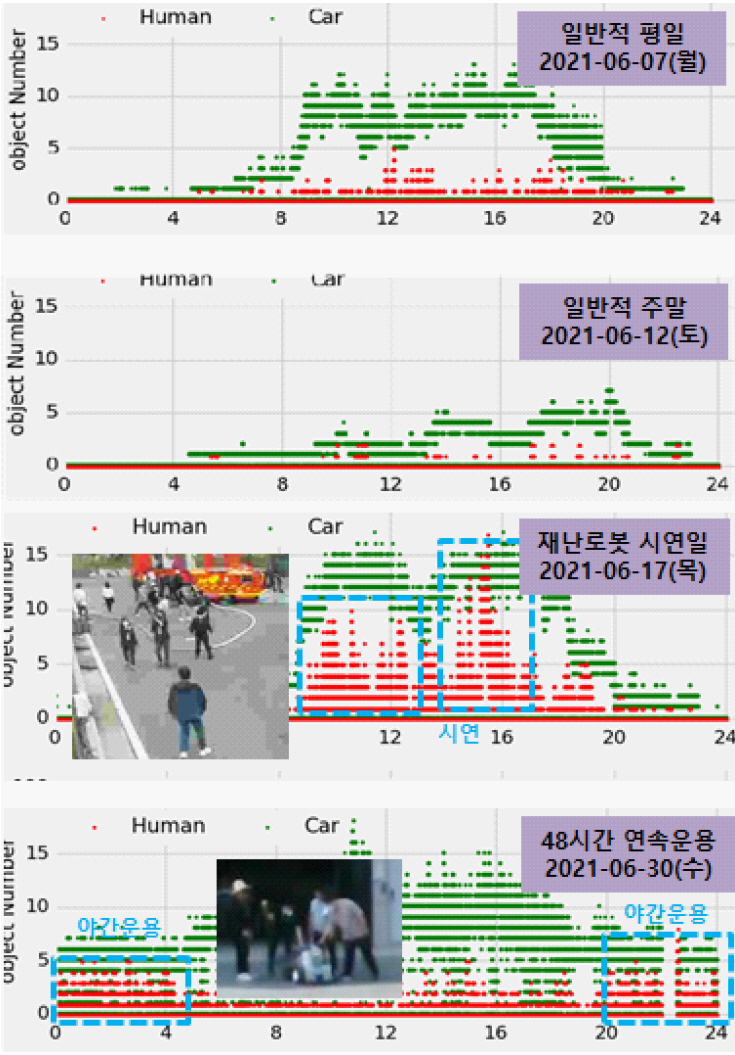

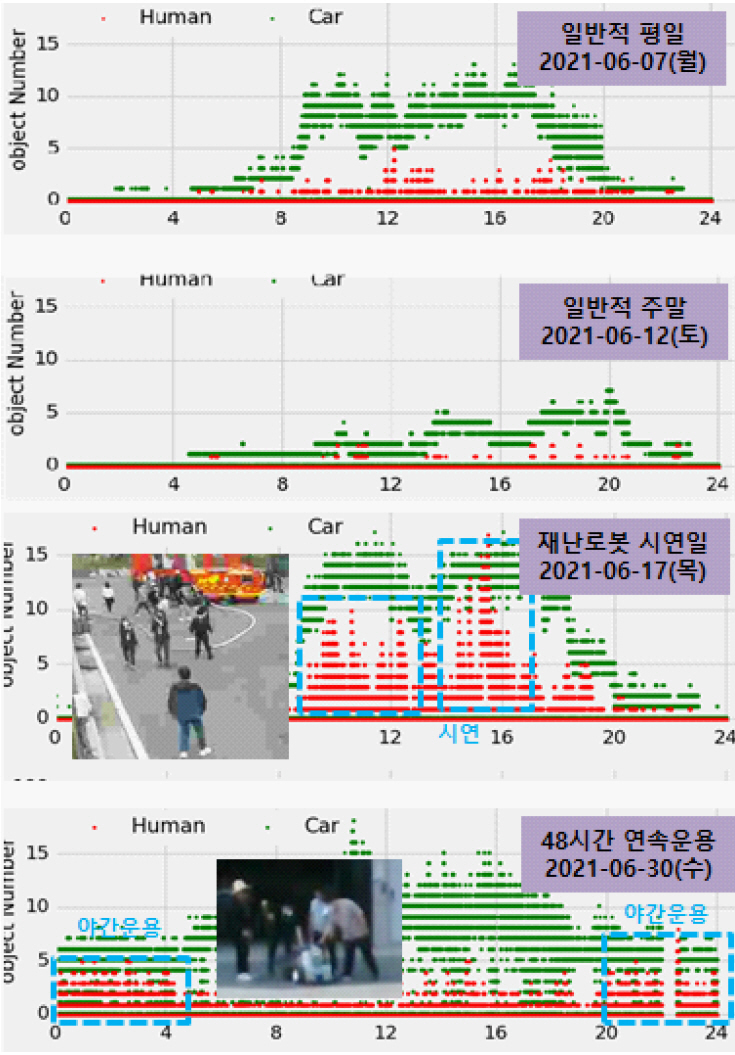

그림 9는 상기 알고리즘에 따라서 사람/차량 환경지도에 기반하여 해당 감시지역의 사람과 차량의 시간대별 유동량을 분석 수행한 결과이다. 일반적으로 평일의 경우, 오전 8시 전후의 출근시간부터 사람과 차량의 통행량이 증가했으며, 점심시간에는 평균 5명 전후의 가장 많은 군중이 발생하였다. 주말에는 평일에 비해 대폭 감소된 통행량을 보였으며, 저녁시간에는 일부 통행량이 증가하는 경향이 있었다. 2021년 4월부터 6개월간의 운용기간 중, 6월 17일의 경우 재난로봇 시연행사로 인해 최대 17명까지의 군중과 최고 활동량이 발생하였 으며, 6월 30일의 경우 48시간 연속운용 테스트로 인해 저녁 8시~새벽 6까지 5명 전후의 활동이 기록된 것이 그림을 통해서 확인 가능하다.

Ⅴ. 결론

고정형 CCTV를 사용하여 이상상황을 검출하여 알려주는 연구가 실용화단계에 이르고 있다. 하지만, 특정 지역 내에서의 모든 지점에 CCTV를 설치하기 어려운 이유로, 최근에는 이동형 로봇을 활용하는 연구 및 시범 사업이 증가하고 있는 추세이다. 대체로, 다양한 종류의 센서를 사용하지만 이를 융합하여 사용하는 경우가 적으며, 다수의 에이전트를 활용한 연구는 거의 없는 실정이다. 본고에서는 현재 경비로봇에 대한 현황과 함께 연구 개발 중인 멀티모달 센서기반 멀티에이전트 경비로봇에 대한 연구를 소개하였다. 다양한 센서의 융합을 통한 검출 및 인식기술의 향상과 더불어 실제 테스트베드에 환경을 구축하고 데이터를 수집하였다. 또한 멀티에이전트 시스템에서 보다 효율적인 데이터 처리와 전송을 위해 환경지도 형태로 변환하고, 이를 통해서 감시지역 전역에 대한 이상상황 판단을 수행하였다. 본 연구는 공개 소프트웨어 과제로서 향후 수집된 데이터셋과 관련된 소스를 오픈할 예정이다.

참고문헌

그림 1

그림 2

그림 3

그림 4

그림 5

그림 6

그림 7

그림 8

그림 9